01

引言

自从大约十年前深度学习技术被引入人脸识别领域以来,人脸识别的准确率已经大大提高。但在使用人脸识别技术的过程中频繁出现的歧视、误判事件引发了舆论的关注,如何正确使用人脸识别技术,如何对其中的风险进行分析与治理,是亟需研究并解决的问题。围绕这些问题,Nature发表了相关的专题文章《Is facial recognition too biased to be let loose?》[1],上海计算机软件技术开发中心参与并发布了《人脸识别安全技术规范》团体标准[2]。本文将对Nature的文章进行解读,结合其他相关工作,介绍人脸识别的风险与治理相关研究成果。

02

人脸识别的风险

人脸识别最主要的风险之一就是准确率的问题,即使在实验环境下取得相当高的准确率,在真实环境中由于光照、天气、角度、数据分布等原因,同样的人脸识别系统效果可能会大打折扣。

2016年至2019年间,伦敦大都会警察局测试了实时人脸识别技术,他们邀请英国科尔切斯特埃塞克斯大学的法律学者Daragh Murray在警方车辆内的控制室监控人脸识别相关试验。

图一 装有人脸识别系统的警方车辆[1]

就像我们在电影中看到的一样,当摄像头扫描购物中心或广场上的行人时,他们将图像输入车辆内的计算机(图一)。Murray和警察看到计算机在实时视频中识别人脸时,会首先定位人脸区域。然后提取关键特征,并将其与观察名单中的嫌疑人进行比较。如果有匹配项,在警察检查匹配情况后会决定是否冲出去阻止“嫌疑人”或是逮捕他们。

伦敦警察部队总部苏格兰场也曾委托Murray和他的埃塞克斯大学同事,社会学家Pete Fussey,对其利用人脸识别系统的搜捕行为进行研究。但2019年7月公布的结果显示,研究人员在6个试验中对42人进行了标记,警察最终在人群中抓捕了22人,但只有8人是匹配正确的[3]。

2018年,计算机科学家Timnit Gebru发表了一篇论文,发现一些先进的人脸识别软件在识别女性和有色人种面部的表现要比在识别男性、白人面孔方面差得多[4]。Grbru后来又指出,尽管一些公司在肤色较浅和较深的面孔上对性别进行分类方面有所改进,但他们在从肤色较深的脸上猜出一个人的年龄方面表现更差[5]。2021年6月,世界上最大的科学计算协会——纽约市计算机协会敦促暂停个人和政府使用人脸识别技术,因为“基于种族、性别和其他特征的明显偏见”。从中我们可以看出,对部分人群的识别准确率会带来一定的偏见问题。

此外,人脸识别技术的其他一些负面事件也暴露了其中的伦理、道德的风险。

在2017年央视“3.15”晚会上,主持人在技术专家帮助下,不仅能让观众的一张自拍照会眨眼,还能让其变成可受任何人控制的脸部模型,并以此攻破了人脸认证。

据美国《财富》杂志2019年12月12日报道,硅谷一家人工智能公司曾使用3D面具成功欺骗了支付宝和微信支付,并且顺利通过机场、火车站等自助终端检验(图二)。

图二 顺利骗过支付宝和微信的3D面具(来源:mashable)

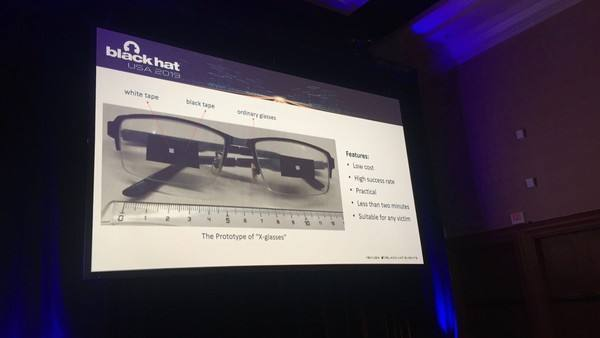

在拉斯维加斯举办的 2019 世界黑帽(Black Hat)安全大会上,腾讯公司的研究人员演示了攻破苹果 Face ID 的法宝:一款特制眼镜。这幅眼镜镜片上贴有黑色胶带,黑色胶带中心还贴有白色胶带(图三)。

图三 攻破Face ID的眼镜 (来源:百度)

在演示中,研究人员只需要将这款眼镜戴在受害者的脸上即可在无需通过“活体检测”的情况下解锁 Face ID。但是,鉴于不法分子需要在不唤醒受害者的情况下把眼镜戴在其脸上,所以这种攻击本身存在一定难度。

2019年,国内爆火的AI换脸软件“ZAO”也引起了不小的风波,其因用户协议涉嫌过度收集用户个人信息问题而遭到质疑,其App协议中要求获得用户人脸照片“完全免费、不可撤销、永久、可转授权和可再许可的权利”,被指存在隐私与安全风险。许多法律专业人士也表示,ZAO存在许多法律隐患,包括过度收集用户个人信息、转嫁侵权责任等。9月3日,工信部就“ZAO”App网络数据安全问题开展问询约谈。

人脸识别的滥用风险的事件还有许多,例如2020年6月的中国人脸识别第一案:浙理工教授状告杭州野生动物世界在未与本人进行任何协商亦未征得同意情况下,通过短信的方式告知其“园区年卡系统已升级为人脸识别入园,原指纹识别已取消,未注册人脸识别的用户将无法正常入园。”

03

人脸识别风险分析

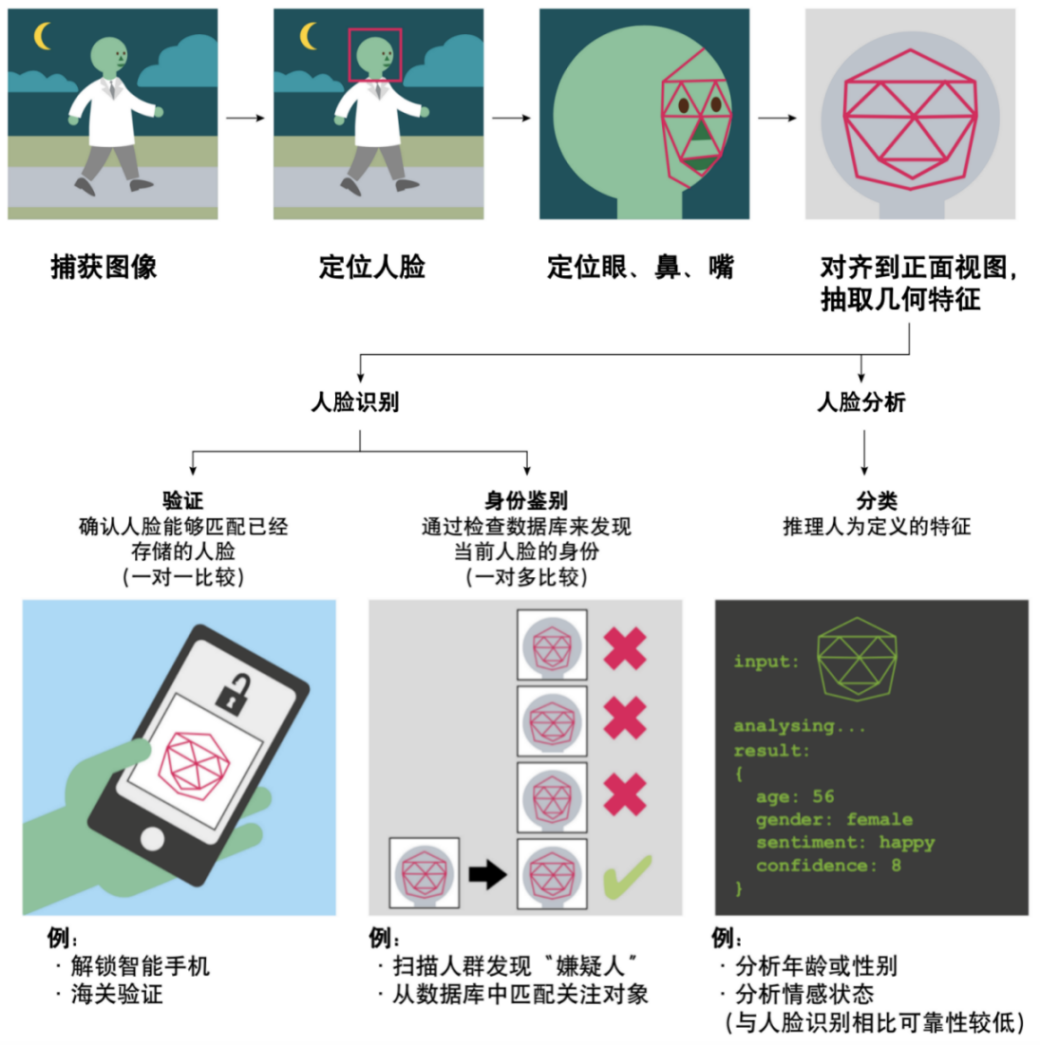

人脸识别系统可以分为两种主要类型,一种是一对多识别,也就是将人脸匹配到大型数据库。另一种是一对一验证,也就是确保一个人与自己的照片匹配,可以用于解锁智能手机或是国家边境护照控制。而人脸分类属于人脸分析系统,即判断输入的人脸图片中人类的情感或是年龄等,如图四所示。

图四 人脸识别、分类系统的工作流程[1]

从前文介绍的几种风险事件可以看出,由于一对一验证相比一对多识别要简单一些,不太容易产生误判、偏见问题,因此它的风险主要来源于对抗攻击。

此前,央视曾报道过研究人员将程序生成的图片打印并贴在眼镜上,就可以成功解锁19款手机(图五),而这种技术和前文介绍的攻破苹果Face ID的“眼镜”都属于“对抗样本”[6]攻击,tensorflow文档对其的定义是“对抗样本是为了混淆神经网络而专门设计的输入,通过在原始图像上添加肉眼难以察觉的微小扰动,大幅度降低原有分类模型的准确率[7]。”目前机器学习普遍缺乏对抗鲁棒性,易受对抗样本的影响。样本经过轻微修改后,输出结果可能会谬以千里。

图五 可以解锁他人手机的特制眼镜

尽管研发对抗样本的难度一般较大,攻击算法需要先抓住被攻击模型的漏洞(掌握一定的模型信息),才能有攻击的机会,这个过程往往费时耗力,但一旦成功,可复制性会极大的降低攻击成本,譬如图五的案例中仅用打印的对抗样本图案就能作为“作案工具”。

另外,我们的往期文章也介绍过以Deepfake为代表的一系列虚假人脸生成技术[8-9],利用这些技术可以生成肉眼无法辨别的虚假人脸。而Face X-Ray、MesoNet等对应的虚假人脸鉴别技术也正在快速发展中[10-11],AI人脸造假攻防战已经打响。

在一对多识别中,由于技术本身正在发展,在应用到现实环境中时很容易产生各种各样的问题,例如前文案例中介绍的女性以及有色人种的识别准确率比起男性、白人要低很多,这可能是训练数据中的数据分布不平衡以及现实生活中采集照片、视频质量的不确定性造成的,虽然从根本上来看属于识别准确率的问题,但是它也会带来很大的社会舆论、伦理道德问题,例如加剧人们对人群歧视问题的担忧、对人工智能技术的反感等(图六)。

图六 2020年1月在英国卡迪夫的抗议人脸识别活动[1]

此外,在人脸识别技术的应用、推广过程中,如果方法不当,或是被不法分子利用,也会带来很严重的安全、隐私风险,例如中国人脸识别第一案、“ZAO” App事件等。

04

人脸识别风险治理

从上面的分析可以看到,人脸识别技术的风险有对抗攻击风险、道德伦理风险、安全隐私风险、滥用风险等。需要通过不同的手段进行治理,才能规避这些风险。

1.相关政策和立法

目前大量 AI 公司都集中在应用开发领域,而专注于 AI 安全研究,尤其是原创性技术研究的公司屈指可数。因此,通过相关政策和立法,引导AI对抗技术的商业化落地和AI安全市场的发展,是加强网络安全的重要途径之一,也是促进AI技术应用和推广的安全保障。

而对公民隐私权的保护也是相关部门需要考虑的问题,人脸数据泄露相关的丑闻不断曝出,政府应该制定相应的法律规定,处罚相关的行为,指导相关技术的使用,促进人脸识别行业规范化运作,避免滥用问题的产生。

2.人工监督

英国警方的案例中可以看到人脸识别技术在真实环境中的准确率远低于预期,甚至有无辜群众被误抓,这种现象会给当事人的心理带来很大的负面影响,也会造成社会各界对人工智能技术的质疑。因此,在需要极高识别准确率的领域中适当引入人工审核、监督也能够提高人脸识别技术的易用性、可靠性。

3.改进人脸识别算法

该领域还在快速发展当中,目前最先进的算法甚至可以将侧面照片与数据库中的正面照片比对并正确识别人脸,但是由于现实环境的不可控性,以及对抗攻击等因素,人脸识别算法还需要进一步完善。

4.数据治理

目前的人工智能是数据驱动的,人脸识别算法需要大量的人脸数据进行训练、验证和测试。研究人员和使用者需要注意其中的数据分布、质量、隐私等问题,确保数据分布均匀,才能使模型尽可能的公平公正,不产生偏见。而相关企业、单位对人脸识别系统采集到的人脸数据也应加强管理,遵从相关法律、法规,保护用户的隐私。

5.标准制定

Nature文章中这样评论人脸识别技术:“系统在没有对其性能进行适当评估的情况下被引入现实环境应用。[1]”目前缺乏统一的、全面的人脸识别技术测评方法,而正是因为缺乏适当的评估、验证,才会造成人脸识别在现实环境中的失效。应制定相关的测评技术标准,以规范业界对相关技术的测评,确保系统落地的质量。目前和人脸识别相关的标准已陆续发布并实施。上海计算机软件技术开发中心参与的团体标准《人脸识别安全技术规范》,于2021-11-02 发布,并且在2021-11-15实施。

05

总结

在本期文章中我们介绍了人脸识别的技术、风险与治理。

人脸识别近年来在生活中几乎已经无处不在,它最大的特点是易用,只需摄像头即可采集,而不像指纹需要特定设备采集,但同时在它的使用、推广过程中我们也看到了产生了非常多的风险,比较严重的有错误抓捕无辜群众、破解智能手机付款验证等。

由于目前相关法律、技术标准相对滞后,监管部门面临着一些法律规范的适用难题,为应对人脸识别技术与应用中可能存在的违法违规行为和灰色地带,加快相关标准与法律法规的研究制定势在必行。同时研究机构也应当重视AI安全的相关研究,从模型、数据等方面同时加强人脸识别的安全性、可靠性。只有在这些方面同时推进工作,才能有效实现人脸识别应用的风险治理。

参考文献:

[1] Is facial recognition too biased to be let loose? https://www.nature.com/articles/d41586-020-03186-4

[2] T/AII 001-2021. 人脸识别安全技术规范

[3] Fussey, P. & Murray, D. Independent Report on the London Metropolitan Police Service’s Trial of Live Facial Recognition Technology (Univ. Essex, 2019).

[4] Buolamwini, J. & Gebru, T. Proc. Mach. Learn. Res. 81, 77–91 (2018).

[5]Raji, I. D. et al Saving Face: Investigating the Ethical Concerns of Facial Recognition Auditing. https://arxiv.org/abs/2001.00964 (2020).

[6]Szegedy C , Zaremba W , Sutskever I , et al. Intriguing properties of neural networks. Computer Science, 2013.

[7]Martin Abadi, Ashish Agarwal, Paul Barham, et al. TensorFlow: Large-scale machine learning on heterogeneous systems,2015. Software available from tensorflow.org.

[8] Zakharov, E.; Shysheya, A.; Burkov, E. & Lempitsky, V. S. (2019), 'Few-Shot Adversarial Learning of Realistic Neural Talking Head Models.', CoRR abs/1905.08233 .

[9]Thies J , Zollhfer M , Stamminger M , et al. Face2Face: Real-time Face Capture and Reenactment of RGB Videos. 2020.

[10]Li, L.; Bao, J.; Zhang, T.; Yang, H.; Chen, D.; Wen, F. & Guo, B. (2019), 'Face X-ray for More General Face Forgery Detection.', CoRR abs/1912.13458 .

[11]Afchar D , Nozick V , Yamagishi J , et al. MesoNet: a Compact Facial Video Forgery Detection Network. 2018 IEEE International Workshop on Information Forensics and Security (WIFS). IEEE, 2018.

人工智能评测服务

上海市计算机软件测评重点实验室(SSTL)人工智能测评服务面向计算机视觉、语音识别、自然语言处理、推荐与搜索等领域,聚焦人工智能应用过程中的模型功能有效性评估、模型性能评估、数据集质量评估、对抗样本防御能力等,提供全方位的测评服务,保障人工智能应用的质量。

作者信息

1.丁敏捷,硕士、上海计算机软件技术开发中心人工智能治理研究所算法工程师,主要研究方向包括自然语言处理、知识图谱、图数据库等。完成基于BERT的英文语料自动填充系统开发、基于MesoNet的深度伪造人脸检测系统开发,参与上海人工智能技术协会计算机视觉团体标准、自然语言处理评测标准研制,在ICTAI 2019与KSEM 2021学术会议发表学术论文2篇。

2.陈敏刚,研究员、博士、上海计算机软件技术开发中心人工智能治理研究所执行所长、上海市计算机软件评测重点实验室副主任、软件工程研究所副所长,ISO/IEC JTC1 SC42国际人工智能标准化专家、上海市科技发展重点领域技术预见专家组专家,上海市科技进步特等奖获得者,完成十多项人工智能与大数据的国家标准研制,在国内外期刊杂志发表学术论文40多篇。

上海市计算机软件评测重点实验室(简称SSTL)由上海市科委批准成立于1997年,是全国最早开展信息系统质量与安全测评的第三方专业机构之一,隶属于上海计算机软件技术开发中心。

觉得内容还不错的话,给我点个“在看”呗

我知道你在看哟