点击上方 蓝字关注我们

从star到子图:提升具有局部结构意识的 GNN

https://openreview.net/forum?id=Mspk_WYKoEH

作者:

Lingxiao Zhao, Wei Jin, Leman Akoglu, Neil Shah

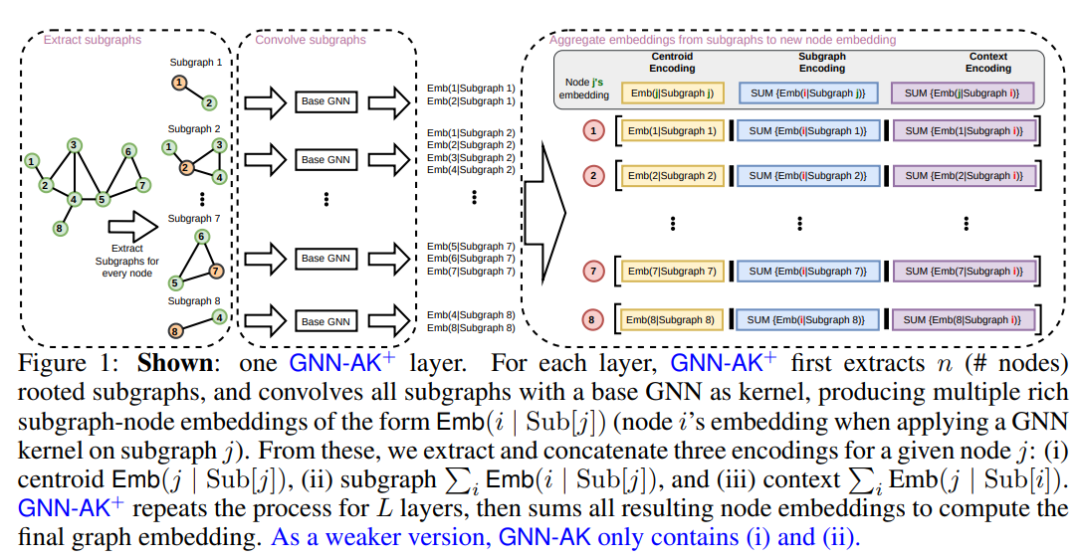

消息传递神经网络 (MPNN) 是图神经网络 (GNN) 的一种常见类型,其中每个节点的表示是通过聚合来自其直接邻居的表示递归计算的,类似于星形模式。MPNN 因其高效和可扩展而吸引人,但它们的表达能力受到一阶 Weisfeiler-Lehman 同构测试 (1-WL) 的限制。先前的工作以可扩展性和有时泛化性能为代价提出了高度表达的模型。

本文的工作介于这两种机制之间:作者引入了一个通用框架来提升 MPNN 以使其更具表现力,同时具有有限的可扩展性开销并大大提高了实际性能。作者通过将 MPNN 中的局部聚合从星型模式扩展到一般子图模式(例如,k-egonet)来实现这一点:在框架中,每个节点表示被计算为周围诱导子图的编码,而不是仅直接邻居的编码(即一个strar)。作者选择子图编码器作为 GNN(主要是 MPNN,考虑到可扩展性)来设计一个通用框架,用作提升任何 GNN 的encoder。本文将提出的方法称为 GNN-AK (GNN As Kernel),因为该框架类似于卷积神经网络,将内核替换为GNN。

从理论上讲,作者证明了该框架比 1&2-WL 更强大,并且不低于 3-WL。作者还设计了子图采样策略,可大大减少内存占用并提高速度,同时保持性能。作者的方法为几个著名的图 ML 任务设置了新的最先进的性能;具体来说,锌上的 0.08 MAE,CIFAR10 和 PATTERN 的准确率分别为 74.79% 和 86.887%。

GLASS:带有Labeling Tricks的 GNN 用于子图表示学习

Xiyuan Wang, Muhan Zhang

GLASS: GNN with Labeling Tricks for Subgraph Representation Learning

https://openreview.net/forum?id=XLxhEjKNbXj

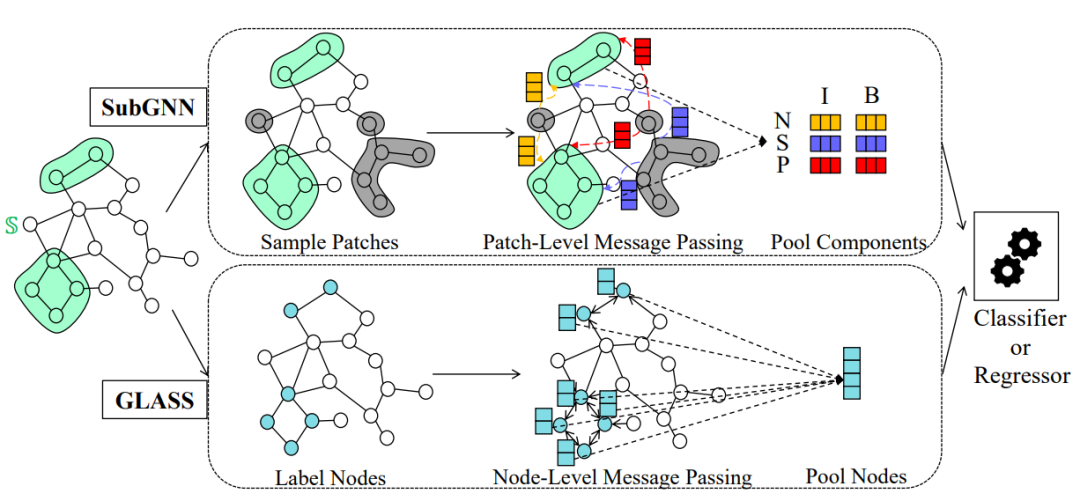

尽管图神经网络 (GNN) 在图表示学习方面取得了显著成就,但很少有作品尝试使用它们来预测整个图中子图的属性。现有的方法 SubGNN 引入了一个过于复杂的子图级 GNN 模型,该模型合成了三个通道,每个通道都有两个精心设计的子图级消息传递模块,但仅略胜于节点级别消息传递。通过分析 SubGNN 和普通 GNN,作者发现子图表示学习的关键可能是区分子图内部和外部的节点。

有了这种见解,作者提出了一种富有表现力和可扩展的标签技巧,即 max-zero-one,以增强子图任务的普通 GNN。生成的模型称为 GLASS(带有用于子图的标签技巧的 GNN)。作者从理论上描述了 GLASS 的表达能力。与 SubGNN 相比,GLASS 更具表现力、可扩展性和更易于实现。对八个基准数据集的实验表明,GLASS 的平均性能优于最强的基准。

等变子图聚合网络

https://openreview.net/forum?id=dFbKQaRk15w

作者:Beatrice Bevilacqua, Fabrizio Frasca, Derek Lim, Balasubramaniam Srinivasan, Chen Cai, Gopinath Balamurugan, Michael M. Bronstein

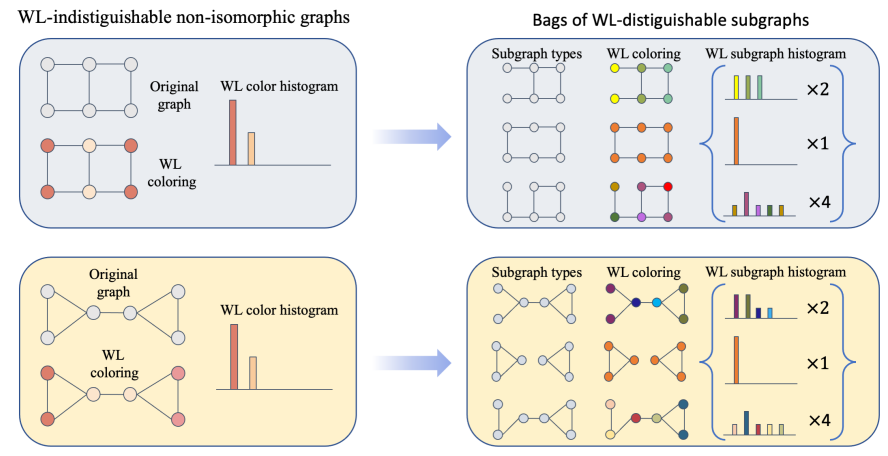

消息传递神经网络 (MPNN) 是图结构数据深度学习的领先架构,这在很大程度上是由于其简单性和可扩展性。不幸的是,结果表明这些架构的表达能力有限。本文提出了一种称为等变子图聚合网络(ESAN)的新框架来解决这个问题。我们的主要观察是,虽然 MPNN 可能无法区分两个图,但它们通常包含可区分的子图。因此,作者建议将每个图表示为一组由某些预定义派生的子图,并使用合适的等变架构对其进行处理。

作者开发了用于图同构的一维 Weisfeiler-Leman (1-WL) 测试的新变体,并根据这些新的 WL 变体证明 ESAN 的表达能力的下限。进一步证明该的方法增加了 MPNN 和更具表现力的架构的表达能力。此外,作者提供了描述子图选择策略和等变神经架构等设计选择如何影响我们架构的表达能力的理论结果。为了处理增加的计算成本,作者提出了一种子图采样方案,可以将其视为框架的随机版本。在真实和合成数据集上进行的一组综合实验表明,作者的框架提高了流行 GNN 架构的表达能力和整体性能。

大家好我们是深度学习与图网络公众号

关注图神经网络,图神经网络的应用,

最新的图学习研究进展

欢迎关注我们