点击上方 蓝字关注我们

Disentangled Contrastive Learning on Graphs

作者:

Haoyang Li (Tsinghua University)Xin Wang (Tsinghua University)Ziwei Zhang (Tsinghua University)Zehuan Yuan (Nanjing University)Hang Li (Huawei Tech. Investment)Wenwu Zhu (Tsinghua University)

Openreview: https://openreview.net/forum?id=C_L0Xw_Qf8M

得分:8/5, 6/4,5/4

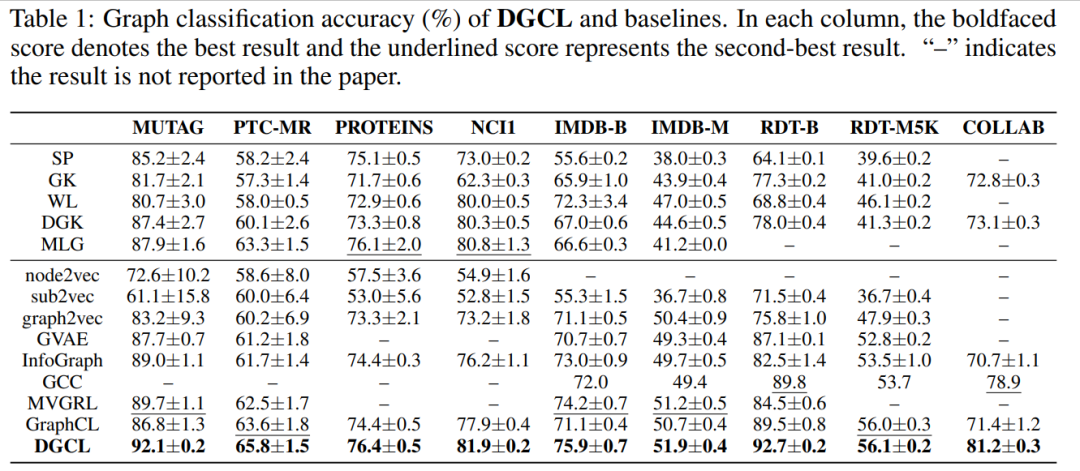

最近,图神经网络(GNN)的自监督学习因其在学习图结构数据表示方面的显着成功而引起了相当大的关注。然而,真实世界图的形成通常源于许多潜在因素的高度复杂的相互作用。现有的 GNN 的自监督学习方法本质上是整体的,并且忽略了潜在因素的纠缠,导致学习到的表示对于下游任务不是最优的并且难以解释。使用自监督学习学习解开的图表示提出了巨大的挑战,并且在很大程度上仍被现有文献忽略。在本文中,作者介绍了 Disentangled Graph Contrastive Learning (DGCL) 方法,该方法能够通过自监督学习解缠结图级表示。特别是,作者首先识别输入图的潜在因素并导出其分解表示。每个分解表示描述了与图的特定潜在因子相关的潜在和解开的方面。然后以对比学习的方式提出了一个新的因子区分目标,它可以强制分解表示独立地反映来自不同潜在因子的表达信息。对合成数据集和真实数据集的大量实验证明了方法相对于几个最先进的基线的优越性

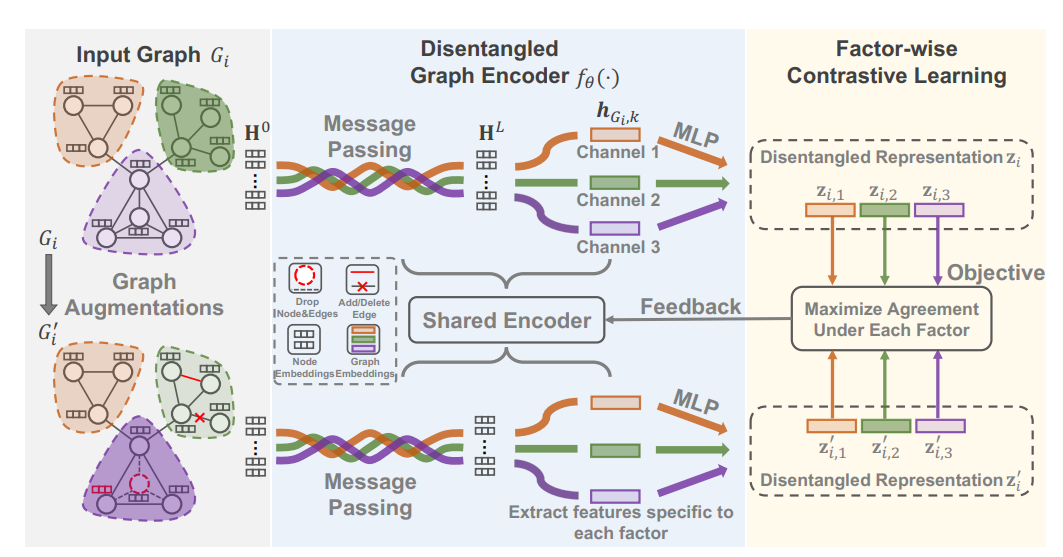

GCL模型的框架。(1) 图增强以产生 Gi ,并且它们都馈送到共享Disentangled 图编码器 fθ(·)。(2)在编码器fθ(·)中,节点特征H0首先由L个消息传递层聚合,然后作为多通道消息传递层的输入。(3) 基于Disentangled 图表示 zi ,逐因子对比学习旨在最大化每个潜在因子下的一致性,并为编码器提供反馈以改善解缠结。这个例子假设有三个潜在因素,因此三个通道.

Review 1 8/5

本文提出了一种Disentangled 图对比学习模型(DGCL),这是研究Disentangled 自监督图表示学习的第一项工作。作者解决了现有自监督方法采用整体方式学习图表示的重要问题,同时在很大程度上忽略了现实世界图中潜在因素的纠缠。具体来说,首先,作者设计了一个新的Disentangled 图编码器来生成分解图表示。该编码器能够学习Disentangled 的潜在因素并捕获图的多个方面。然后,DGCL 提出了一种新的因子对比算法,以独立地解决针对每个潜在因子的定制判别任务。它可以鼓励学习的表示具有表现力和Disentangled 。为了解决重要的推理和学习问题,DGCL 引入了具有理论贡献的期望最大化 (EM) 算法的可扩展变体。对合成数据集和真实数据集的大量实验证明了该方法在多个基线上的优越性。

Review 2 6/4

本文将Disentangled 学习的思想引入到图表示中。为了鼓励表示具有独立的子组件,作者使用 k 个单独的 GNN 输出通道,并在建模过程中使用通道分配作为潜在因素。作为一种无监督学习方法,对比学习被考虑。总体而言,该设置是新颖的,并且论文提出了完整且实用的优化算法。但是,我有以下问题:由于Disentangled 表示是本文的主要追求之一,因此不考虑 Beta-VAE 和因子-VAE 等经典的解缠结表示学习方法。实验中使用的图的大小适中,因此我不确定按照作者的建议考虑是否计算成本太高。事实上,对于本文中的图表示学习问题,甚至不需要图重构。作者提出了类EM算法来优化ELBO。为连续潜变量优化 ELBO 是常见且易于实现的。使用离散通道作为潜在变量的动机是什么?

第 148 行:论文声称其他图编码器本质上是整体的。这里整体的定义是什么?

为什么所提出的方法不如 WL-kernel 等其他经典方法那么全面?

在图 4 中,(c) 显示了清晰的逐块对角线模式,但同时每个块之间的相关性并不明显小于 (a) 和 (c)。仔细一看,好像比(b)还差。如果学习到的表示很好地解开,我预计每个块之间的相关性会小得多。

Review 3 5/4

本文研究了图的自监督学习。关键思想是将对比学习与Disentangled 相结合。具体来说,作者定义了不同的因素来DisentangleZi 不同组中的潜在嵌入。然后作者从原始图生成增强样本,并为学习图表示施加因子级对比损失。作者在几个图分类基准上评估了该方法,并显示了对几种基线方法的改进。该方法是合理的,但新颖性有限。图表示学习的对比学习思想已经被一些作品探索过,数据增强技术是从现有作品中借用的[49]。本文的主要扩展是将潜在嵌入 Zi 划分为不同的因素/组。此扩展的技术新颖性有些有限。另一个问题是为对比学习生成正负样本。作者按照 [49] 生成增强图,使用四种不同类型的图增强策略:节点删除、边缘扰动、属性屏蔽和子图采样。这种技术可能适用于通用的全局级图形数据增强。然而,为了生成按因子增强的样本,这种扰动很可能会使生成的样本在考虑的某些因素方面与原始图不同。实验结果总体上是相当积极的。作者将他们的方法与图核方法、图嵌入方法和最近几个学期的图对比学习进行了比较。他们在几个基准测试中表现出持续的改进。但是,如果作者能展示Disentangled结模块学到的潜在因素是什么会更好.