点击上方 蓝字关注我们

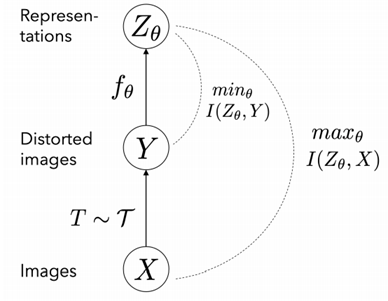

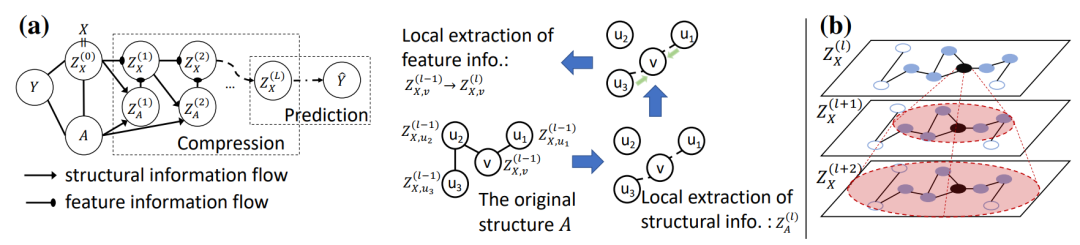

Information bottleneck: 给定输入数据X和标签Y,信息瓶颈(IB)原则旨在发现潜在表示 Z, 使其同时满足:(1)对于Y而言信息量最大(Sufficient);(2)包含尽可能少的输入数据X的信息(Minimal)。

论文名称:Graph information bottleneck(NeurIPS'20)

https://arxiv.org/abs/2010.12811

作者:Tailin Wu, Hongyu Ren, Pan Li, Jure Leskovec

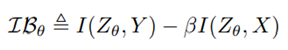

图神经网络 (GNN) 提供了一种有效融合网络结构和节点特征信息的表达方式。然而,GNN 容易受到对抗性攻击。针对此问题,本文基于传统信息论中Information bottleneck (IB)提出了图信息瓶颈 (GIB),即最大化表示和目标之间的互信息,同时约束表示和输入数据之间的互信息来学习得到给定任务最小的sufficient表示。与一般的 IB 不同的是GIB 对结构和特征信息进行了正则化。文中设计了两种用于结构正则化的采样算法,并提出两个新模型实例化 GIB 原理:GIB-Cat 和 GIB-Bern。实验证明,该模型对图结构和顶点属性均具有更强的抗扰动性。

论文名称:使用子图信息瓶颈预测可识别的子图(ICLR'21)

Recognizing Predictive Substructures with Subgraph Information Bottleneck

https://arxiv.org/abs/2103.11155

作者: Junchi Yu, Tingyang Xu, Yu Rong, Yatao Bian, Junzhou Huang, Ran He

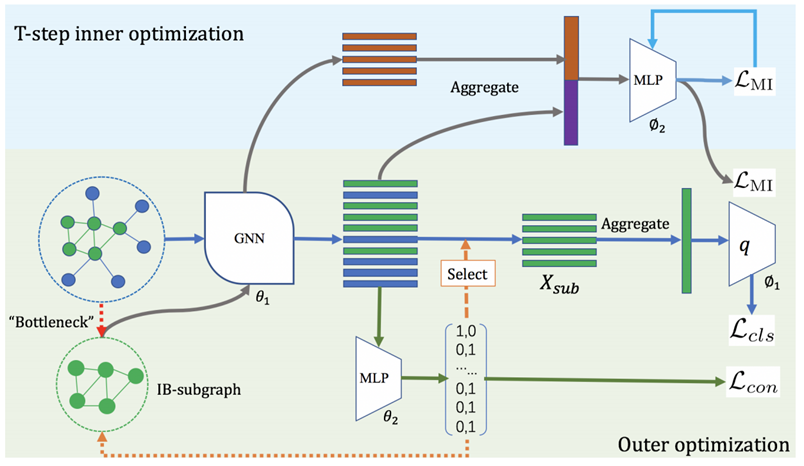

图卷积网络(GCN)的出现极大地推动了图学习的进步。然而,图数据中的噪声和冗余以及预测结果的可解释性差阻碍了GCN的进一步发展。受信息瓶颈(IB)原则的启发,本文提出了一种新颖的子图信息瓶颈(SIB)框架来识别此类子图,称为 IB-subgraph。由于互信息难通常难以处理且图数据往往具有离散性,难以对SIB 的目标函数进行优化。为解决此问题,文中结合不规则图的互信息估计器引入了一种双层优化方案。此外,在connectivity loss中选择子图部分采用连续松弛,从而提高模型的稳定性。文章从理论上证明了互信息估计方案的误差界限和 IB 子图的噪声不变性。

论文名称:利用对抗性图增强改进图对比学习(arxiv'21)

Adversarial Graph Augmentation to Improve Graph Contrastive Learning

https://arxiv.org/abs/2106.05819

作者:Susheel Suresh, Pan Li, Cong Hao, Jennifer Neville

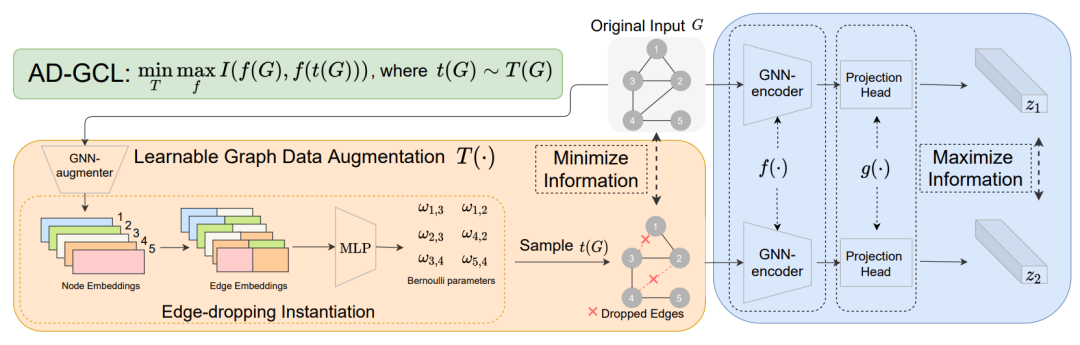

图对比学习 (GCL) 通过最大化相同图在不同增强形式中表示之间的对应关系,能够在无标签的情况下训练得到稳健且可转移的GNN。然而,由传统 GCL 训练的GNN容易提取出冗余的图特征,降低模型的鲁棒性且严重阻碍特征应用在下游任务上的效果。针对这些问题,本文提出了一种新的原则,称为对抗性GCL (AD-GCL),它使GNN 能够通过优化 GCL 中使用的对抗性图增强策略来避免在训练期间捕获冗余信息。文中通过理论分析解释AD-GCL原则,并基于AD-GCL实例化了一个可训练的edge-dropping图增强模型。通过与SOTA图对比学习方法比较,AD-GCL在无监督学习、转移、和半监督学习中分别实现了14%,6% 和3%的性能提升。

往期推荐