点击上方 蓝字关注我们

对图结构化数据的通用性,可传递性和鲁棒性表示学习仍然是当前图神经网络(GNN)面临的挑战。与针对卷积神经网络(CNN)开发的图像数据不同,针对GNN的自我监督学习和预训练的探索较少。在本文中,作者提出了一种图对比学习(GraphCL)学习框架,用于学习图数据的无监督表示。首先设计四种类型的图扩充,以结合各种先验。然后,在四种不同的情况下系统地研究图扩充的各种组合对多个数据集的影响:半监督,无监督和迁移学习以及对抗攻击。

结果表明,即使不调参或不使用复杂的GNN架构,与最新方法相比,GraphCL框架也可以生成具有相似或更好的通用性,可传递性和鲁棒性的图表示。

Code:https://github.com/Shen-Lab/GraphCL

Paper: https://arxiv.org/abs/2010.13902

Appendix: https://yyou1996.github.io/files/neurips2020_graphcl_supplement.pdf

本文指出GNN预训练有一定的必要性,但也提出之前预训练的方法存在一些问题,“这种过于强调邻居的方案并不总是有益处的,还可能会损害结构信息”。so,需要一个设计合理的预训练框架来捕获图结构数据中的高度异构信息。

本文贡献

在本文中,针对GNN的预训练,作者提出了具有增强功能的对比学习,来解决图中数据异质性问题。

对比学习(Contrastive Learning):在适当的变换下使得表现形式彼此一致。通过在不同的扩充view下最大化特征的一致性来学习表示,而这些view是在保持特征不变性的情况下通过特定于数据或者任务的扩充手段获得。对于图数据而言,尝试重建顶点的传统方法被视为一种局部对比,而过分强调邻接信息却同时也受邻接信息所制约。

数据增强(Data Augmentation):通过应用某些合理的转换,在不影响语义标签的情况下创建新颖而现实的数据

图的数据增强

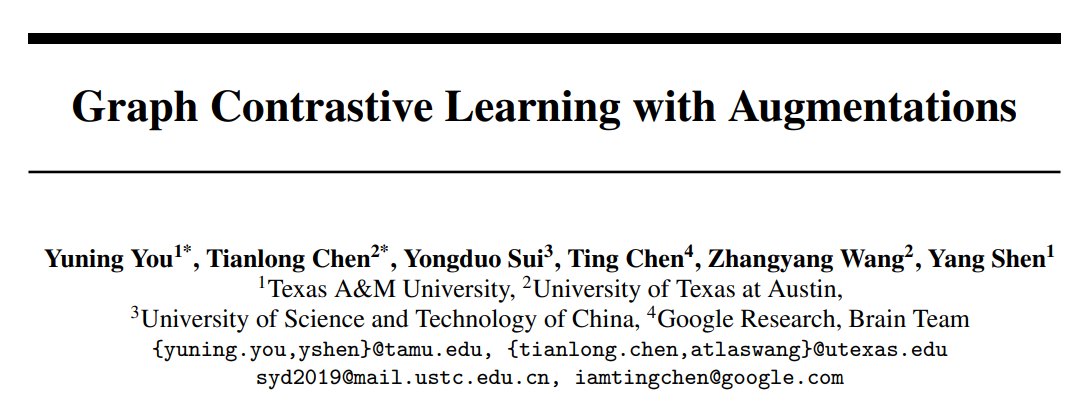

数据扩充的目的是在不影响语义的前提下,通过应用一定的转换来生成新颖的、合理的数据。除了一些计算代价昂贵的图外,对图数据增强目前研究还不够深入。图数据集来自不同领域,较难获取图中直观且通用的图数据增强方式。下图是本文总结的4种数据增强手段:

Node dropping:随机从图中去除掉部分比例的节点来扰动G图的完整性,每个节点的失活概率服从i.i.d的均匀分布;

边扰动:随机增加或删除一定比例的边来扰动G G的连通性,每个边的增加或者删除的概率亦服从i.i.d的均匀分布;

属性屏蔽:随机去除部分节点的属性信息,迫使模型使用上下文信息来重新构建被屏蔽的顶点属性。

子图划分:使用随机游走的方式从G GG中提取子图的方法。

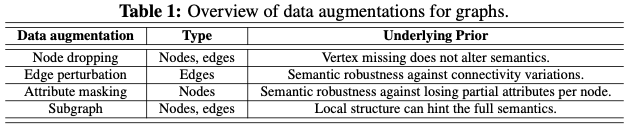

有以下3种方法。

图对比学习GraphCL

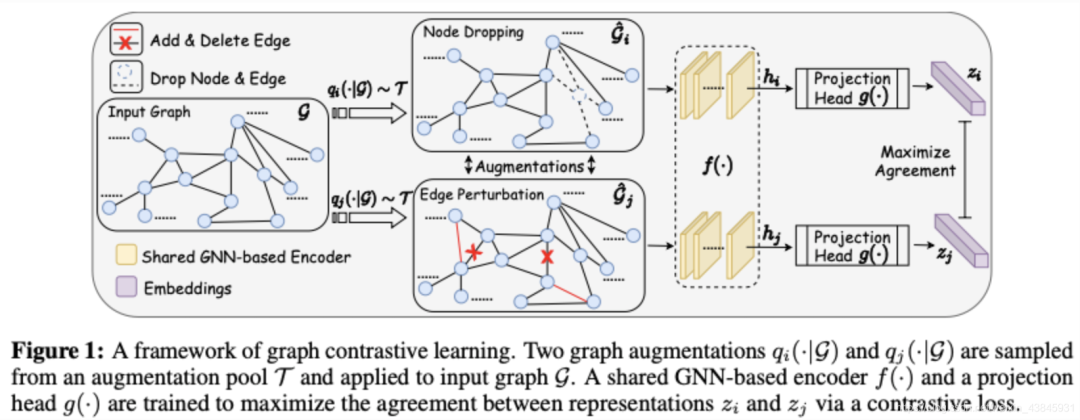

如下图所示,通过潜在空间中的对比损失来最大化同一图的两个扩充view之间的一致性,来进行预训练。

模型由4部分组成:

图数据增强

基于GNN的编码器:GNN范式,先聚合邻居再readout成图的embedding;

投影:使用双层MLP表示;

Contrastive loss:,使得与负样本对相比正样本对之间的一致性最大化(这里是指的两种数据增强方式之间的一致性)损失函数加入了temperature parameter,最终损失是在小批量中所有正对之间的和表示。

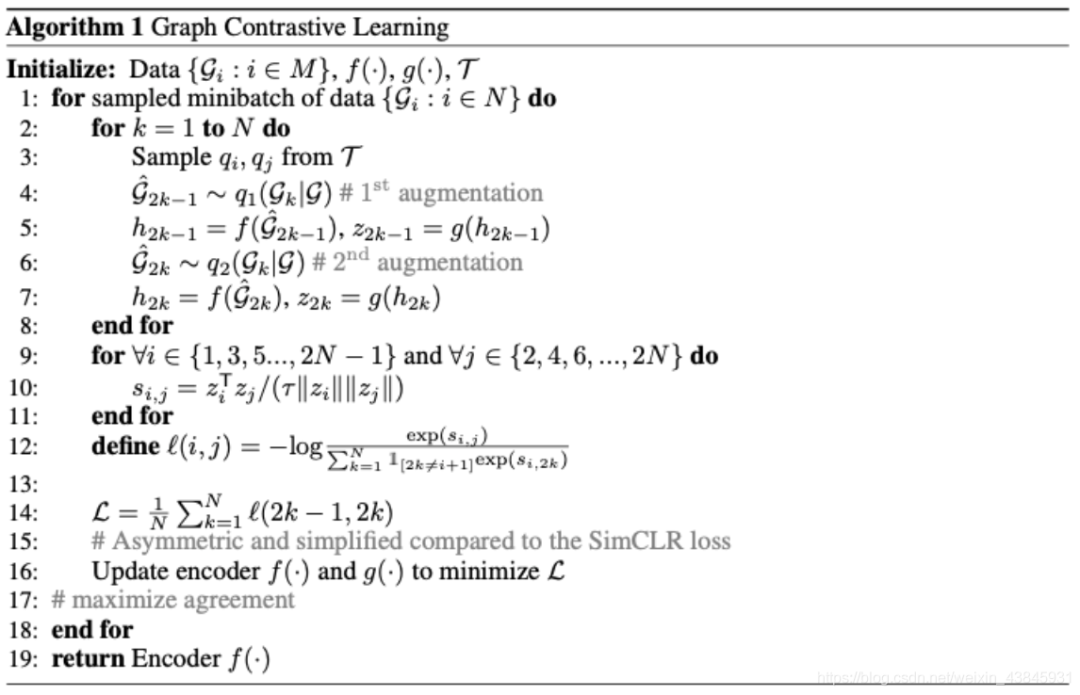

算法流程图如下:

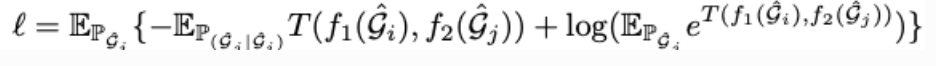

GraphCL可以被视为两种增强图的潜在表示之间相互信息最大化的一种方式,见附录F,这里不提供详细介绍。损失改写如下:

上述loss本质为最大化的互信息下界。此外,通过重新解释上式,可以将GraphCL重写为一个通用框架,以统一针对图结构化数据的对比学习方法。

图对比学习中数据增强扮演的角色

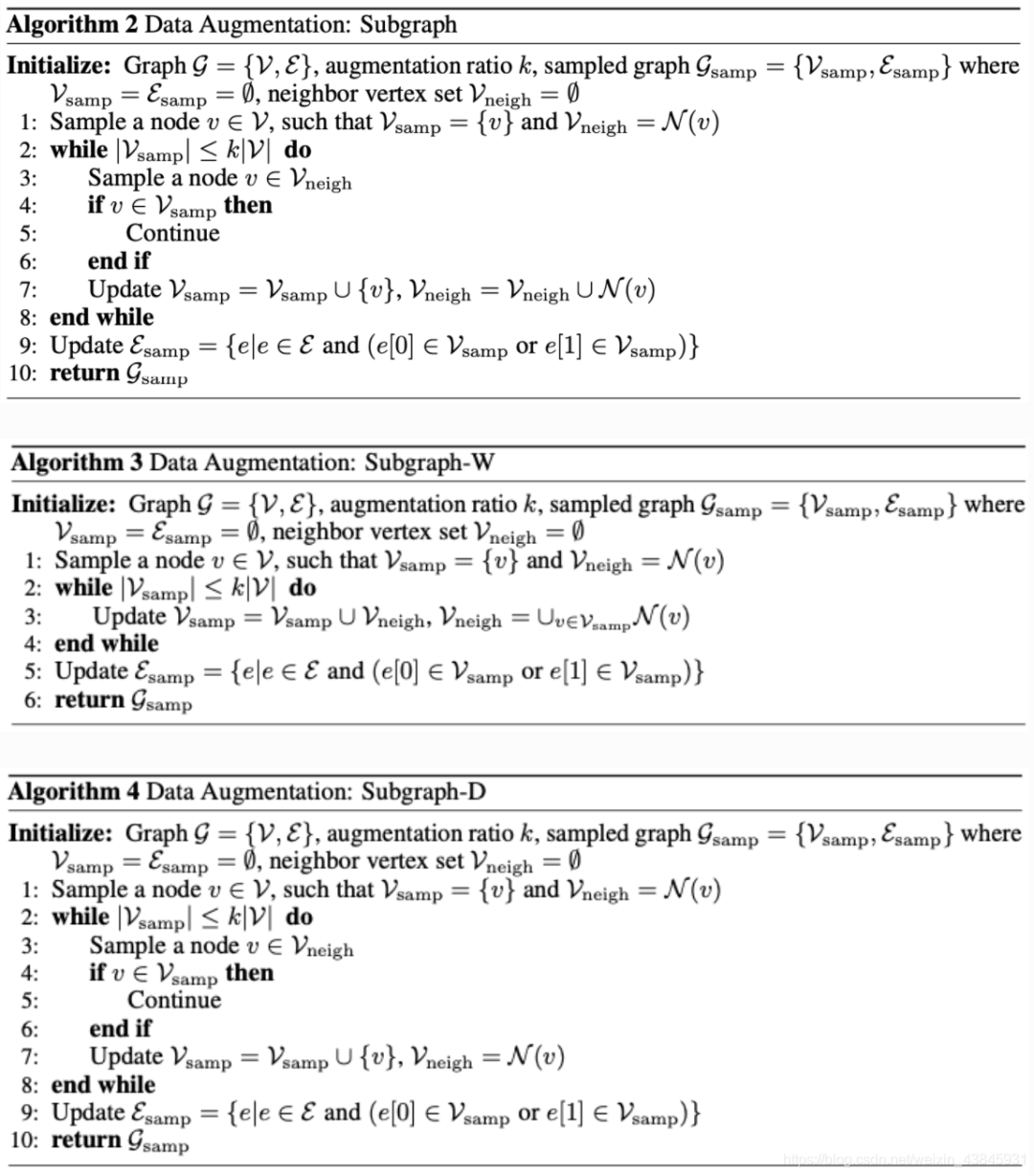

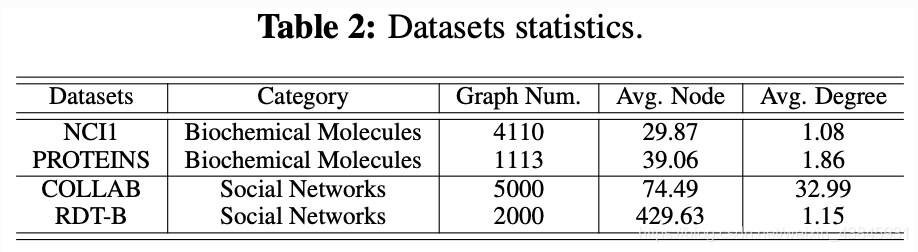

数据集介绍见下表。

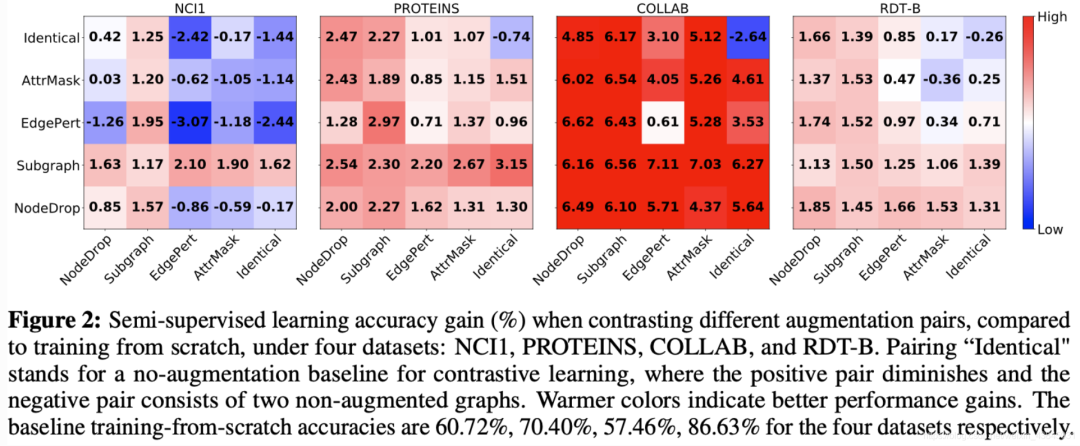

本节评估了GraphCL框架中图的数据增强作用。如图所示,以半监督人物为例,横轴、纵轴分别表示框架图中的两个增强方式的具体实施方案,其中Identical表示原图数据,不同的数值变化表示相比于与baseline之间的精度波动。

我们可以看到一些有趣的现象:

数据扩充对图对比学习至关重要。当应用适当的扩充时,会灌输数据分布上的相应先验,从而通过最大化图及其扩充之间的一致性来使模型学习对所需扰动不变的表示。

组合不同的扩充方式会带来更多的性能收益。与图中对角线的增益相比,最优的增益往往在应用不同的数据扩充方式进行对比学习时获得。这点在视觉对比学习任务中也有类似的结论,组合不同的扩充方式会避免学习到的特征过于拟合low-level的"shortcut",从而使得特征更加的具有通用性。此外,训练不同的特征之间的对比学习模型会使得收敛速度下降。

有效图扩充的类型、范围和模式

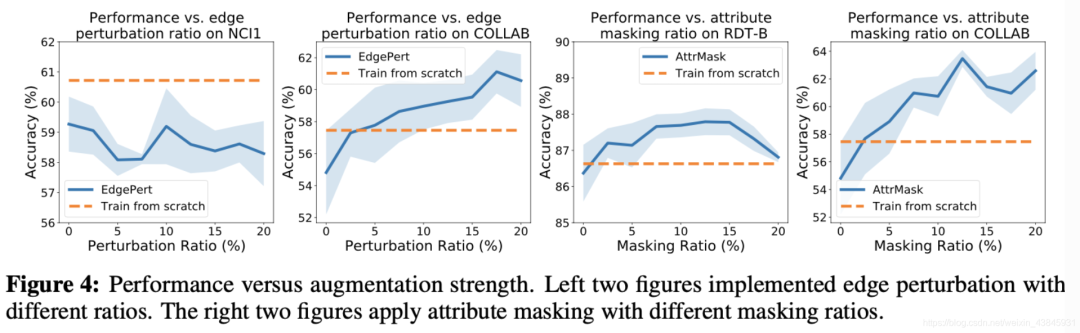

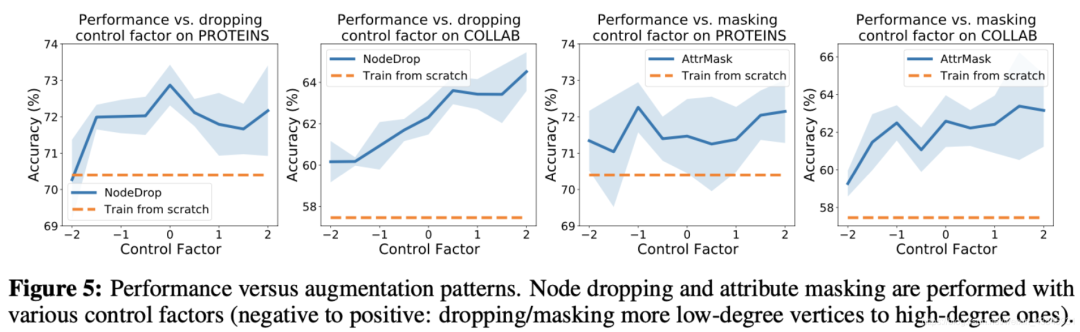

直接上实验和结论:

(1)边缘扰动有益于社交网络,但会伤害一些生化分子图。这取决于边的重要程度(图4左2)。

应用属性masking可在更密集的图中实现更好的性能(图4右2)。

(2)节点删除和子图通常对图数据集有益。节点删除在丢失某些顶点不会更改语义信息的先验条件下直观的迎合了我们的认知。子图刻意增强局部(即子图)和全局信息的一致性有助于表示学习。

(3)过于简单的对比任务无济于事

在本文中,作者探索针对GNN预训练的对比学习。首先,提出了几种图数据扩充方法,并介绍某些特定的数据分布先验的基础上进行了讨论。随着新的扩充,作者为GNN预训练提出了一种新颖的图对比学习框架(GraphCL),以促进不变表示学习以及严格的理论分析。作者系统地评估和分析了提出的框架中数据扩充的影响,揭示了其原理并指导了扩充的选择。实验结果验证了提出的框架在通用性和鲁棒性方面的最新性能.