导读:图卷积可以看做是拉普拉斯平滑的近似,这是一个优点也是缺点,图卷积正是通过这种平滑学习到了邻居的关系,融合更多有用的信息,获得了非常好的性能(在同源类的网络上),但是进行多次平滑之后,同一个连通部分的区域内的节点特征越来越相似,矩阵的rank降低,最终收敛到一个固定的值,这降低了节点表征的区分度或者说不存在区分性了,到目前为止有很多相关工作在解决这样的问题,之前小编也整理了一些,今天继续这里学习一下ICML'20中的三篇论文以及KDD中的一篇论文,最后一篇也可以参考一下。更多精彩内容:图优化|如何解决图神经网络(GNN)训练中过度平滑(oversmoothing)的问题?

1.Continuous Graph Neural Networks

https://arxiv.org/pdf/1912.00967.pdf

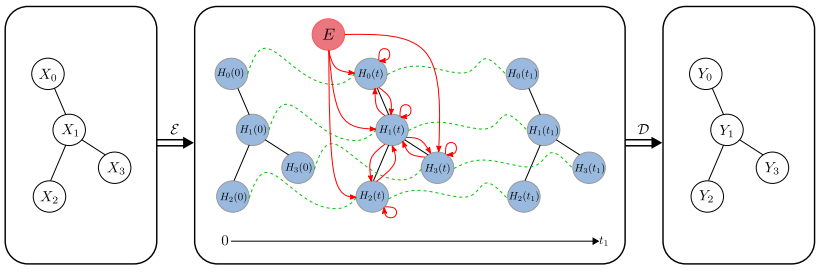

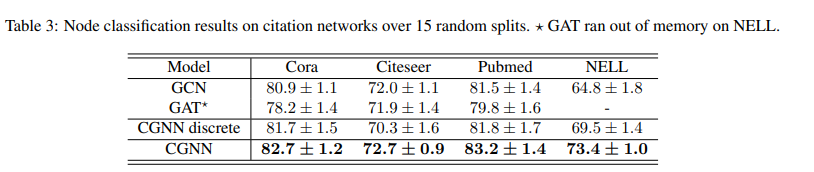

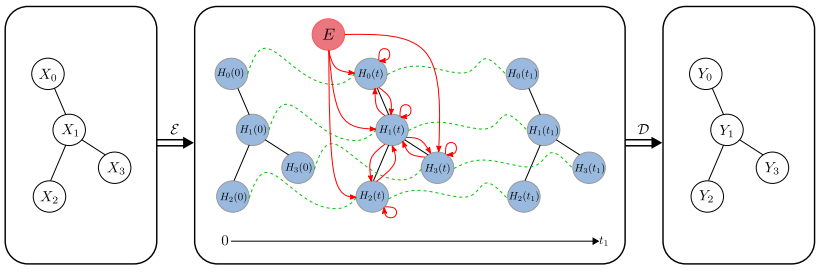

ICML'20本文建立在图神经网络与传统动力系统联系之上。作者提出了连续图神经网络(Continuous Graph Neural Networks,CGNN),它可以将现有的具有离散动力学的图神经网络进行泛化,(GCN等可以被看做是特定离散化方案)。本文的关键点是如何表征节点表示的连续动态性,即节点表示的导数(w.r.t.时间)。受图上现有的基于扩散的方法(例如社交网络上的PageRank和流行模型)的启发,作者将导数定义为当前节点表示形式,邻居表示形式和节点的初始值的组合。本文提出并分析了图上的两种可能的动力学-包括节点表示的每个维度(也称为特征通道)独立变化或彼此交互-两者都有理论上的依据。所提出的连续图神经网络对于过度平滑具有鲁棒性,因此能够构建更深的网络,从而能够捕获节点之间的远程依存关系。

模型的输入是具有节点特征的图,最初使用单个神经网络层对这些节点特征进行编码,而忽略了图结构。然后,使用另一单层神经网络和softmax函数获得logit,接着使用微分方程更改表示形式。红线代表ODE定义的信息传输。

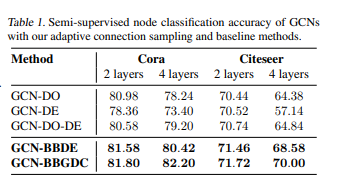

2.Bayesian Graph Neural Networks with Adaptive Connection Sampling

https://arxiv.org/abs/2006.04064

ICML'20作者为图神经网络(GNN)中的自适应连接采样(adaptive connection sampling)提出了一个统一的框架,该框架概括了用于训练GNN的现有随机正则化方法。所提出的框架不仅减轻了深层GNN的过度平滑和过度拟合的趋势,而且使使用GNN进行图分析任务时具有不确定性的学习成为可能。本文不使用现有的固定采样率或在随机正则化方法中手动调整它们作为模型超参数,而是提出了自适应连接采样,可以与GNN模型参数一起以全局和局部方式进行训练。具有自适应连接采样的GNN,在训练上等效于训练贝叶斯GNN的有效近似。在基准数据集上进行消融研究表明,自适应学习采样率是提高GNN在半监督节点分类的关键,并且它不易出现过度平滑和过度拟。3. Simple and Deep Graph Convolutional Networks

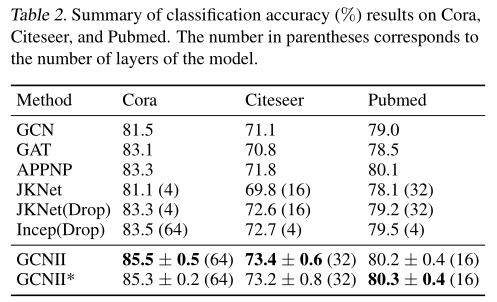

https://proceedings.icml.cc/book/3586.pdfICML'20图卷积网络(GCNS)是一种强大的图结构数据深度学习方法。最近,GCNS及其变体在真实数据集上的各个应用领域都显示出了优异的性能。尽管取得了成功,但由于过平滑的问题,目前的大多数GCN模型都很浅。本文研究了深图卷积网络的设计与分析问题。提出了GCNII模型,它是对普通GCN模型的扩展,使用了两个简单而有效的技术:初始残差和恒等映射(Identity mapping),作者提供了理论和实验证据,证明这两种技术有效地缓解了过平滑问题。实验表明,深度GCNII模型在各种半监督和全监督任务上的性能优于最先进的方法。

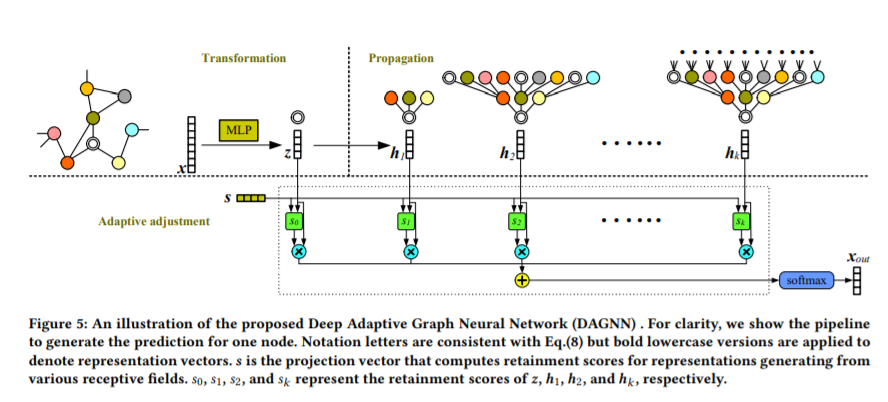

4.Towards Deeper Graph Neural Networkshttps://arxiv.org/abs/2007.09296 KDD'20图神经网络在图表示学习领域取得了显著的成功。图卷积执行邻域聚合,并表示最重要的图运算之一。然而,这些邻域聚合方法的一层只考虑近邻,当进一步启用更大的接受域时,性能会下降。最近的一些研究将这种性能下降归因于过度平滑问题,即重复传播使得不同类的节点表示无法区分。在这项工作中,作者系统地研究这一观察结果,并对更深的图神经网络发展新的见解。本文首先对这一问题进行了系统的分析,认为当前图卷积运算中表示变换与传播的纠缠是影响算法性能的关键因素。将这两种操作解耦后,更深层次的图神经网络可用于从更大的接受域学习图节点表示。在建立深度模型时,进一步对上述观察结果进行了理论分析,这可以作为过度平滑问题的严格而温和的描述。在理论和实证分析的基础上,提出了深度自适应图神经网络(DAGNN),以自适应地吸收来自大接受域的信息。一组关于Citation、合著和共购数据集的实验证实了我们的分析和见解,并展示了提出的方法的优越性。

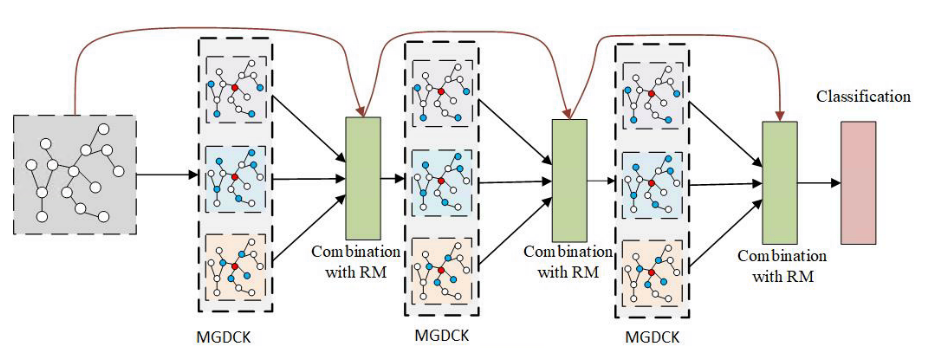

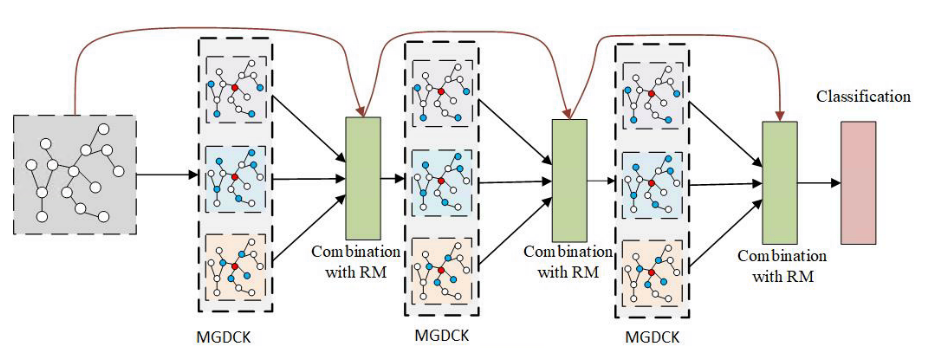

5. Graph Dilated Network with Rejection Mechanism

https://www.mdpi.com/2076-3417/10/7/2421最近,图神经网络(GNN)在处理基于图的数据方面取得了巨大的成功。GNN的基本思想是迭代地汇总来自邻居的信息,这是拉普拉斯平滑的一种特殊形式。但是,大多数GNN都陷入了过度平滑的问题,即,当模型更深入时,学习到的表示就变得难以区分了。这反映了当前的GNN无法探索全局图结构。在本文中,作者提出了一种新颖的图神经网络来解决这个问题。设计了一种拒绝机制来解决过度平滑的问题,并提出了一种扩张的图卷积核来捕获高级图结构。大量实验结果表明,所提出的模型优于最新的GNN,并且可以有效克服过度平滑的问题。