图上信息如何聚合以及如何学习他们之间的相互影响至关重要,本次推文学习三篇图上信息相互作用相关的文章,第一篇利用特征和结构的互信息进行无监督的表示学习,其中非常重要的一点是对global mi的分解;第二篇认为GCN进行信息聚合的时候没有考虑到非独立同分布的情况,因此提出了一种通过邻居节点表示的成对交互来增加加权和。第一篇侧重中心节点与邻居的关系,第二篇侧重邻居和邻居的关系,最后一篇偏应用一些,这里不多介绍,三篇都是A类会议,已经公开,感兴趣的同学请查看原文。

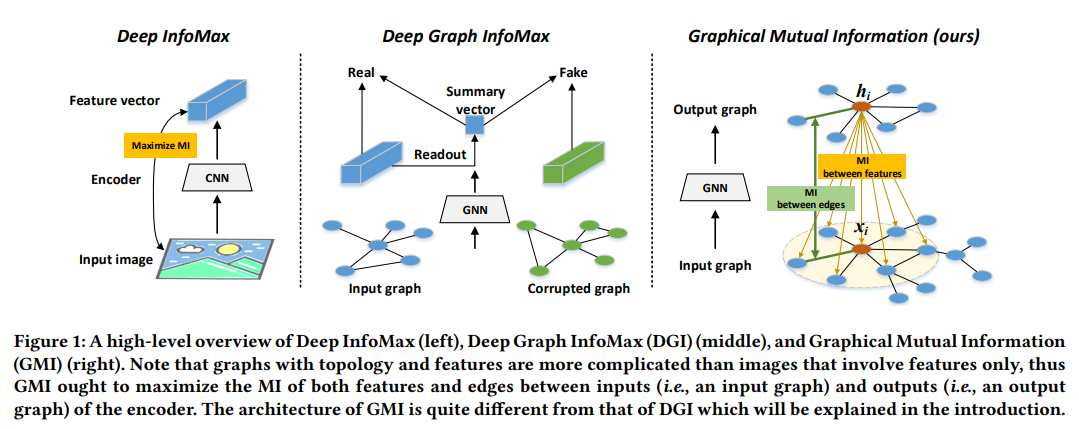

WWW'20 本文研究如何以无监督的方式将图数据中大量信息保存并嵌入到空间中。为此,提出了一个新概念:图互信息(GMI),用于测量输入图和隐藏表示之间的相关性。GMI在图数据中引入在其他领域中常用的互信息,考虑了节点特征和拓扑结构的两个方面的互信息。

GMI具有几个优点:首先,它对于输入图的同构变换( isomorphic transformation)是不变的(也就是说如果图是同构的只是编号不一样,那么计算得到的MI不应该有差别);此外,可以通过目前已有的互信息方法(如MINE)有效地进行估计和最大化。最后,理论分析证实了其正确性和合理性。借助GMI,本文设计了一种无监督的学习模型,该模型通过最大化图神经编码器的输入和输出之间的GMI来训练。

图:Deep InfoMax(左),Deep Graph InfoMax(DGI)(中)和图形互信息(GMI)(右)。拓扑结构和特征的图要比仅包含特征的图更为复杂,因此GMI应该使编码器的输入(即输入图)和输出(即输出图)之间的特征和边缘的MI最大化。GMI的体系结构与DGI的结构有很大不同。

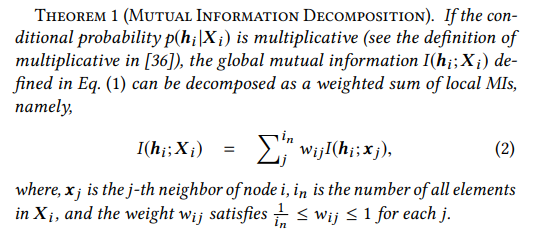

Feature Mutual Information(最大化hi和邻居的互信息)

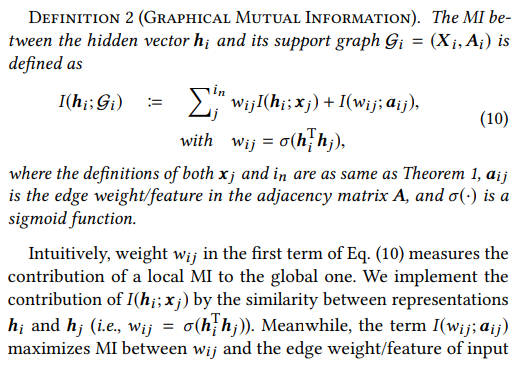

Topology-Aware Mutual Information

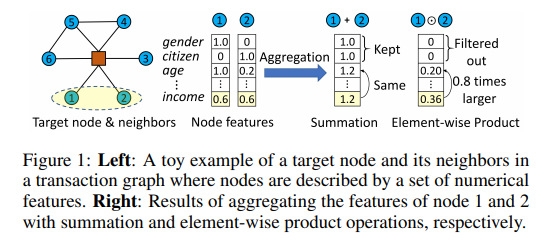

IJCAI'20 图神经网络将图卷积定义为所连接节点的特征的加权总和,以形成目标节点的表示形式。然而,加权和的运算假设相邻节点彼此独立,并且忽略它们之间可能的相互作用。

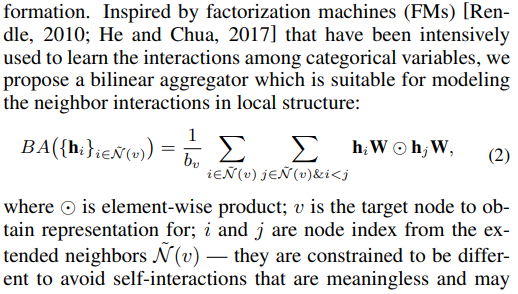

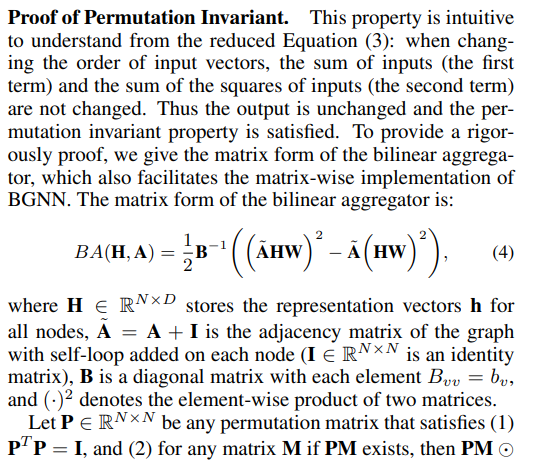

当存在这样的相互作用时,例如两个相邻节点的同时出现是目标节点特征的强烈信号,则现有的GNN模型可能无法捕获该信号。这项工作认为在GNN中对相邻节点之间的交互进行建模的重要性。提出了一种新的图卷积算子,该算子通过邻居节点表示的成对交互来增加加权和。将此框架称为双线性图神经网络(BGNN),它通过相邻节点之间的双线性交互作用来提高GNN表示能力。

BGNN Model

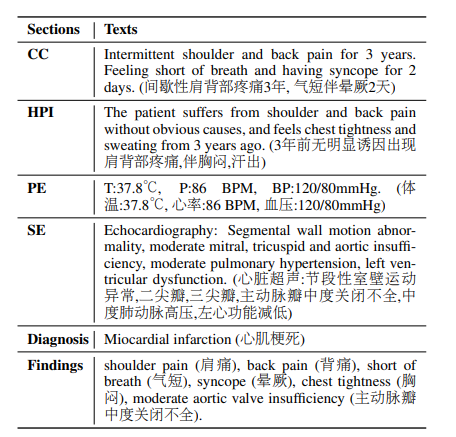

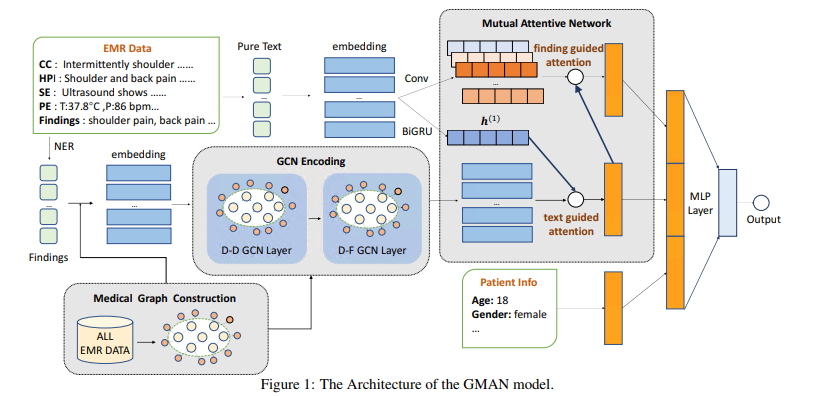

自动诊断一直受困于缺乏可靠的语料库来训练可信赖的预测模型的问题。此外,大多数基于深度学习的诊断模型都采用序列学习技术(CNN或RNN),难以提取复杂的结构信息,例如关键医疗实体之间的图结构。在本文中,作者建议基于真实医院的高标准EMR文档构建诊断模型,以提高结果模型的准确性和可信度。同时,将图卷积网络引入该模型中,以减轻稀疏特征问题并促进结构信息的提取以进行诊断。此外,提出了相互关注的网络,以增强输入的表示,以实现更好的模型性能。在实际的EMR文档上进行的评估表明,与以前的基于序列学习的诊断模型相比,所提出的模型更为准确。所提出的模型已集成到中国数百家初级卫生保健机构的信息系统中,以协助医生进行诊断过程。