本文继续介绍三篇ICML2020与Graph相关的论文,涉及minCUT pooling, GNN的通用性分析, 多视角对比学习,每一篇论文都非常的精彩,值得学习,以下内容仅供参考,如果疏漏和错误,欢迎指出。1. ICML2020 Spectral Clustering with Graph Neural Networks for Graph Poolinghttps://arxiv.org/pdf/1907.00481.pdf

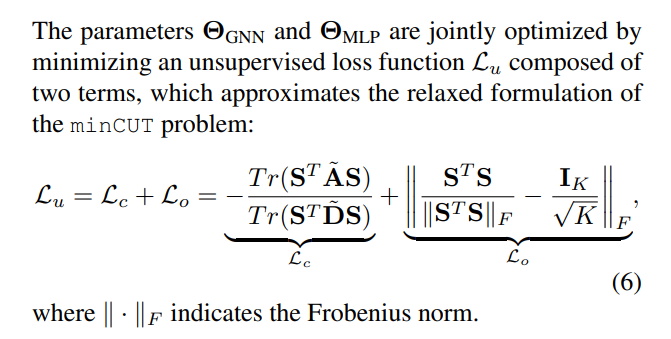

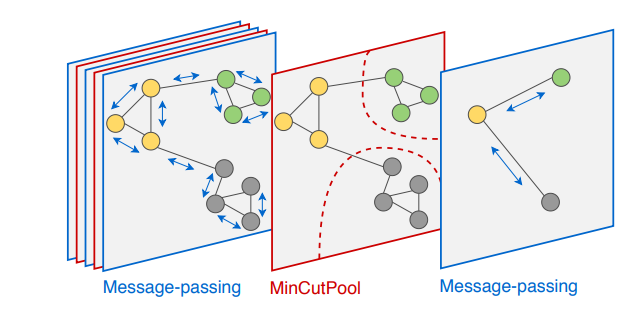

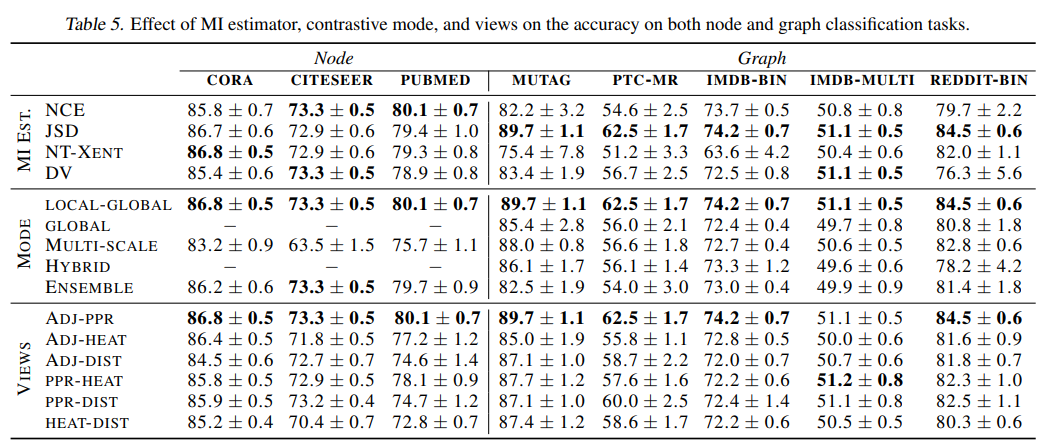

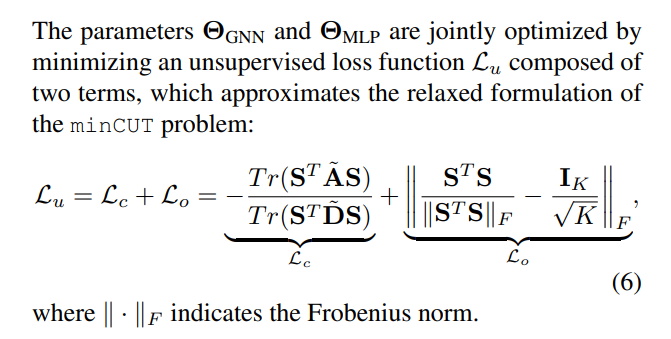

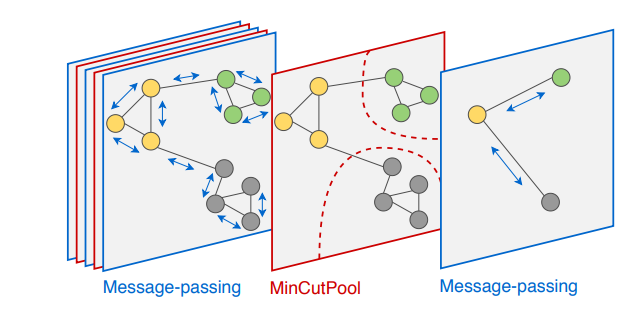

谱聚类(SC)是一种常用的聚类方法,该方法能够根据特征值分解找到联系密切的communities.谱聚类如果用到图网络上,一种自然而然的想法是对联系紧密的communities进行pooling,然后进行下一步的操作。但是谱分解涉及到拉普拉斯矩阵的分解,复杂度非常的高,另外如果pooling完,我们还要继续pooling,需要重新计算一次分解,这个过程是不可导的。另外谱聚类的方法没有用到节点的特征,只是根据拉普拉斯矩阵进行分解的。这篇论文非常巧妙地提出了一种minCUT的方法,可以求导,并且不需要进行谱分解,代码已经公开。具体来看,本文提出了一种最小割的loss作为regularization,也就是下面的公式,其中L_c根据minCUT学习一个assignment matrix,使得联系紧密的communities内部更加紧凑,L_o是一个约束,约束这些assignment matrix之间不要都一样了(正交),不然所有的点都聚在一起了,这里不做过多介绍,有兴趣请查看原文,公众号后期会做进一步详细的解析,尽请关注。2. ICML2020 Fast Learning of Graph Neural Networks with Guaranteed Generalizability:

One-hidden-layer Casehttps://arxiv.org/pdf/2006.14117.pdf

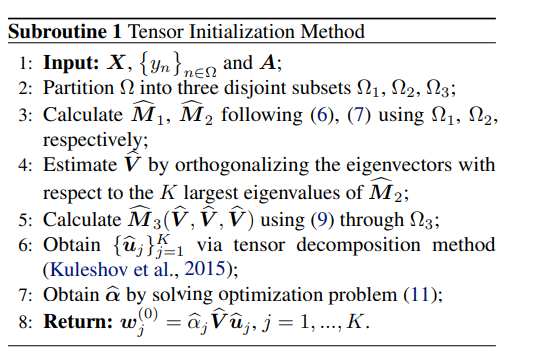

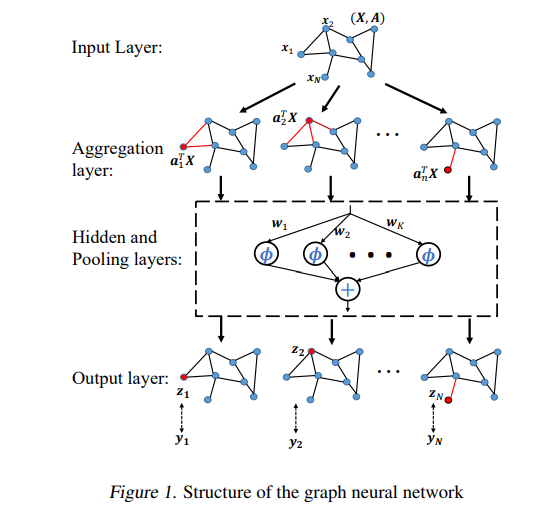

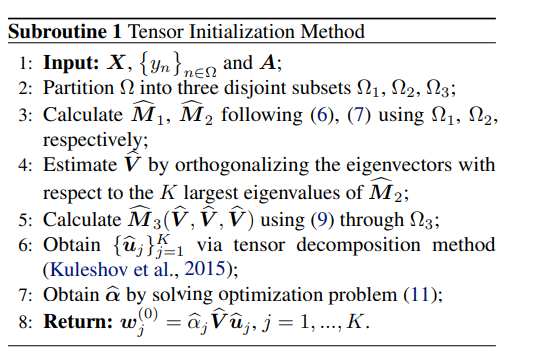

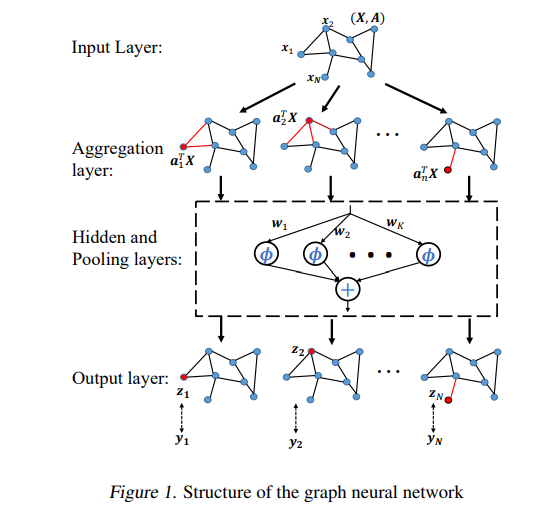

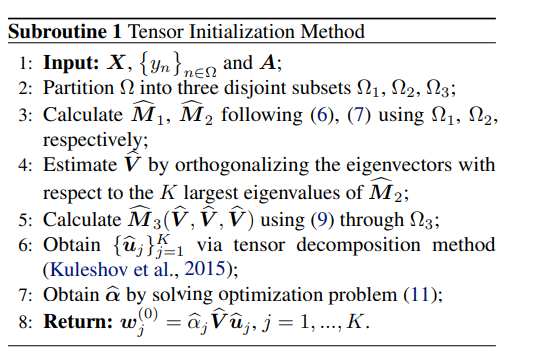

这篇论文参考之前从模型估计上对NN泛化的研究(这些研究假设存在真实的模型,可以理解为上帝视角下的真实模型,可以无差的将样本映射到label上),来对GNN通用性进行理论分析,作者以一个one-hidden-layer case展开,该GNN有一个隐藏层,用于回归和二元分类问题本文,作者通过算法设计和理论分析来学习具有零泛化误差的GNN模型。这里用one-hidden-layer case 主要原因是GNN算法中图上每个节点的表示都跟邻居特征有关,这种依赖关系使学习问题的分析大大复杂化,一层的便于分析和理解。本文提出使用张量初始化并通过加速梯度下降(AGD)进行更新提出的模型。同时也证明了,在有足够数量的训练样本的情况下,该算法针对回归问题可以得到一个ground-truth model with the zero generalization

error for regression problems。对于二分类问题,该方法能够充分接近真实的模型。

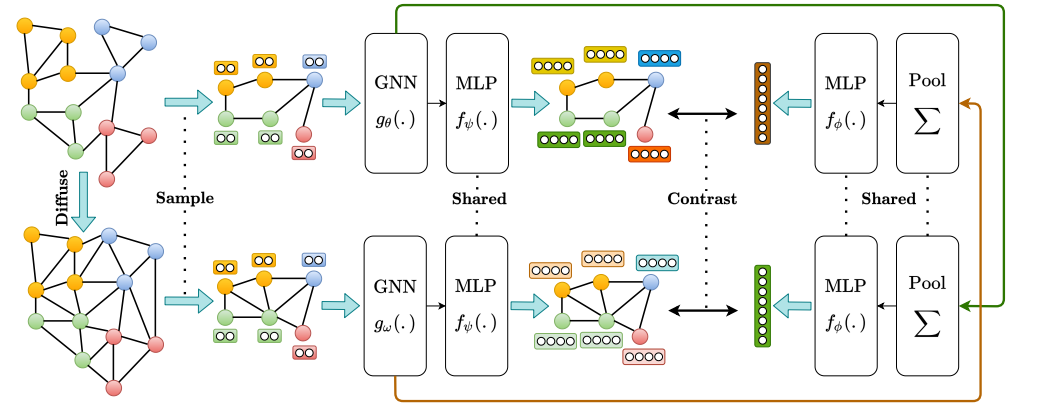

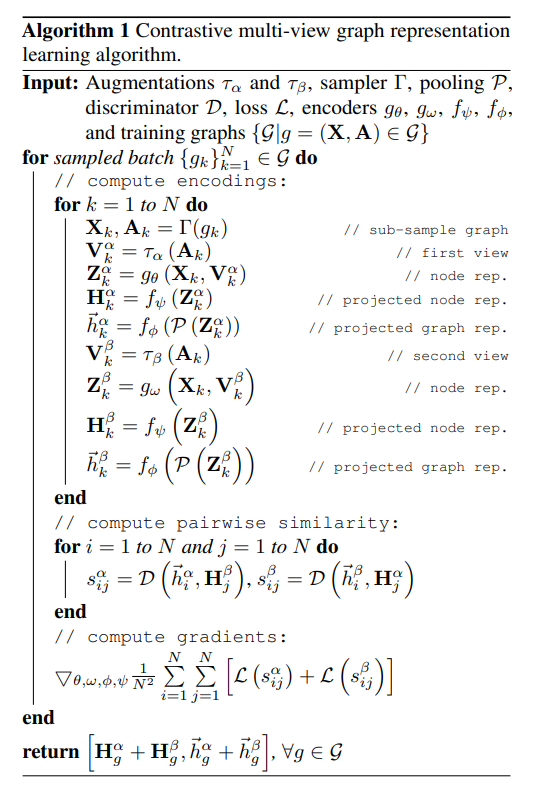

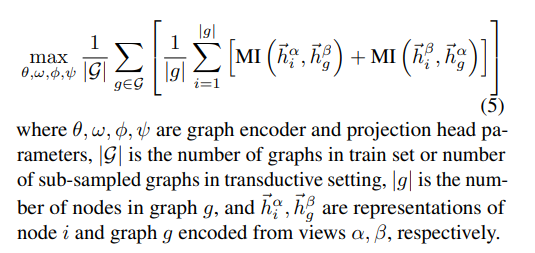

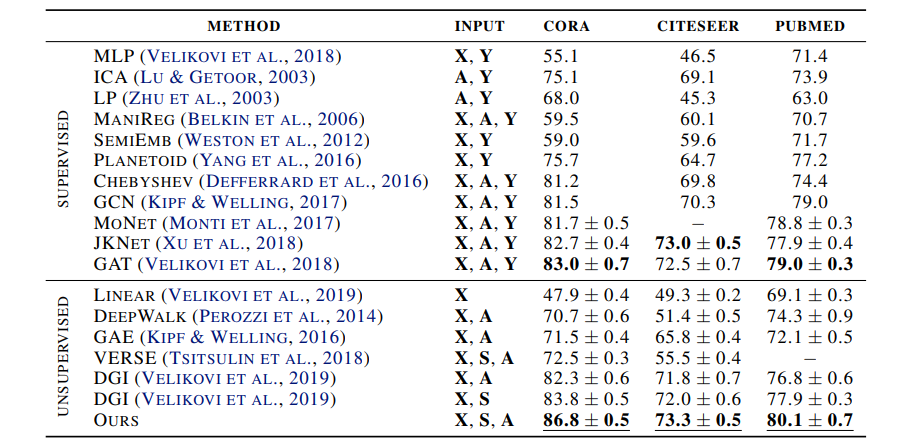

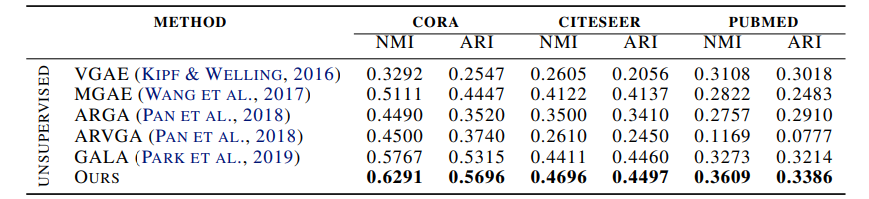

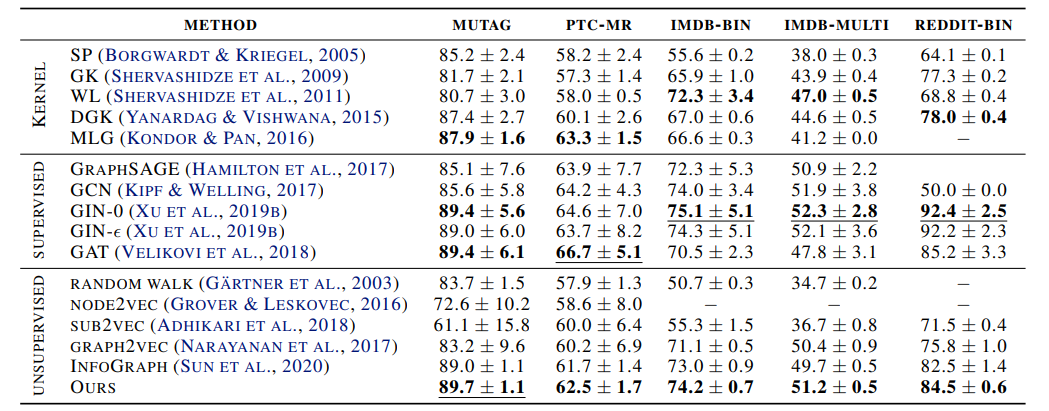

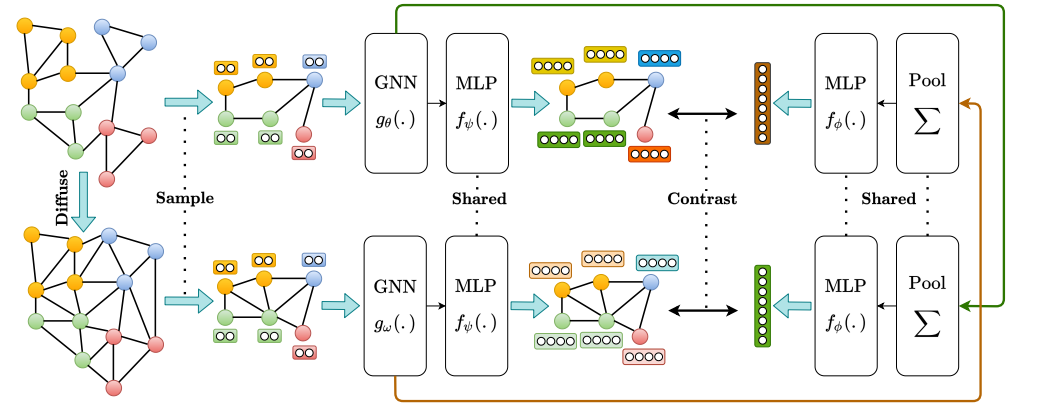

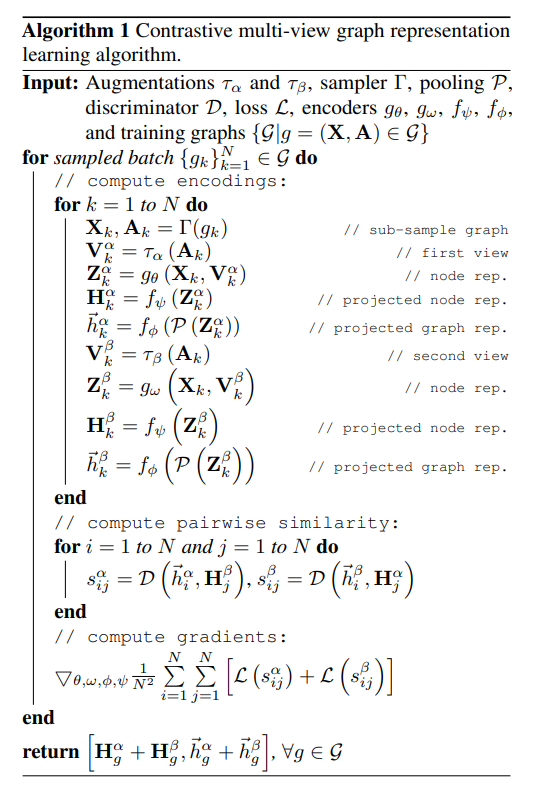

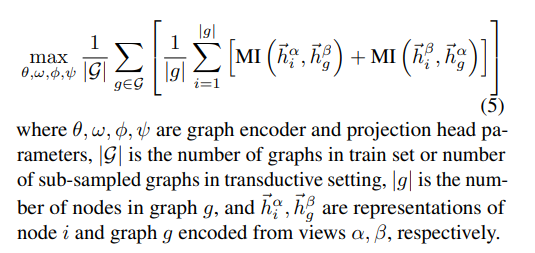

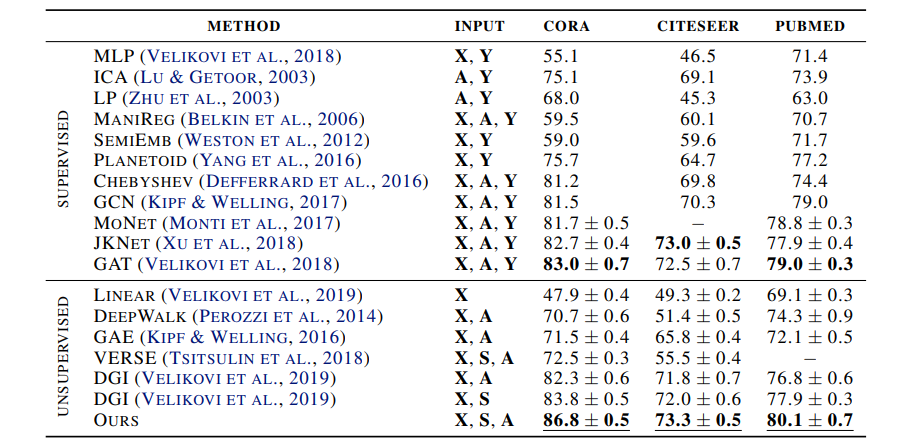

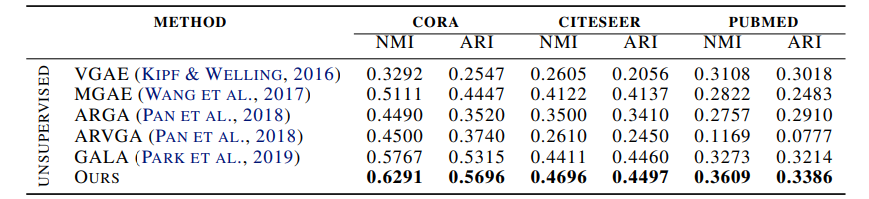

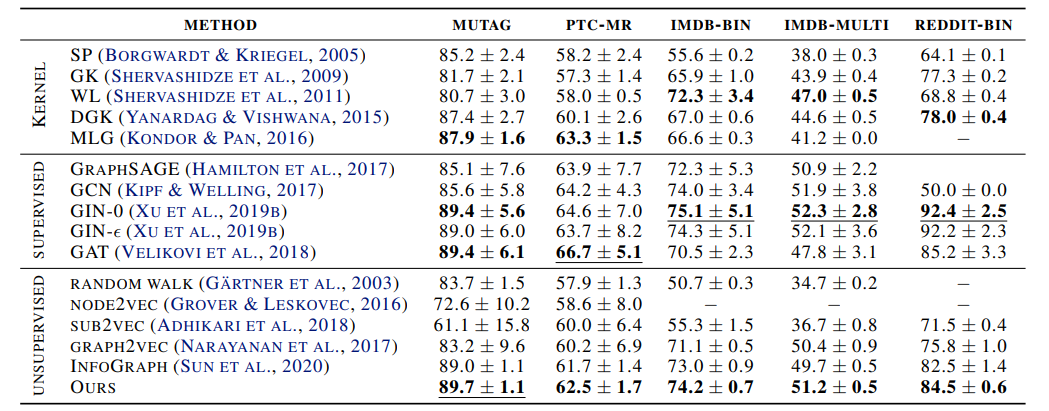

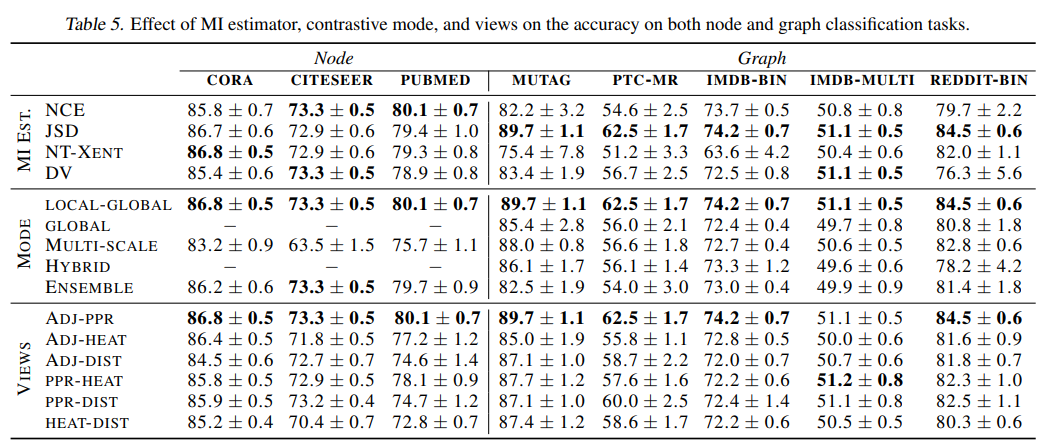

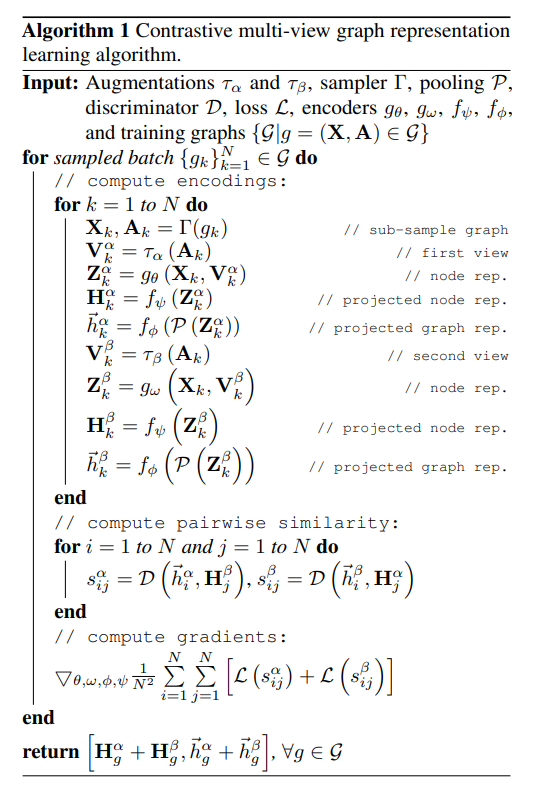

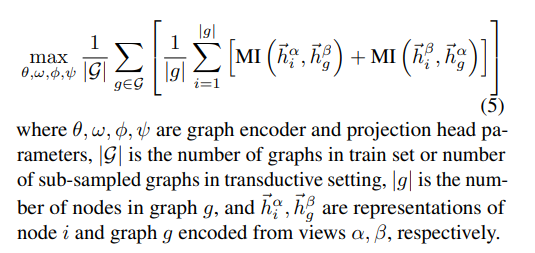

3. Contrastive Multi-View Representation Learning on Graphshttps://arxiv.org/pdf/2006.05582.pdf前面的推文中我们介绍了: 自监督学习的方法主要可以分为 3 类:基于上下文(Context based) 、基于时序(Temporal Based)以及基于对比(Contrastive Based)(点击可以查看—>高效利用无标注数据:自监督学习简述),这篇论文引入了对比学习的自监督学习方法来学习节点和图级别的表示。论文发现,简单地将视图增加进行多视角的编码不会提高模型的性能,而最好的方法是来自一阶邻居的对比和图扩散(graph diffusion)。本文实验的结果感人,提升了不少。

作者引入了一种自监督方法来训练图编码器,方法是最大化图的不同结构视图表示之间的互信息,也有相对严谨的证明。顶会快讯 | ICML2020 | 连续图神经网络;常数曲率图神经网络;贝叶斯图神经网络

顶会快讯 | ICML2020 | 图分类readout函数,池化函数,以及双曲聚合函数/双曲BN