今天这篇博文将讨论一下推荐领域Benchmark的一些问题,也会介绍一下最新论文《BARS: Towards Open Benchmarking for Recommender Systems》中的一些观点。

首先讲讲什么是Benchmark,所谓Benchmark就是用来做比较的规范。在现在的AI领域中,包括NLP、CV等,一个典型的Benchmark通常包含数据集、指标和计算性能的方式。当然它的前提是领域内的人都愿意接受这个规范。因此,为了确保让大家接受,近期的许多基准,要么选择一组具有代表性的标准任务,例如GLUE 或 XTREME;要么会通过征集的意见来构建,例如SuperGLUE、GEM 或 BIG-Bench等。

那么这个规范有什么用呢?没有这个规范会怎么样呢?这个规范就是用来对比的,做出让大家信服的对比。如果没有这样一个规范,比如某论文在一些冷门数据集上做实验,甚至用一些冷门的评价指标,告诉大家XXX模型取得了多少多少的提升,这很难让大家信服。

而当前推荐领域的Benchmark是一直被诟病的一件事情,目前该领域的研究存在一些问题:

没有被一致认同的数据集和评价指标。推荐由于其强烈的工业属性,一般在工业界被划分为召回和排序,再细分可能还有粗排、精排、重排等等。其中在召回阶段,候选项(Candidate Items)是很多的,常常上亿,而现有的公开数据集往往达不到这一个要求。这也成为了一个学术界和工业界的鸿沟,就是数据规模问题。其次,在推荐领域的评价指标五花八门,现在往往是拿信息检索的指标来做评价的,而在工业界普遍认为,如果评价指标看的是AUC就是排序,评价指标是Recall和NDCG就是召回,但是学术界在撰写论文的时候并没有写的那么清楚。 不可复现性。这个就不说了,懂得都懂。 没有一套易上手的框架。现在在推荐领域比较知名的框架是RecBole,但它只能算是一个代码库,就是方便研究人员对比一些常见Baseline,离真正意义上的Benchmark还有一些距离。

《BARS: Towards Open Benchmarking for Recommender Systems》是华为、人大、清华和港中文联合发布的最新的推荐领域的Benchmark,他们开源了这一工具https://openbenchmark.github.io/BARS/,这篇论文我很推荐初学者去阅读,其中没有冷门的词汇,通读下来很顺畅,也能对推荐有一个大体的了解。

好了言归正传,我们今天主要来看看这篇论文中一些有趣的结论。

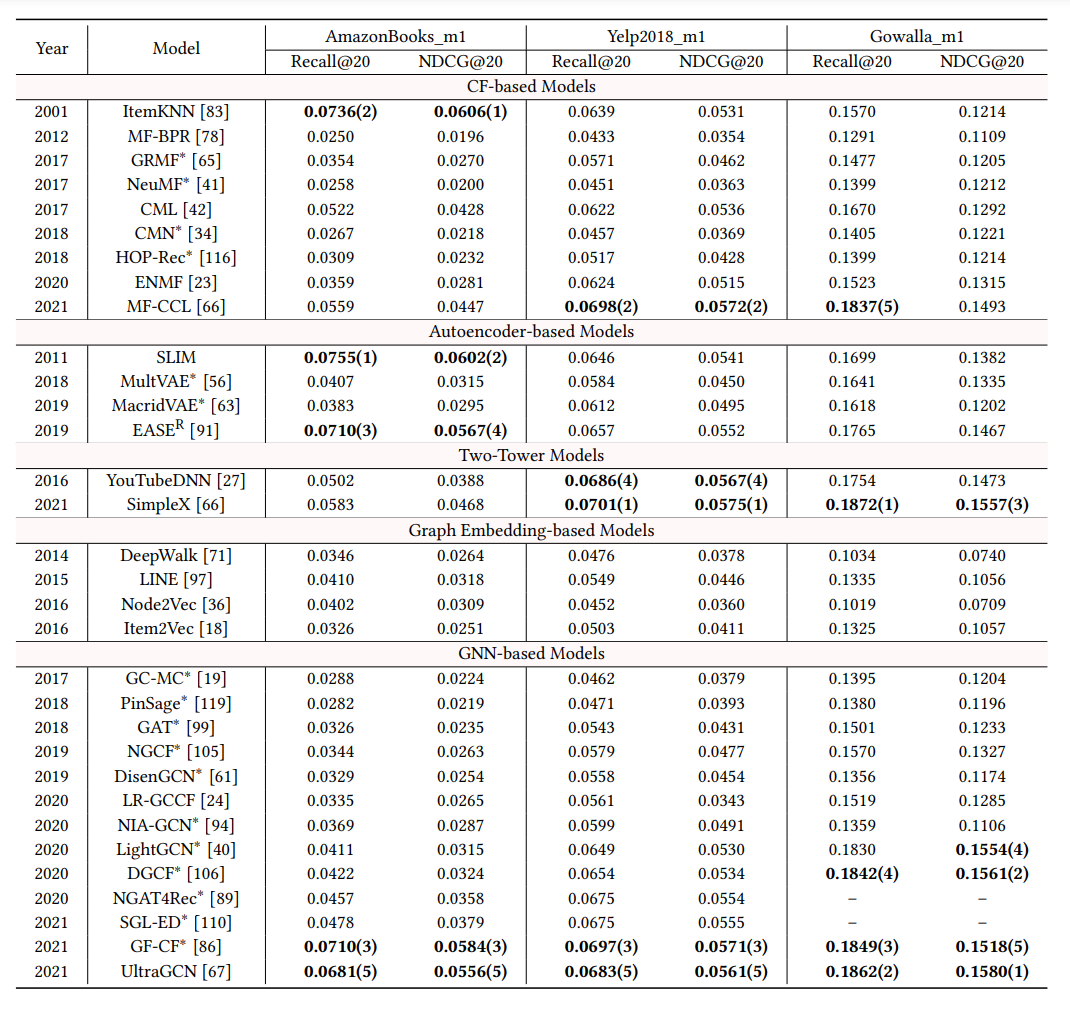

上图是召回领域一些工作的对比,论文发现了一些有趣的结论:

GNN确实有一定的效果 每个类别都有表现在top-5以内的模型,说明召回任务还没有被任何类型的方法所主导,仍然有很大的发展空间,任何方法都有可能出现新的突破 基于item相关性的方法对效果能有很大的提升 简单的YouTubeDNN就能取得非常不错的效果,其他方法的提升其实都一般

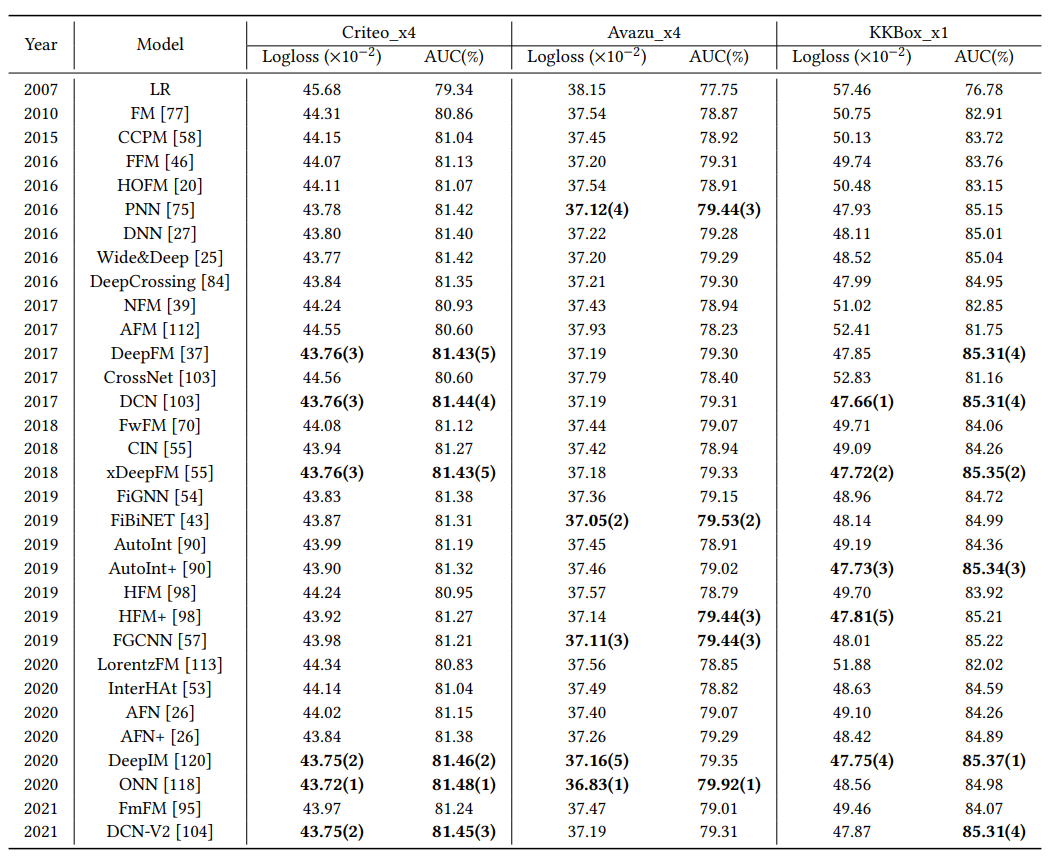

上图对比的是AUC,就是排序的工作对比,依旧有一些令人大跌眼镜的结论:

没有一个模型可以统治所有的数据集,这与现有论文报道的结果相矛盾 以DeepFM,xDeepFM为首的一些模型很能打 排序阶段想提升效果很难

所以,看到这些结论,我们确实迫切地需要一个被大家所认可的Benchmark,BARS不一定能被认可,但是需要有科研人员来做这样的工作,来治一治动辄十几个点提升的方法和论文。