标题:ICML'22|ProGCL:重新思考图对比学习中的难样本挖掘

“Paper title:ProGCL:Rethinking Hard Negative Mining in Graph Contrastive Learning Paper link: https://arxiv.org/abs/2110.02027 Code: https://github.com/junxia97/ProGCL

”

背景

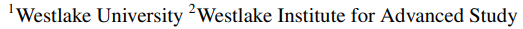

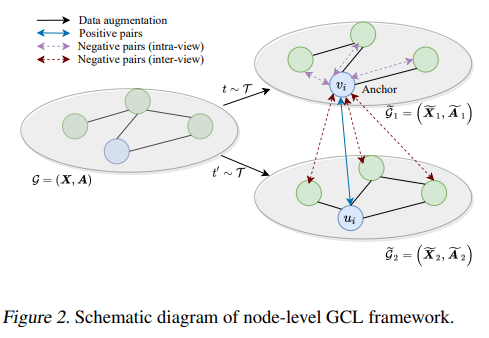

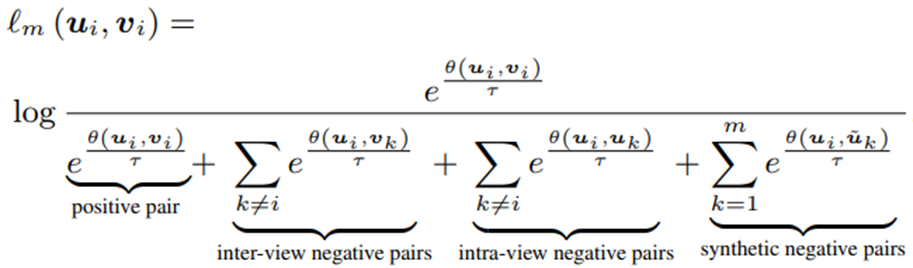

图对比学习在无监督节点表征学习任务上取得了巨大成功,其基本的框架如上图所示,图数据经过两种增广后得到两个视角的图数据和。我们把不同视角下同一个节点称为正样本对,任意两个不同样本称为负样本对。假设一对正样本对为,对比损失如下:

摘要

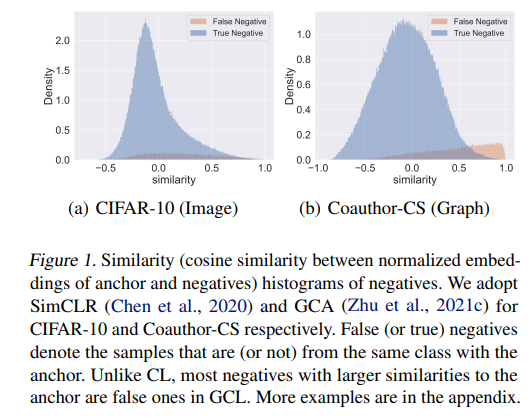

最近的研究表明,难的负样本(与锚点样本更相似的负样本)可以提高对比学习的表现。然而,作者发现现有的其他领域的难负样本挖掘技术并不能很好地促进图对比学习(参见原文Table 5)。作者对此现象进行了实验和理论分析,发现可以归因于图神经网络的消息传递机制。如果像其他领域那样仅仅把相似度做为衡量负样本难易程度的指标,在图对比学习中大多数的难负样本是潜在的假负样本(与锚点样本同一类, Figure 1)。为了弥补这一缺陷,作者利用混合分布来估计负样本为真负样本的概率,并设计了两种方案(即 ProGCL-weight 和 ProGCL-mix)来提高 GCL 的性能。

分析

实验分析

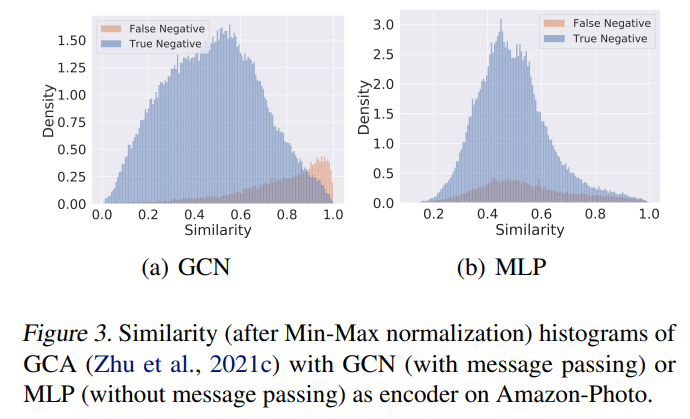

为了探究消息传递机制在图对比学习中的作用,作者将图对比学习中的GCN替换为MLP(即去掉信息传递机制),发现负样本的分布呈现与其他领域相似的单峰分布。这说明消息传递机制是造成上述现象的本质原因。但是,直接去掉消息传递机制又不能很好地利用图的结构信息。图神经网络的消息传递机制会拉近邻近节点的表征,即增大很多对假锚点样本与假负样本的相似度。进一步导致图对比学习的负样本的分布呈现双峰分布。

为了探究消息传递机制在图对比学习中的作用,作者将图对比学习中的GCN替换为MLP(即去掉信息传递机制),发现负样本的分布呈现与其他领域相似的单峰分布。这说明消息传递机制是造成上述现象的本质原因。但是,直接去掉消息传递机制又不能很好地利用图的结构信息。图神经网络的消息传递机制会拉近邻近节点的表征,即增大很多对假锚点样本与假负样本的相似度。进一步导致图对比学习的负样本的分布呈现双峰分布。

理论分析

作者证明随着信息传递的进行,任意两个节点间的相似度都会大于他们的初始相似度。具体参考原文。

方法

ProGCL

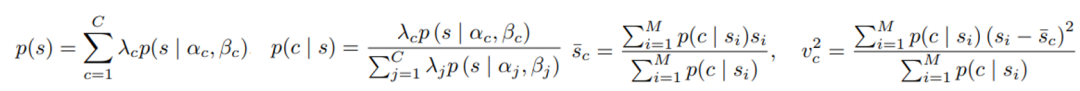

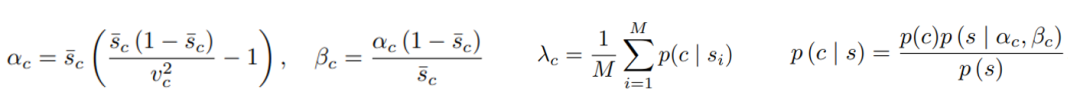

上述分析表明相似度不能做为衡量图对比学习中负样本难易程度的指标,因此作者想在衡量图对比学习中负样本难易程度时考虑负样本为真负样本的概率。作者利用混合分布来估计该概率,但是常用的高斯混合只能拟合对称的分布,因此,作者利用了更加灵活的Beta混合分布,然后利用EM算法估计负样本为真的概率。EM算法估计Beta混合分布的参数的步骤如下:

E-step:

M-step:

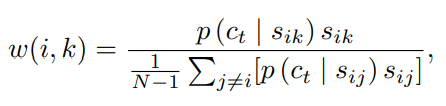

由此,根据样本间相似度就能估计出负样本为真的概率。此概率与相似度一起构成了一个新的衡量图对比学习中负样本难易程度的指标:

由此,根据样本间相似度就能估计出负样本为真的概率。此概率与相似度一起构成了一个新的衡量图对比学习中负样本难易程度的指标:

有了以上的新度量,作者设计了两种方案来改进图对比学习中的难负样本挖掘:

方案一:ProGCL-weight

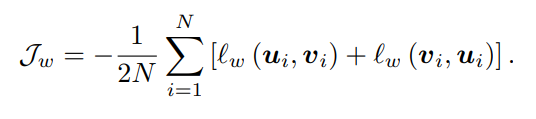

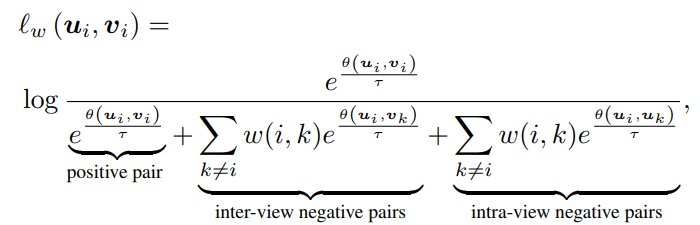

用新指标负样本进行加权 最终的损失函数为:

最终的损失函数为:

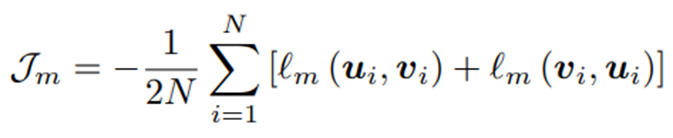

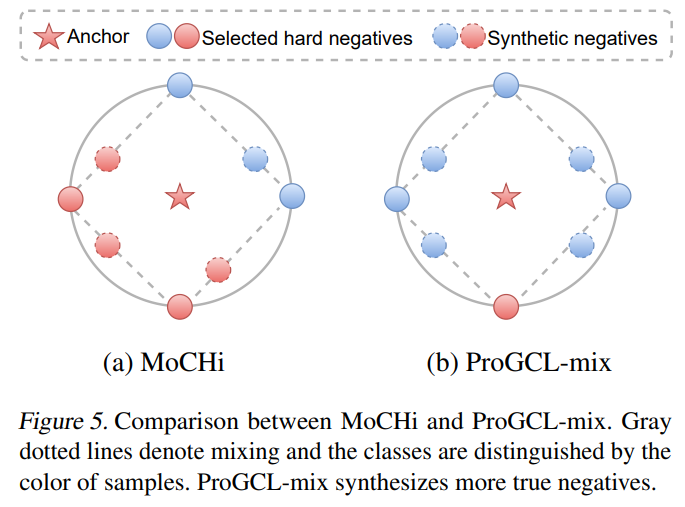

方案二:ProGCL-mix

合成更多的负样本

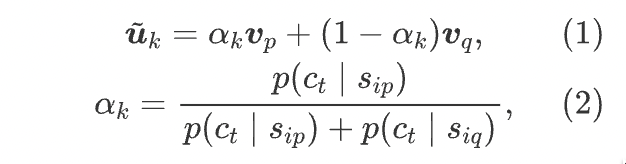

一方面,作者用上面提出的新度量选择负样本进行mixup,这能让选到的负样本为真的概率更高也能使选到的负样本更可能是难负样本。另一方面,在进行mixup时,用来mix的系数也是由估计出的负样本为真的概率决定的。公式如下:

一方面,作者用上面提出的新度量选择负样本进行mixup,这能让选到的负样本为真的概率更高也能使选到的负样本更可能是难负样本。另一方面,在进行mixup时,用来mix的系数也是由估计出的负样本为真的概率决定的。公式如下:

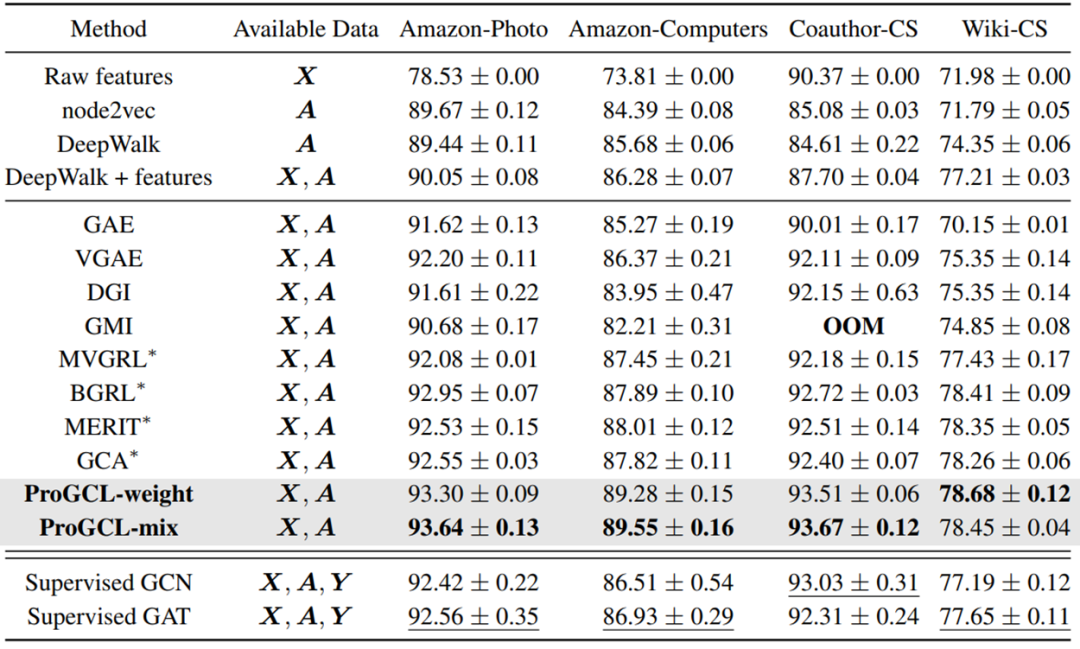

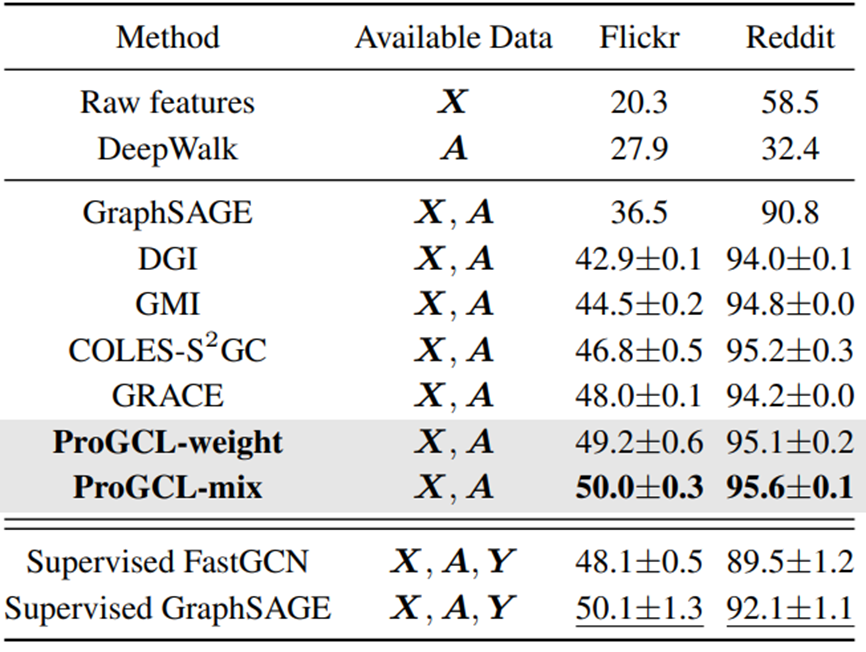

实验

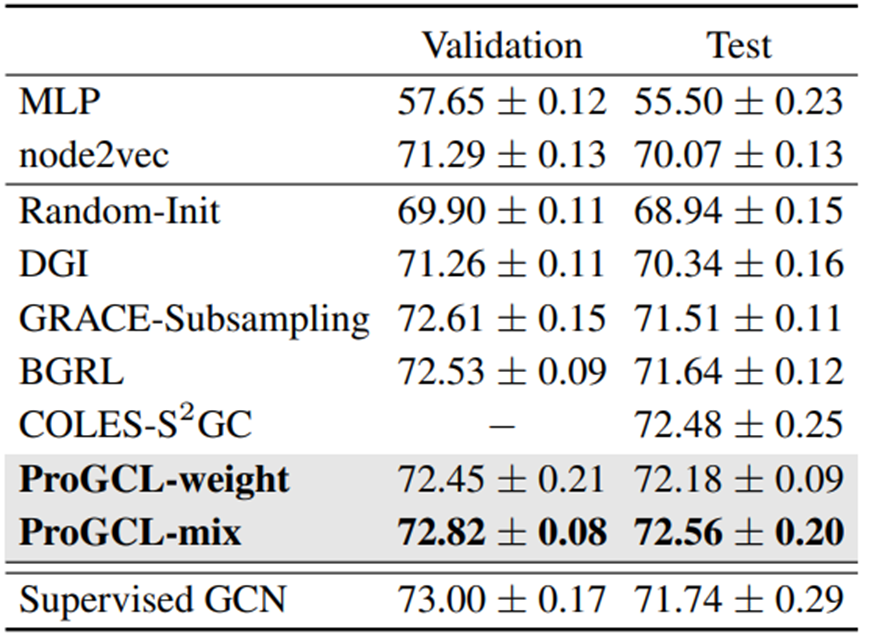

作者以GCA和GRACE方法为基础模型,说明其设计的两种难负样本挖掘技术的有效性:

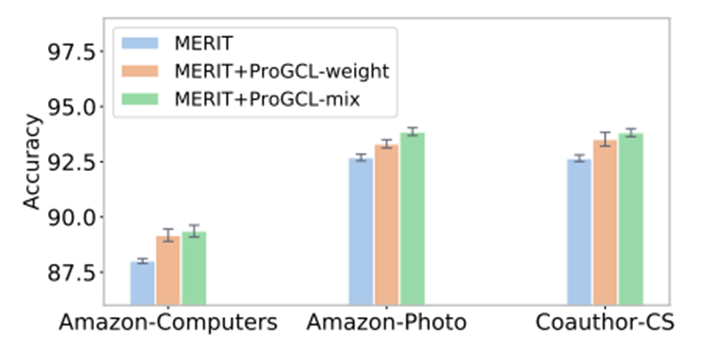

提升其他基于负样本的图对比学习方法:

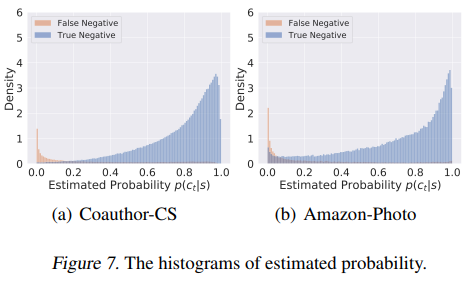

估计出的负样本为真的概率的分布:

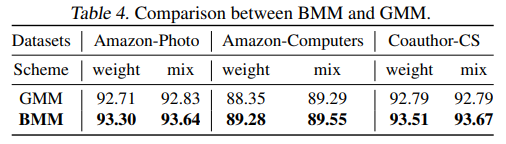

BMM vs GMM

更多的分析性的实验请参考原文。

总结

在本文中,作者发现现有的其他领域的难负样本挖掘技术并不能很好地提高图对比学习的表现,并对这一现象进行深入探究,发现可以归因于图神经网络的信息传递机制。此外,作者设计了一些更合适在图对比学习中进行难负样本挖掘的方案。然而,作者在训练过程中仅进行了一次概率估计,动态的概率估计是否会带来进一步的性能增益仍然值得进一步探究。