Parquet格式:

数据模型: Avro, Thrift, Protocol Buffers, POJOs

查询引擎: Hive, Impala, Pig, Presto, Drill, Tajo, HAWQ, IBM Big SQL

计算框架: MapReduce, Spark, Cascading, Crunch, Scalding, Kite

Parquet是一种列式的二进制文件格式,Impala基于Parquet文件可以高效的处理大型复杂查询

1 数据准备

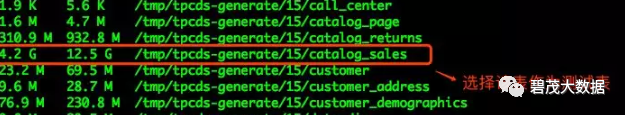

使用hive-testbench生成15GB测试数据,挑选catalog_sales表做为测试表

生成的表数据为text类型

查看catalog_sales表生成的text数据大小

2 创建Parquet表

SQL脚本:

set parquet_file_size=512M;

set COMPRESSION_CODEC=snappy;

drop table if exists catalog_sales;

create table default.catalog_sales

stored as parquetas select * from tpcds_text_15.catalog_sales;

创建Parquet表并导入数据

[root@ip-168-12-26-81 impala-parquet]# impala-shell -f load_parquet.sql Starting Impala Shell without Kerberos authentication

查看HDFS上catalog_sales表占用空间大小

[root@ip-168-12-13-67 ~]# hadoop fs -du -h user/hive/warehouse

验证

数据量大小与原始表tpcds_text_15.catalog_sales表数据量一致即可

3 Parquet block size

默认情况下,Impala的INSERT...SELECT语句创建的Parquet文件的块大小是256MB

被Impala写入的Parquet文件都是一个单独的块,允许整个文件刚好由一台机器处理

在将Parquet文件拷贝到HDFS其他目录或者其他HDFS时,使用hdfs dfs -pb来保留原始块大小

如果Parquet表中或者查询访问的某个分区中只有一个或几个数据块,则可能会导致查询性能下降:没有足够的数据来利用Impala查询的分布式能力

每个数据块由其中一台DataNode上的单个CPU核来处理

在一个由100个节点组成的16核机器中,可以同时处理数千个数据文件

如在“许多小文件”和“单个大文件”之间找到一个高I/O和并行处理能力的平衡点,就可以在执行INSERT...SELECT语句之前设置PARQUET_FILE_SIZE,以控制每个生成的Parquet文件的大小

Impala2.0之前你要指定绝对字节数,2.0以后你可以以m或者g为单位,分别代表MB和GB大小。基于特定的数据量选择不同的file size做一些基准测试,然后找到适合你集群和数据文件的PARQUET_FILE_SIZE大小

关注公众号:领取精彩视频课程&海量免费语音课程