ICML 2022 | Self-Supervised Representation Learning via Latent Graph Prediction

“文章信息

来源:Proceedings of the 39th International Conference on Machine Learning(ICML) 2022

”

标题:Self-Supervised Representation Learning via Latent Graph Prediction

作者:Yaochen Xie, Zhao Xu, Shuiwang Ji

链接:https://proceedings.mlr.press/v162/xie22e.html

内容简介

图神经网络的自监督学习 (SSL) 正在成为一种利用未标记数据的热门方式。目前,大多数方法都是基于从图像域改编的对比学习,这需要视图生成和足够数量的负样本。相比之下,现有的预测模型不需要负抽样,但在pretext训练任务的设计上缺乏理论指导。本文提出了 LaGraph,这是一个基于潜在图预测的理论基础的SSL 框架。LaGraph 的学习目标是作为预测未观察到的潜在图的目标的自我监督上限而得出的。除了提高性能之外,LaGraph 还解释了预测模型最近取得的成功,其中包括基于不变性的目标。本文提供了将 LaGraph 与不同领域的相关方法进行比较的理论分析。本文的实验结果证明了 LaGraph 在性能方面的优越性以及在图级和节点级任务上减少训练样本量的鲁棒性。

图SSL方法大多依赖于大量的训练样本来包含足够数量的负样本,在计算资源有限的情况下,对比方法可能不适用于大规模图。为了解决这个缺点,BGRL (Thakoor et al., 2021) 将 BYOL (Grill et al., 2020) 适应于图域。BGRL 仍然从每个给定的图获得不同的视图,但它通过用离线嵌入的预测替换对比目标来消除对负样本的要求。BGRL 在对比方法中取得了有竞争力的表现。然而,与基于互信息估计和最大化的对比方法不同,BYOL 和 BGRL 缺乏理论指导,需要实施措施来防止崩溃,例如停止梯度、EMA 和归一化层。

本文提出了 LaGraph,一种基于自监督的潜在图预测的SSL 框架,用于图数据的表示学习。特别是,本文描述了潜在图的概念,并将潜在图预测作为pretext学习任务引入。本文通过推导其自监督上界将潜在图预测的监督目标调整为自监督设置,据此本文提出了 LaGraph 的学习框架。本文通过将 LaGraph 与不同领域的理论上合理的方法进行比较来进一步证明 LaGraph。本文的实验结果证明了 LaGraph 在图级和节点级表示学习上的有效性,其中在大多数数据集上实现了显着的性能提升,对于较小的批量大小或在节点子集上的训练具有更高的稳定性。

方法介绍

潜在图预测

本文的方法将潜在图预测视为训练图神经网络的pretext任务。先介绍潜在数据的一般概念,然后介绍其对图数据的具体定义,以及学习任务的构建。对于任何观察到的数据实例 ,本文假设存在对应的潜在数据 ,确定 的语义,使得潜在数据 是从先验的 生成的,而观察到的数据实例是从某个特定的分布以潜在数据为条件,即 。观察数据和潜在数据对最常见的情况是噪声数据及其干净版本。

对于图数据,本文考虑这样一种情况,观察到的图数据 是(嘈杂地)从其潜在图 生成的,具有相同的节点集和边集,其中节点两个图的特征矩阵 和 具有相同的维度。本文在不失一般性的情况下对图做了两个假设。首先,本文假设观察到的图中每个节点 的观察到的特征向量 是从以相应潜在图为条件的某个分布独立生成的。换句话说,如何从潜在特征 生成 不受其他观察到的特征向量的生成的影响。其次,本文假设观察到的图的条件分布以潜在图为中心,即 。当本文对生成过程知之甚少时,上述假设是很自然的,并且通常用于其他图像中的非结构和零均值噪声等数据类型。在不同节点的生成过程相关或分布不以 为中心的情况下,本文仍然可以将相关或有偏差的分量考虑到潜在特征中,从而满足假设。

由于潜在数据通常决定观察数据的语义,本文相信潜在图的预测可以为图级和节点级表示的学习提供信息监督。因此,本文对构建潜在图预测的学习任务感兴趣。要执行潜在图预测,可以直接使用图神经网络 将观察到的图 作为输入,并预测其潜在图 的特征矩阵。当潜在特征矩阵 的基本事实已知时,学习目标可以设计为:

直观地说,潜在图预测可以被认为是来自噪声数据重建的广义任务,该任务从噪声数据中预测信号,目标为 ,其中从信号到噪声的映射数据 通常可以显式建模,并且通常可以捕获信号样本(地面实况)。在数据重建的情况下,给定的噪声模型 可以直接捕获或综合生成 对。然而,当任务被推广到潜在图预测时,有一个关键挑战阻止本文直接应用预测任务。也就是说,虽然有噪声数据重建的自然监督,但没有观察到潜在图,本文无法明确地建模从潜在图到观察到的图的映射,即条件分布 。

潜在图预测的自监督上限

考虑一个图 及其潜在图 。本文让 中任何元素的方差以 为界, 为图 中节点 的子集。对于任何图神经网络 ,有如下不等式:

直观地说,上界的第一个分量测量给定观察图 的特征矩阵 上的重构误差,从而强制中间表示具有信息性。第二个组件通过鼓励节点的输出不受输入图中其特征缺失的影响,控制在重建 的特征时可以从节点 的输入特征访问多少信息。然后本文称第一个分量为重构项,第二个分量为不变正则化项。请注意,与 BGRL 目标相比,不变性正则化仅在屏蔽节点上计算,基于不同的理论基础并导致不同的效果。

LaGraph 框架

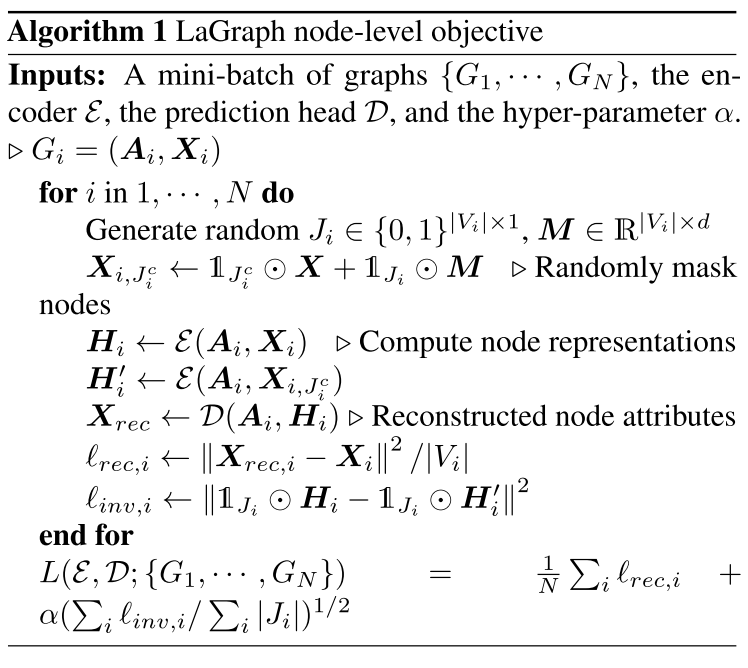

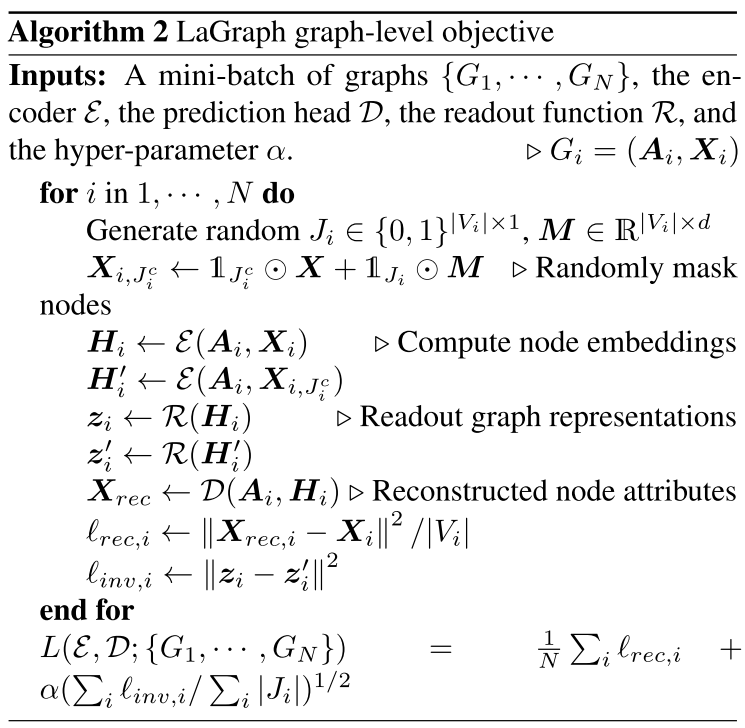

算法 1 和算法 2 分别提供了节点级和图级目标计算的伪代码。

实验分析

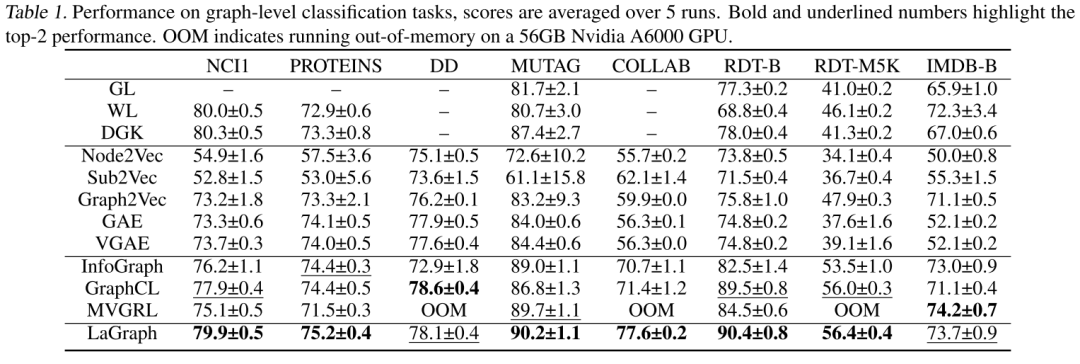

本文根据线性分类准确度评估 LaGraph 的性能,并将其与三种基于内核的方法进行比较,包括 graphlet 内核 (GL) (Shervashidze et al., 2009)、WeisfeilerLehman 内核 (WL) (Shervashidze et al., 2011)和深度图内核 (DGK) (Yanardag & Vishwanathan, 2015),以及五种无监督方法,包括 Node2Vec (Grover & Leskovec, 2016)、Sub2Vec (Adhikari et al., 2018)、Graph2Vec (Narayanan et al., 2017) , GAE 和 VGAE (Kipf & Welling, 2016)。本文进一步将结果与最近基于对比学习的 SOTA SSL 方法进行比较,包括 InfoGraph (Sun et al., 2019)、MVGRL (Hassani & Khasahmadi, 2020) 和 GraphCL (You et al., 2020)。下表中的结果表明,LaGraph 在大多数数据集上优于当前的 SOTA 方法,并且在其余数据集上与最佳性能相当。

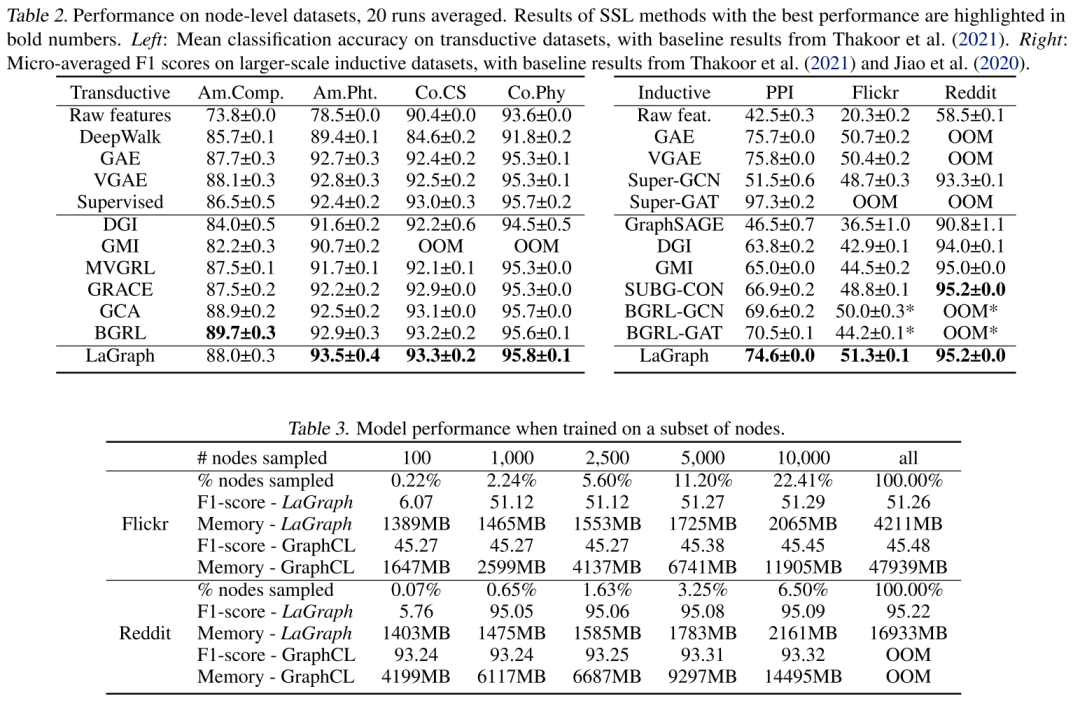

对于转导学习的评估,本文将 LaGraph 在线性分类精度方面的性能与 DeepWalk (Perozzi et al., 2014b)、GAE、VGAE 以及包括 Deep Graph InfoMax (DGI) 在内的六种对比学习方法进行了比较,其中 BGRL 是当前最先进的用于节点级表示学习的 SSL 方法。本文进一步包括对原始节点特征(原始特征)直接执行线性分类和通过监督训练进行参考的结果。本文确保四个转导数据集的 LaGraph 的 GPU 内存消耗低于 16GB。然后,本文对更大规模的归纳数据集进行了额外的实验,并将本文的结果在微平均 F1score 与 DeepWalk、无监督 GraphSAGE 方面进行了比较。下表中显示了转换数据集和归纳数据集的结果。

总结

本文介绍了 LaGraph,这是一种最先进的预测 SSL 框架,其目标基于自监督的潜在图预测。本文提供了理论分析并讨论了 LaGraph 与不同相关领域的理论之间的关系。实验结果证明了所提出框架的强大有效性以及图级和节点级任务的训练规模的稳定性。目前,本文的框架主要考虑潜在图的节点特征。对包含更丰富信息(例如边特征和潜在连通性)的潜在图预测框架的进一步研究可能会进一步提高性能。