Apache Doris

Doris概述篇

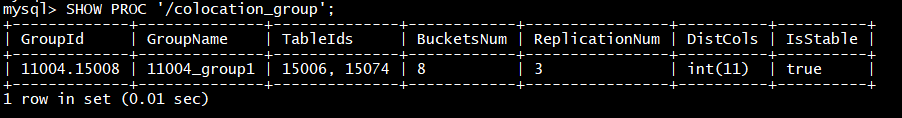

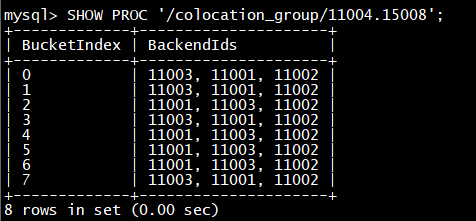

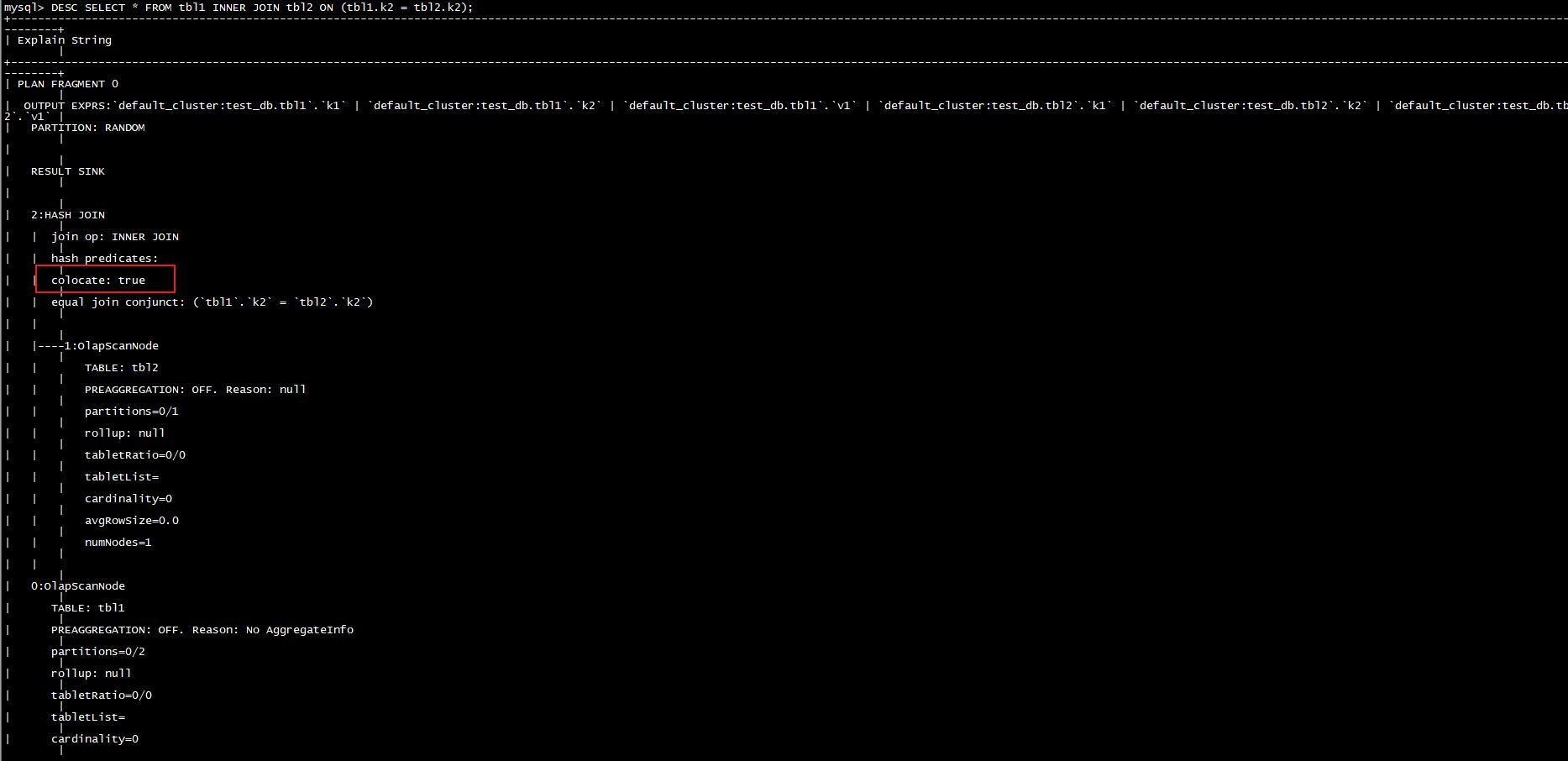

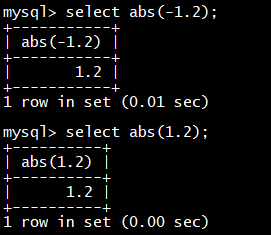

前言

Doris由百度大数据部研发,之前叫百度Palo,于2017年开源,2018年贡献到 Apache 社区后,更名为Doris。

Doris简介

Apache Doris是一个现代化的基于MPP(大规模并行处理)技术的分析型数据库产品。简单来说,MPP是将任务并行的分散到多个服务器和节点上,在每个节点上计算完成后,将各自部分的结果汇总在一起得到最终的结果(与Hadoop相似)。仅需亚秒级响应时间即可获得查询结果,有效地支持实时数据分析。

Apache Doris可以满足多种数据分析需求,例如固定历史报表,实时数据分析,交互式数据分析和探索式数据分析等。令您的数据分析工作更加简单高效!

MPP ( Massively Parallel Processing ),即大规模并行处理,在数据库非共享集群中,每个节点都有独立的磁盘存储系统和内存系统,业务数据根据数据库模型和应用特点划分到各个节点上,每台数据节点通过专用网络或者商业通用网络互相连接,彼此协同计算,作为整体提供数据库服务。非共享数据库集群有完全的可伸缩性、高可用、高性能、优秀的性价比、资源共享等优势。简单来说,MPP 是将任务并行的分散到多个服务器和节点上,在每个节点上计算完成后,将各自部分的结果汇总在一起得到最终的结果 ( 与 Hadoop 相似 )。

核心特性

- 基于MPP(大规模并行处理)架构的分析型数据库

- 性能卓越,PB级别数据毫秒/秒级响应

- 支持标准SQL语言,兼容MySQL协议

- 向量化执行器

- 高效的聚合表技术

- 新型预聚合技术Rollup

- 高性能、高可用、高可靠

- 极简运维,弹性伸缩

Doris特点

- 性能卓越

TPC-H、TPC-DS性能领先,性价比高,高并发查询,100台集群可达10w QPS,流式导入单节点50MB/s,小批量导入毫秒延迟

- 简单易用

高度兼容MySql协议;支持在线表结构变更高度集成,不依赖于外部存储系统

- 扩展性强

架构优雅,单集群可以水平扩展至200台以上

- 高可用性

多副本,元数据高可用

Doris发展历程

对比其他的数据分析框架

开源OLAP引擎对比

- OLTP 与 OLAP

OLTP是 Online Transaction Processing 的简称;OLAP 是 OnLine Analytical Processing 的简称

OLTP的查询一般只会访问少量的记录,且大多时候都会利用索引。比如最常见的基于主键的 CRUD 操作

OLAP 的查询一般需要 Scan 大量数据,大多时候只访问部分列,聚合的需求(Sum,Count,Max,Min 等)会多于明细的需求(查询原始的明细数据)

- HTAP

HTAP 是 Hybrid Transactional(混合事务)/Analytical Processing(分析处理)的简称。

基于创新的计算存储框架,HTAP 数据库能够在一份数据上同时支撑业务系统运行和 OLAP 场景,避免在传统架构中,在线与离线数据库之间大量的数据交互。此外,HTAP 基于分布式架构,支持弹性扩容,可按需扩展吞吐或存储,轻松应对高并发、海量数据场景。

目前,实现 HTAP 的数据库不多,主要有 PingCAP 的 TiDB、阿里云的 HybridDB for MySQL、百度的 BaikalDB 等。其中,TiDB 是国内首家开源的 HTAP 分布式数据库。

- OLAP分类

MOLAP:通过预计算,提供稳定的切片数据,实现多次查询一次计算,减轻了查询时的计算压力,保证了查询的稳定性,是“空间换时间”的最佳路径。实现了基于Bitmap的去重算法,支持在不同维度下去重指标的实时统计,效率较高。

ROLAP:基于实时的大规模并行计算,对集群的要求较高。MPP引擎的核心是通过将数据分散,以实现CPU、IO、内存资源的分布,来提升并行计算能力。在当前数据存储以磁盘为主的情况下,数据Scan需要的较大的磁盘IO,以及并行导致的高CPU,仍然是资源的短板。因此,高频的大规模汇总统计,并发能力将面临较大挑战,这取决于集群硬件方面的并行计算能力。传统去重算法需要大量计算资源,实时的大规模去重指标对CPU、内存都是一个巨大挑战。目前Doris最新版本已经支持Bitmap算法,配合预计算可以很好地解决去重应用场景。

doris是一个ROLAP引擎, 可以满足以下需求

- 灵活多维分析

- 明细+聚合

- 主键更新

对比其他的OLAP系统

- MOLAP模式的劣势(以Kylin为例)

- 应用层模型复杂,根据业务需要以及Kylin生产需要,还要做较多模型预处理。这样在不同的业务场景中,模型的利用率也比较低。

- 由于MOLAP不支持明细数据的查询,在“汇总+明细”的应用场景中,明细数据需要同步到DBMS引擎来响应交互,增加了生产的运维成本。

- 较多的预处理伴随着较高的生产成本。

- ROLAP模式的优势

- 应用层模型设计简化,将数据固定在一个稳定的数据粒度即可。比如商家粒度的星形模型,同时复用率也比较高。

- App层的业务表达可以通过视图进行封装,减少了数据冗余,同时提高了应用的灵活性,降低了运维成本。

- 同时支持“汇总+明细”。

- 模型轻量标准化,极大的降低了生产成本。

综上所述,在变化维、非预设维、细粒度统计的应用场景下,使用MPP引擎驱动的ROLAP模式,可以简化模型设计,减少预计算的代价,并通过强大的实时计算能力,可以支撑良好的实时交互体验。

总结:

- 数据压缩率Clickhouse好

- ClickHouse单表查询性能优势巨大

- Join查询两者各有优劣,数据量小情况下Clickhouse好,数据量大Doris好

- Doris对SQL支持情况要好

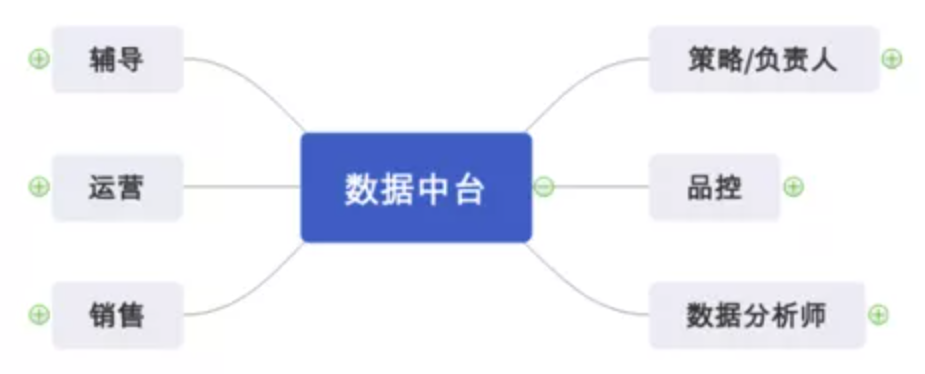

使用场景

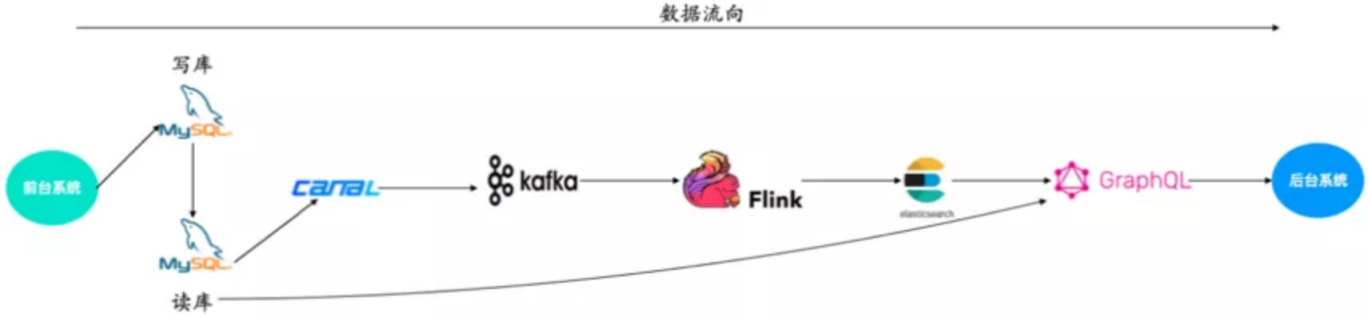

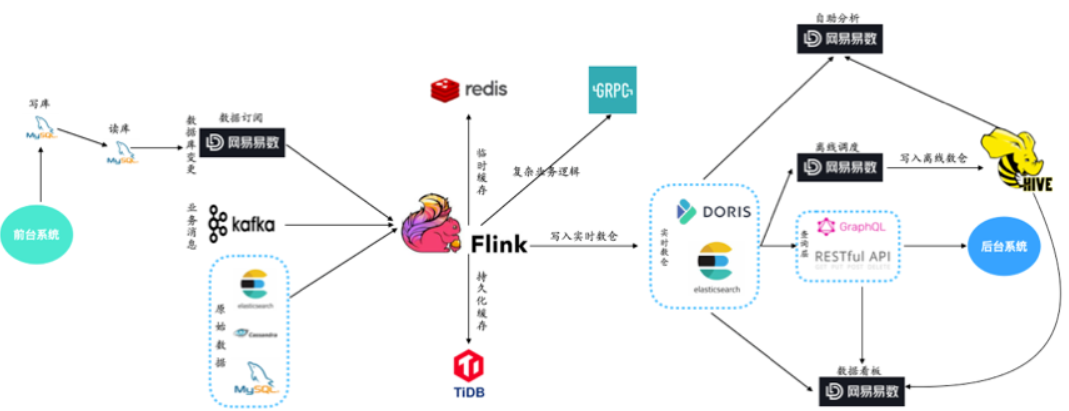

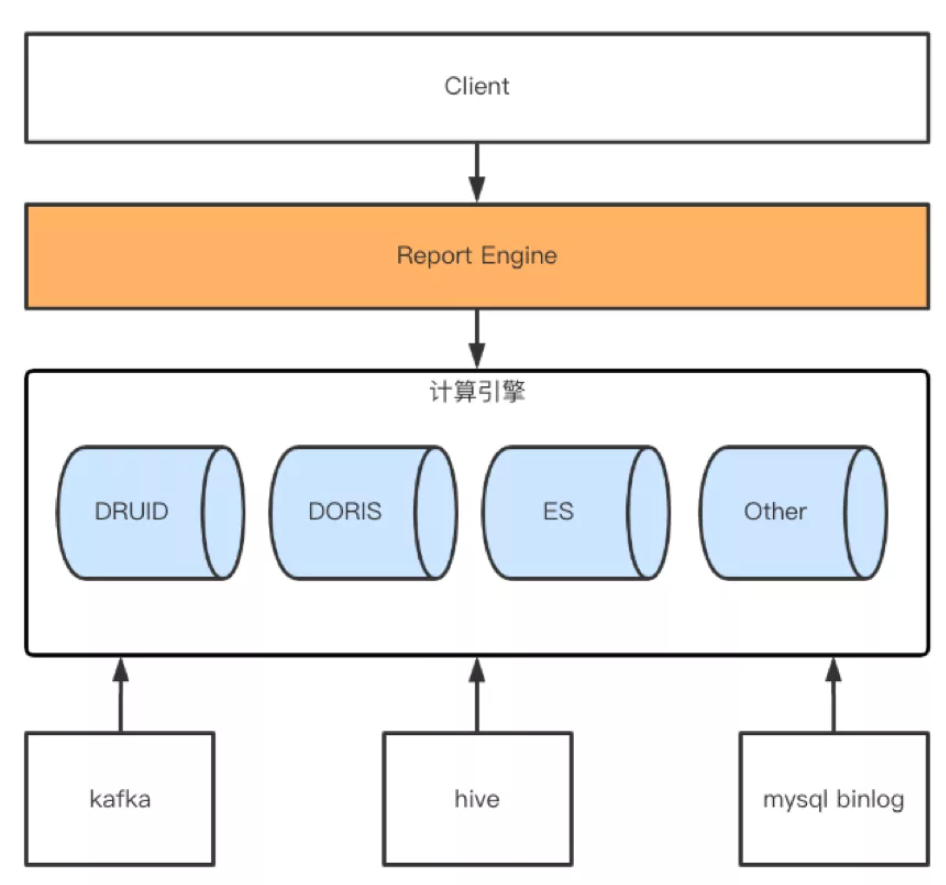

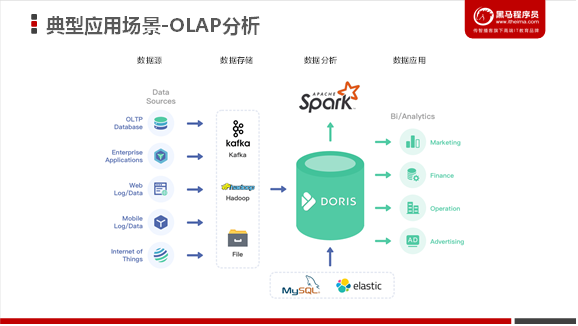

上图是整个Doris的具体使用场景,主要是它的接收数据源,以及它的一个整体的模块,还有最后它的一个可视化的呈现。后面会有一张更详细的图去介绍它整个的来源,以及最后可以输出的数据流向。

一般情况下,用户的原始数据,比如日志或者在事务型数据库中的数据,经过流式系统或离线处理后,导入到Doris中以供上层的报表工具或者数据分析师查询使用。

使用用户

Doris原理篇

名称解释

整体架构

Doris主要整合了Google Mesa(数据模型),Apache Impala(MPP Query Engine)和Apache ORCFile (存储格式,编码和压缩) 的技术。

为什么要将这三种技术整合?

- Mesa可以满足我们许多存储需求的需求,但是Mesa本身不提供SQL查询引擎。

- Impala是一个非常好的MPP SQL查询引擎,但是缺少完美的分布式存储引擎。

- 自研列式存储:存储层对存储数据的管理通过storage_root_path路径进行配置,路径可以是多个。存储目录下一层按照分桶进行组织,分桶目录下存放具体的tablet,按照tablet_id命名子目录。

因此选择了这三种技术的组合。

Doris的系统架构如下,Doris主要分为FE和BE两个组件:

- Doris的架构很简洁,使用MySQL协议,用户可以使用任何MySQL ODBC/JDBC和MySQL客户端直接访问Doris,只设**FE(Frontend)、BE(Backend)**两种角色、两个进程,不依赖于外部组件,方便部署和运维。

- FE:Frontend,即 Doris 的前端节点。主要负责接收和返回客户端请求、元数据以及集群管理、查询计划生成等工作

- BE:Backend,即 Doris 的后端节点。主要负责数据存储与管理、查询计划执行等工作。

- FE,BE都可线性扩展

- FE主要有两个角色,一个是follower,另一个是observer。多个follower组成选举组,会选出一个master,master是follower的一个特例,Master跟follower,主要是用来达到元数据的高可用,保证单节点宕机的情况下,元数据能够实时地在线恢复,而不影响整个服务。

- Observer节点仅从 leader 节点进行元数据同步,不参与选举。可以横向扩展以提供元数据的读服务的扩展性。

- 数据的可靠性由BE保证,BE会对整个数据存储多副本或者是三副本。副本数可根据需求动态调整。

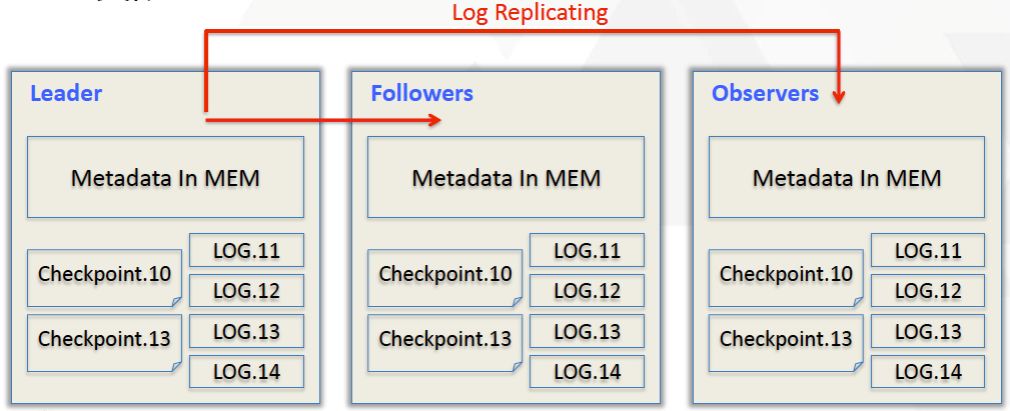

元数据结构

Doris采用Paxos协议以及Memory+ Checkpoint + Journal的机制来确保元数据的高性能及高可靠。元数据的每次更新,都会遵照以下几步:

- 首先写入到磁盘的日志文件中

- 然后再写到内存中

- 最后定期checkpoint到本地磁盘上

相当于是一个纯内存的一个结构,也就是说所有的元数据都会缓存在内存之中,从而保证FE在宕机后能够快速恢复元数据,而且不丢失元数据。

Leader、follower和 observer它们三个构成一个可靠的服务,如果发生节点宕机的情况,一般是部署一个leader两个follower,目前来说基本上也是这么部署的。就是说三个节点去达到一个高可用服务。单机的节点故障的时候其实基本上三个就够了,因为FE节点毕竟它只存了一份元数据,它的压力不大,所以如果FE太多的时候它会去消耗机器资源,所以多数情况下三个就足够了,可以达到一个很高可用的元数据服务。

数据分发

- 数据主要都是存储在BE里面,BE节点上物理数据的可靠性通过多副本来实现,默认是3副本,副本数可配置且可随时动态调整,满足不同可用性级别的业务需求。FE调度BE上副本的分布与补齐。

- 如果说用户对可用性要求不高,而对资源的消耗比较敏感的话,我们可以在建表的时候选择建两副本或者一副本。比如在百度云上我们给用户建表的时候,有些用户对它的整个资源消耗比较敏感,因为他要付费,所以他可能会建两副本。但是我们一般不太建议用户建一副本,因为一副本的情况下可能一旦机器出问题了,数据直接就丢了,很难再恢复。一般是默认建三副本,这样基本可以保证一台机器单机节点宕机的情况下不会影响整个服务的正常运作。

Doris编译部署篇

该章节主要介绍了部署 Doris 所需软硬件环境、建议的部署方式、集群扩容缩容,以及集群搭建到运行过程中的常见问题。

Doris编译

Apache Doris提供直接可以部署的版本压缩包:https://cloud.baidu.com/doc/PALO/s/Ikivhcwb5

也可以自行编译压缩包后使用(推荐)

使用 Docker 开发镜像编译(推荐)

这个是官方文档推荐的,可以非常方便顺利的编译源码,如果需要快速部署的,可以使用这种方式。这种方式的优点就是不用配置环境变量,也不用考虑各种版本问题,进入开发镜像系统后直接下载 doris 源码编译即可。

首先需要安装 Docker,Docker 在 Linux 下安装比较简单,可以参考以下附件:

如果已经启动了 Docker 服务(systemctl status docker),我们直接拉取镜像,开始编译 Doris。

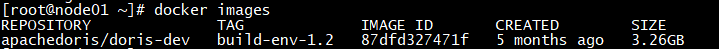

操作步骤

说明

1

拉取Doris官方提供的Docker镜像,目前可用版本有:build-env、build-env-1.1、build-env-1.2

docker pull apachedoris/doris-dev:build-env-1.2

2

查看 Docker 镜像

docker images

3

运行镜像

将容器中的 maven 下载的包保存到宿主机本地指定的文件中,避免重复下载,同时会将编译的 Doris 文件保存到宿主机本地指定的文件,方便部署

docker run -it \

-v /u01/.m2:/root/.m2 \

-v /u01/incubator-doris-DORIS-0.13-release/:/root/incubator-doris-DORIS-0.13-release/ \

apachedoris/doris-dev:build-env-1.2

开启之后, 就在容器内了

4

下载Doris的安装包

cd /opt

5

解压安装

tar -zxvf apache-doris-0.13.0.0-incubating-src.tar.gz

cd apache-doris-0.13.0.0-incubating-src

6

开始编译(此过程需要等待很久,根据网速来定)

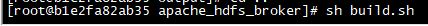

sh build.sh

7

编译完成

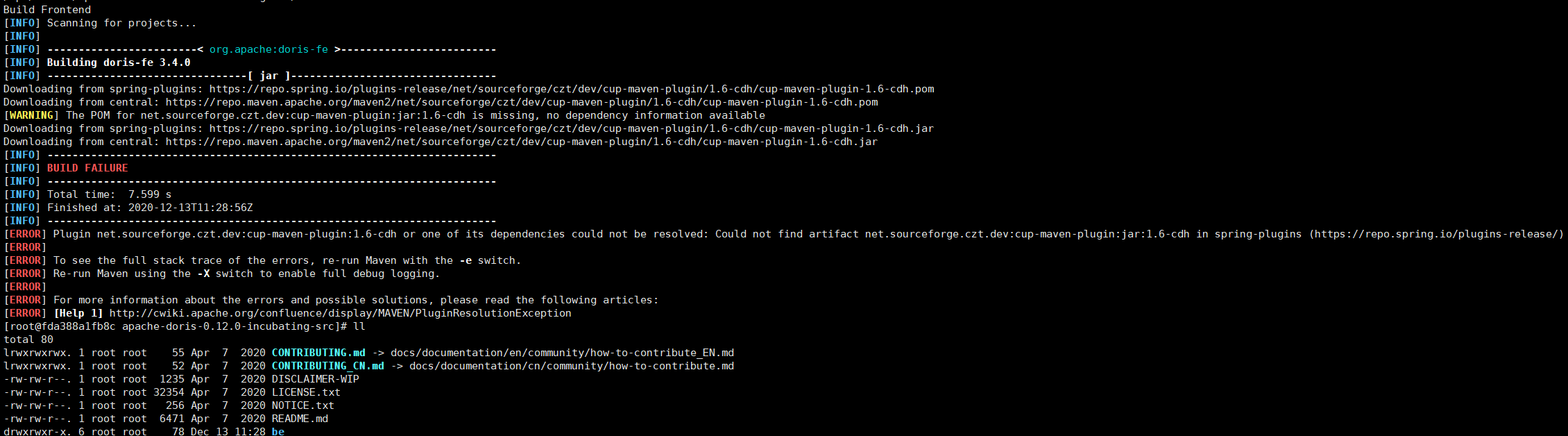

遇到的问题

- 其中错误重点:

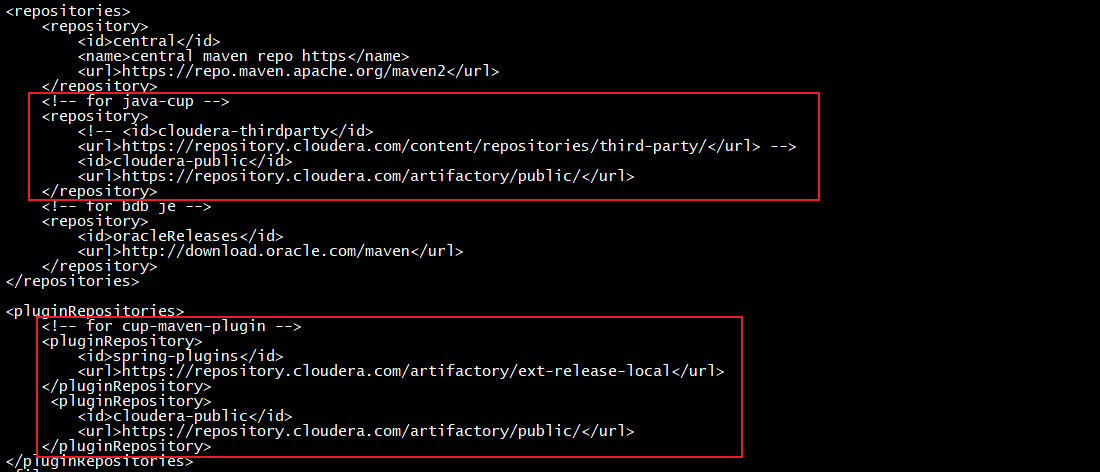

Plugin net.sourceforge.czt.dev:cup-maven-plugin:1.6-cdh or one of its dependencies could not be resolved: Could not find artifact net.sourceforge.czt.dev:cup-maven-plugin:jar:1.6-cdh in spring-plugins (https://repo.spring.io/plugins-release/)

- 解决方式:

vi fe/pom.xml change

然后再次重新执行编译

直接编译(CentOS/Ubuntu)

使用直接编译方式需要注意第三方包的下载一定要下载指定连接的包且务必完整。

环境准备

- Centos Linux release 7.7.1908

- GCC 7.3+

- Oracle JDK 1.8+

- Python 2.7+

- Apache Maven 3.5+

- CMake 3.11+

- Bison 3.0+

系统依赖(一次性安装)

如果一次性安装所需软件,可以直接使用官方的如下命令:

sudo yum groupinstall ‘Development Tools’ && sudo yum install maven cmake byacc flex automake libtool bison binutils-devel zip unzip ncurses-devel curl git wget python2 glibc-static libstdc+±static java-1.8.0-openjdk

手动安装系统依赖

如果单独安装可以参考如下步骤

CMake 3.11+

# 0 基本的务必安装

yum install **-**y zip unzip curl git wget python2

# 1 下载并解压

# 访问 https://cmake.org/files,比如以 linux x86_64 系统为例,安装 3.11.4,可以下载如下

wget https**😕/cmake.org/files/v3.11/**cmake-3.11.4-Linux-x86_64.tar.gz

tar **-**zxf cmake-3.11.4-Linux-x86_64.tar.gz

# 2 编译或创建软连

#cd cmake-3.11.4-Linux-x86_64

#./bootstrap --prefix=/usr/local/cmake

mv cmake-3.11.4-Linux-x86_64 **/usr/local/**cmake

ln -s **/usr/local/cmake/bin/**cmake **/usr/bin/**cmake

# 3 添加到环境变量

export PATH**=$PATH:/usr/local/cmake/**bin

# 查看版本验证

cmake **–**version

GCC 7.3+

这一步非常重要,最好下载满足条件的版本,耐心的编译,否则因为 GCC 版本或者包的问题容易在编译 Doris 出现一系列莫名的错误,因为 Doris 中依赖了较多的三方库(可以查看thirdparty/vars.sh),其中有些三方库会一般都需要对应的版本对 GCC 有一些要求。

# 1 查看环境中的 gcc 是否满足条件

gcc **-**v

# 2 环境(必须)

yum groupinstall “Development Tools”

yum install **-**y glibc-static libstdc+±static

yum install **-**y byacc flex automake libtool binutils-devel ncurses-devel

# 3 下载 GCC

# 例如这里下载 gcc 7.3.0 版本

# 官网下载页:https://gcc.gnu.org/releases.html

# 3.1 方式一【推荐】:编译方式(以 华中科技大源 为例)

wget http**😕/mirror.hust.edu.cn/gnu/gcc/gcc-7.3.0/**gcc-7.3.0.tar.xz

tar **-**xf gcc-7.3.0.tar.xz

cd gcc-7.3.0

# 下载需要的包

# 需方访问 ftp://gcc.gnu.org/pub/gcc/infrastructure/,

# 如果失败可以将 mpc-1.0.3.tar.gz、mpfr-3.1.4.tar.bz2、isl-0.16.1.tar.bz2、gmp-6.1.0.tar.bz2 包下载放到项目根目录下

**./contrib/**download_prerequisites

# 编译

mkdir build

cd build

**…/**configure **–prefix=/usr/local/**gcc-7.3.0 **–enable-checking=**release **–enable-languages=c,**c++ **–**disable-multilib

# 若给的资源不够,会导致编译时间较长

make -j\[(nproc)/4+1]

make install

# 3.2 方式二:解压后创建软连直接使用

wget https**😕/gfortran.meteodat.ch/download/x86_64/releases/**gcc-7.5.0.tar.xz

tar **-**xf gcc-7.5.0.tar.xz

mv gcc-7.5.0 /usr/local/

# 4【可选】卸载或备份

rpm **-**q gcc

rpm -e gcc-4.8.5-39.el7.x86_64

rpm **-**q libmpc

rpm **-**q mpfr

# 【推荐】备份

mv **/usr/bin/**gcc **/usr/bin/**gcc_old

mv **/usr/bin/**g++ **/usr/bin/**g++_old

mv **/usr/lib64/**libstdc++.so.6 **/usr/lib64/**libstdc++.so.6_old

# 5 创建软连

ln -s **/usr/local/gcc-7.3.0/bin/**gcc **/usr/bin/**gcc

ln -s **/usr/local/gcc-7.3.0/bin/**g++ **/usr/bin/**g++

cp **/usr/local/gcc-7.3.0/lib64/**libstdc++.so.6.0.24 /usr/lib64/

ln -s **/usr/lib64/**libstdc++.so.6.0.24 **/usr/lib64/**libstdc++.so.6

ln -s **/usr/local/gcc-7.3.0/lib64/**libatomic.so.1 **/usr/lib64/**libatomic.so.1

# 5 查看版本以验证

gcc **-**v

g++ **-**v

strings **/usr/lib64/**libstdc++.so.6 | grep GLIBC

Bison 3.0+

# 1 查看当前系统的 Bsion 版本

bison **-**V

# 2 如果没有,则需要安装

wget http**😕/ftp.gnu.org/gnu/bison/**bison-3.0.5.tar.xz

tar **-**xf bison-3.0.5.tar.xz

cd bison-3.0.5

mkdir build

cd build

**…/**configure **–prefix=/usr/local/**bison-3.0.5

make && make install

# 3 替换为新版本

mv **/usr/bin/**bison **/usr/bin/**bison_old

ln -s **/usr/local/bison-3.0.5/bin/**bison **/usr/bin/**bison

其它

Apache Maven 需要 3.5+ 、Oracle JDK 1.8+ 、Python 2.7+ 这些可自行查找相关资料进行安装。

开始编译 Doris

操作步骤

说明

1

下载Doris的安装包

wget https**😕/mirrors.tuna.tsinghua.edu.cn/apache/incubator/doris/0.13.0-incubating/** apache-doris-0.13.0.0-incubating-src.tar.gz

2

解压缩

tar **-**zxf apache-doris-0.13.0.0-incubating-src.tar.gz

3

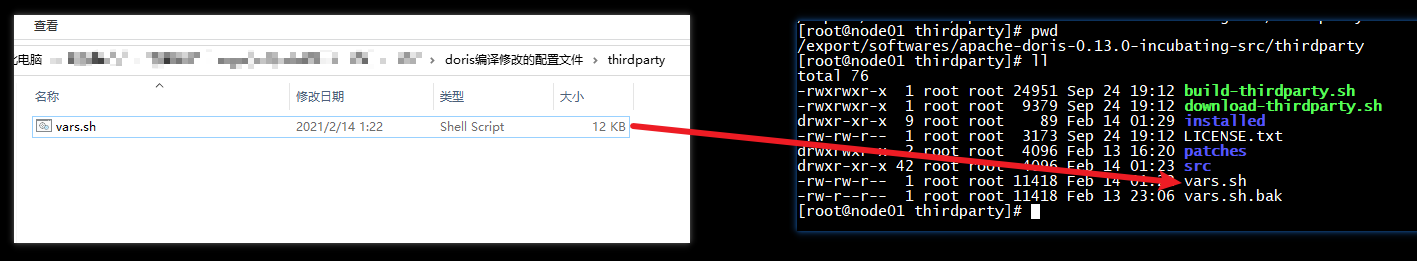

上传“doris编译修改的配置文件\\thirdparty\vars.sh”脚本文件覆盖到“/export/softwares/ apache-doris-0.13.0.0-incubating-src/thirdparty”目录

4

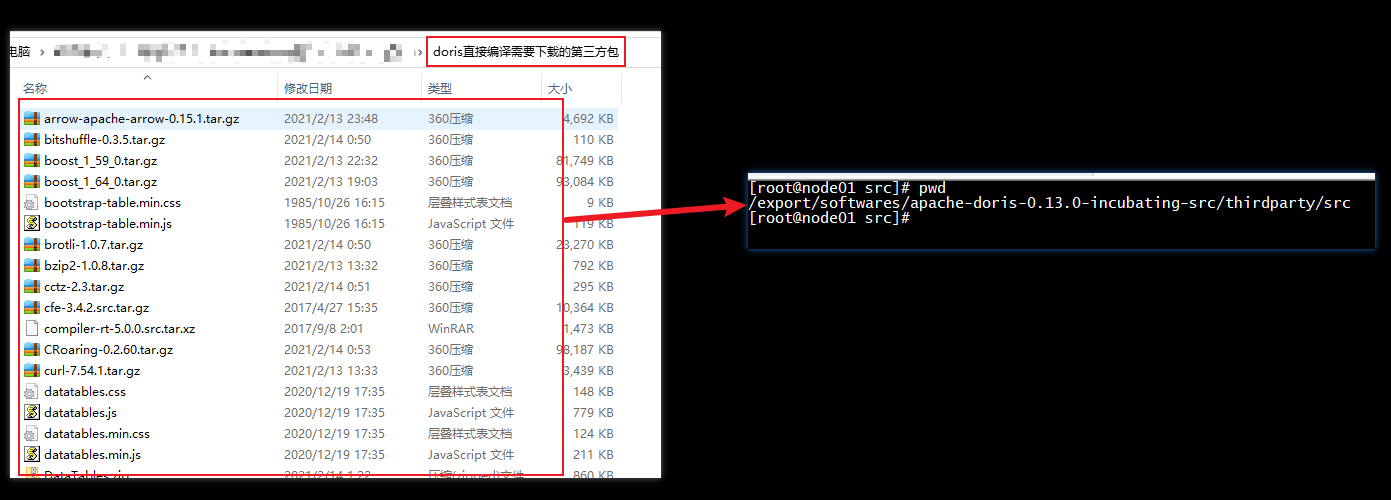

【为加速编译可以使用提供的第三方包】

上传“doris直接编译需要下载的第三方包”目录下所有文件上传到“/export/softwares/ apache-doris-0.13.0.0-incubating-src/thirdparty/src”目录

5

开始编译

cd apache-doris-0.13.0.0-incubating-src

# 从 0.13 版本开始,因为协议的不兼容,移除了 mysql-5.7.18 和 lzo-2.10 库

# 如果需要访问 mysql 外部表,可以编译时手动添加 WITH_MYSQL=1

# 如果需要继续使用 LZO 压缩算法(例如访问早期写入数据时),添加 WITH_LZO=1

# 如果编译的机器网速很慢,可以后台执行

#WITH_MYSQL=1 sh build.sh >log.txt 2>&1 &

# --clean

WITH_MYSQL=1 sh build.sh

遇到的问题

js_generator.cc:(.text+0xfc3c): undefined reference to `well_known_types_js’

查找 Doris 源码中的 js_embed,一般在三方库的 protobuf 下,直接移除掉,重新编译即可

find ./ **-**name js_embed

mv **./thirdparty/src/protobuf-3.5.1/src/**js_embed ./

/lib64/libstdc++.so.6: version `GLIBCXX_3.4.21’ not found

问题的原因就是在使用 gcc 编译时,使用本地环境的库 libstdc++.so.6 中的方法时找不到需要的信息,一般是在安装或升级是没有把环境变量的这个库文件升级,解决方法如下:

find / **-**name “libstdc++.so*”

cd **/usr/**lib64

strings **/usr/lib64/**libstdc++.so.6 | grep GLIBC

# 查看 /usr/lib64 目录下的 libstdc 开头的文件

[root@node1 lib64]# ll libstdc*****

lrwxrwxrwx 1 root root 19 Nov 19 09**😗*07 libstdc++.so.6 -> libstdc++.so.6.0.19

**-rwxr-xr-x 1 root root 995840 Sep 30 10😗*17 libstdc++.so.6.0.19

# 把高版本的拷贝到 /usr/lib64 下

cp **/usr/local/gcc-7.3.0/lib64/**libstdc++.so.6.0.24 ./

# 创建软连接

rm libstdc++.so.6

ln -s libstdc++.so.6.0.24 libstdc++.so.6

libatomic.so.1: cannot open shared object file: No such file or directory

编译三方包时如果报如下的错误

./comp_err: error while loading shared libraries**😗* libatomic.so.1**😗* cannot open shared object file**😗* No such file or directory

make**[3]😗* *** [include/mysqld_error.h] Error 127

make**[2]😗* *** [extra/CMakeFiles/GenError.dir/all] Error 2

make**[1]😗* *** [libmysql/CMakeFiles/mysqlclient.dir/rule] Error 2

make**😗* *** [mysqlclient] Error 2

原因是安装 gcc 或升级之后,其中的 libatomic.so.1 包没有在环境变量中生效,我们直接将新版本 gcc 的安装目录下的 libatomic.so.1 软连到 /usr/lib64 下即可。

ln -s **/usr/local/gcc-7.3.0/lib64/**libatomic.so.1 **/usr/lib64/**libatomic.so.1

Could NOT find Curses (missing: CURSES_LIBRARY CURSES_INCLUDE_PATH)

在编译安装 GCC 7.3 时,其中我们安装了 ncurses-devel,如果忽略了这个,系统环境又没有安装,则在编译 Doris 时就会报这个错误,解决方法就是 yum 安装这个依赖。

yum install ncurses-devel

configure: error: Building GCC requires GMP 4.2+, MPFR 2.4.0+ and MPC 0.8.0+.

环境中缺少依赖,解决方法如下:

yum install gmp gmp-devel mpfr mpfr-devel libmpc libmpc-devel

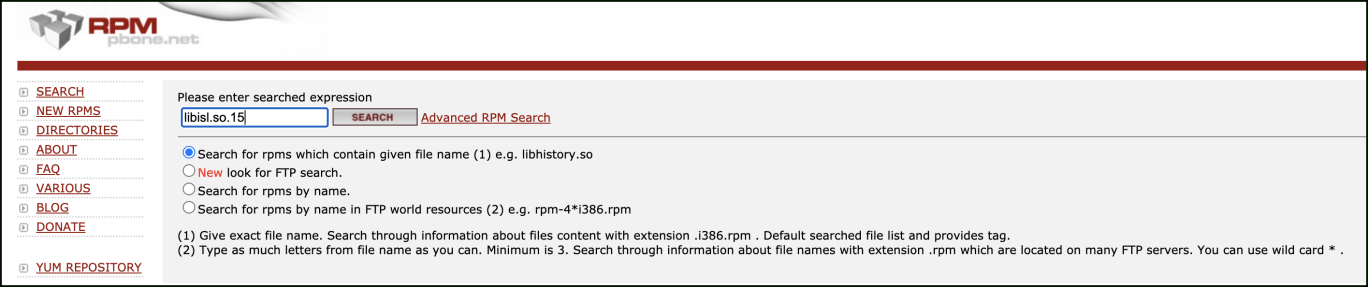

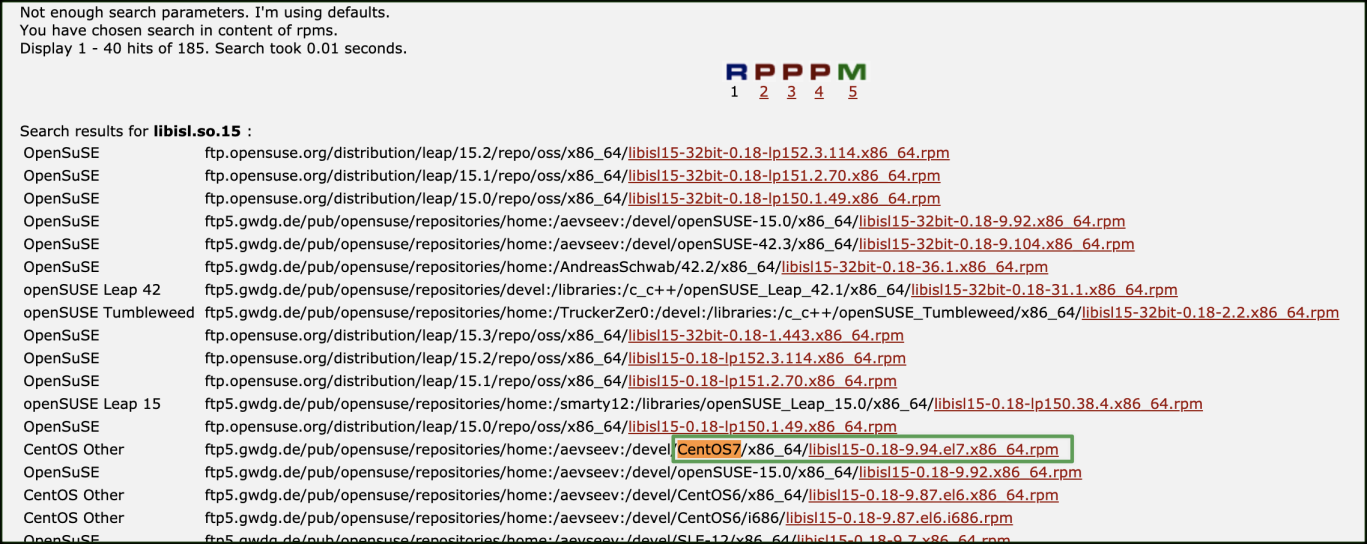

error while loading shared libraries: libisl.so.15: cannot open shared object file: No such file or directory

这个问题比较隐蔽,通过访问 http://rpm.pbone.net/搜索 libisl.so.15 库。

在查询出的结果中,我们查找 CentOS7 的条目,可以发下这个库为 libisl15-0.18-9.94.el7.x86_64.rpm,到这里问题就好解决了,我们直接下载这个包安装即可

wget ftp**😕/ftp.pbone.net/mirror/ftp5.gwdg.de/pub/opensuse/repositories/home😕aevseev😕devel/CentOS7/x86_64/**libisl15-0.18-9.94.el7.x86_64.rpm

rpm **-**ivh libisl15-0.18-9.94.el7.x86_64.rpm

Could not resolve dependencies for project org.apache:fe-core:jar:3.4.0: Failure to find com.sleepycat:je:jar:7.3.7

原因就是通过 https://repo.spring.io/libs-milestone/com/sleepycat/je/7.3.7/je-7.3.7.jar 下载包时需要用户认证,所以会下载失败,可以在 Maven 配置文件 setting.xml 中新增如下的仓库镜像,重新编译即可。

A required class was missing while executing net.sourceforge.czt.dev:cup-maven-plugin:1.6-cdh:generate: org/sonatype/plexus/build/incremental/BuildContext

清除 Maven 本地仓库的 cup-maven-plugin(Maven 配置的仓库路径下的 net/sourceforge/czt/dev/cup-maven-plugin/1.6-cdh),为了防止其他镜像资源的影响,可以先将本地 Maven 配置文件中添加的其它镜像注释掉,可以只保留下面的一个镜像,用来可以正常下载 je-7.3.7.jar 依赖包。

Doris 源码下的 fe/pom.xml 中的

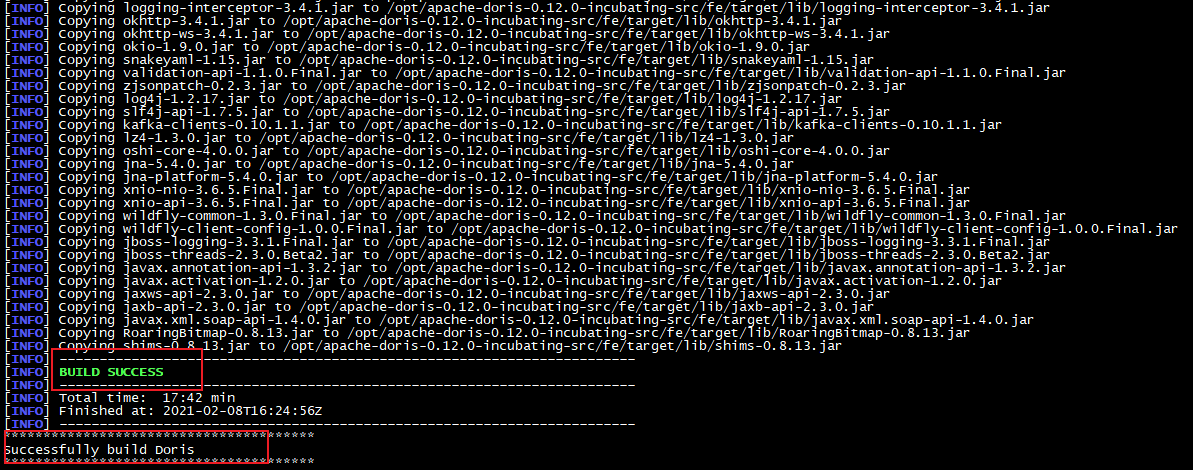

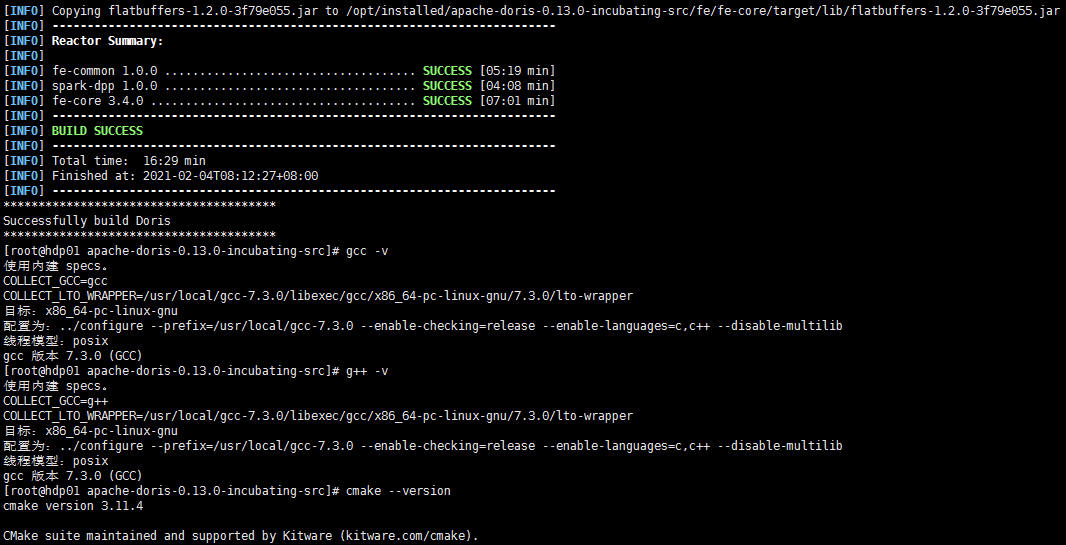

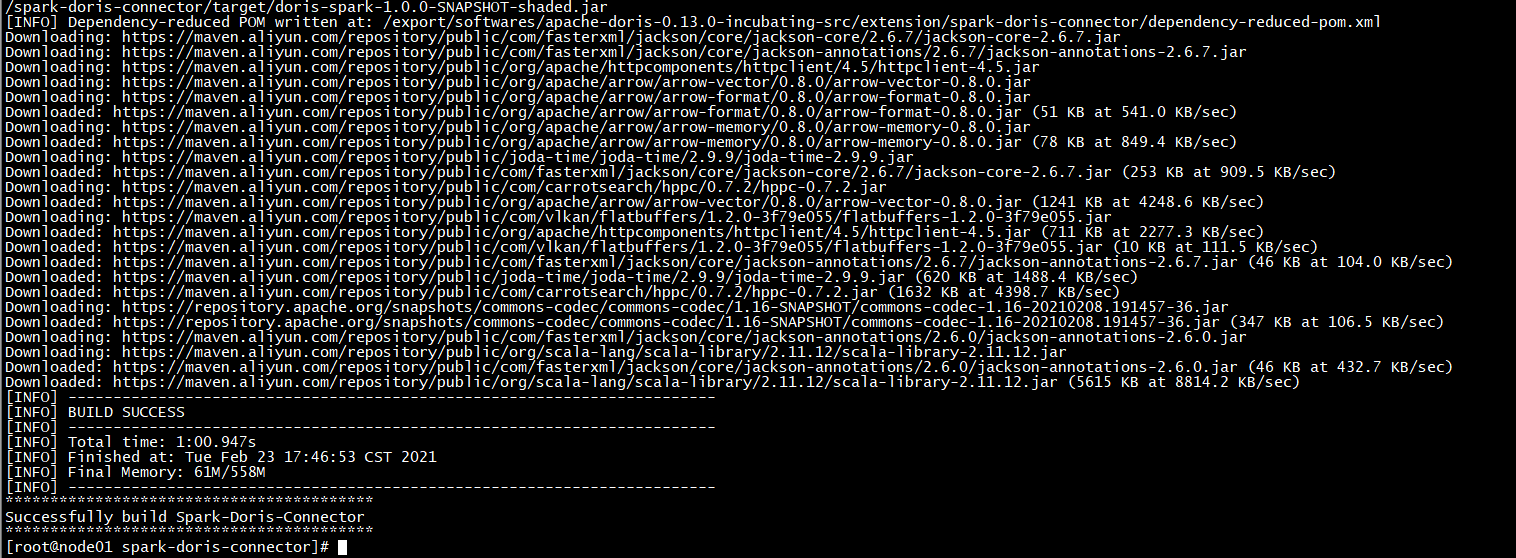

编译成功

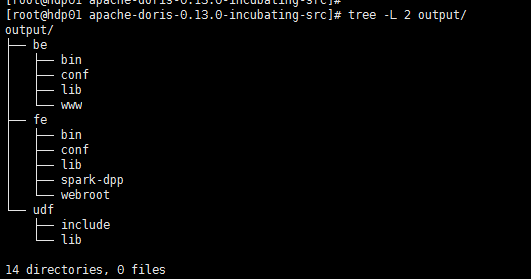

Doris 编译成功后控制台显示如下 Successfully build Doris

同时编译成功后会在项目根目录下生成 output/,其中为编译之后可以直接部署的二进制包,大概有 1.2GB。

安装与部署

该章节主要介绍了部署 Doris 所需软硬件环境、建议的部署方式、集群扩容缩容,以及集群搭建到运行过程中的常见问题

软硬件需求

Doris 作为一款开源的 MPP 架构 OLAP 数据库,能够运行在绝大多数主流的商用服务器上。为了能够充分运用 MPP 架构的并发优势,以及 Doris 的高可用特性,我们建议 Doris 的部署遵循以下需求:

- Linux 操作系统版本需求

Linux系统

版本

Centos

7.1及以上

Ubuntu

16.04及以上

- 软件需求

软件

版本

Java

1.8及以上

GCC

7.3及以上

- 开发测试环境

模块

CPU

内存

磁盘

网络

实例数量

Frontend

8核+

8GB+

SSD 或 SATA,10GB+ *

千兆网卡

1

Backend

8核+

16GB+

SSD 或 SATA,50GB+ *

千兆网卡

1-3 *

- 生产环境

模块

CPU

内存

磁盘

网络

实例数量

Frontend

16核+

64GB+

SSD 或 RAID,100GB+ *

万兆网卡

1-5 *

Backend

16核+

64GB+

SSD 或 SATA,100GB+ *

万兆网卡

10-100 *

注意点一:

- FE 的磁盘空间主要用于存储元数据,包括日志和 image。通常从几百 MB 到几个 GB 不等。

- BE 的磁盘空间主要用于存放用户数据,总磁盘空间按用户总数据量 * 3(3副本)计算,然后再预留额外 40% 的空间用作后台 compaction 以及一些中间数据的存放。

- 一台机器上可以部署多个 BE 实例,但是只能部署一个 FE。如果需要 3 副本数据,那么至少需要 3 台机器各部署一个 BE 实例(而不是1台机器部署3个BE实例)。多个FE所在服务器的时钟必须保持一致(允许最多5秒的时钟偏差)

- 测试环境也可以仅适用一个 BE 进行测试。实际生产环境,BE 实例数量直接决定了整体查询延迟。

- 所有部署节点关闭 Swap。

注意点二:FE 节点的数量

-

FE 角色分为 Follower 和 Observer,(Leader 为 Follower 组中选举出来的一种角色,以下统称 Follower,具体含义见 元数据设计文档)。

-

FE 节点数据至少为1(1 个 Follower)。当部署 1 个 Follower 和 1 个 Observer 时,可以实现读高可用。当部署 3 个 Follower 时,可以实现读写高可用(HA)。

-

Follower 的数量必须为奇数,Observer 数量随意。

-

根据以往经验,当集群可用性要求很高是(比如提供在线业务),可以部署 3 个 Follower 和 1-3 个 Observer。如果是离线业务,建议部署 1 个 Follower 和 1-3 个 Observer。

-

- 通常我们建议 10 ~ 100 台左右的机器,来充分发挥 Doris 的性能(其中 3 台部署 FE(HA),剩余的部署 BE)

- 当然,Doris的性能与节点数量及配置正相关。在最少4台机器(一台 FE,三台 BE,其中一台 BE 混部一个 Observer FE 提供元数据备份),以及较低配置的情况下,依然可以平稳的运行 Doris。

- 如果 FE 和 BE 混部,需注意资源竞争问题,并保证元数据目录和数据目录分属不同磁盘。

-

Broker 部署

- Broker 是用于访问外部数据源(如 hdfs)的进程。通常,在每台机器上部署一个 broker 实例即可。

-

网络需求

Doris 各个实例直接通过网络进行通讯。以下表格展示了所有需要的端口

- 当部署多个 FE 实例时,要保证 FE 的 http_port 配置相同。

- 部署前请确保各个端口在应有方向上的访问权限。

资源规划

node1

node2

node3

FE(Leader)

FE(Follower)

FE(Follower)

BE

BE

BE

BROKER

BROKER

BROKER

注意点:

- 因测试环境资源有限,FE和BE节点部署在相同服务器,生产环境建议分开

启动FE

配置环境变量

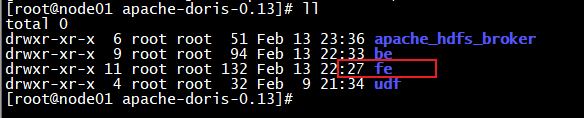

- 拷贝 FE 部署文件到指定节点(node1)

将源码编译生成的 output 下的 fe 文件夹拷贝到 FE 的节点/export/server/apache-doris-0.13.0路径下

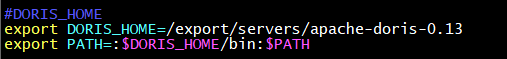

- 配置环境变量

vim /etc/profile

#DORIS_HOME

export DORIS_HOME**=/export/server/apache-doris-0.13.0**

export PATH**=:PATH**

重新加载环境变量:source /etc/profile

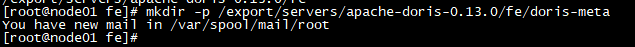

创建doris-mate

- 配置文件为 fe/conf/fe.conf。其中注意:meta_dir:元数据存放位置。默认在 fe/doris-meta/ 下。需手动创建该目录

mkdir -p /export/server/apache-doris-0.13.0/fe/doris-meta

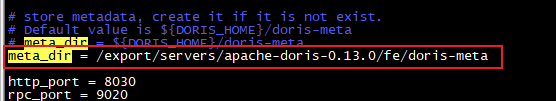

- 配置fe/conf/fe.conf配置文件

vim conf/fe.conf

meta_dir = /export/server/apache-doris-0.13.0/fe/doris-meta

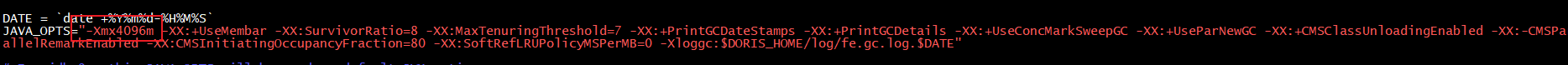

修改fe.conf中的JAVA_OPTS

- fe.conf 中 JAVA_OPTS 默认 java 最大堆内存为 4GB,建议生产环境调整至 8G 以上。

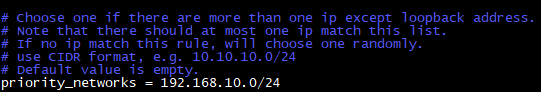

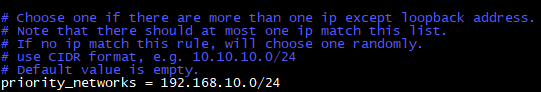

修改ip绑定(可选)

如果机器有多个ip, 比如内网外网, 虚拟机docker等, 需要进行ip绑定, 以便在配置集群时可以正确识别

修改fe服务的配置文件(ip地址根据环境实际ip进行修改)

vim /export/server/apache-doris-0.13.0/fe/conf/fe.conf

priority_networks = 192.168.10.0/24

将安装目录分发到另外两台节点

scp -r /export/server/apache-doris-0.13.0/ node2:/export/server/

scp -r /export/server/apache-doris-0.13.0/ node3:/export/server/

启动FE

三台机器分别启动

sh /export/server/apache-doris-0.13.0/fe/bin/start_fe.sh --daemon

日志默认存放在 fe/log/ 目录下

配置BE

配置be节点

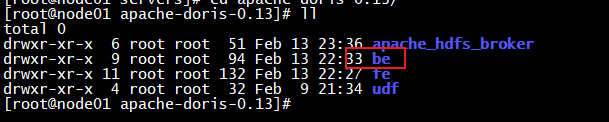

- 拷贝 BE 部署文件到指定节点(node1)

将源码编译生成的 output 下的 be 文件夹拷贝到 BE 的节点/export/server/apache-doris-0.13.0路径下

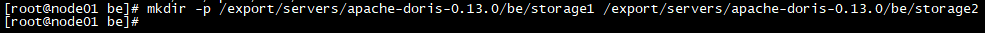

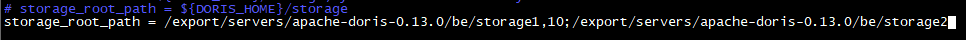

创建storage_root_path, 并配置be.conf

配置文件为 be/conf/be.conf。主要是配置 storage_root_path:数据存放目录。默认在be/storage下,需要手动创建该目录。多个路径之间使用 ; 分隔(最后一个目录后不要加 ;)

mkdir -p /export/server/apache-doris-0.13.0/be/storage1 /export/server/apache-doris-0.13.0/be/storage2

vim conf/be.conf

storage_root_path = /export/server/apache-doris-0.13.0/be/storage1,10;/export/server/apache-doris-0.13.0/be/storage2

添加BE

使用mysql连接

操作步骤

说明

1

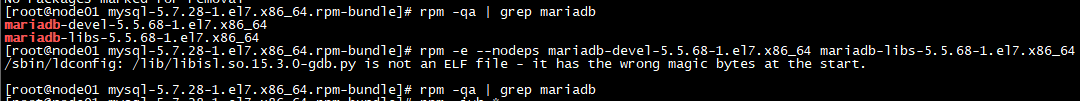

删除操作系统自带的mysql库文件(node1)

rpm -qa | grep mariadb

rpm -e --nodeps mariadb-libs-5.5.68-1.el7.x86_64

2

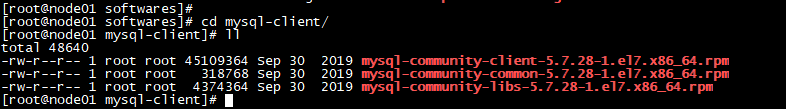

安装mysql-client

上传”资料\软件\mysql-client”目录下的rpm到服务器节点/export/server/mysql-client

3

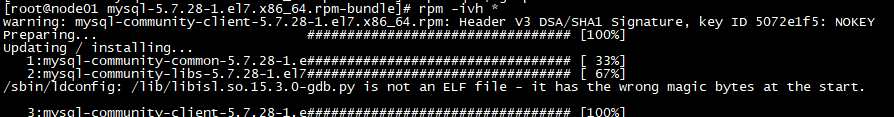

进行安装

rpm -ivh *

4

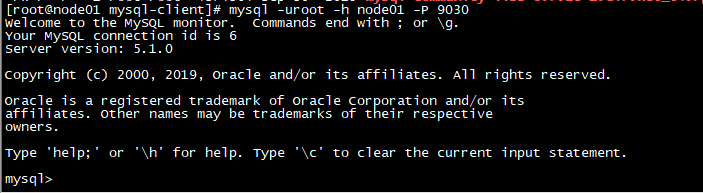

连接node1服务器上的mysql实例(默认端口9030,默认没有密码)

mysql -uroot -h node1 -P 9030

5

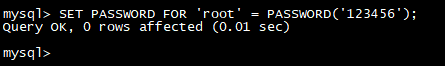

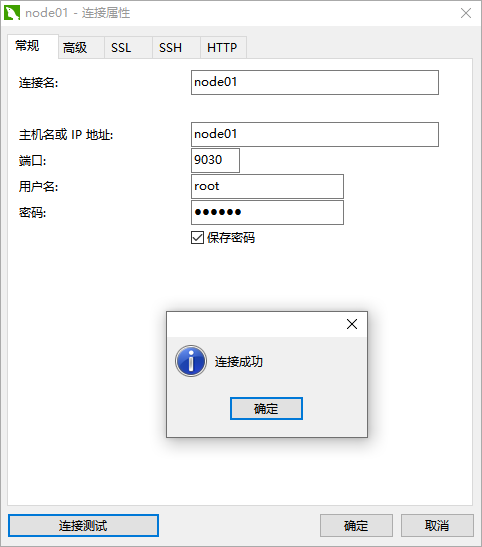

登陆后,可以通过以下命令修改 root 密码

SET PASSWORD FOR ‘root’ = PASSWORD**(‘123456’);**

6

使用Navicat客户端登录

添加be

操作步骤

说明

1

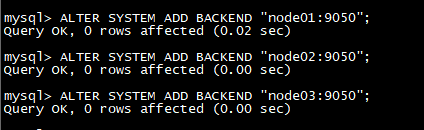

BE 节点需要先在 FE 中添加,才可加入集群(node1)

mysql -uroot -h node1 -P 9030 -p

输入密码:123456

2

登录后添加BE节点port为be上的heartbeat_service_port端口,默认9050

ALTER SYSTEM ADD BACKEND “node1:9050”;

ALTER SYSTEM ADD BACKEND “node2:9050”;

ALTER SYSTEM ADD BACKEND “node3:9050”;

3

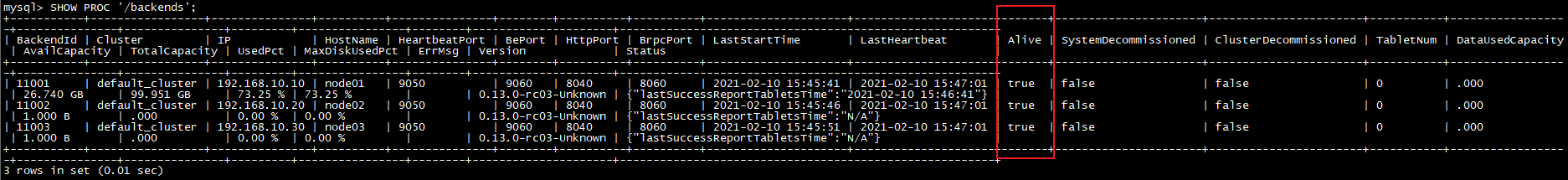

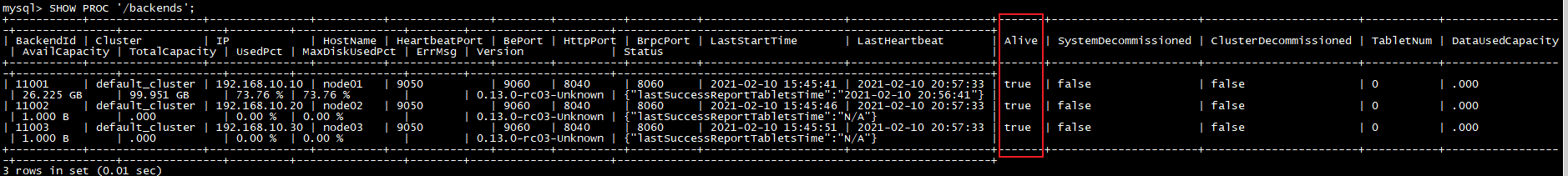

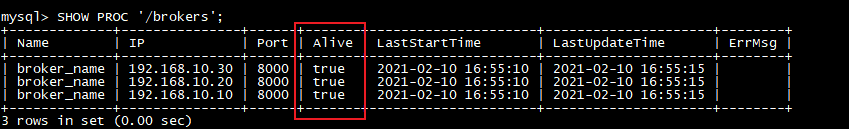

查看BE状态,alive必须为true

SHOW PROC ‘/backends’;

查看 BE 运行情况。如一切正常,isAlive 列应为 true

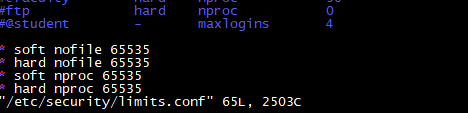

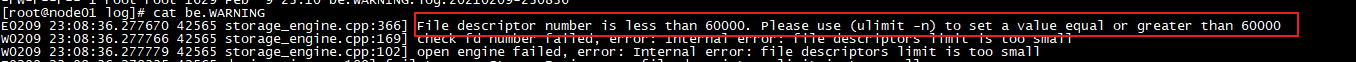

修改可打开文件数

ulimit -n 65535

上述方式在重启系统后失效

或者修改配置文件: /etc/security/limits.conf, 添加

* soft nofile 65535

* hard nofile 65535

* soft nproc 65535

* hard nproc 65535

这种方法需要重启机器才能生效(所有BE节点都需要进行配置)

否则启动不成功, 日志报错

修改ip绑定

如果机器有多个ip, 比如内网外网, 虚拟机docker等, 需要进行ip绑定, 以便在配置集群时可以正确识别

修改fe服务的配置文件(ip地址根据环境实际ip进行修改)

vim /export/server/apache-doris-0.13.0/be/conf/be.conf

priority_networks = 192.168.10.0/24

将安装目录分发到另外两台节点

scp -r /export/server/apache-doris-0.13.0/be node2:/export/server/apache-doris-0.13.0

scp -r /export/server/apache-doris-0.13.0/be node3:/export/server/apache-doris-0.13.0

启动BE

三台机器分别启动

sh /export/server/apache-doris-0.13.0/be/bin/start_be.sh --daemon

日志默认存放在 fe/log/ 目录下

查看FE 和 BE

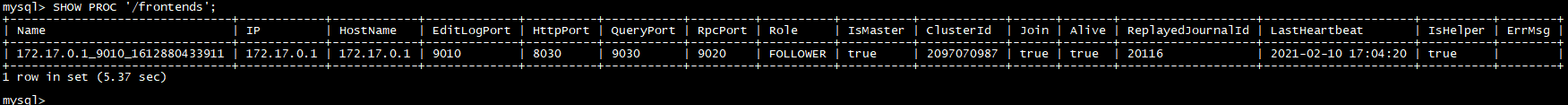

- 在mysql终端中

show proc ‘/frontends’;

show proc ‘/backends’;

查看 BE 运行情况。如一切正常,isAlive 列应为 true

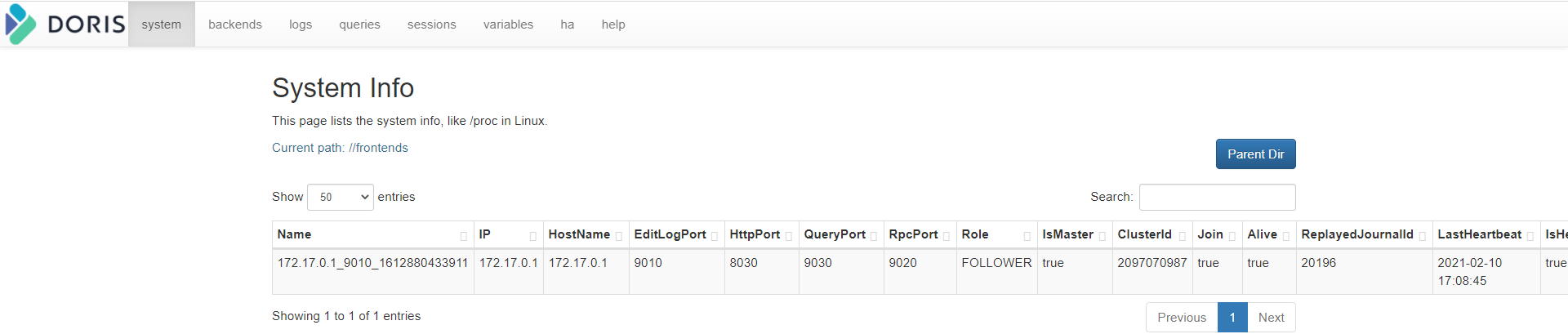

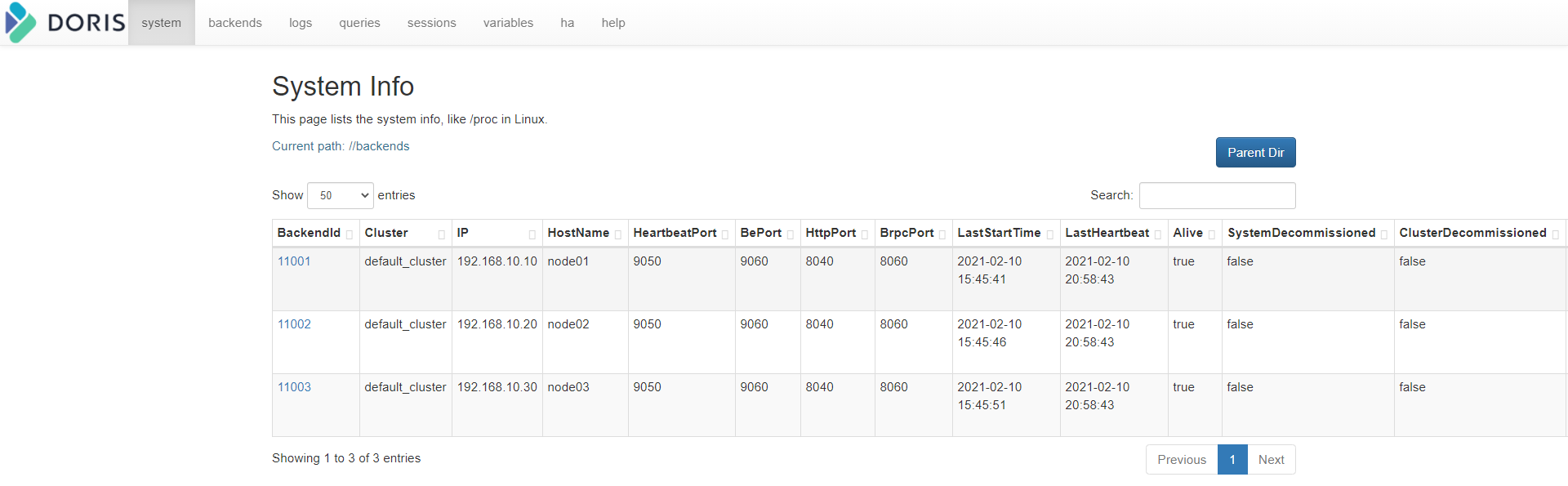

- 通过前端界面访问FE:

http://192.168.52.150:8030/frontend

http://192.168.52.150:8030/system?path=//frontends

- 通过前端界面访问BE:

http://192.168.52.150:8030/backend

http://192.168.52.150:8030/system?path=//backends

用户名为root, 密码为空

添加FS_BROKER(可选)

BROKER以插件的形式,独立于Doris的部署,建议每个PE和BE节点都部署一个Broker,Broker是用于访问外部数据源的进程,默认是HDFS,上传编译好的hdfs_broker

配置broker节点

拷贝源码 fs_broker 的 output 目录下的相应 Broker 目录到需要部署的所有节点上。建议和 BE 或者 FE 目录保持同级。

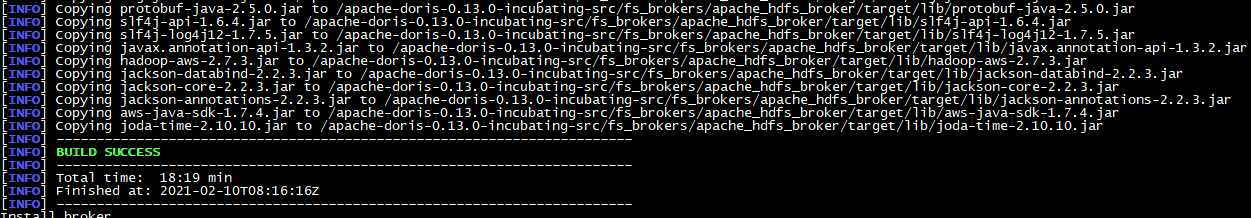

编译fs_broker

拷贝output目录的部署到node1节点

docker cp b1e2fa82ab35:/ apache-doris-0.13.0-incubating-src/fs_brokers/apache_hdfs_broker/output /export/server/apache-doris-0.13.0/

将安装目录分发到另外两台节点

进入/export/server/apache-doris-0.13.0目录

scp -r apache_hdfs_broker/ node2:/export/server/apache-doris-0.13.0/

scp -r apache_hdfs_broker/ node3:/export/server/apache-doris-0.13.0/

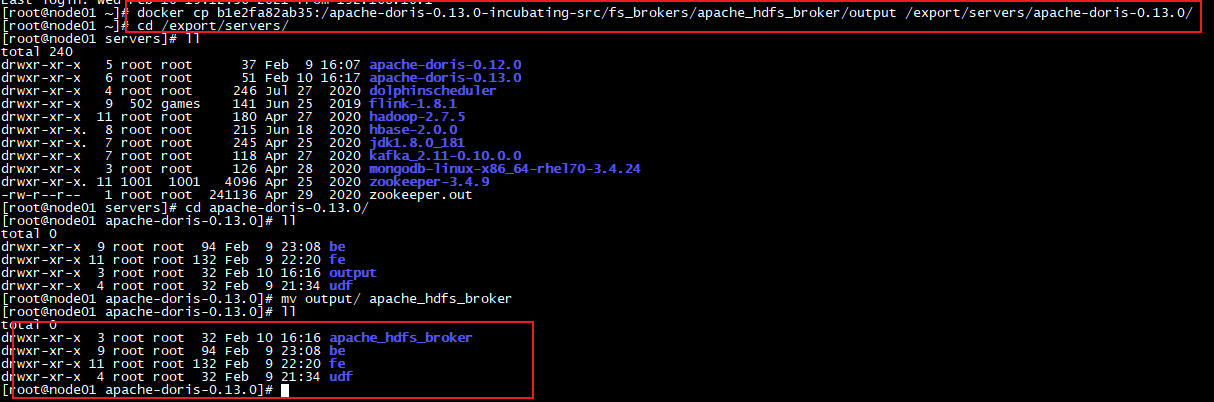

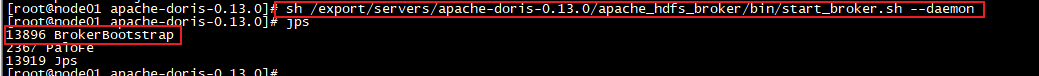

启动 Broker

三台机器分别启动

sh /export/server/apache-doris-0.13.0/apache_hdfs_broker/bin/start_broker.sh --daemon

添加broker节点

使用mysql客户端访问pe,添加broker节点

mysql -uroot -h node1 -P 9030 -p

输入密码:123456

要让 Doris 的 FE 和 BE 知道 Broker 在哪些节点上,通过 sql 命令添加 Broker 节点列表

ALTER SYSTEM ADD BROKER broker_name “node1:8000”,“node2:8000”,“node3:8000”;

其中 host 为 Broker 所在节点 ip;port 为 Broker 配置文件中的 broker_ipc_port。

查看 Broker 状态

SHOW PROC “/brokers”;

注:在生产环境中,所有实例都应使用守护进程启动,以保证进程退出后,会被自动拉起,如 Supervisor (opens new window)。如需使用守护进程启动,在 0.9.0 及之前版本中,需要修改各个 start_xx.sh 脚本,去掉最后的 & 符号。从 0.10.0 版本开始,直接调用 sh start_xx.sh 启动即可。也可参考 这里

扩容缩容

Doris 可以很方便的扩容和缩容 FE、BE、Broker 实例。

FE 扩容和缩容

可以通过将 FE 扩容至 3 个以上节点来实现 FE 的高可用。

FE 节点的扩容和缩容过程,不影响当前系统运行

- 增加 FE 节点

FE 分为 Leader,Follower 和 Observer 三种角色。 默认一个集群,只能有一个 Leader,可以有多个 Follower 和 Observer。其中 Leader 和 Follower 组成一个 Paxos 选择组,如果 Leader 宕机,则剩下的 Follower 会自动选出新的 Leader,保证写入高可用。Observer 同步 Leader 的数据,但是不参加选举。如果只部署一个 FE,则 FE 默认就是 Leader。

第一个启动的 FE 自动成为 Leader。在此基础上,可以添加若干 Follower 和 Observer。

添加 Follower 或 Observer。使用 mysql-client 连接到已启动的 FE,并执行:

ALTER SYSTEM ADD FOLLOWER “ip:port”;

或

ALTER SYSTEM ADD OBSERVER “ip:port”;

其中host为Follower或Observer所在节点 ip,port 为其配置文件 fe.conf 中的 edit_log_port。

配置及启动 Follower或Observer。Follower 和 Observer 的配置同 Leader 的配置。

第一次启动时,需执行以下命令:

./bin/start_fe.sh --helper host:port --daemon

其中 host 为 Leader 所在节点 ip, port 为 Leader 的配置文件 fe.conf 中的 edit_log_port。–helper 参数仅在 follower 和 observer 第一次启动时才需要。

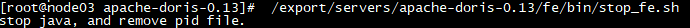

查看 Follower 或 Observer 运行状态。使用 mysql-client 连接到任一已启动的 FE,并执行:SHOW PROC ‘/frontends’; 可以查看当前已加入集群的 FE 及其对应角色。

FE 扩容注意事项:

-

Follower FE(包括 Leader)的数量必须为奇数,建议最多部署 3 个组成高可用(HA)模式即可

-

当 FE 处于高可用部署时(1个 Leader,2个 Follower),我们建议通过增加 Observer FE 来扩展 FE 的读服务能力。当然也可以继续增加 Follower FE,但几乎是不必要的

-

通常一个 FE 节点可以应对 10-20 台 BE 节点。建议总的 FE 节点数量在 10 个以下。而通常 3 个即可满足绝大部分需求

-

helper 不能指向 FE 自身,必须指向一个或多个已存在并且正常运行中的 Master/Follower FE

-

删除 FE 节点

使用以下命令删除对应的 FE 节点:

ALTER SYSTEM DROP FOLLOWER**[OBSERVER]** “fe_host:edit_log_port”;

FE 缩容注意事项:

-

删除 Follower FE 时,确保最终剩余的 Follower(包括 Leader)节点为奇数

-

操作演示

操作步骤

说明

1

使用mysql客户端访问pe,添加broker节点

mysql -uroot -h node1 -P 9030 -p

输入密码:123456

2

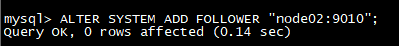

将node2节点添加为FOLLOWER

ALTER SYSTEM ADD FOLLOWER “node2:9010”;

3

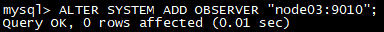

将node3节点添加为OBSERVER

ALTER SYSTEM ADD OBSERVER “node3:9010”;

4

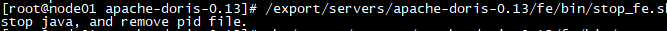

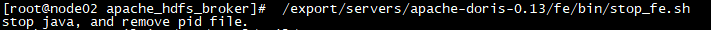

分别停止三台节点的fe服务(三台节点依次停止)

**/export/server/apache-doris-0.13.0/fe/bin/**stop_fe.sh

5

启动node1节点

sh **/export/server/apache-doris-0.13.0/fe/bin/**start_fe.sh **–**daemon

6

启动node2节点(指定leader节点的位置)

sh **/export/server/apache-doris-0.13.0/fe/bin/**start_fe.sh **–helper node1😗*9010 **–**daemon

7

启动node3节点(指定leader节点的位置)

sh **/export/server/apache-doris-0.13.0/fe/bin/**start_fe.sh **–helper node1😗*9010 **–**daemon

8

查看fe节点列表

SHOW PROC ‘/frontends’;

BE 扩容和缩容

用户可以通过 mysql 客户端登陆 Master FE。

BE 节点的扩容和缩容过程,不影响当前系统运行以及正在执行的任务,并且不会影响当前系统的性能。数据均衡会自动进行。根据集群现有数据量的大小,集群会在几个小时到1天不等的时间内,恢复到负载均衡的状态。集群负载情况,可以参见 Tablet 负载均衡文档。

- 增加 BE 节点

BE 节点的增加方式同 BE 部署 一节中的方式,通过 ALTER SYSTEM ADD BACKEND 命令增加 BE 节点。

BE 扩容注意事项:

-

BE 扩容后,Doris 会自动根据负载情况,进行数据均衡,期间不影响使用

-

删除 BE 节点

删除 BE 节点有两种方式:DROP 和 DECOMMISSION

DROP 语句如下:

ALTER SYSTEM DROP BACKEND “be_host:be_heartbeat_service_port”;

注意事项:

- DROP BACKEND 会直接删除该 BE,并且其上的数据将不能再恢复!!!所以我们强烈不推荐使用 DROP BACKEND 这种方式删除 BE 节点。当你使用这个语句时,会有对应的防误操作提示。

DECOMMISSION 语句如下:

ALTER SYSTEM DECOMMISSION BACKEND “be_host:be_heartbeat_service_port”;

DECOMMISSION 命令说明:

- 该命令用于安全删除 BE 节点。命令下发后,Doris 会尝试将该 BE 上的数据向其他 BE 节点迁移,当所有数据都迁移完成后,Doris 会自动删除该节点。

- 该命令是一个异步操作。执行后,可以通过 SHOW PROC ‘/backends’; 看到该 BE 节点的 isDecommission 状态为 true。表示该节点正在进行下线。

- 该命令不一定执行成功。比如剩余 BE 存储空间不足以容纳下线 BE 上的数据,或者剩余机器数量不满足最小副本数时,该命令都无法完成,并且 BE 会一直处于 isDecommission 为 true 的状态。

- DECOMMISSION 的进度,可以通过 SHOW PROC ‘/backends’; 中的 TabletNum 查看,如果正在进行,TabletNum 将不断减少。

- 该操作可以通过:

CANCEL DECOMMISSION BACKEND “be_host:be_heartbeat_service_port”;

命令取消。取消后,该 BE 上的数据将维持当前剩余的数据量。后续 Doris 重新进行负载均衡

Broker 扩容缩容

Broker 实例的数量没有硬性要求。通常每台物理机部署一个即可。Broker 的添加和删除可以通过以下命令完成:

ALTER SYSTEM ADD BROKER broker_name “broker_host:broker_ipc_port”;

ALTER SYSTEM DROP BROKER broker_name “broker_host:broker_ipc_port”;

ALTER SYSTEM DROP ALL BROKER broker_name**;**

Broker 是无状态的进程,可以随意启停。当然,停止后,正在其上运行的作业会失败,重试即可。

Doris实践篇

Doris 采用 MySQL 协议进行通信,用户可通过 MySQL client 或者 MySQL JDBC连接到 Doris 集群。选择 MySQL client 版本时建议采用5.1 之后的版本,因为 5.1 之前不能支持长度超过 16 个字符的用户名。

创建用户

- Root 用户登录与密码修改

Doris 内置 root 和 admin 用户,密码默认都为空。启动完 Doris 程序之后,可以通过 root 或 admin 用户连接到 Doris 集群。 使用下面命令即可登录 Doris:

mysql -h node1 -P9030 -uroot

登陆后,可以通过以下命令修改 root 密码

SET PASSWORD FOR ‘root’ = PASSWORD**(‘your_password’);**

- 创建新用户

通过下面的命令创建一个普通用户

CREATE USER ‘test’ IDENTIFIED BY ‘test_passwd’;

后续登录时就可以通过下列连接命令登录。

mysql -h node1 -P9030 -utest -ptest_passwd

注意:

- 新创建的普通用户默认没有任何权限。权限授予可以参考后面的权限授予。

创建数据库并赋予权限

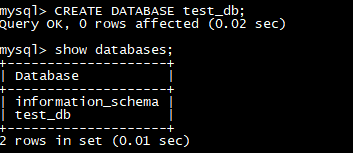

- 创建数据库

初始可以通过 root 或 admin 用户创建数据库:

CREATE DATABASE test_db**;**

注意:

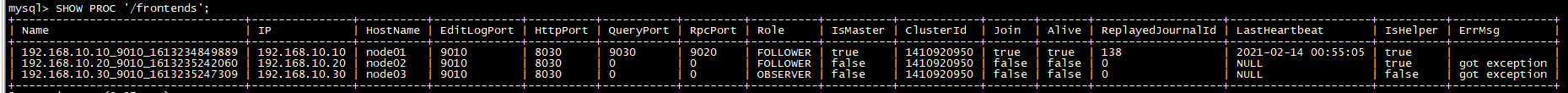

- 所有命令都可以使用 ‘HELP command;’ 查看到详细的语法帮助。如:HELP CREATE DATABASE;

- 如果不清楚命令的全名,可以使用 “help 命令某一字段” 进行模糊查询。如键入 ‘HELP CREATE’,可以匹配到 CREATE DATABASE, CREATE TABLE, CREATE USER 等命令。

数据库创建完成之后,可以通过 SHOW DATABASES; 查看数据库信息。

show databases;

information_schema是为了兼容MySQL协议而存在,实际中信息可能不是很准确,所以关于具体数据库的信息建议通过直接查询相应数据库而获得。

- 权限赋予

test_db 创建完成之后,可以通过 root/admin 账户将 test_db 读写权限授权给普通账户,如 test。授权之后采用 test 账户登录就可以操作 test_db 数据库了。

GRANT ALL ON test_db TO test**;**

[Doris 建表、数据导入与删除](http://www.mianshigee.com/tutorial/Doris/4.md#Doris %E5%BB%BA%E8%A1%A8%E3%80%81%E6%95%B0%E6%8D%AE%E5%AF%BC%E5%85%A5%E4%B8%8E%E5%88%A0%E9%99%A4)

可以通过在 mysql-client 中执行以下 help 命令获得更多帮助:

- help create table

- help load

- help mini load

- help delete

- help alter table

基本概念

在 Doris 中,数据都以**表(Table)**的形式进行逻辑上的描述。

Row & Column

一张表包括行(Row)和列(Column)。Row 即用户的一行数据。Column 用于描述一行数据中不同的字段。

Column 可以分为两大类:Key 和 Value。从业务角度看,Key 和 Value 可以分别对应维度列和指标列。从聚合模型的角度来说,Key 列相同的行,会聚合成一行。其中 Value 列的聚合方式由用户在建表时指定。关于更多聚合模型的介绍,可以参阅 Doris 数据模型

Tablet & Partition

在 Doris 的存储引擎中,用户数据被水平划分为若干个数据分片(Tablet,也称作数据分桶)。每个 Tablet 包含若干数据行。各个 Tablet 之间的数据没有交集,并且在物理上是独立存储的。

多个 Tablet 在逻辑上归属于不同的分区(Partition)。一个 Tablet 只属于一个 Partition。而一个 Partition 包含若干个 Tablet。因为 Tablet 在物理上是独立存储的,所以可以视为 Partition 在物理上也是独立。Tablet 是数据移动、复制等操作的最小物理存储单元。

若干个 Partition 组成一个 Table。Partition 可以视为是逻辑上最小的管理单元。数据的导入与删除,都可以或仅能针对一个 Partition 进行。

建表(Create Table)

使用 CREATE TABLE 命令建立一个表(Table)。更多详细参数可以查看:

HELP CREATE TABLE;

首先切换数据库:

USE test_db**;**

Doris 的建表是一个同步命令,命令返回成功,即表示建表成功。

可以通过 HELP CREATE TABLE; 查看更多帮助。

CREATE TABLE IF NOT EXISTS test_db**.table0**

(

`user_id` LARGEINT NOT NULL COMMENT “用户id”,

`date` DATE NOT NULL COMMENT “数据灌入日期时间”,

`timestamp` DATETIME NOT NULL COMMENT “数据灌入的时间戳”,

`city` VARCHAR(20) COMMENT “用户所在城市”,

`age` SMALLINT COMMENT “用户年龄”,

`sex` TINYINT COMMENT “用户性别”,

`last_visit_date` DATETIME REPLACE DEFAULT “1970-01-01 00:00:00” COMMENT “用户最后一次访问时间”,

`cost` BIGINT SUM DEFAULT “0” COMMENT “用户总消费”,

`max_dwell_time` INT MAX DEFAULT “0” COMMENT “用户最大停留时间”,

`min_dwell_time` INT MIN DEFAULT “99999” COMMENT “用户最小停留时间”

)

ENGINE**=**olap

AGGREGATE KEY(`user_id`, `date`, `timestamp`, `city`, `age`, `sex`)

PARTITION BY RANGE(`date`)

(

PARTITION `p202001` VALUES LESS THAN (“2020-02-01”),

PARTITION `p202002` VALUES LESS THAN (“2020-03-01”),

PARTITION `p202003` VALUES LESS THAN (“2020-04-01”)

)

DISTRIBUTED BY HASH**(`user_id`)** BUCKETS 16

PROPERTIES

(

“replication_num” = “3”,

“storage_medium” = “SSD”,

“storage_cooldown_time” = “2021-05-01 12:00:00”

);

字段类型

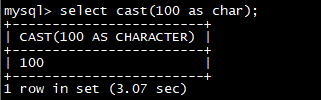

- TINYINT数据类型

长度: 长度为1个字节的有符号整型。

范围: [-128, 127]

转换: Doris可以自动将该类型转换成更大的整型或者浮点类型。使用CAST()函数可以将其转换成CHAR。

举例:

select **cast(**100 as char);

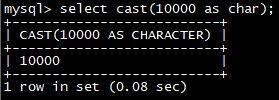

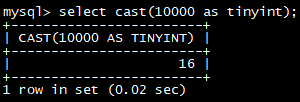

- SMALLINT数据类型

长度: 长度为2个字节的有符号整型。

范围: [-32768, 32767]

转换: Doris可以自动将该类型转换成更大的整型或者浮点类型。使用CAST()函数可以将其转换成TINYINT,CHAR。

举例:

select **cast(**10000 as char);

select **cast(**10000 as tinyint);

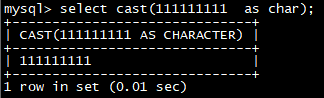

- INT数据类型

长度: 长度为4个字节的有符号整型。

范围: [-2147483648, 2147483647]

转换: Doris可以自动将该类型转换成更大的整型或者浮点类型。使用CAST()函数可以将其转换成TINYINT,SMALLINT,CHAR

举例:

select **cast(**111111111 as char);

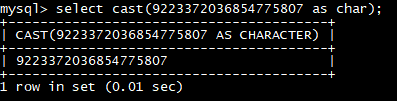

- BIGINT数据类型

长度: 长度为8个字节的有符号整型。

范围: [-9223372036854775808, 9223372036854775807]

转换: Doris可以自动将该类型转换成更大的整型或者浮点类型。使用CAST()函数可以将其转换成TINYINT,SMALLINT,INT,CHAR

举例:

select **cast(**9223372036854775807 as char);

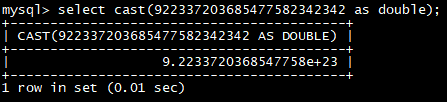

- LARGEINT数据类型

长度: 长度为16个字节的有符号整型。

范围: [-2^127, 2^127-1]

转换: Doris可以自动将该类型转换成浮点类型。使用CAST()函数可以将其转换成TINYINT,SMALLINT,INT,BIGINT,CHAR

举例:

select **cast(**922337203685477582342342 as double);

- FLOAT数据类型

长度: 长度为4字节的浮点类型。

范围: -3.40E+38 ~ +3.40E+38。

转换: Doris会自动将FLOAT类型转换成DOUBLE类型。用户可以使用CAST()将其转换成TINYINT, SMALLINT, INT, BIGINT, STRING, TIMESTAMP。

- DOUBLE数据类型

长度: 长度为8字节的浮点类型。

范围: -1.79E+308 ~ +1.79E+308。

转换: Doris不会自动将DOUBLE类型转换成其他类型。用户可以使用CAST()将其转换成TINYINT, SMALLINT, INT, BIGINT, STRING, TIMESTAMP。用户可以使用指数符号来描述DOUBLE 类型,或通过STRING转换获得。

- DECIMAL数据类型

DECIMAL[M, D]

保证精度的小数类型。M代表一共有多少个有效数字,D代表小数点后最多有多少数字。M的范围是[1,27],D的范围是[1,9],另外,M必须要大于等于D的取值。默认取值为decimal[10,0]。

precision: 1 ~ 27

scale: 0 ~ 9

- DATE数据类型

范围: [0000-01-01~9999-12-31]。默认的打印形式是’YYYY-MM-DD’。

- DATETIME数据类型

范围: [0000-01-01 00:00:00~9999-12-31 23:59:59]。默认的打印形式是’YYYY-MM-DD HH:MM:SS’。

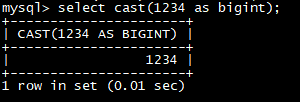

- CHAR数据类型

范围: char[(length)],定长字符串,长度length范围1~255,默认为1。

转换:用户可以通过CAST函数将CHAR类型转换成TINYINT,,SMALLINT,INT,BIGINT,LARGEINT,DOUBLE,DATE或者DATETIME类型。

示例:

select **cast(**1234 as bigint);

- VARCHAR数据类型

范围: char(length),变长字符串,长度length范围1~65535。

转换:用户可以通过CAST函数将CHAR类型转换成TINYINT,,SMALLINT,INT,BIGINT,LARGEINT,DOUBLE,DATE或者DATETIME类型。

示例:

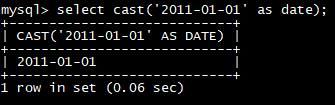

select cast(‘2011-01-01’ as date);

select cast(‘2011-01-01’ as datetime);

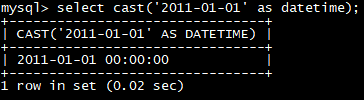

select **cast(**3423 as bigint);

- HLL数据类型

范围:char(length),长度length范围1~16385。用户不需要指定长度和默认值、长度根据数据的聚合程度系统内控制,并且HLL列只能通过配套的hll_union_agg、hll_cardinality、hll_hash进行查询或使用

数据划分

Doris支持单分区和复合分区两种建表方式。

在复合分区中:

- 第一级称为 Partition,即分区。用户可以指定某一维度列作为分区列(当前只支持整型和时间类型的列),并指定每个分区的取值范围。

- 第二级称为 Distribution,即分桶。用户可以指定一个或多个维度列以及桶数对数据进行 HASH 分布。

以下场景推荐使用复合分区

- 有时间维度或类似带有有序值的维度,可以以这类维度列作为分区列。分区粒度可以根据导入频次、分区数据量等进行评估。

- 历史数据删除需求:如有删除历史数据的需求(比如仅保留最近N 天的数据)。使用复合分区,可以通过删除历史分区来达到目的。也可以通过在指定分区内发送 DELETE 语句进行数据删除。

- 解决数据倾斜问题:每个分区可以单独指定分桶数量。如按天分区,当每天的数据量差异很大时,可以通过指定分区的分桶数,合理划分不同分区的数据,分桶列建议选择区分度大的列。

用户也可以不使用复合分区,即使用单分区。则数据只做 HASH 分布。

下面以聚合模型为例,分别演示两种分区的建表语句。

- Partition

- Bucket

- PROPERTIES

- ENGINE

关于 Partition 和 Bucket 的数量和数据量的建议

- 一个表的 Tablet 总数量等于 (Partition num * Bucket num)。

- 一个表的 Tablet 数量,在不考虑扩容的情况下,推荐略多于整个集群的磁盘数量。

- 单个 Tablet 的数据量理论上没有上下界,但建议在 1G - 10G 的范围内。如果单个 Tablet 数据量过小,则数据的聚合效果不佳,且元数据管理压力大。如果数据量过大,则不利于副本的迁移、补齐,且会增加 Schema Change 或者 Rollup 操作失败重试的代价(这些操作失败重试的粒度是 Tablet)。

- 当 Tablet 的数据量原则和数量原则冲突时,建议优先考虑数据量原则。

- 在建表时,每个分区的 Bucket 数量统一指定。但是在动态增加分区时(ADD PARTITION),可以单独指定新分区的 Bucket 数量。可以利用这个功能方便的应对数据缩小或膨胀。

- 一个 Partition 的 Bucket 数量一旦指定,不可更改。所以在确定 Bucket 数量时,需要预先考虑集群扩容的情况。比如当前只有 3 台 host,每台 host 有 1 块盘。如果 Bucket 的数量只设置为 3 或更小,那么后期即使再增加机器,也不能提高并发度。

- 举一些例子:假设在有10台BE,每台BE一块磁盘的情况下。如果一个表总大小为 500MB,则可以考虑4-8个分片。5GB:8-16个。50GB:32个。500GB:建议分区,每个分区大小在 50GB 左右,每个分区16-32个分片。5TB:建议分区,每个分区大小在 50GB 左右,每个分区16-32个分片。

注:表的数据量可以通过 show data 命令查看,结果除以副本数,即表的数据量。

演示单分区和复合分区

单分区

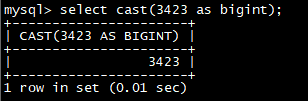

建立一个名字为 table1 的逻辑表。分桶列为 siteid,桶数为 10。

这个表的 schema 如下:

- siteid:类型是INT(4字节), 默认值为10

- citycode:类型是SMALLINT(2字节)

- username:类型是VARCHAR, 最大长度为32, 默认值为空字符串

- pv:类型是BIGINT(8字节), 默认值是0; 这是一个指标列, Doris内部会对指标列做聚合操作, 这个列的聚合方法是求和(SUM)

建表语句如下:

CREATE TABLE table1

(

siteid INT DEFAULT ‘10’,

citycode SMALLINT,

username VARCHAR(32) DEFAULT ‘’,

pv BIGINT SUM DEFAULT ‘0’

)

AGGREGATE KEY(siteid, citycode**,** username**)**

DISTRIBUTED BY HASH**(siteid)** BUCKETS 10

PROPERTIES**(“replication_num” = “1”);**

将 table1_data 导入 table1 中:vim table1_data

10,101,jim,2

11,101,grace,2

12,102,tom,2

13,102,bush,3

14,103,helen,3

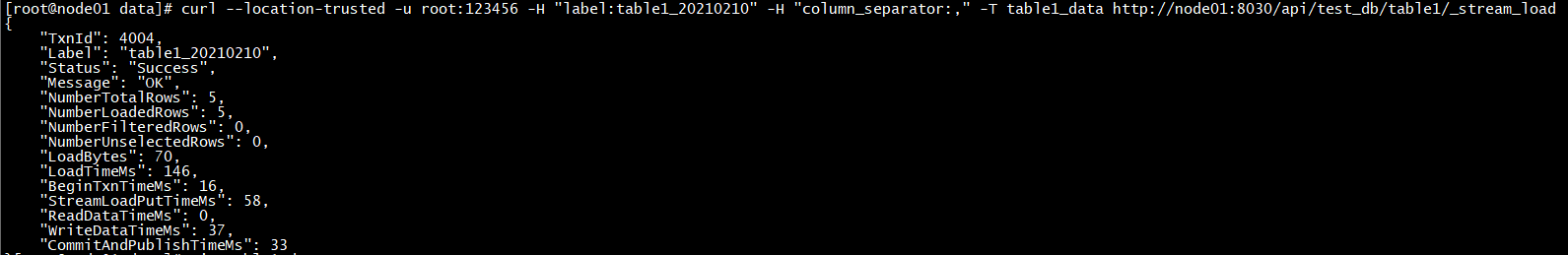

curl --location-trusted -u root:123456 -H “label:table1_20210210” -H “column_separator:,” -T table1_data http://node1:8030/api/test_db/table1/_stream_load

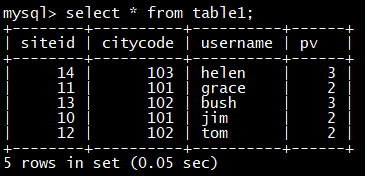

select * from table1**;**

复合分区

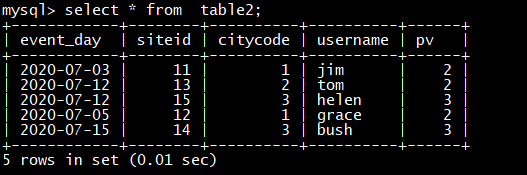

建立一个名字为 table2 的逻辑表。

这个表的 schema 如下:

- event_day:类型是DATE,无默认值

- siteid:类型是INT(4字节), 默认值为10

- citycode:类型是SMALLINT(2字节)

- username:类型是VARCHAR, 最大长度为32, 默认值为空字符串

- pv:类型是BIGINT(8字节), 默认值是0; 这是一个指标列, Doris 内部会对指标列做聚合操作, 这个列的聚合方法是求和(SUM)

我们使用 event_day 列作为分区列,建立3个分区: p202006, p202007, p202008

-

p202006:范围为 [最小值, 2020-07-01)

-

p202007:范围为 [2020-07-01, 2020-08-01)

-

p202008:范围为 [2020-08-01, 2020-09-01)

-

注意区间为左闭右开。

每个分区使用 siteid 进行哈希分桶,桶数为10

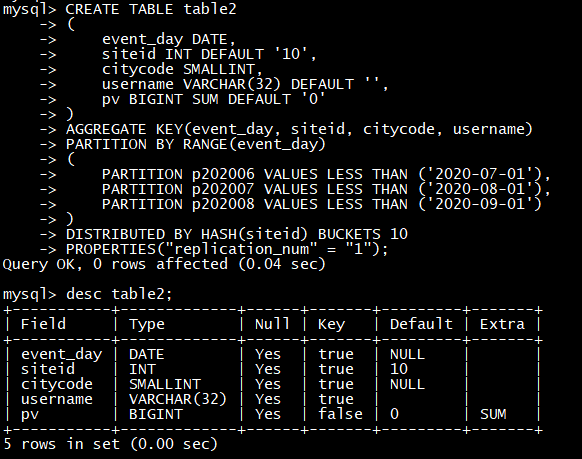

建表语句如下:

CREATE TABLE table2

(

event_day DATE,

siteid INT DEFAULT ‘10’,

citycode SMALLINT,

username VARCHAR(32) DEFAULT ‘’,

pv BIGINT SUM DEFAULT ‘0’

)

AGGREGATE KEY(event_day, siteid**,** citycode**,** username**)**

PARTITION BY RANGE(event_day)

(

PARTITION p202006 VALUES LESS THAN (‘2020-07-01’),

PARTITION p202007 VALUES LESS THAN (‘2020-08-01’),

PARTITION p202008 VALUES LESS THAN (‘2020-09-01’)

)

DISTRIBUTED BY HASH**(siteid)** BUCKETS 10

PROPERTIES**(“replication_num” = “1”);**

将 table2_data 导入 table2 中:vim table2_data

2020-07-03|11|1|jim|2

2020-07-05|12|1|grace|2

2020-07-12|13|2|tom|2

2020-07-15|14|3|bush|3

2020-07-12|15|3|helen|3

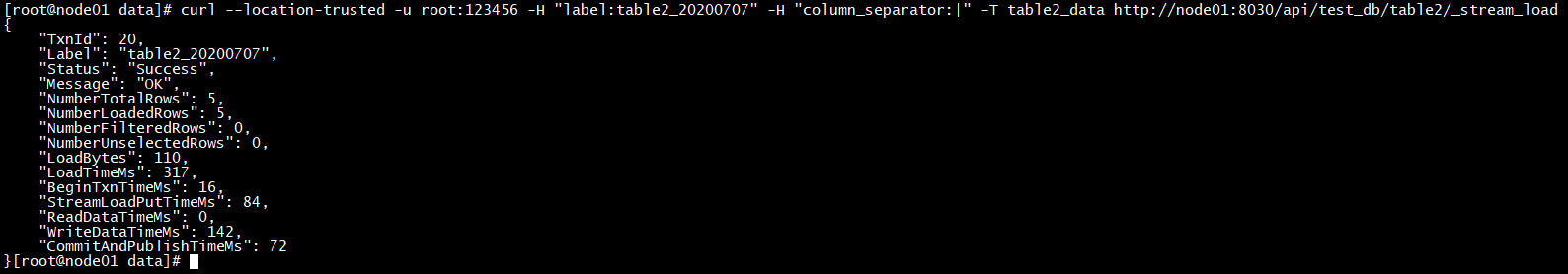

curl --location-trusted -u root:123456 -H “label:table2_20200707” -H “column_separator:|” -T table2_data http://node1:8030/api/test_db/table2/_stream_load

select * from table2**;**

注意事项:

- 上述表通过设置 replication_num 建的都是单副本的表,Doris建议用户采用默认的 3 副本设置,以保证高可用。

- 可以对复合分区表动态的增删分区。详见 HELP ALTER TABLE 中 Partition 相关部分。

- 数据导入可以导入指定的 Partition。详见 HELP LOAD。

- 可以动态修改表的 Schema。

- 可以对 Table 增加上卷表(Rollup)以提高查询性能,这部分可以参见高级使用指南关于 Rollup 的描述。

- 表的列的Null属性默认为true,会对查询性能有一定的影响。

数据导入(Load)

为适配不同的数据导入需求,Doris系统提供了五种不同的数据导入方式,每种数据导入方式支持不同的数据源,存在不同的方式(异步,同步)

- Broker load

通过Broker进程访问并读取外部数据源(HDFS)导入Doris,用户通过Mysql提交导入作业,异步执行,通过show load命令查看导入结果

- Stream load

用户通过HTTP协议提交请求并携带原始数据创建导入,主要用于快速将本地文件或者数据流中的数据导入到Doris,导入命令同步返回结果

- Insert

类似Mysql中的insert语句,Doris提供insert into table select …的方式从Doris的表中读取数据并导入到另一张表中,或者通过insert into table values(…)的方式插入单条数据

- Multi load

用户可以通过HTTP协议提交多个导入作业,Multi load可以保证多个导入作业的原子生效

- Routine load

用户通过Mysql协议提交例行导入作业,生成一个常驻线程,不间断的从数据源(如Kafka)中读取数据并导入到Doris中

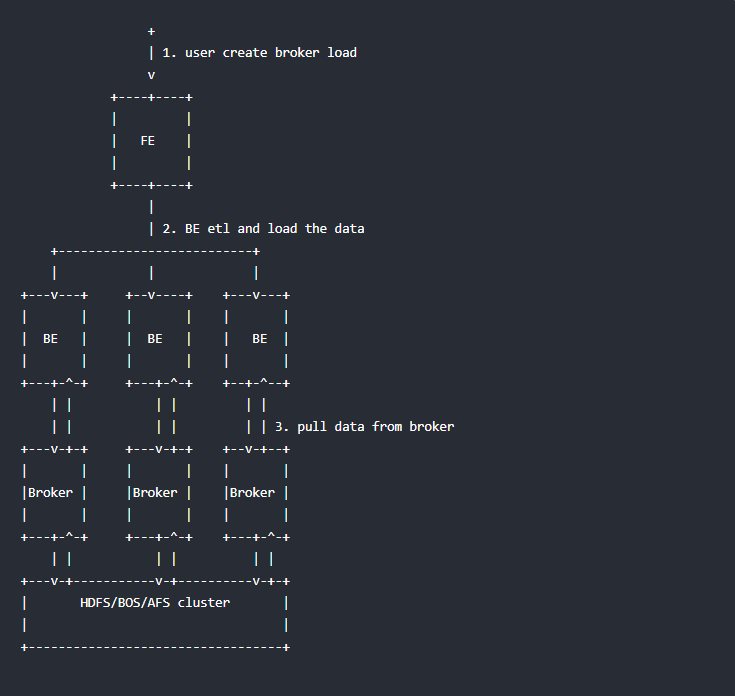

Broker Load

Broker load是一个导入的异步方式,不同的数据源需要部署不同的 broker 进程。可以通过 show broker 命令查看已经部署的 broker。

适用场景

- 源数据在Broker可以访问的存储系统中,如HDFS

- 数据量在几十到几百GB级别

基本原理

用户在递交导入任务后,FE(Doris系统的元数据和调度节点)会生成相应的PLAN(导入执行计划,BE会导入计划将输入导入Doris中)并根据BE(Doris系统的计算和存储节点)的个数和文件的大小,将PLAN分给多个BE执行,每个BE导入一部分数据。BE在执行过程中会从Broker拉取数据,在对数据转换之后导入系统,所有BE均完成导入,由FE最终决定导入是否成功

前置操作

- 启动zookeeper集群(三台节点都启动):zkServer.sh start

- 启动hdfs集群:start-dfs.sh

语法

LOAD LABEL load_label

(

data_desc1**[,** data_desc2**,** …]

)

WITH BROKER broker_name

[broker_properties]

[opt_properties];

load_label

当前导入批次的标签,在一个 database 内唯一。

语法:

[database_name.]your_label

data_desc

用于描述一批导入数据。

语法:

DATA INFILE

(

“file_path1”[, file_path2**,** …]

)

[NEGATIVE]

INTO TABLE `table_name`

[PARTITION (p1, p2**)]**

[COLUMNS TERMINATED BY “column_separator”]

[(column_list)]

[SET (k1 = func(k2))]

**file_path:**文件路径,可以指定到一个文件,也可以用 * 通配符指定某个目录下的所有文件。通配符必须匹配到文件,而不能是目录。

**PARTITION:**如果指定此参数,则只会导入指定的分区,导入分区以外的数据会被过滤掉。如果不指定,默认导入table的所有分区。

**NEGATIVE:**如果指定此参数,则相当于导入一批“负”数据。用于抵消之前导入的同一批数据。该参数仅适用于存在 value 列,并且 value 列的聚合类型仅为 SUM 的情况。

**column_separator:**用于指定导入文件中的列分隔符。默认为 \t如果是不可见字符,则需要加\\x作为前缀,使用十六进制来表示分隔符。如hive文件的分隔符\x01,指定为"\\x01"

**column_list:**用于指定导入文件中的列和 table 中的列的对应关系。当需要跳过导入文件中的某一列时,将该列指定为 table 中不存在的列名即可。

语法:(col_name1, col_name2, …)

**SET:**如果指定此参数,可以将源文件某一列按照函数进行转化,然后将转化后的结果导入到table中。

目前支持的函数有:

- strftime(fmt, column) 日期转换函数

- fmt: 日期格式,形如%Y%m%d%H%M%S (年月日时分秒)

- column: column_list中的列,即输入文件中的列。存储内容应为数字型的时间戳。

- 如果没有column_list,则按照palo表的列顺序默认输入文件的列。

- time_format(output_fmt, input_fmt, column) 日期格式转化

- output_fmt: 转化后的日期格式,形如%Y%m%d%H%M%S (年月日时分秒)

- input_fmt: 转化前column列的日期格式,形如%Y%m%d%H%M%S (年月日时分秒)

- column: column_list中的列,即输入文件中的列。存储内容应为input_fmt格式的日期字符串。

- 如果没有column_list,则按照palo表的列顺序默认输入文件的列。

- alignment_timestamp(precision, column) 将时间戳对齐到指定精度

- precision: year|month|day|hour

- column: column_list中的列,即输入文件中的列。存储内容应为数字型的时间戳。

- 如果没有column_list,则按照palo表的列顺序默认输入文件的列。

- 注意:对齐精度为year、month的时候,只支持20050101~20191231范围内的时间戳。

- default_value(value) 设置某一列导入的默认值

- 不指定则使用建表时列的默认值

- md5sum(column1, column2, …) 将指定的导入列的值求md5sum,返回32位16进制字符串

- replace_value(old_value[, new_value]) 将导入文件中指定的old_value替换为new_value

- new_value如不指定则使用建表时列的默认值

- hll_hash(column) 用于将表或数据里面的某一列转化成HLL列的数据结构

- now() 设置某一列导入的数据为导入执行的时间点。该列必须为 DATE/DATETIME 类型

broker_name

所使用的 broker 名称,可以通过 show broker 命令查看。不同的数据源需使用对应的 broker。

broker_properties

用于提供通过 broker 访问数据源的信息。不同的 broker,以及不同的访问方式,需要提供的信息不同。

Apache HDFS:

社区版本的 hdfs,支持简单认证、kerberos 认证。以及支持 HA 配置。

- 简单认证:

- hadoop.security.authentication = simple (默认)

- username:hdfs 用户名

- password:hdfs 密码

- kerberos 认证:

- hadoop.security.authentication = kerberos

- kerberos_principal:指定 kerberos 的 principal

- kerberos_keytab:指定 kerberos 的 keytab 文件路径。该文件必须为 broker 进程所在服务器上的文件。

- kerberos_keytab_content:指定 kerberos 中 keytab 文件内容经过 base64 编码之后的内容。这个跟 kerberos_keytab 配置二选一就可以。

- namenode HA:

通过配置 namenode HA,可以在 namenode 切换时,自动识别到新的 namenode- dfs.nameservices: 指定 hdfs 服务的名字,自定义,如:“dfs.nameservices” = “my_ha”

- dfs.ha.namenodes.xxx:自定义 namenode 的名字,多个名字以逗号分隔。其中 xxx 为 dfs.nameservices 中自定义的名字,如 “dfs.ha.namenodes.my_ha” = “my_nn”

- dfs.namenode.rpc-address.xxx.nn:指定 namenode 的rpc地址信息。其中 nn 表示 dfs.ha.namenodes.xxx 中配置的 namenode 的名字,如:“dfs.namenode.rpc-address.my_ha.my_nn” = “host:port”

- dfs.client.failover.proxy.provider:指定 client 连接 namenode 的 provider,默认为:org.apache.hadoop.hdfs.server.namenode.ha.ConfiguredFailoverProxyProvider

opt_properties

用于指定一些特殊参数。

语法:

[PROPERTIES (“key”=“value”, …)]

可以指定如下参数:

- timeout:指定导入操作的超时时间。默认超时为4小时。单位秒。

- max_filter_ratio:最大容忍可过滤(数据不规范等原因)的数据比例。默认零容忍。

- exec_mem_limit:设置导入使用的内存上限。默认为2G,单位字节。这里是指单个 BE 节点的内存上限。一个导入可能分布于多个BE。我们假设 1GB 数据在单个节点处理需要最大5GB内存。那么假设1GB文件分布在2个节点处理,那么理论上每个节点需要内存为2.5GB。则该参数可以设置为 2684354560,即2.5GB

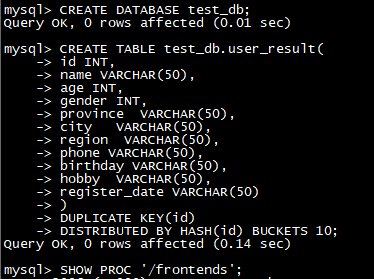

数据导入演示

操作步骤

说明

1

启动zookeeper集群(三台节点都启动)

zkServer.sh start

2

启动hdfs集群

start-dfs.sh

3

进入mysqlclient,创建表

CREATE TABLE test_db**.user_result(**

id INT,

name VARCHAR(50),

age INT,

gender INT,

province VARCHAR(50),

city VARCHAR(50),

region VARCHAR(50),

phone VARCHAR(50),

birthday VARCHAR(50),

hobby VARCHAR(50),

register_date VARCHAR(50)

)

DUPLICATE KEY(id)

DISTRIBUTED BY HASH**(id)** BUCKETS 10**;**

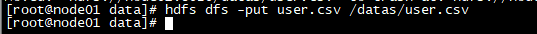

4

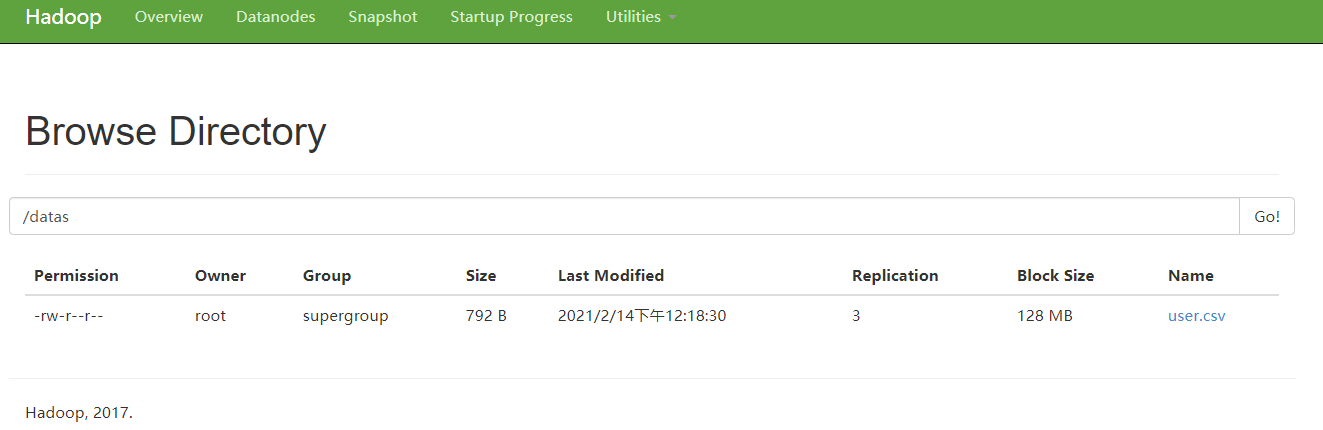

上传数据,将“资料\测试数据\user.csv”上传到hdfs

5

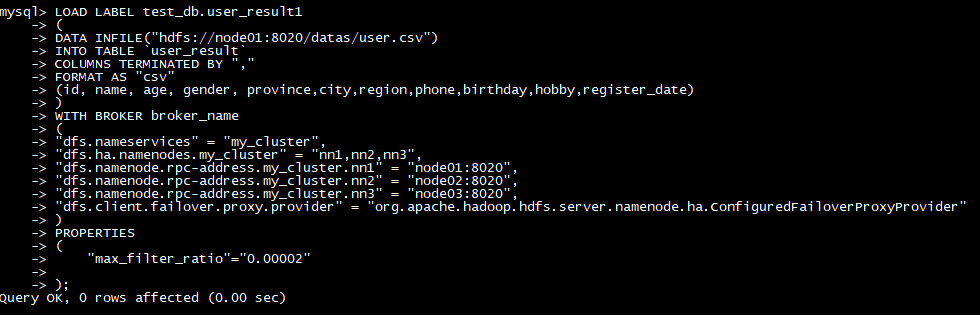

导入数据

LOAD LABEL test_db**.**user_result

(

DATA INFILE**(“hdfs://node1:8020/datas/user.csv”)**

INTO TABLE `user_result`

COLUMNS TERMINATED BY “,”

FORMAT AS “csv”

(id, name**,** age**,** gender**,** province**,city,region,phone,birthday,hobby,register_date)**

)

WITH BROKER broker_name

(

“dfs.nameservices” = “my_cluster”,

“dfs.ha.namenodes.my_cluster” = “nn1,nn2,nn3”,

“dfs.namenode.rpc-address.my_cluster.nn1” = “node1:8020”,

“dfs.namenode.rpc-address.my_cluster.nn2” = “node2:8020”,

“dfs.namenode.rpc-address.my_cluster.nn3” = “node3:8020”,

“dfs.client.failover.proxy.provider” = “org.apache.hadoop.hdfs.server.namenode.ha.ConfiguredFailoverProxyProvider”

)

PROPERTIES

(

“max_filter_ratio”=“0.00002”

);

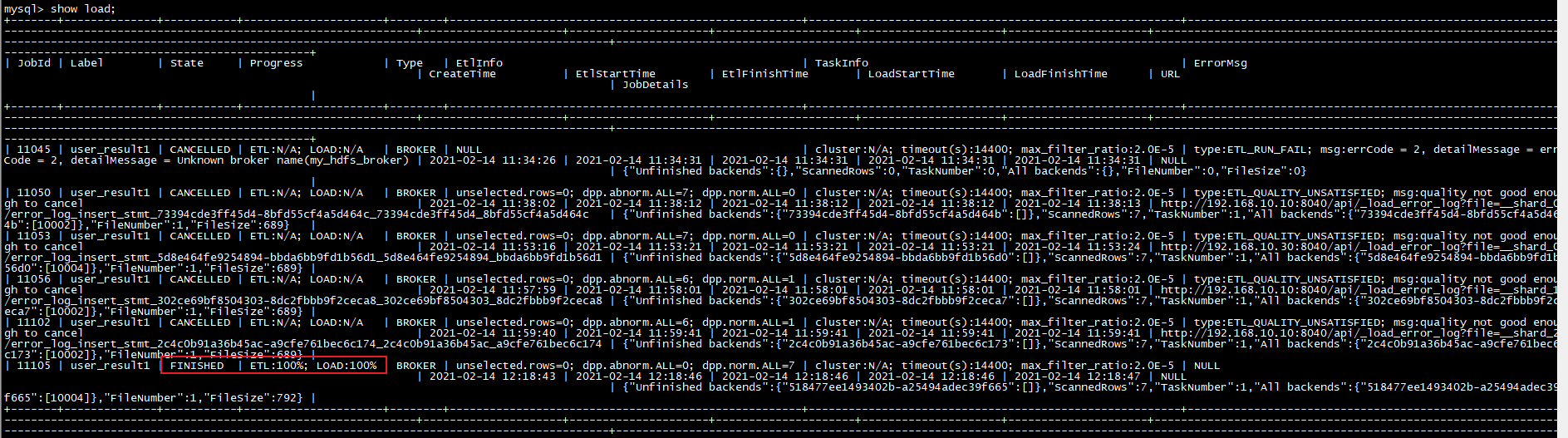

6

查看load作业

7

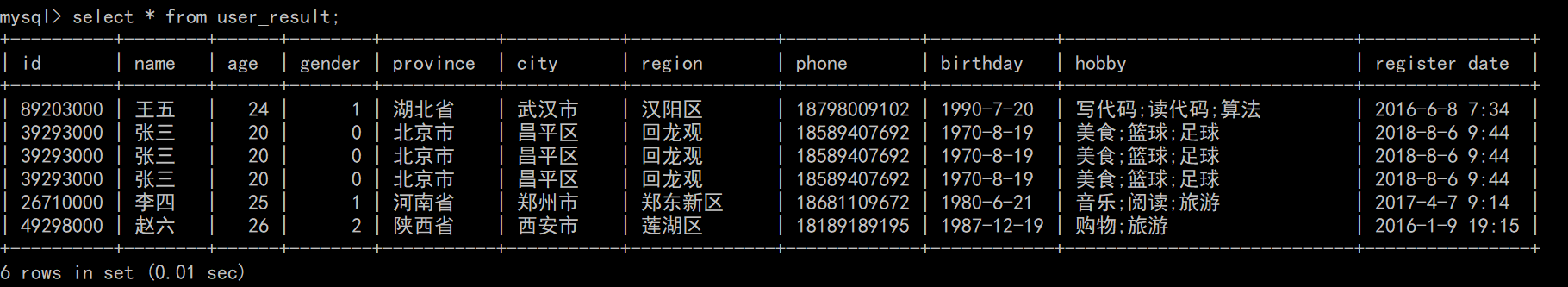

查询表数据

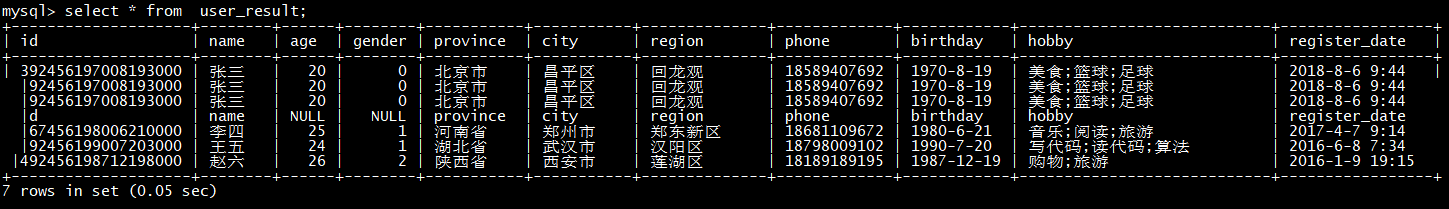

select * from user_result;

查看导入

Broker load 导入方式由于是异步的,所以用户必须将创建导入的 Label 记录,并且在查看导入命令中使用 Label 来查看导入结果。查看导入命令在所有导入方式中是通用的,具体语法可执行 HELP SHOW LOAD 查看。

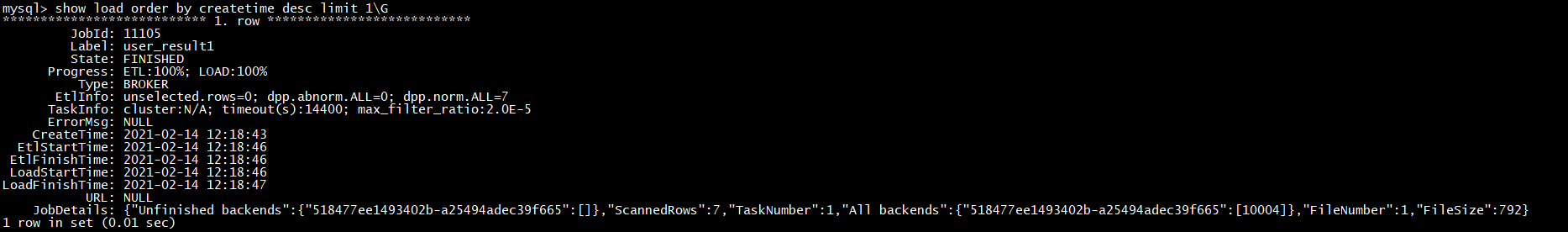

show load order by createtime desc limit 1\G

JobId

导入任务的唯一ID,每个导入任务的 JobId 都不同,由系统自动生成。与 Label 不同的是,JobId永远不会相同,而 Label 则可以在导入任务失败后被复用。

Label

导入任务的标识。

State

导入任务当前所处的阶段。在 Broker load 导入过程中主要会出现 PENDING 和 LOADING 这两个导入中的状态。如果 Broker load 处于 PENDING 状态,则说明当前导入任务正在等待被执行;LOADING 状态则表示正在执行中。

导入任务的最终阶段有两个:CANCELLED 和 FINISHED,当 Load job 处于这两个阶段时,导入完成。其中 CANCELLED 为导入失败,FINISHED 为导入成功。

Progress

导入任务的进度描述。分为两种进度:ETL 和 LOAD,对应了导入流程的两个阶段 ETL 和 LOADING。目前 Broker load 由于只有 LOADING 阶段,所以 ETL 则会永远显示为 N/A

LOAD 的进度范围为:0~100%。

LOAD 进度 = 当前完成导入的表个数 / 本次导入任务设计的总表个数 * 100%

如果所有导入表均完成导入,此时 LOAD 的进度为 99% 导入进入到最后生效阶段,整个导入完成后,LOAD 的进度才会改为 100%。

导入进度并不是线性的。所以如果一段时间内进度没有变化,并不代表导入没有在执行。

Type

导入任务的类型。Broker load 的 type 取值只有 BROKER。

EtlInfo

主要显示了导入的数据量指标 unselected.rows , dpp.norm.ALL 和 dpp.abnorm.ALL。用户可以根据第一个数值判断 where 条件过滤了多少行,后两个指标验证当前导入任务的错误率是否超过 max_filter_ratio。

三个指标之和就是原始数据量的总行数。

TaskInfo

主要显示了当前导入任务参数,也就是创建 Broker load 导入任务时用户指定的导入任务参数,包括:cluster,timeout 和max_filter_ratio。

ErrorMsg

在导入任务状态为CANCELLED,会显示失败的原因,显示分两部分:type 和 msg,如果导入任务成功则显示 N/A。

type的取值意义:

USER_CANCEL: 用户取消的任务

ETL_RUN_FAIL:在ETL阶段失败的导入任务

ETL_QUALITY_UNSATISFIED:数据质量不合格,也就是错误数据率超过了 max_filter_ratio

LOAD_RUN_FAIL:在LOADING阶段失败的导入任务

TIMEOUT:导入任务没在超时时间内完成

UNKNOWN:未知的导入错误

CreateTime/EtlStartTime/EtlFinishTime/LoadStartTime/LoadFinishTime

这几个值分别代表导入创建的时间,ETL阶段开始的时间,ETL阶段完成的时间,Loading阶段开始的时间和整个导入任务完成的时间。

Broker load 导入由于没有 ETL 阶段,所以其 EtlStartTime, EtlFinishTime, LoadStartTime 被设置为同一个值。

导入任务长时间停留在 CreateTime,而 LoadStartTime 为 N/A 则说明目前导入任务堆积严重。用户可减少导入提交的频率。

LoadFinishTime - CreateTime = 整个导入任务所消耗时间

LoadFinishTime - LoadStartTime = 整个 Broker load 导入任务执行时间 = 整个导入任务所消耗时间 - 导入任务等待的时间

URL

导入任务的错误数据样例,访问 URL 地址既可获取本次导入的错误数据样例。当本次导入不存在错误数据时,URL 字段则为 N/A。

JobDetails

显示一些作业的详细运行状态。包括导入文件的个数、总大小(字节)、子任务个数、已处理的原始行数,运行子任务的 BE 节点 Id,未完成的 BE 节点 Id。

{“Unfinished backends”:{“9c3441027ff948a0-8287923329a2b6a7”:[10002]},“ScannedRows”:2390016,“TaskNumber”:1,“All backends”:{“9c3441027ff948a0-8287923329a2b6a7”:[10002]},“FileNumber”:1,“FileSize”:1073741824}

其中已处理的原始行数,每 5 秒更新一次。该行数仅用于展示当前的进度,不代表最终实际的处理行数。实际处理行数以 EtlInfo 中显示的为准。

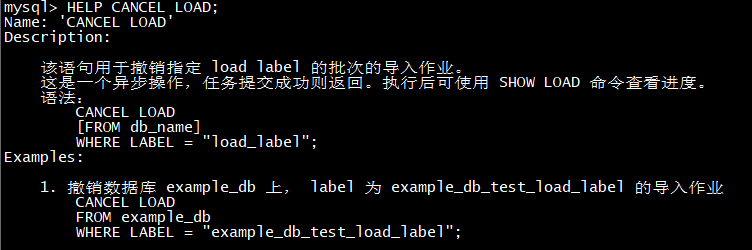

取消导入

当 Broker load 作业状态不为 CANCELLED 或 FINISHED 时,可以被用户手动取消。取消时需要指定待取消导入任务的 Label 。取消导入命令语法可执行 HELP CANCEL LOAD查看。

其他导入案例参考

- 从 HDFS 导入一批数据,数据格式为CSV,同时使用 kerberos 认证方式,同时配置 namenode HA

设置最大容忍可过滤(数据不规范等原因)的数据比例。

LOAD LABEL test_db**.**user_result2

(

DATA INFILE**(“hdfs://node1:8020/datas/user.csv”)**

INTO TABLE `user_result`

COLUMNS TERMINATED BY “,”

FORMAT AS “csv”

(id, name**,** age**,** gender**,** province**,city,region,phone,birthday,hobby,register_date)**

)

WITH BROKER broker_name

(

“hadoop.security.authentication”=“kerberos”,

“kerberos_principal”=“doris@YOUR.COM”,

“kerberos_keytab_content”=“BQIAAABEAAEACUJBSURVLkNPTQAEcGFsbw”,

“dfs.nameservices” = “my_ha”,

“dfs.ha.namenodes.my_ha” = “my_namenode1, my_namenode2”,

“dfs.namenode.rpc-address.my_ha.my_namenode1” = “node1:8020”,

“dfs.namenode.rpc-address.my_ha.my_namenode2” = “node2:8020”,

“dfs.client.failover.proxy.provider” = “org.apache.hadoop.hdfs.server.namenode.ha.ConfiguredFailoverProxyProvider”

)

PROPERTIES

(

“max_filter_ratio”=“0.00002”

);

- 从 HDFS 导入一批数据,指定超时时间和过滤比例。使用铭文 my_hdfs_broker 的 broker。简单认证。

LOAD LABEL test_db**.**user_result3

(

DATA INFILE**(“hdfs://node1:8020/datas/user.csv”)**

INTO TABLE `user_result`

)

WITH BROKER broker_name

(

“username” = “hdfs_user”,

“password” = “hdfs_passwd”

)

PROPERTIES

(

“timeout” = “3600”,

“max_filter_ratio” = “0.1”

);

其中 hdfs_host 为 namenode 的 host,hdfs_port 为 fs.defaultFS 端口(默认9000)

- 从 HDFS 导入一批数据,指定hive的默认分隔符\x01,并使用通配符*指定目录下的所有文件

使用简单认证,同时配置 namenode HA。

LOAD LABEL test_db**.**user_result4

(

DATA INFILE**(“hdfs://node1:8020/datas/input/*”)**

INTO TABLE `user_result`

COLUMNS TERMINATED BY “\\x01”

)

WITH BROKER broker_name

(

“username” = “hdfs_user”,

“password” = “hdfs_passwd”,

“dfs.nameservices” = “my_ha”,

“dfs.ha.namenodes.my_ha” = “my_namenode1, my_namenode2”,

“dfs.namenode.rpc-address.my_ha.my_namenode1” = “node1:8020”,

“dfs.namenode.rpc-address.my_ha.my_namenode2” = “node2:8020”,

“dfs.client.failover.proxy.provider” = “org.apache.hadoop.hdfs.server.namenode.ha.ConfiguredFailoverProxyProvider”

)

- 从 HDFS 导入一批“负”数据。同时使用 kerberos 认证方式。提供 keytab 文件路径

LOAD LABEL test_db**.**user_result5

(

DATA INFILE**(**"hdfs://node1:8020/datas/input/old_file)

NEGATIVE

INTO TABLE `user_result`

COLUMNS TERMINATED BY “\t”

)

WITH BROKER broker_name

(

“hadoop**.security.**authentication” = “kerberos”,

“kerberos_principal”=“doris@YOUR**.**COM”,

“kerberos_keytab”="**/home/palo/palo.**keytab"

)

- 从 HDFS 导入一批数据,指定分区。同时使用 kerberos 认证方式。提供 base64 编码后的 keytab 文件内容

LOAD LABEL test_db.user_result6

(

DATA INFILE(“hdfs**😕/node1:8020/datas/input/file**”)

INTO TABLE `user_result`

PARTITION (p1, p2)

COLUMNS TERMINATED BY “,”

(k1, k3, k2, v1, v2)

)

WITH BROKER broker_name

(

“hadoop**.security.**authentication”=“kerberos”,

“kerberos_principal”=“doris@YOUR**.**COM”,

“kerberos_keytab_content”=“BQIAAABEAAEACUJBSURVLkNPTQAEcGFsbw”

)

Stream Load

Broker load是一个同步的导入方式,用户通过发送HTTP协议将本地文件或者数据流导入到Doris中,Stream Load同步执行导入并返回结果,用户可以通过返回判断导入是否成功。

适用场景

Stream load 主要适用于导入本地文件,或通过程序导入数据流中的数据。

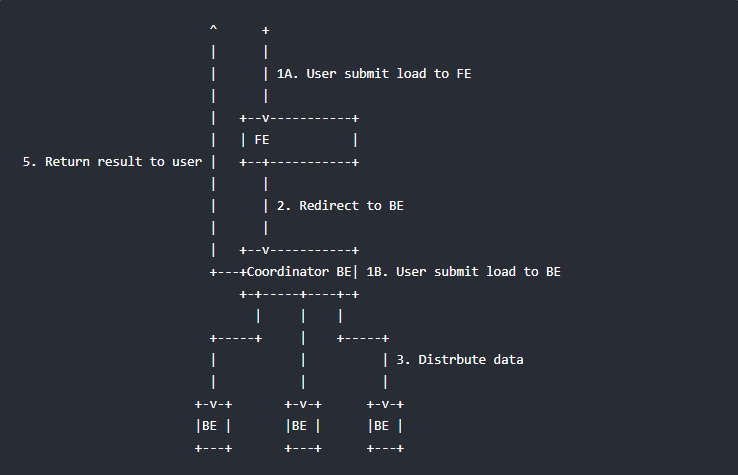

基本原理

下图展示了 Stream load 的主要流程,省略了一些导入细节。

Stream load 中,Doris 会选定一个节点作为 Coordinator 节点。该节点负责接数据并分发数据到其他数据节点。

用户通过 HTTP 协议提交导入命令。如果提交到 FE,则 FE 会通过 HTTP redirect 指令将请求转发给某一个 BE。用户也可以直接提交导入命令给某一指定 BE。

导入的最终结果由 Coordinator BE 返回给用户。

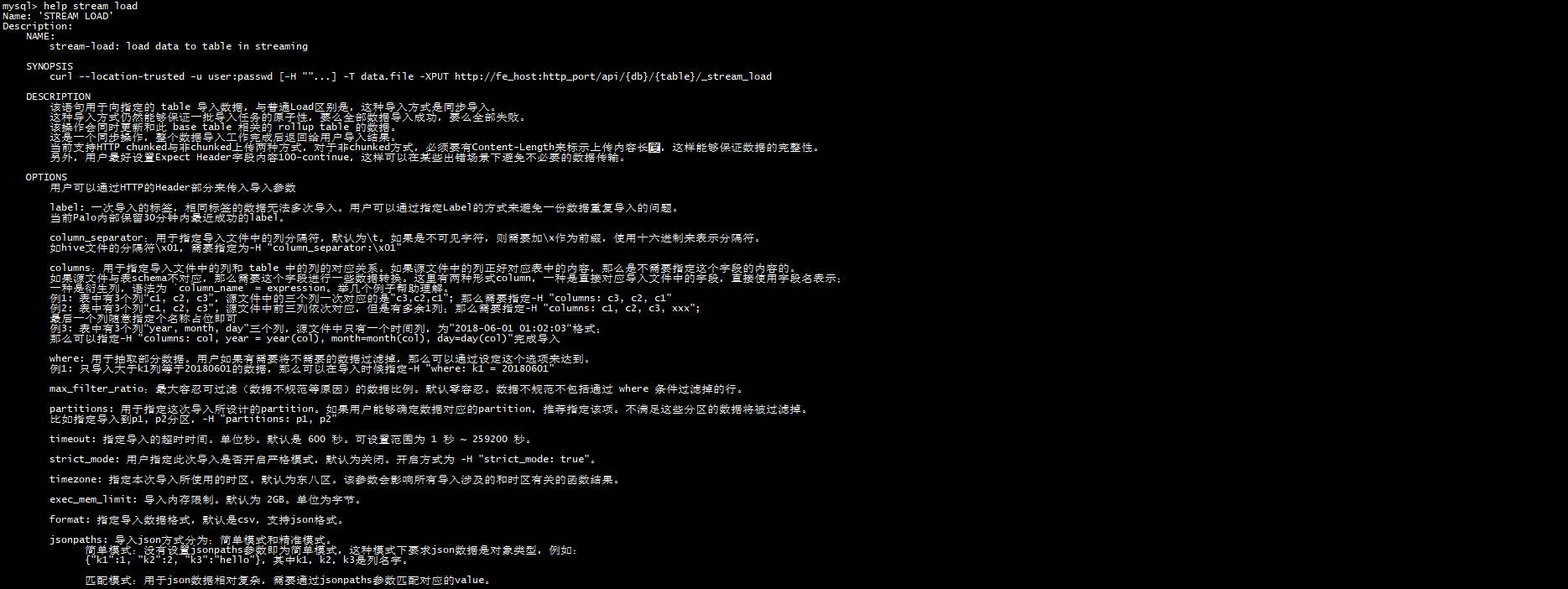

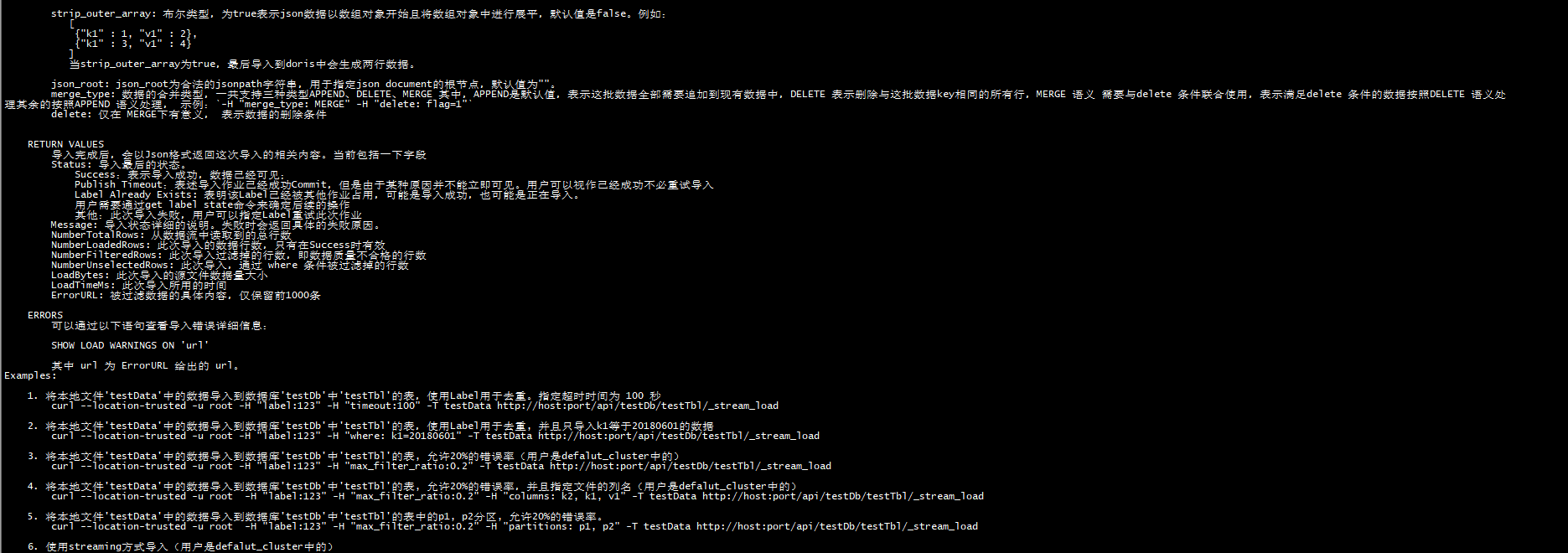

语法

具体帮助使用help stream load查看

数据导入演示

操作步骤

说明

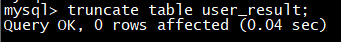

1

进入mysqlclient,清空上次导入到user_result表的数据

truncate table user_result;

2

通过命令将csv将数据导入到doris,-H指定参数,column_seqarator指定分割符,-T指定数据源文件(在csv文件目录下执行)

curl --location-trusted -u root -H “label:123” -H “column_separator:,” -T user.csv -X PUT http://node1:8030/api/test_db/user_result/_stream_load

3

查询导入表的数据

其他导入案例参考

- 将本地文件’testData’中的数据导入到数据库’testDb’中’testTbl’的表,使用Label用于去重

curl **–**location-trusted -u root -H “label:123” -T testData http😕/host:port/api/testDb/testTbl/_stream_load

- 将本地文件’testData’中的数据导入到数据库’testDb’中’testTbl’的表,使用Label用于去重, 并且只导入k1等于20180601的数据

curl **–**location-trusted -u root **-**H “label:123” -H “where: k1=20180601” -T testData http😕/host:port/api/testDb/testTbl/_stream_load

- 将本地文件’testData’中的数据导入到数据库’testDb’中’testTbl’的表, 允许20%的错误率(用户是defalut_cluster中的)

curl **–**location-trusted -u root **-**H “label:123” -H “max_filter_ratio:0.2” -T testData http😕/host:port/api/testDb/testTbl/_stream_load

- 将本地文件’testData’中的数据导入到数据库’testDb’中’testTbl’的表, 允许20%的错误率,并且指定文件的列名(用户是defalut_cluster中的)

curl **–**location-trusted -u root **-**H “label:123” **-**H “max_filter_ratio:0.2” -H “columns: k2, k1, v1” -T testData http😕/host:port/api/testDb/testTbl/_stream_load

- 将本地文件’testData’中的数据导入到数据库’testDb’中’testTbl’的表中的p1, p2分区, 允许20%的错误率。

curl **–**location-trusted -u root **-**H “label:123” **-**H “max_filter_ratio:0.2” -H “partitions: p1, p2” -T testData http😕/host:port/api/testDb/testTbl/_stream_load

- 使用streaming方式导入(用户是defalut_cluster中的)

seq 1 10 | awk ‘{OFS="\t"}{print $1, $1 * 10}’ | curl –location-trusted -u root -T - http😕/host:port/api/testDb/testTbl/_stream_load

- 导入含有HLL列的表,可以是表中的列或者数据中的列用于生成HLL列

curl **–**location-trusted -u root -H “columns: k1, k2, v1=hll_hash(k1)” -T testData http😕/host:port/api/testDb/testTbl/_stream_load

Routine Load

例行导入功能为用户提供了义中自动从指定数据源进行数据导入的功能

适用场景

当前仅支持kafka系统进行例行导入。

使用限制

- 支持无认证的 Kafka 访问,以及通过 SSL 方式认证的 Kafka 集群。

- 支持的消息格式为 csv 文本格式。每一个 message 为一行,且行尾不包含换行符。

- 仅支持 Kafka 0.10.0.0(含) 以上版本。

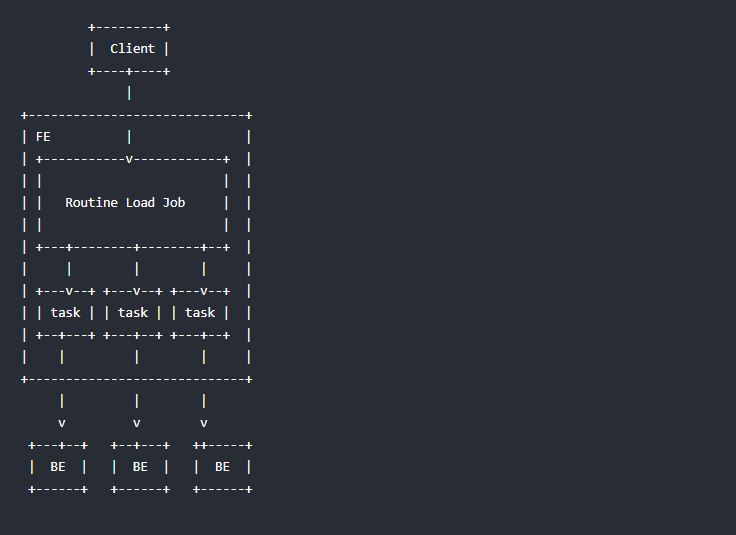

基本原理

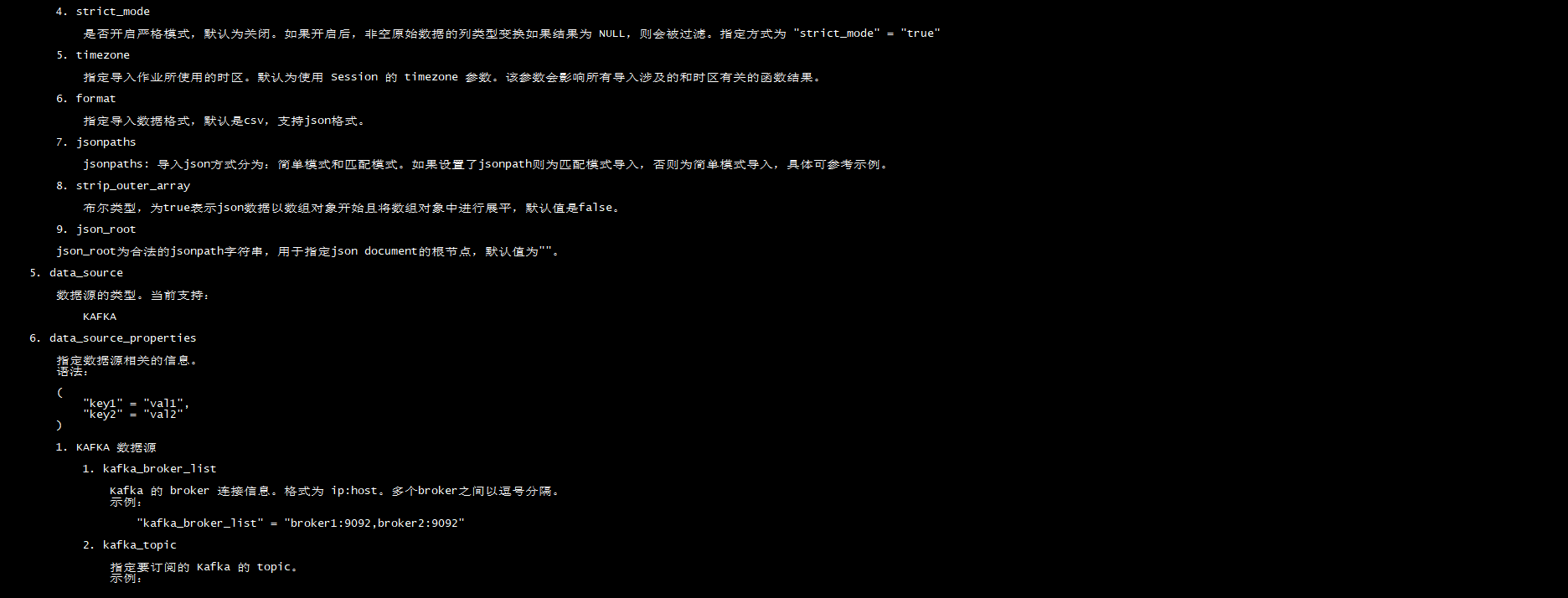

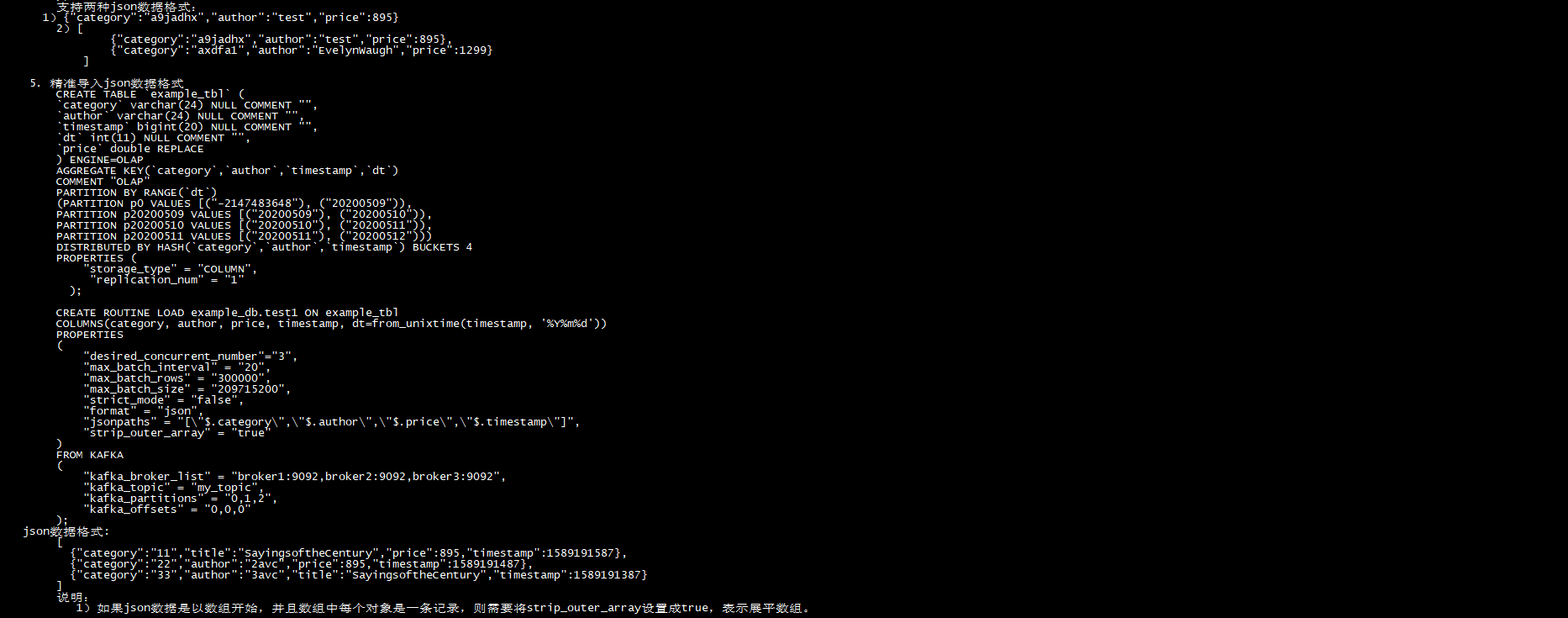

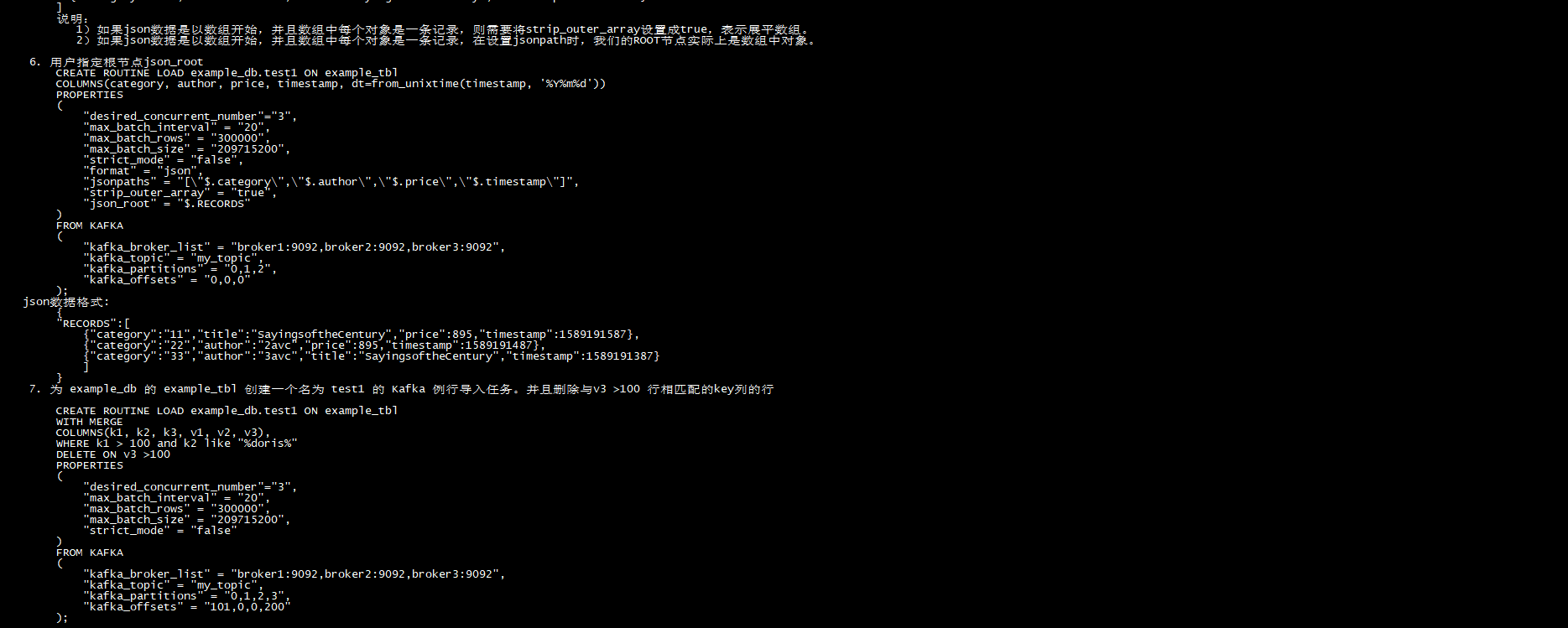

如上图,Client 向 FE 提交一个例行导入作业。

FE 通过 JobScheduler 将一个导入作业拆分成若干个 Task。每个 Task 负责导入指定的一部分数据。Task 被 TaskScheduler 分配到指定的 BE 上执行。

在 BE 上,一个 Task 被视为一个普通的导入任务,通过 Stream Load 的导入机制进行导入。导入完成后,向 FE 汇报。

FE 中的 JobScheduler 根据汇报结果,继续生成后续新的 Task,或者对失败的 Task 进行重试。

整个例行导入作业通过不断的产生新的 Task,来完成数据不间断的导入。

前置操作

- 启动zookeeper集群(三台节点都启动):zkServer.sh start

- 启动kafka集群,创建topic,并向topic写入一批数据

创建例行导入任务

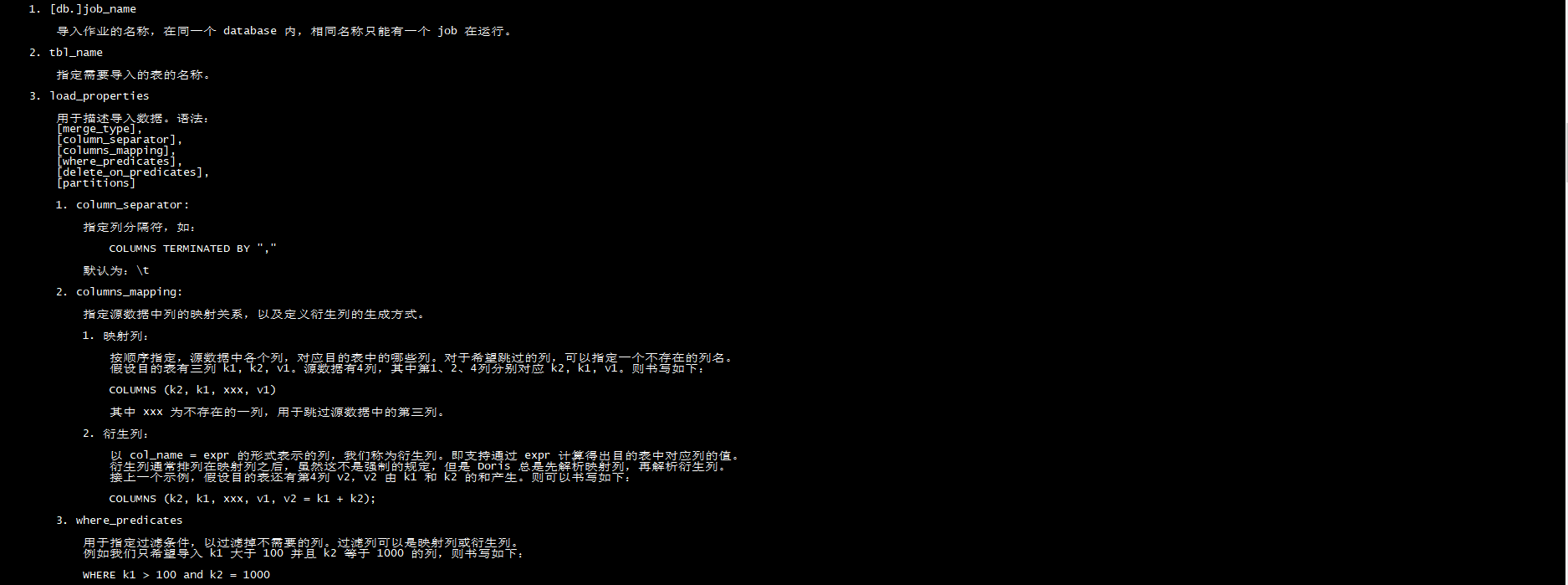

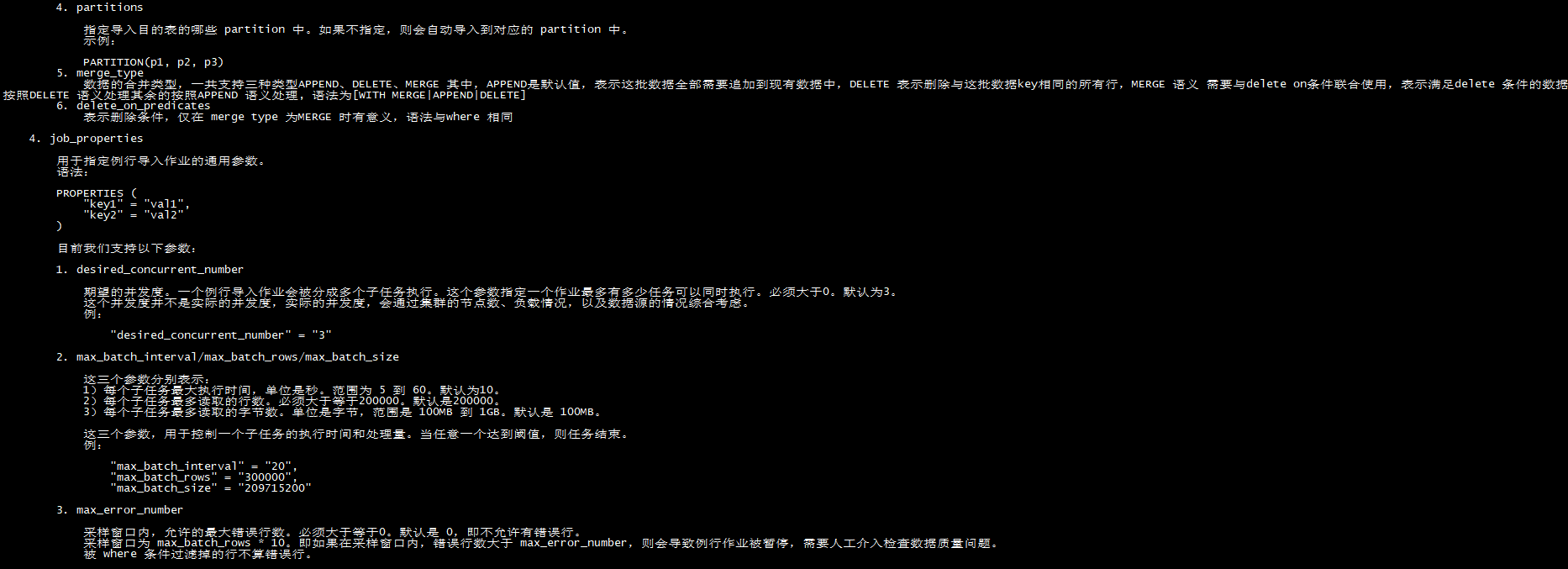

创建例行导入任务的的详细语法可以连接到 Doris 后,执行 HELP ROUTINE LOAD; 查看语法帮助。这里主要详细介绍,创建作业时的注意事项。

语法:

CREATE ROUTINE LOAD **[db.]**job_name ON tbl_name

[load_properties]

[job_properties]

FROM data_source

[data_source_properties]

数据导入演示

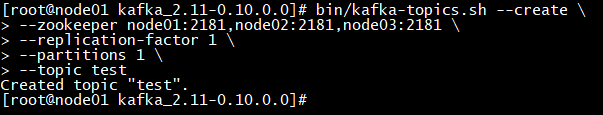

操作步骤

说明

1

启动kafka集群(三台节点都启动)

cd /export/server/kafka_2.11-0.10.0.0

nohup bin/kafka-server-start.sh config/server.properties 2>&1 &

2

创建topic

bin/kafka-topics.sh --create \

–zookeeper node1:2181,node2:2181,node3:2181 \

–replication-factor 1 \

–partitions 1 \

–topic test

3

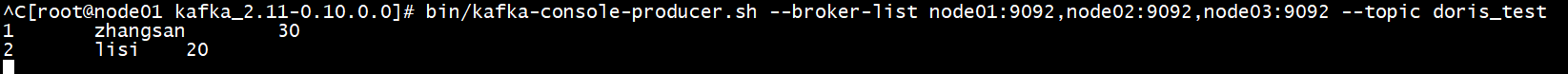

往test topic中插入一批测试数据

启动kafka生产者命令行工具

bin/kafka-console-producer.sh --broker-list node1:9092,node2:9092,node3:9092 --topic test

每个字段以\t分割

4

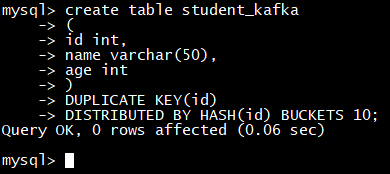

在doris中创建对应表

create table student_kafka

(

id int,

name varchar(50),

age int

)

DUPLICATE KEY(id)

DISTRIBUTED BY HASH**(id)** BUCKETS 10**;**

5

创建导入作业,desired_concurrent_number指定并行度

CREATE ROUTINE LOAD test_db**.**kafka_job1 on student_kafka

PROPERTIES

(

“desired_concurrent_number”=“1”,

“strict_mode”=“false”,

“format” = “json”

)

FROM KAFKA

(

“kafka_broker_list”= “node1:9092,node2:9092,node3:9092”,

“kafka_topic” = “test”,

“property.group.id” = “test_group_1”,

“property.kafka_default_offsets” = “OFFSET_BEGINNING”,

“property.enable.auto.commit” = “false”

);

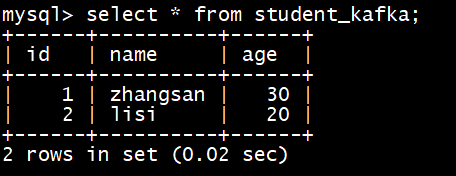

6

查询表的数据(有一定延迟时间)

select * from student_kafka;

查看导入作业状态

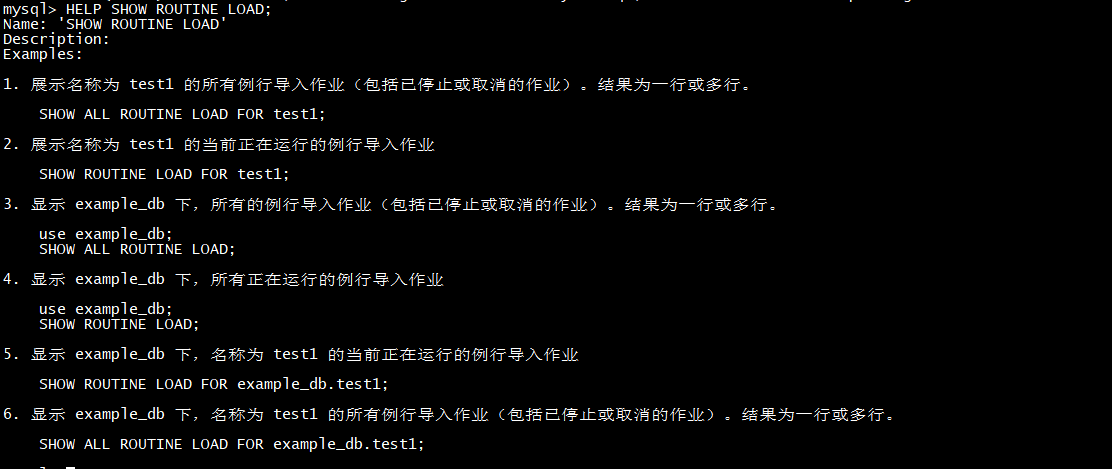

- 查看作业状态的具体命令和示例可以通过 HELP SHOW ROUTINE LOAD; 命令查看。

- 只能查看当前正在运行中的任务,已结束和未开始的任务无法查看。

HELP SHOW ROUTINE LOAD;

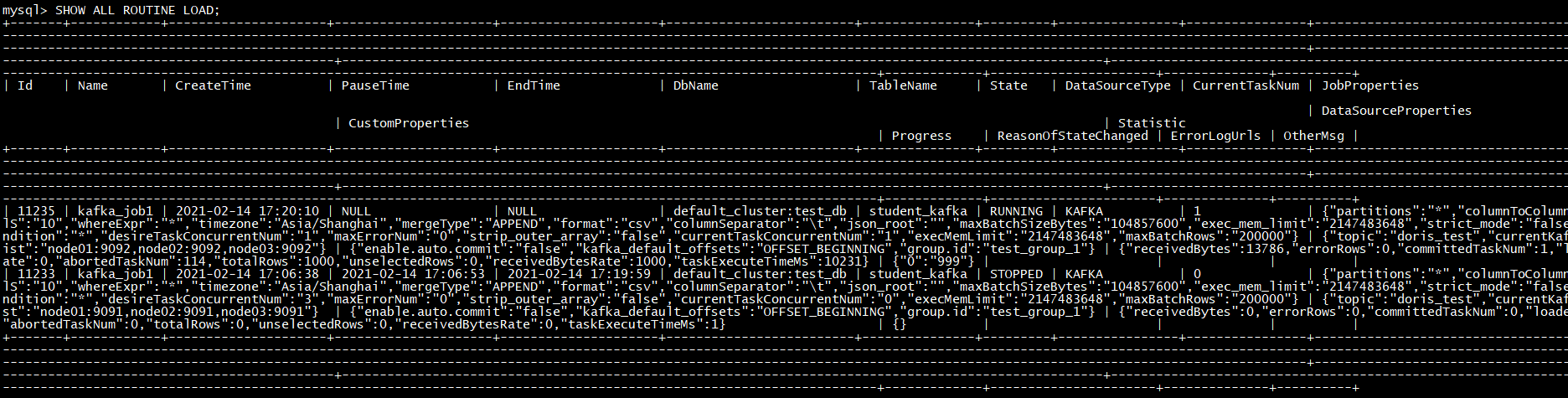

SHOW ALL ROUTINE LOAD;

显示 test_db 下,所有的例行导入作业(包括已停止或取消的作业)。结果为一行或多行。

修改作业属性

用户可以修改已经创建的作业。具体说明可以通过 HELP ALTER ROUTINE LOAD; 命令查看。

作业控制

用户可以通过一下 三个命令来控制作业:

- STOP:停止

- PAUSE:暂停

- RESUME:重启

可以通过以下三个命令查看帮助和示例。

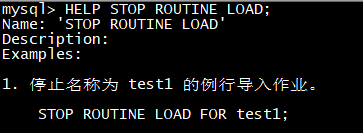

- HELP STOP ROUTINE LOAD;

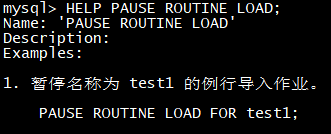

- HELP PAUSE ROUTINE LOAD;

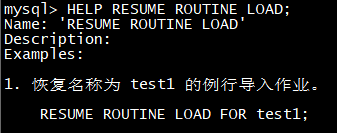

- HELP RESUME ROUTINE LOAD;

Insert Into

Insert Into 语句的使用方式和 MySQL 等数据库中 Insert Into 语句的使用方式类似。但在 Doris 中,所有的数据写入都是一个独立的导入作业。所以这里将 Insert Into 也作为一种导入方式介绍。

主要的 Insert Into 命令包含以下两种;

- INSERT INTO tbl SELECT …

- INSERT INTO tbl (col1, col2, …) VALUES (1, 2, …), (1,3, …);

其中第二种命令仅用于 Demo,不要使用在测试或生产环境中。

创建导入

Insert Into 命令需要通过 MySQL 协议提交,创建导入请求会同步返回导入结果。

语法:

INSERT INTO table_name [partition_info] [WITH LABEL label**]** [col_list] [query_stmt] [VALUES];

示例:

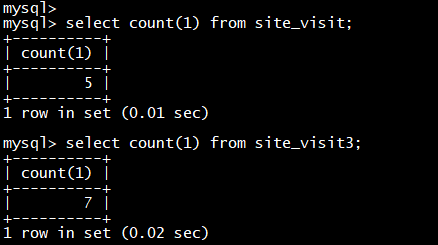

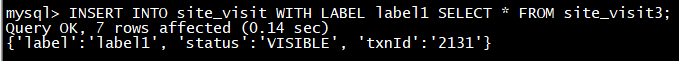

INSERT INTO site_visit WITH LABEL label1 SELECT * FROM site_visit3**;**

注意:

当需要使用 CTE(Common Table Expressions) 作为 insert 操作中的查询部分时,必须指定 WITH LABEL 和 column list 部分。示例

INSERT INTO site_visit WITH LABEL label1 SELECT * FROM site_visit3**;**

导入结果

Insert Into 本身就是一个 SQL 命令,其返回结果会根据执行结果的不同,分为以下几种:

- 结果集为空

如果 insert 对应 select 语句的结果集为空,则返回如下:

mysql**>** insert into tbl1 select * from empty_tbl**;**

Query OK**,** 0 rows affected (0.02 sec)

Query OK 表示执行成功。0 rows affected 表示没有数据被导入。

- 结果集不为空

在结果集不为空的情况下。返回结果分为如下几种情况:

-

- Insert 执行成功并可见:

mysql**>** insert into tbl1 select * from tbl2**;**

Query OK**,** 4 rows affected (0.38 sec)

{‘label’:‘insert_8510c568-9eda-4173-9e36-6adc7d35291c’, ‘status’:‘visible’, ‘txnId’:‘4005’}

mysql**>** insert into tbl1 with label my_label1 select * from tbl2**;**

Query OK**,** 4 rows affected (0.38 sec)

{‘label’:‘my_label1’, ‘status’:‘visible’, ‘txnId’:‘4005’}

mysql**>** insert into tbl1 select * from tbl2**;**

Query OK**,** 2 rows affected**,** 2 warnings (0.31 sec)

{‘label’:‘insert_f0747f0e-7a35-46e2-affa-13a235f4020d’, ‘status’:‘visible’, ‘txnId’:‘4005’}

mysql**>** insert into tbl1 select * from tbl2**;**

Query OK**,** 2 rows affected**,** 2 warnings (0.31 sec)

{‘label’:‘insert_f0747f0e-7a35-46e2-affa-13a235f4020d’, ‘status’:‘committed’, ‘txnId’:‘4005’}

Query OK 表示执行成功。4 rows affected 表示总共有4行数据被导入。2 warnings 表示被过滤的行数。

同时会返回一个 json 串:

{‘label’:‘my_label1’, ‘status’:‘visible’, ‘txnId’:‘4005’}

{‘label’:‘insert_f0747f0e-7a35-46e2-affa-13a235f4020d’, ‘status’:‘committed’, ‘txnId’:‘4005’}

{‘label’:‘my_label1’, ‘status’:‘visible’, ‘txnId’:‘4005’, ‘err’:‘some other error’}

label 为用户指定的 label 或自动生成的 label。Label 是该 Insert Into 导入作业的标识。每个导入作业,都有一个在单 database 内部唯一的 Label。

status 表示导入数据是否可见。如果可见,显示 visible,如果不可见,显示 committed。

txnId 为这个 insert 对应的导入事务的 id。

err 字段会显示一些其他非预期错误。

当需要查看被过滤的行时,用户可以通过如下语句

show load where label**=“xxx”;**

返回结果中的 URL 可以用于查询错误的数据,具体见后面 查看错误行 小结。

数据不可见是一个临时状态,这批数据最终是一定可见的

可以通过如下语句查看这批数据的可见状态:

show transaction where id**=4005;**

返回结果中的 TransactionStatus 列如果为 visible,则表述数据可见。

-

- Insert 执行失败

执行失败表示没有任何数据被成功导入,并返回如下:

mysql**>** insert into tbl1 select * from tbl2 where k1 = “a”;

ERROR 1064 (HY000): all partitions have no load data. url**😗* http**😕/10.74.167.16:8042/api/_load_error_log?file=__shard_2/error_log_insert_stmt_ba8bb9e158e4879-**ae8de8507c0bf8a2_ba8bb9e158e4879_ae8de8507c0bf8a2

其中 ERROR 1064 (HY000): all partitions have no load data 显示失败原因。后面的 url 可以用于查询错误的数据,具体见后面 查看错误行 小结。

综上,对于 insert 操作返回结果的正确处理逻辑应为:

- 如果返回结果为 ERROR 1064 (HY000),则表示导入失败。

- 如果返回结果为 Query OK,则表示执行成功。

- 如果 rows affected 为 0,表示结果集为空,没有数据被导入。

- 如果 rows affected 大于 0:

- 如果 status 为 committed,表示数据还不可见。需要通过 show transaction 语句查看状态直到 visible

- 如果 status 为 visible,表示数据导入成功。

- 如果 warnings 大于 0,表示有数据被过滤,可以通过 show load 语句获取 url 查看被过滤的行

删除数据(Delete)

Doris 目前可以通过两种方式删除数据:DELETE FROM 语句和 ALTER TABLE DROP PARTITION 语句。

语法:

DELETE FROM table_name [PARTITION partition_name**]**

WHERE

column_name1 op { value | value_list } [ AND column_name2 op { value | value_list } …];

DELETE FROM Statement(条件删除)

delete from 语句类似标准 delete 语法,具体使用可以查看 help delete; 帮助。这里主要说明一些注意事项。

- 该语句只能针对 Partition 级别进行删除。如果一个表有多个 partition 含有需要删除的数据,则需要执行多次针对不同 Partition 的 delete 语句。而如果是没有使用 Partition 的表,partition 的名称即表名。

- where 后面的条件谓词只能针对 Key 列,并且谓词之间,只能通过 AND 连接。如果想实现 OR 的语义,需要执行多条 delete。

- delete 是一个同步命令,命令返回即表示执行成功。

- 从代码实现角度,delete 是一种特殊的导入操作。该命令所导入的内容,也是一个新的数据版本,只是该版本中只包含命令中指定的删除条件。在实际执行查询时,会根据这些条件进行查询时过滤。所以,不建议大量频繁使用 delete 命令,因为这可能导致查询效率降低。

- 数据的真正删除是在 BE 进行数据 Compaction 时进行的。所以执行完 delete 命令后,并不会立即释放磁盘空间。

- delete 命令一个较强的限制条件是,在执行该命令时,对应的表,不能有正在进行的导入任务(包括 PENDING、ETL、LOADING)。而如果有 QUORUM_FINISHED 状态的导入任务,则可能可以执行。

- delete 也有一个隐含的类似 QUORUM_FINISHED 的状态。即如果 delete 只在多数副本上完成了,也会返回用户成功。但是会在后台生成一个异步的 delete job(Async Delete Job),来继续完成对剩余副本的删除操作。如果此时通过 show delete 命令,可以看到这种任务在 state 一栏会显示 QUORUM_FINISHED。

如:

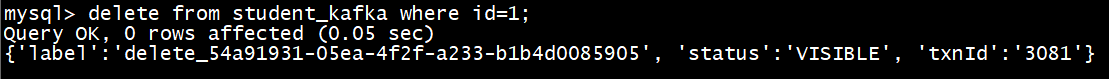

delete from student_kafka where id**=1;**

DROP PARTITION Statement(删除分区)

该命令可以直接删除指定的分区。因为 Partition 是逻辑上最小的数据管理单元,所以使用 DROP PARTITION 命令可以很轻量的完成数据删除工作。并且该命令不受 load 以及任何其他操作的限制,同时不会影响查询效率。是比较推荐的一种数据删除方式。

该命令是同步命令,执行成功即生效。而后台数据真正删除的时间可能会延迟10分钟左右。

简单查询

简单查询

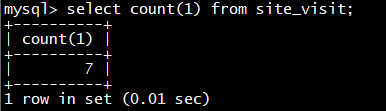

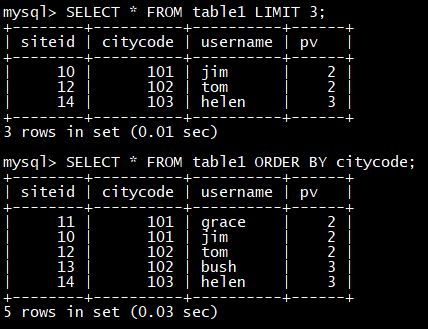

SELECT * FROM table1 LIMIT 3**;**

SELECT * FROM table1 ORDER BY citycode**;**

Join

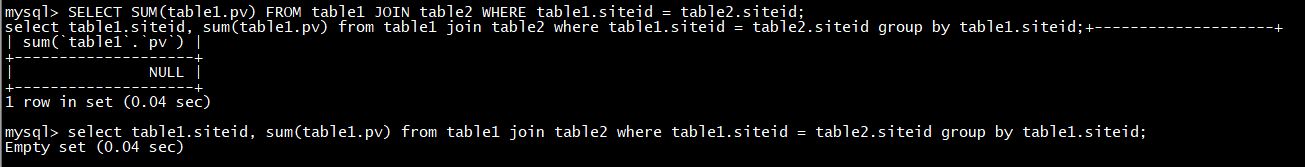

SELECT SUM(table1.pv) FROM table1 JOIN table2 WHERE table1**.siteid = table2.siteid;**

select table1**.siteid,** sum(table1.pv) from table1 join table2 where table1**.siteid = table2.siteid group by table1.siteid;**

子查询

SELECT SUM(pv) FROM table2 WHERE siteid IN (SELECT siteid FROM table1 WHERE siteid > 1**);**

高级功能

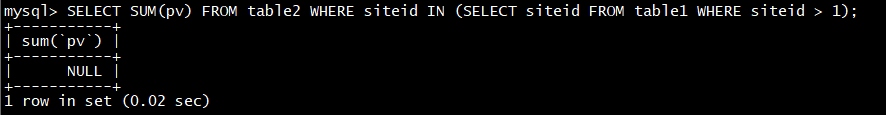

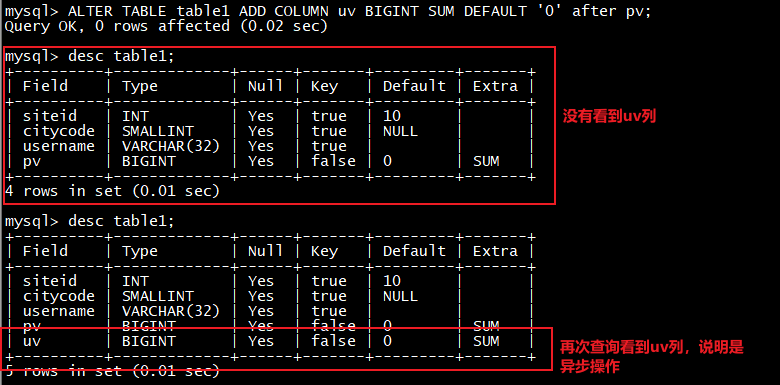

表结构变更

使用alter table 命令, 可进行

- 增加列

- 删除列

- 修改列类型

- 改变列顺序

对上面的table1 添加一列

ALTER TABLE table1 ADD COLUMN uv BIGINT SUM DEFAULT ‘0’ after pv**;**

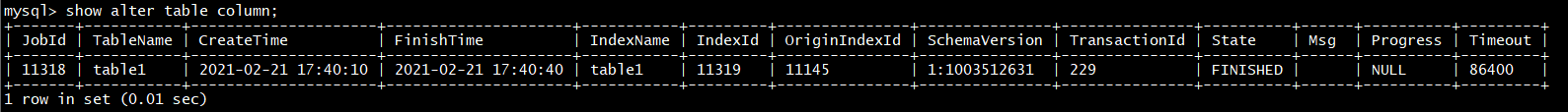

查看执行进度

show alter table column;

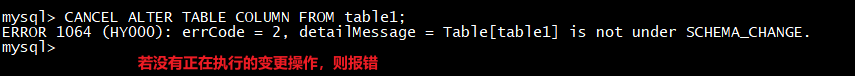

如果想取消掉正在执行的alter, 则使用

show alter table column;

更多帮助,可以参阅: HELP ALTER TABLE

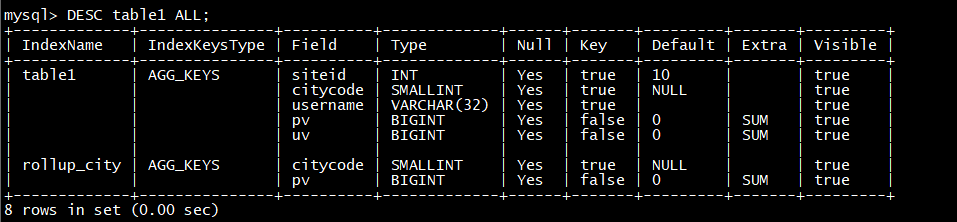

Rollup

Rollup 可以理解为 Table 的一个物化索引结构。物化是因为其数据在物理上独立存储,而 索引 的意思是,Rollup可以调整列顺序以增加前缀索引的命中率,也可以减少key列以增加数据的聚合度。

对于 table1 明细数据是 siteid, citycode, username 三者构成一组 key,从而对 pv 字段进行聚合;如果业务方经常有看城市 pv 总量的需求,可以建立一个只有 citycode, pv 的rollup。

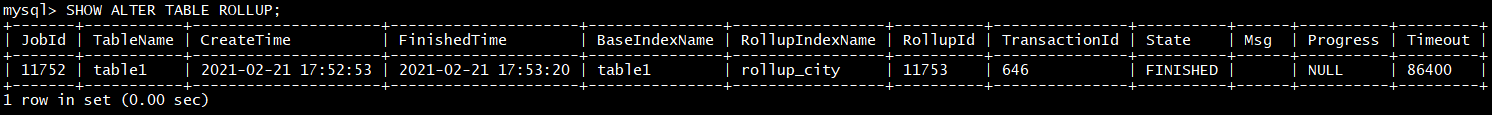

ALTER TABLE table1 ADD ROLLUP rollup_city**(citycode,** pv**);**

通过命令查看完成状态

SHOW ALTER TABLE ROLLUP;

之后可以查看完成情况

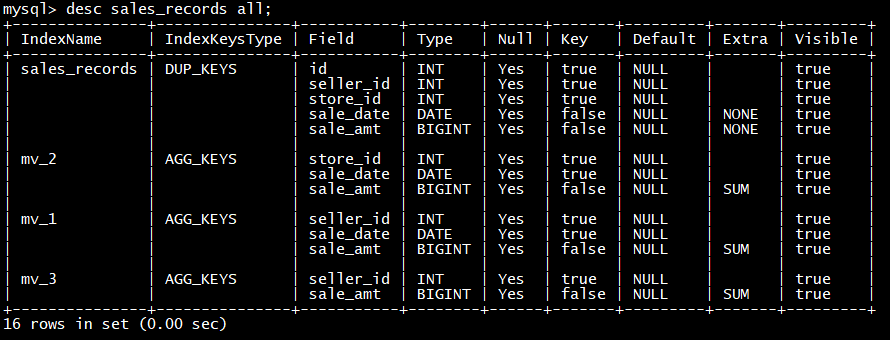

DESC table1 ALL;

可以使用以下命令取消当前正在执行的作业:

CANCEL ALTER TABLE ROLLUP FROM table1**;**

Rollup 建立之后,查询不需要指定 Rollup 进行查询。还是指定原有表进行查询即可。程序会自动判断是否应该使用 Rollup。是否命中 Rollup可以通过 EXPLAIN your_sql; 命令进行查看。

更多帮助,可以参阅 HELP ALTER TABLE。

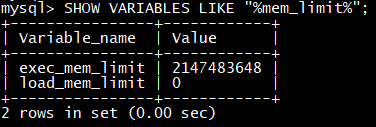

高级设置

增大内存

内存不够时, 查询可能会出现‘Memory limit exceeded’, 这是因为doris对每个用户默认设置内存限制为 2g

SHOW VARIABLES LIKE “%mem_limit%”;

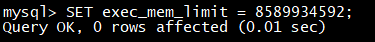

exec_mem_limit 的单位是 byte,可以通过 SET 命令改变 exec_mem_limit 的值。如改为 8GB。

SET exec_mem_limit = 8589934592**;**

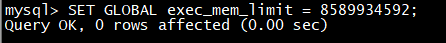

上述设置仅仅在当前session有效, 如果想永久有效, 需要添加 global 参数

SET GLOBAL exec_mem_limit = 8589934592**;**

修改超时时间

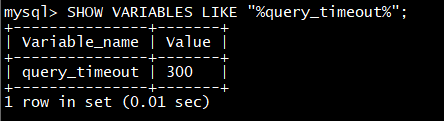

doris默认最长查询时间为300s, 如果仍然未完成, 会被cancel掉

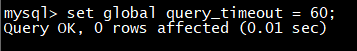

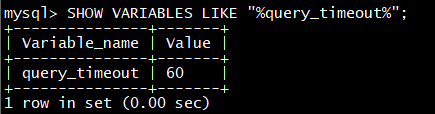

SHOW VARIABLES LIKE “%query_timeout%”;

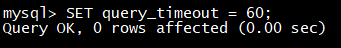

可以修改为60s

SET query_timeout = 60**;**

同样, 如果需要全局生效需要添加参数 global

set global query_timeout = 60**;**

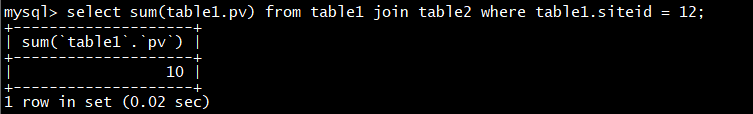

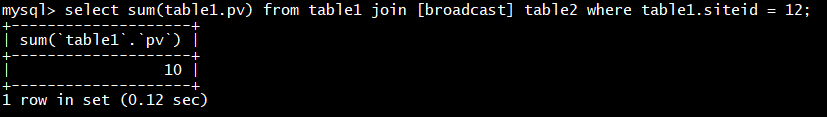

Broadcast/Shuffle Join

doris在join操作的时候时候, 默认使用broadcast的方式进行join, 即将小表通过广播的方式广播到大表所在的节点, 形成内存hash, 然后流式读出大表数据进行hashjoin

但如果小表的数据量也很大的时候, 就会造成内存溢出, 此时需要通过shuffle join的方式进行, 也被称为partition join. 即将大表小表都按照join的key进行hash, 然后进行分布式join

- 使用 Broadcast Join(默认)

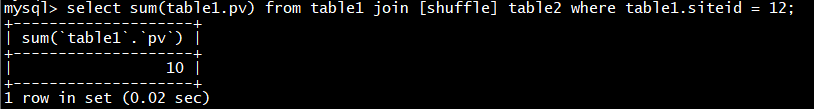

select sum(table1.pv) from table1 join table2 where table1**.siteid = 12;**

- 显示指定braodcast

select sum(table1.pv) from table1 join [broadcast] table2 where table1**.siteid = 12;**

- 使用suffle join

select sum(table1.pv) from table1 join [shuffle] table2 where table1**.siteid = 12;**

doris的高可用方案

当部署多个 FE 节点时,用户可以在多个fe上部署负载均衡实现或者通过mysql connect 自动重连

jdbc**:mysql😕/[host:port],[host:port]…/[database][?propertyName1][=propertyValue1][&propertyName2][=propertyValue2]…**

或者应用可以连接到和应用部署到同一机器上的 MySQL Proxy,通过配置 MySQL Proxy 的 Failover 和 Load Balance 功能来达到目的。

数据模型

在 Doris 中,数据以表(Table)的形式进行逻辑上的描述。一张表包括行(Row)和列(Column)。Row即用户的一行数据。Column 用于描述一行数据中不同的字段。

Column可以分为两大类:Key(维度列)和Value(指标列)

Doris 的数据模型主要分为3类:

- Aggregate

- Uniq

- Duplicate

Aggregate模型(聚合模型)

这是一个典型的用户信息和访问行为的事实表。 在一般星型模型中,用户信息和访问行为一般分别存放在维度表和事实表中。这里我们为了更加方便的解释 Doris 的数据模型,将两部分信息统一存放在一张表中。

表中的列按照是否设置了 AggregationType,分为 Key (维度列) 和 Value(指标列)。没有设置 AggregationType 的,如 user_id、date、age … 等称为 Key,而设置了 AggregationType 的称为 Value。

当我们导入数据时,对于 Key 列相同的行和聚合成一行,而 Value 列会按照设置的 AggregationType 进行聚合。 AggregationType 目前有以下四种聚合方式:

- SUM:求和,多行的 Value 进行累加。

- REPLACE:替代,下一批数据中的 Value 会替换之前导入过的行中的 Value。

- MAX:保留最大值。

- MIN:保留最小值。

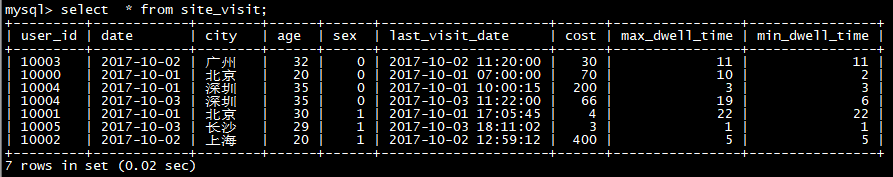

假设我们有以下导入数据(原始数据):

AGGREGATEKEY模型可以提前聚合数据,适合报表和多维度业务

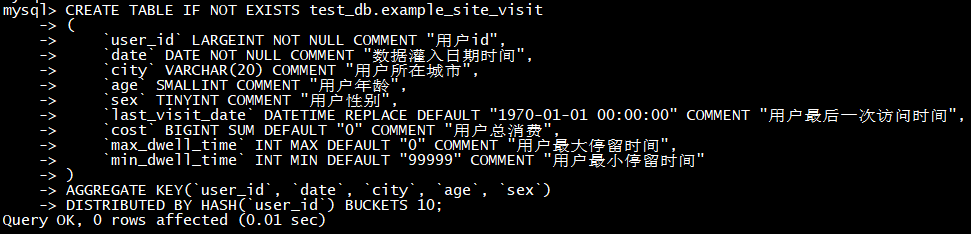

- 演示一:导入数据聚合

操作步骤

说明

1

创建doris表

CREATE TABLE IF NOT EXISTS test_db**.**example_site_visit

(

`user_id` LARGEINT NOT NULL COMMENT “用户id”,

`date` DATE NOT NULL COMMENT “数据灌入日期时间”,

`city` VARCHAR(20) COMMENT “用户所在城市”,

`age` SMALLINT COMMENT “用户年龄”,

`sex` TINYINT COMMENT “用户性别”,

`last_visit_date` DATETIME REPLACE DEFAULT “1970-01-01 00:00:00” COMMENT “用户最后一次访问时间”,

`cost` BIGINT SUM DEFAULT “0” COMMENT “用户总消费”,

`max_dwell_time` INT MAX DEFAULT “0” COMMENT “用户最大停留时间”,

`min_dwell_time` INT MIN DEFAULT “99999” COMMENT “用户最小停留时间”

)

AGGREGATE KEY(`user_id`, `date`, `city`, `age`, `sex`)

DISTRIBUTED BY HASH**(`user_id`)** BUCKETS 10**;**

2

插入数据

insert into test_db**.example_site_visit values(10000,‘2020-10-01’,‘北京’,20,0,‘2020-10-01 06:00:00’,20,10,10);**

insert into test_db**.example_site_visit values(10000,‘2020-10-01’,‘北京’,20,0,‘2020-10-01 07:00:00’,15,2,2);**

insert into test_db**.example_site_visit values(10001,‘2020-10-01’,‘北京’,30,1,‘2020-10-01 17:05:45’,2,22,22);**

insert into test_db**.example_site_visit values(10002,‘2020-10-02’,‘上海’,20,1,‘2020-10-02 12:59:12’,200,5,5);**

insert into test_db**.example_site_visit values(10003,‘2020-10-02’,‘广州’,32,0,‘2020-10-02 11:20:00’,30,11,11);**

insert into test_db**.example_site_visit values(10004,‘2020-10-01’,‘深圳’,35,0,‘2020-10-01 10:00:15’,100,3,3);**

insert into test_db**.example_site_visit values(10004,‘2020-10-03’,‘深圳’,35,0,‘2020-10-03 10:20:22’,11,6,6);**

3

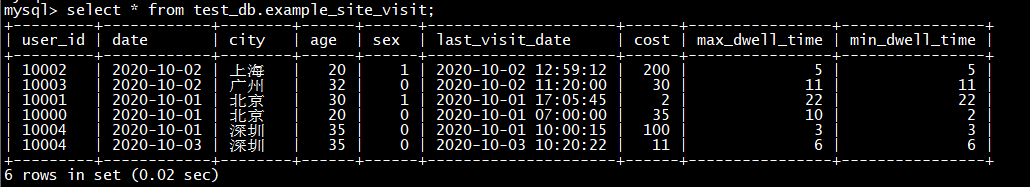

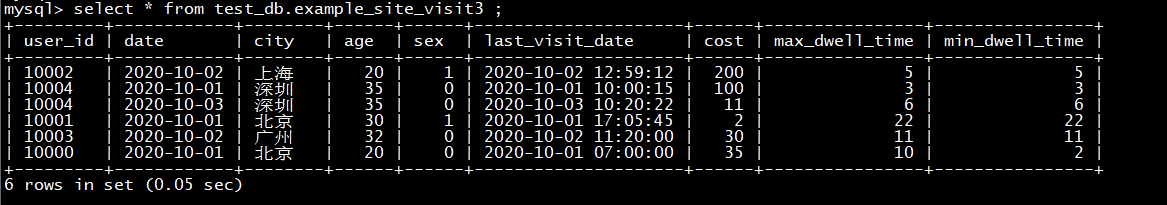

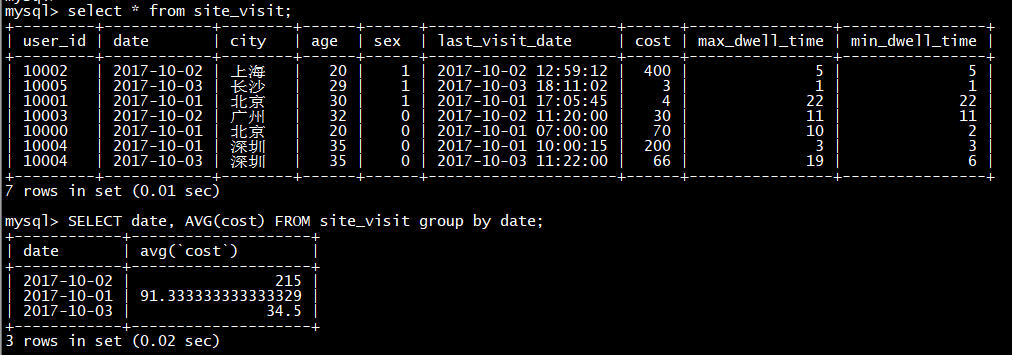

select * from test_db**.example_site_visit;**

可以看到,用户 10000 只剩下了一行聚合后的数据。而其余用户的数据和原始数据保持一致。这里先解释下用户 10000 聚合后的数据:

前5列没有变化,从第6列 last_visit_date 开始:

2020-10-01 07:00:00:因为 last_visit_date 列的聚合方式为 REPLACE,所以 2020-10-01 07:00:00 替换了 2020-10-01 06:00:00 保存了下来。

注:在同一个导入批次中的数据,对于 REPLACE 这种聚合方式,替换顺序不做保证。如在这个例子中,最终保存下来的,也有可能是 2020-10-01 06:00:00。而对于不同导入批次中的数据,可以保证,后一批次的数据会替换前一批次。

35:因为 cost 列的聚合类型为 SUM,所以由 20 + 15 累加获得 35。

10:因为 max_dwell_time 列的聚合类型为 MAX,所以 10 和 2 取最大值,获得 10。

2:因为 min_dwell_time 列的聚合类型为 MIN,所以 10 和 2 取最小值,获得 2。

经过聚合,Doris 中最终只会存储聚合后的数据。换句话说,即明细数据会丢失,用户不能够再查询到聚合前的明细数据了。

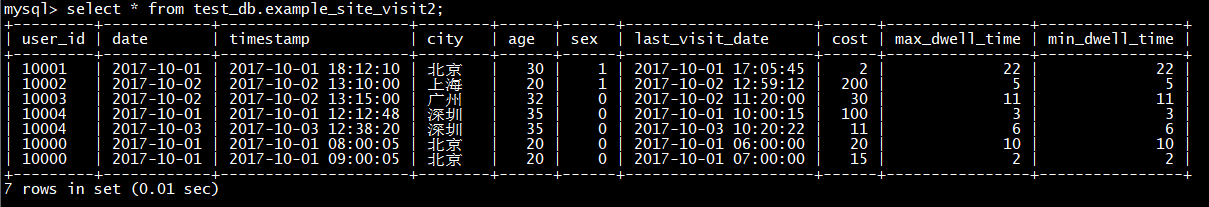

- 演示二:保留明细数据

操作步骤

说明

1

创建doris表

CREATE TABLE IF NOT EXISTS test_db**.**example_site_visit2

(

`user_id` LARGEINT NOT NULL COMMENT “用户id”,

`date` DATE NOT NULL COMMENT “数据灌入日期时间”,

`timestamp` DATETIME COMMENT “数据灌入时间,精确到秒”,

`city` VARCHAR(20) COMMENT “用户所在城市”,

`age` SMALLINT COMMENT “用户年龄”,

`sex` TINYINT COMMENT “用户性别”,

`last_visit_date` DATETIME REPLACE DEFAULT “1970-01-01 00:00:00” COMMENT “用户最后一次访问时间”,

`cost` BIGINT SUM DEFAULT “0” COMMENT “用户总消费”,

`max_dwell_time` INT MAX DEFAULT “0” COMMENT “用户最大停留时间”,

`min_dwell_time` INT MIN DEFAULT “99999” COMMENT “用户最小停留时间”

)

AGGREGATE KEY(`user_id`, `date`, `timestamp`, `city`, `age`, `sex`)

DISTRIBUTED BY HASH**(`user_id`)** BUCKETS 10**;**

2

插入数据

insert into test_db**.example_site_visit2 values(10000,‘2017-10-01’,‘2017-10-01 08:00:05’,‘北京’,20,0,‘2017-10-01 06:00:00’,20,10,10);**

insert into test_db**.example_site_visit2 values(10000,‘2017-10-01’,‘2017-10-01 09:00:05’,‘北京’,20,0,‘2017-10-01 07:00:00’,15,2,2);**

insert into test_db**.example_site_visit2 values(10001,‘2017-10-01’,‘2017-10-01 18:12:10’,‘北京’,30,1,‘2017-10-01 17:05:45’,2,22,22);**

insert into test_db**.example_site_visit2 values(10002,‘2017-10-02’,‘2017-10-02 13:10:00’,‘上海’,20,1,‘2017-10-02 12:59:12’,200,5,5);**

insert into test_db**.example_site_visit2 values(10003,‘2017-10-02’,‘2017-10-02 13:15:00’,‘广州’,32,0,‘2017-10-02 11:20:00’,30,11,11);**

insert into test_db**.example_site_visit2 values(10004,‘2017-10-01’,‘2017-10-01 12:12:48’,‘深圳’,35,0,‘2017-10-01 10:00:15’,100,3,3);**

insert into test_db**.example_site_visit2 values(10004,‘2017-10-03’,‘2017-10-03 12:38:20’,‘深圳’,35,0,‘2017-10-03 10:20:22’,11,6,6);**

3

select * from test_db**.**example_site_visit2 ;

我们可以看到,存储的数据,和导入数据完全一样,没有发生任何聚合。这是因为,这批数据中,因为加入了 timestamp 列,所有行的 Key 都不完全相同。

也就是说,只要保证导入的数据中,每一行的 Key 都不完全相同,那么即使在聚合模型下,Doris 也可以保存完整的明细数据。

- 演示三:导入数据与已有数据聚合

刚才讲了数据在导入的时候会有一次合并,因为要聚合。还有一种情况是如果我先导入了一批数据,然后又导入了一批数据,这两批的数据之间有相同的时候,也需要进行一个合并。

操作步骤

说明

1

创建doris表

CREATE TABLE IF NOT EXISTS test_db**.**example_site_visit3

(

`user_id` LARGEINT NOT NULL COMMENT “用户id”,

`date` DATE NOT NULL COMMENT “数据灌入日期时间”,

`city` VARCHAR(20) COMMENT “用户所在城市”,

`age` SMALLINT COMMENT “用户年龄”,

`sex` TINYINT COMMENT “用户性别”,

`last_visit_date` DATETIME REPLACE DEFAULT “1970-01-01 00:00:00” COMMENT “用户最后一次访问时间”,

`cost` BIGINT SUM DEFAULT “0” COMMENT “用户总消费”,

`max_dwell_time` INT MAX DEFAULT “0” COMMENT “用户最大停留时间”,

`min_dwell_time` INT MIN DEFAULT “99999” COMMENT “用户最小停留时间”

)

AGGREGATE KEY(`user_id`, `date`, `city`, `age`, `sex`)

DISTRIBUTED BY HASH**(`user_id`)** BUCKETS 10**;**

2

插入数据

insert into test_db**.example_site_visit3 values(10000,‘2020-10-01’,‘北京’,20,0,‘2020-10-01 06:00:00’,20,10,10);**

insert into test_db**.example_site_visit3 values(10000,‘2020-10-01’,‘北京’,20,0,‘2020-10-01 07:00:00’,15,2,2);**

insert into test_db**.example_site_visit3 values(10001,‘2020-10-01’,‘北京’,30,1,‘2020-10-01 17:05:45’,2,22,22);**

insert into test_db**.example_site_visit3 values(10002,‘2020-10-02’,‘上海’,20,1,‘2020-10-02 12:59:12’,200,5,5);**

insert into test_db**.example_site_visit3 values(10003,‘2020-10-02’,‘广州’,32,0,‘2020-10-02 11:20:00’,30,11,11);**

insert into test_db**.example_site_visit3 values(10004,‘2020-10-01’,‘深圳’,35,0,‘2020-10-01 10:00:15’,100,3,3);**

insert into test_db**.example_site_visit3 values(10004,‘2020-10-03’,‘深圳’,35,0,‘2020-10-03 10:20:22’,11,6,6);**

3

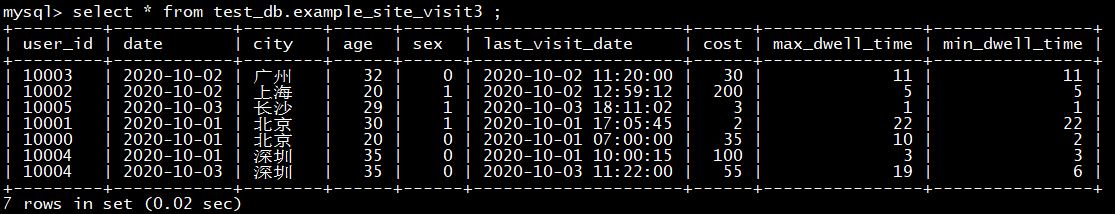

select * from test_db**.**example_site_visit3 ;

4

再导入一批新的数据:

insert into test_db**.example_site_visit3 values(10004,‘2020-10-03’,‘深圳’,35,0,‘2020-10-03 11:22:00’,44,19,19);**

insert into test_db**.example_site_visit3 values(10005,‘2020-10-03’,‘长沙’,29,1,‘2020-10-03 18:11:02’,3,1,1);**

5

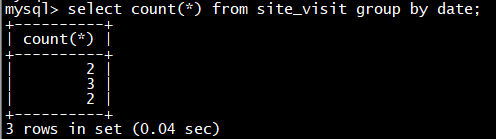

select * from test_db**.**example_site_visit3 ;

可以看到,用户 10004 的已有数据和新导入的数据发生了聚合。同时新增了 10005 用户的数据。

数据的聚合,在 Doris 中有如下三个阶段发生:

- 每一批次数据导入的 ETL 阶段。该阶段会在每一批次导入的数据内部进行聚合。

- 底层 BE 进行数据 Compaction 的阶段。该阶段,BE 会对已导入的不同批次的数据进行进一步的聚合。

- 数据查询阶段。在数据查询时,对于查询涉及到的数据,会进行对应的聚合。

数据在不同时间,可能聚合的程度不一致。比如一批数据刚导入时,可能还未与之前已存在的数据进行聚合。但是对于用户而言,用户只能查询到聚合后的数据。即不同的聚合程度对于用户查询而言是透明的。用户需始终认为数据以最终的完成的聚合程度存在,而不应假设某些聚合还未发生。(可参阅聚合模型的局限性一节获得更多详情。)

Uniq模型(唯一主键)

在某些多维分析场景下,用户更关注的是如何保证 Key 的唯一性,即如何获得 Primary Key 唯一性约束。因此,我们引入了 Uniq 的数据模型。该模型本质上是聚合模型的一个特例,也是一种简化的表结构表示方式。

Unique Key 的模型主要面向留存分析或者订单分析的场景,他们需要一个 Unique Key 的约束去保证整个数据不丢不重。然后 Duplicate Key 的模型,就是这个数据可能重复,

- 演示

操作步骤

说明

1

创建doris表

CREATE TABLE IF NOT EXISTS test_db**.user**

(

`user_id` LARGEINT NOT NULL COMMENT “用户id”,

`username` VARCHAR(50) NOT NULL COMMENT “用户昵称”,

`city` VARCHAR(20) COMMENT “用户所在城市”,

`age` SMALLINT COMMENT “用户年龄”,

`sex` TINYINT COMMENT “用户性别”,

`phone` LARGEINT COMMENT “用户电话”,

`address` VARCHAR(500) COMMENT “用户地址”,

`register_time` DATETIME COMMENT “用户注册时间”

)

UNIQUE KEY(`user_id`, `username`)

DISTRIBUTED BY HASH**(`user_id`)** BUCKETS 10**;**

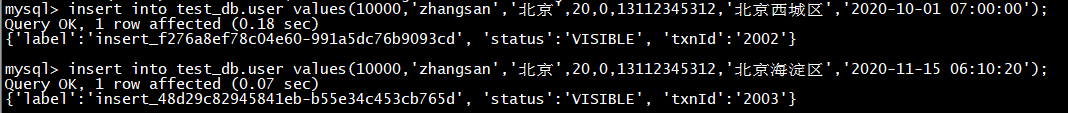

3

插入数据

insert into test_db**.user** values(10000,‘zhangsan’,‘北京’,20,0,13112345312,‘北京西城区’,‘2020-10-01 07:00:00’);

insert into test_db**.user** values(10000,‘zhangsan’,‘北京’,20,0,13112345312,‘北京xx区’,‘2020-11-15 06:10:20’);

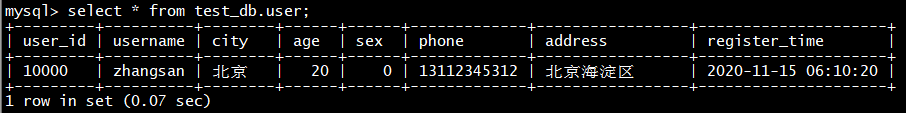

4

查询数据

select * from test_db**.user;**

即 Uniq 模型完全可以用聚合模型中的 REPLACE 方式替代。其内部的实现方式和数据存储方式也完全一样

Duplicate 模型(冗余模型)

Duplicate Key 的模型,就是说支持一个用户导入之后把这个数据全部放在数据库里面,我们不再做提前的聚合,也不单独保证唯一性,只做一个排序。因此,我们引入 Duplicate 数据模型来满足这类需求。

如:对于有些日志分析它不太在意数据多几条或者少几条,可能只关心排序,这个时候可能重复 Key 的模型会更加有效果。

- 演示

操作步骤

说明

1

创建doris表

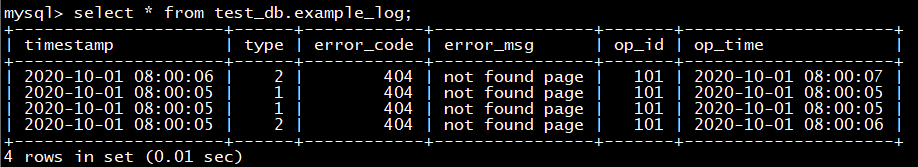

CREATE TABLE IF NOT EXISTS test_db.example_log

(

`timestamp` DATETIME NOT NULL COMMENT “日志时间”,

`type` INT NOT NULL COMMENT “日志类型”,

`error_code` INT COMMENT “错误码”,

`error_msg` VARCHAR(1024) COMMENT “错误详细信息”,

`op_id` BIGINT COMMENT “负责人id”,

`op_time` DATETIME COMMENT “处理时间”

)

DUPLICATE KEY(`timestamp`, `type`)

DISTRIBUTED BY HASH**(`timestamp`)** BUCKETS 10**;**

2

插入数据

insert into test_db**.example_log values(‘2020-10-01 08:00:05’,1,404,‘not found page’,** 101**,** ‘2020-10-01 08:00:05’);

insert into test_db**.example_log values(‘2020-10-01 08:00:05’,1,404,‘not found page’,** 101**,** ‘2020-10-01 08:00:05’);

insert into test_db**.example_log values(‘2020-10-01 08:00:05’,2,404,‘not found page’,** 101**,** ‘2020-10-01 08:00:06’);

insert into test_db**.example_log values(‘2020-10-01 08:00:06’,2,404,‘not found page’,** 101**,** ‘2020-10-01 08:00:07’);

3

查询数据

select * from test_db.example_log**;**

这种数据模型区别于 Aggregate 和 Uniq 模型。数据完全按照导入文件中的数据进行存储,不会有任何聚合。即使两行数据完全相同,也都会保留。 而在建表语句中指定的 DUPLICATE KEY,只是用来指明底层数据按照那些列进行排序

数据模型的总结

索引和Rollup

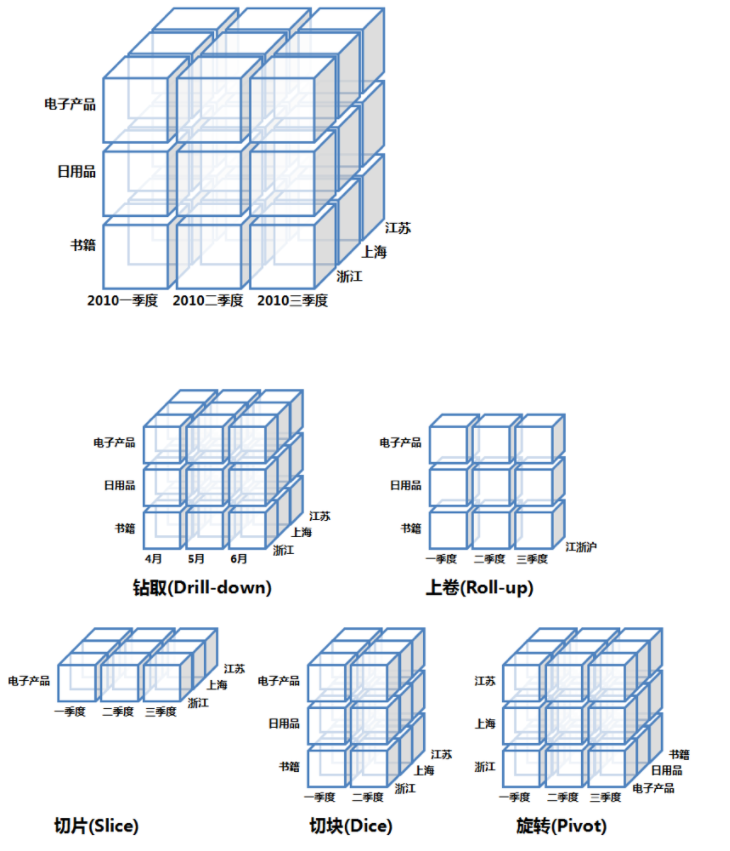

ROLLUP 在多维分析中是“上卷”的意思,即将数据按某种指定的粒度进行进一步聚合。

Rollup可以理解为表的一个物化索引结构,Rollup可以调整列的顺序以增加前缀索引的命中率,也可以减少key列以增加数据的聚合度。

基本概念

在 Doris 中,我们将用户通过建表语句创建出来的表成为 Base 表(Base Table)。Base 表中保存着按用户建表语句指定的方式存储的基础数据。

在 Base 表之上,我们可以创建任意多个 ROLLUP 表。这些 ROLLUP 的数据是基于 Base 表产生的,并且在物理上是独立存储的。

ROLLUP 表的基本作用,在于在 Base 表的基础上,获得更粗粒度的聚合数据。

- 在聚合表的基础上,按照其他维度再进一步聚合,提升查询效率。

- Doris索引是固定的前缀索引,用rollup改变索引顺序

下面我们用示例详细说明在不同数据模型中的 ROLLUP 表及其作用。

案例演示

- 在聚合表的基础上,按照其他维度再进一步聚合,提升查询效率。

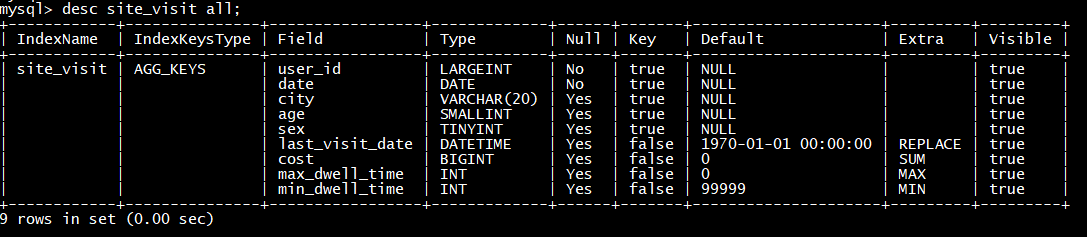

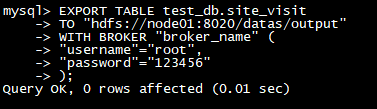

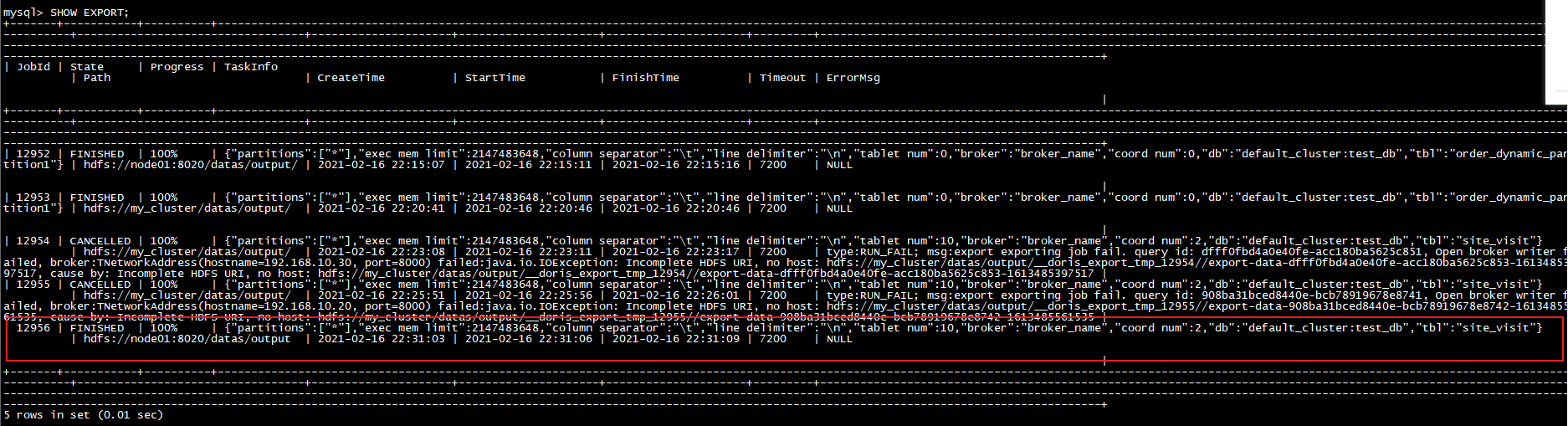

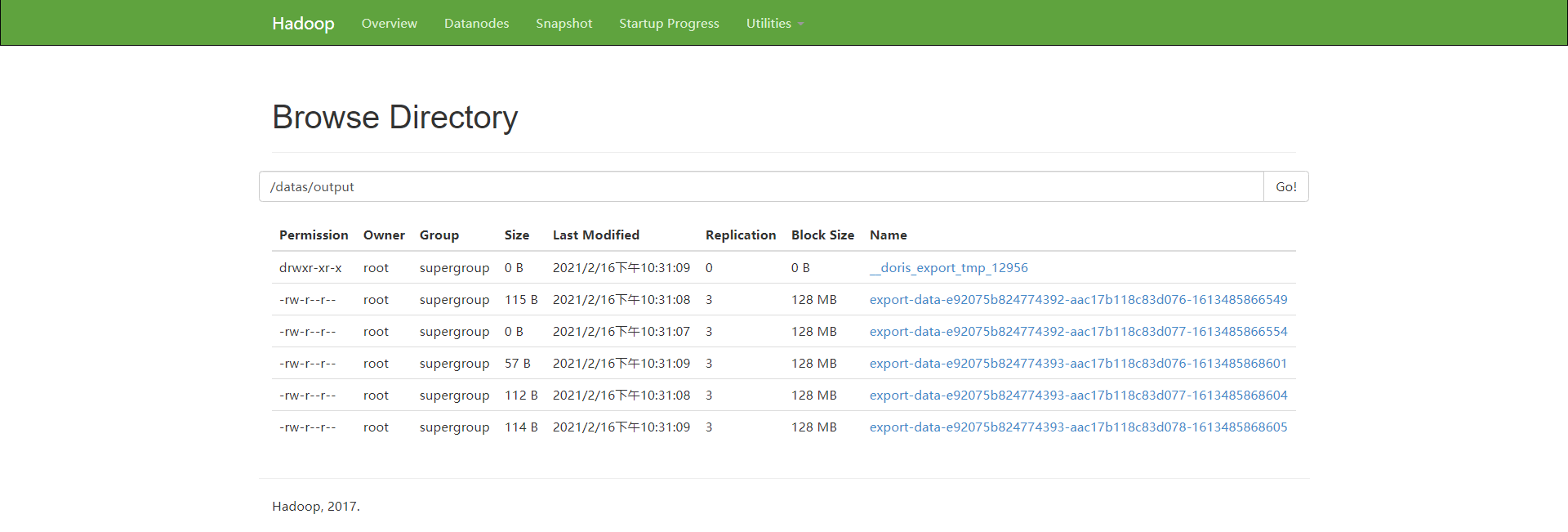

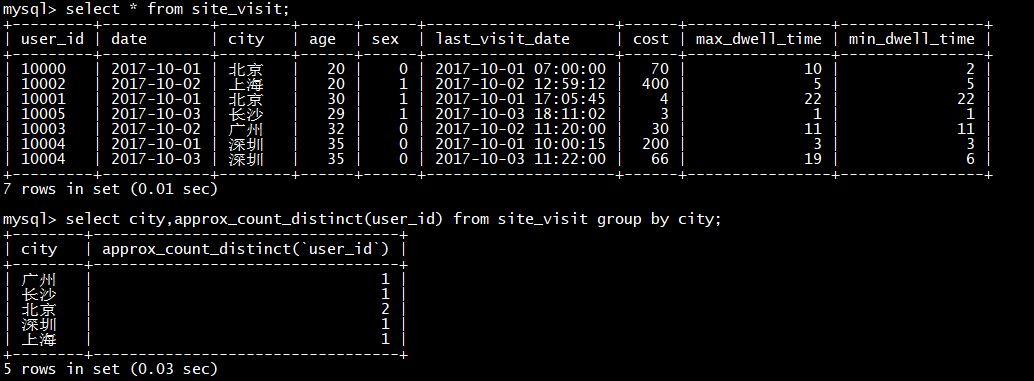

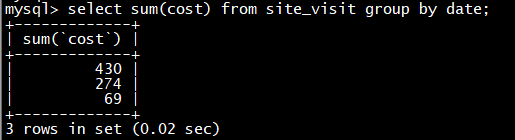

以site_visit表为例

操作步骤

说明

1

创建表

CREATE TABLE IF NOT EXISTS test_db**.**site_visit

(

`user_id` LARGEINT NOT NULL COMMENT “用户id”,

`date` DATE NOT NULL COMMENT “数据灌入日期时间”,

`city` VARCHAR(20) COMMENT “用户所在城市”,

`age` SMALLINT COMMENT “用户年龄”,

`sex` TINYINT COMMENT “用户性别”,

`last_visit_date` DATETIME REPLACE DEFAULT “1970-01-01 00:00:00” COMMENT “用户最后一次访问时间”,

`cost` BIGINT SUM DEFAULT “0” COMMENT “用户总消费”,

`max_dwell_time` INT MAX DEFAULT “0” COMMENT “用户最大停留时间”,

`min_dwell_time` INT MIN DEFAULT “99999” COMMENT “用户最小停留时间”

)

AGGREGATE KEY(`user_id`, `date`, `city`, `age`, `sex`)

DISTRIBUTED BY HASH**(`user_id`)** BUCKETS 10**;**

2

查看表的结构信息

desc site_visit all;

3

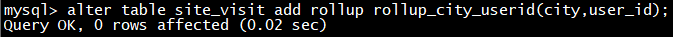

比如需要查看某个城市的user_id数,那么可以建立一个只有user_id和city的rollup

alter table site_visit add rollup rollup_city_userid**(city,user_id);**

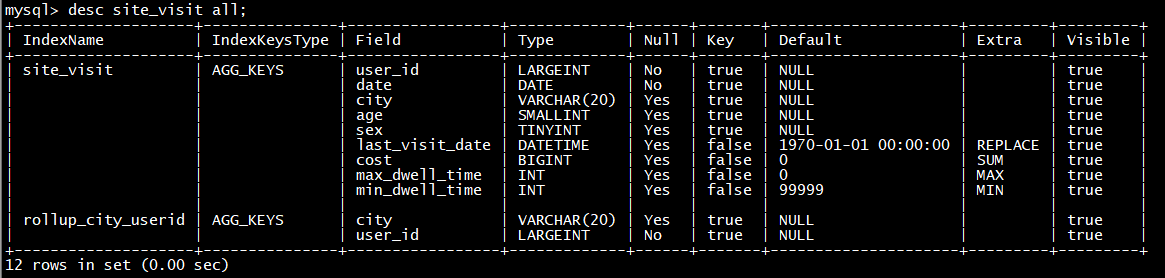

4

查看表的结构信息

desc site_visit all;

5

然后可以通过explain查看执行计划,是否使用到了rollup

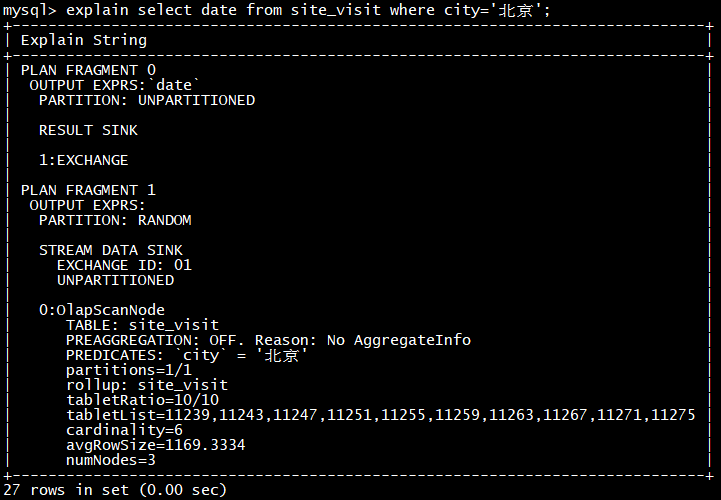

explain select date from site_visit where city=‘北京’;

Doris 会自动命中这个 ROLLUP 表,从而只需扫描极少的数据量,即可完成这次聚合查询。

6

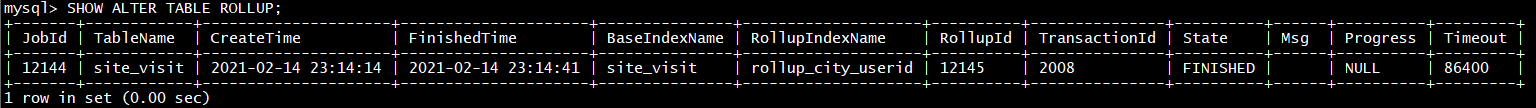

通过命令查看完成状态

SHOW ALTER TABLE ROLLUP;

- Doris索引是固定的前缀索引,用rollup改变索引顺序

因为建表时已经指定了列顺序,所以一个表只有一种前缀索引。这对于使用其他不能命中前缀索引的列作为条件进行的查询来说,效率上可能无法满足需求。因此,我们可以通过创建 ROLLUP 来人为的调整列顺序。

Base 表结构如下:

列名

类型

user_id

BIGINT

age

INT

message

VARCHAR(100)

max_dwell_time

DATETIME

min_dwell_time

DATETIME

我们可以在此基础上创建一个 ROLLUP 表:

列名

类型

age

INT

user_id

BIGINT

message

VARCHAR(100)

max_dwell_time

DATETIME

min_dwell_time

DATETIME

可以看到,ROLLUP 和 Base 表的列完全一样,只是将 user_id 和 age 的顺序调换了。那么当我们进行如下查询时:

SELECT * FROM table where age**=20 and message LIKE “%error%”;**

会优先选择 ROLLUP 表,因为 ROLLUP 的前缀索引匹配度更高。

Aggregate 和 Uniq 模型中的 ROLLUP

因为 Uniq 只是 Aggregate 模型的一个特例,所以这里我们不加以区别。

- 示例1:获得每个用户的总消费

接Aggregate 模型小节的示例2,Base 表结构如下:

可以看到,ROLLUP 中仅保留了每个 user_id,在 cost 列上的 SUM 的结果。那么当我们进行如下查询时:

SELECT user_id**,** sum(cost) FROM table GROUP BY user_id**;**

Doris 会自动命中这个 ROLLUP 表,从而只需扫描极少的数据量,即可完成这次聚合查询。

- 示例2:获得不同城市,不同年龄段用户的总消费、最长和最短页面驻留时间

紧接示例1。我们在 Base 表基础之上,再创建一个 ROLLUP:

当我们进行如下这些查询时:

SELECT city**,** age**,** sum(cost), max(max_dwell_time), min(min_dwell_time) FROM table GROUP BY city**,** age**;**

SELECT city**,** sum(cost), max(max_dwell_time), min(min_dwell_time) FROM table GROUP BY city**;**

SELECT city**,** age**,** sum(cost), min(min_dwell_time) FROM table GROUP BY city**,** age**;**

Doris 会自动命中这个 ROLLUP 表。

Duplicate 模型中的 ROLLUP

前缀索引

不同于传统的数据库设计,Doris 不支持在任意列上创建索引。Doris 这类 MPP 架构的 OLAP 数据库,通常都是通过提高并发,来处理大量数据的。

本质上,Doris 的数据存储在类似 SSTable(Sorted String Table)的数据结构中。该结构是一种有序的数据结构,可以按照指定的列进行排序存储。在这种数据结构上,以排序列作为条件进行查找,会非常的高效。‘’

在 Aggregate、Uniq 和 Duplicate 三种数据模型中。底层的数据存储,是按照各自建表语句中,AGGREGATE KEY、UNIQ KEY 和 DUPLICATE KEY 中指定的列进行排序存储的。

而前缀索引,即在排序的基础上,实现的一种根据给定前缀列,快速查询数据的索引方式。

我们将一行数据的前 36 个字节 作为这行数据的前缀索引。当遇到 VARCHAR 类型时,前缀索引会直接截断。我们举例说明:

当我们的查询条件,是前缀索引的前缀时,可以极大的加快查询速度。比如在第一个例子中,我们执行如下查询:

SELECT * FROM table WHERE user_id**=1829239 and age=**20;

该查询的效率会远高于如下查询:

SELECT * FROM table WHERE age**=**20;

所以在建表时,正确的选择列顺序,能够极大地提高查询效率。

ROLLUP 调整前缀索引

因为建表时已经指定了列顺序,所以一个表只有一种前缀索引。这对于使用其他不能命中前缀索引的列作为条件进行的查询来说,效率上可能无法满足需求。因此,我们可以通过创建 ROLLUP 来人为的调整列顺序。举例说明。

可以看到,ROLLUP 和 Base 表的列完全一样,只是将 user_id 和 age 的顺序调换了。那么当我们进行如下查询时:

SELECT * FROM table where age**=20 and message LIKE “%error%”;**

会优先选择 ROLLUP 表,因为 ROLLUP 的前缀索引匹配度更高。

聚合模型的局限性

这里我们针对 Aggregate 模型(包括 Uniq 模型),来介绍下聚合模型的局限性。

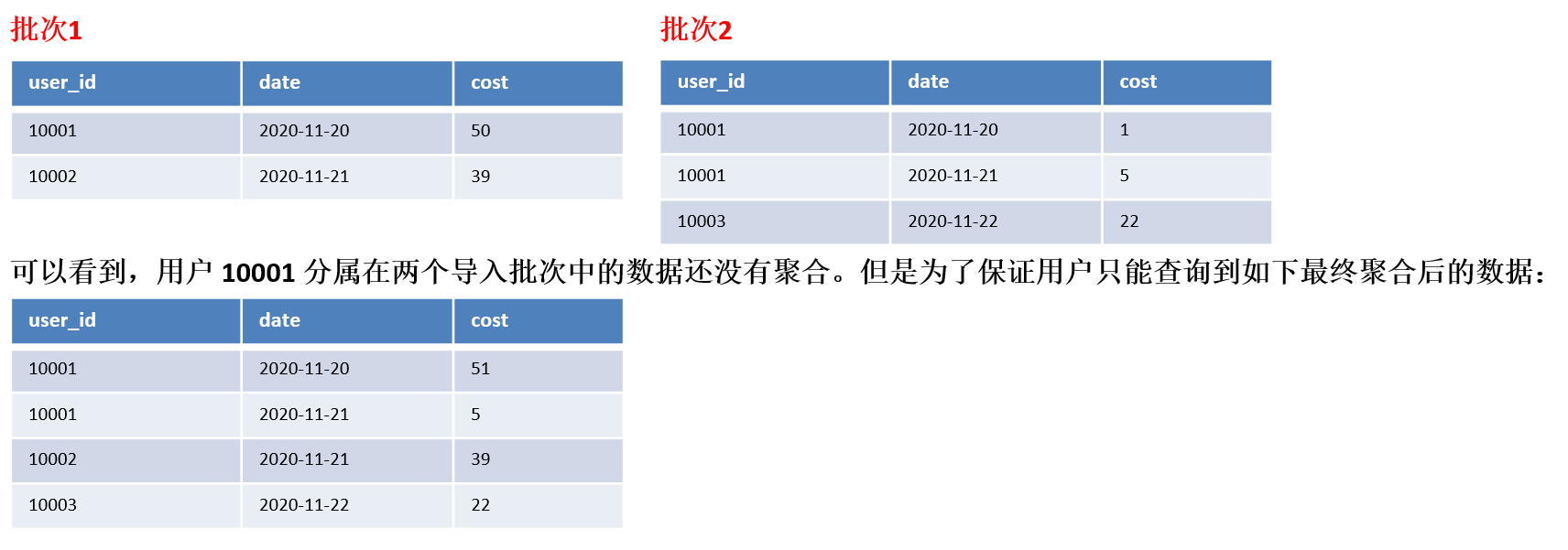

在聚合模型中,模型对外展现的,是最终聚合后的数据。也就是说,任何还未聚合的数据(比如说两个不同导入批次的数据),必须通过某种方式,以保证对外展示的一致性。我们举例说明。

我们在查询引擎中加入了聚合算子,来保证数据对外的一致性。

另外,在聚合列(Value)上,执行与聚合类型不一致的聚合类查询时,要注意语意。比如我们在如上示例中执行如下查询:

SELECT MIN(cost) FROM table;

得到的结果是 5,而不是 1。

同时,这种一致性保证,在某些查询中,会极大的降低查询效率。

我们以最基本的 count(*) 查询为例:

SELECT COUNT(*) FROM table;

在其他数据库中,这类查询都会很快的返回结果。因为在实现上,我们可以通过如“导入时对行进行计数,保存count的统计信息”,或者在查询时“仅扫描某一列数据,获得count值”的方式,只需很小的开销,即可获得查询结果。但是在 Doris 的聚合模型中,这种查询的开销非常大。

我们以刚才的数据为例:

所以,select count(*) from table; 的正确结果应该为 4。但如果我们只扫描 user_id 这一列,如果加上查询时聚合,最终得到的结果是 3(10001, 10002, 10003)。而如果不加查询时聚合,则得到的结果是 5(两批次一共5行数据)。可见这两个结果都是不对的。

为了得到正确的结果,我们必须同时读取 user_id 和 date 这两列的数据,再加上查询时聚合,才能返回 4 这个正确的结果。也就是说,在 count(*) 查询中,Doris 必须扫描所有的 AGGREGATE KEY 列(这里就是 user_id 和 date),并且聚合后,才能得到语意正确的结果。当聚合列非常多时,count(*) 查询需要扫描大量的数据。

因此,当业务上有频繁的 count(*) 查询时,我们建议用户通过增加一个值恒为 1 的,聚合类型为 SUM 的列来模拟 count(*)。如刚才的例子中的表结构,我们修改如下:

Duplicate 模型没有聚合模型的这个局限性。因为该模型不涉及聚合语意,在做 count(*) 查询时,任意选择一列查询,即可得到语意正确的结果。

ROLLUP 的几点说明

- ROLLUP 最根本的作用是提高某些查询的查询效率(无论是通过聚合来减少数据量,还是修改列顺序以匹配前缀索引)。因此 ROLLUP 的含义已经超出了 “上卷” 的范围。这也是为什么我们在源代码中,将其命名为 Materialized Index(物化索引)的原因。

- ROLLUP 是附属于 Base 表的,可以看做是 Base 表的一种辅助数据结构。用户可以在 Base 表的基础上,创建或删除 ROLLUP,但是不能在查询中显式的指定查询某 ROLLUP。是否命中 ROLLUP 完全由 Doris 系统自动决定。

- ROLLUP 的数据是独立物理存储的。因此,创建的 ROLLUP 越多,占用的磁盘空间也就越大。同时对导入速度也会有影响(导入的ETL阶段会自动产生所有 ROLLUP 的数据),但是不会降低查询效率(只会更好)。

- ROLLUP 的数据更新与 Base 表示完全同步的。用户无需关心这个问题。

- ROLLUP 中列的聚合方式,与 Base 表完全相同。在创建 ROLLUP 无需指定,也不能修改。

- 查询能否命中 ROLLUP 的一个必要条件(非充分条件)是,查询所涉及的所有列(包括 select list 和 where 中的查询条件列等)都存在于该 ROLLUP 的列中。否则,查询只能命中 Base 表。

- 某些类型的查询(如 count(*))在任何条件下,都无法命中 ROLLUP。具体参见接下来的 聚合模型的局限性 一节。

- 可以通过 EXPLAIN your_sql; 命令获得查询执行计划,在执行计划中,查看是否命中 ROLLUP。

- 可以通过 DESC tbl_name ALL; 语句显示 Base 表和所有已创建完成的 ROLLUP。

物化视图

物化视图是将预先计算(根据定义好的 SELECT 语句)好的数据集,存储在 Doris 中的一个特殊的表。

物化视图的出现主要是为了满足用户,既能对原始明细数据的任意维度分析,也能快速的对固定维度进行分析查询。

首先,什么是物化视图?

从定义上来说,就是包含了查询结果的数据库对象,可能是对远程数据的本地Copy;也可能是一个表或多表Join后结果的行或列的子集;也可能是聚合后的结果。说白了,就是预先存储查询结果的一种数据库对象。

适用场景

- 分析需求覆盖明细数据查询以及固定维度查询两方面。

- 查询仅涉及表中的很小一部分列或行。

- 查询包含一些耗时处理操作,比如:时间很久的聚合操作等。

- 查询需要匹配不同前缀索引。

优势

-

对于那些经常重复的使用相同的子查询结果的查询性能大幅提升。

-

Doris自动维护物化视图的数据,无论是新的导入,还是删除操作都能保证base 表和物化视图表的数据一致性。无需任何额外的人工维护成本。

-

查询时,会自动匹配到最优物化视图,并直接从物化视图中读取数据。

-

自动维护物化视图的数据会造成一些维护开销,会在后面的物化视图的局限性中展开说明。

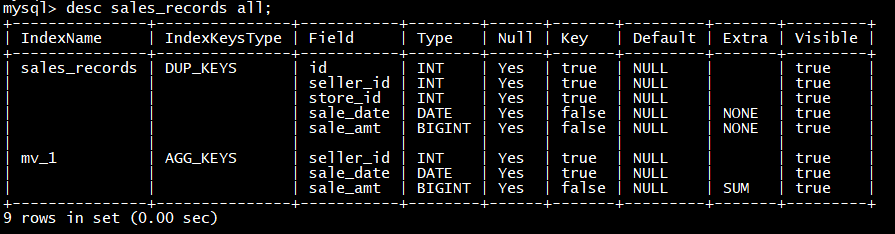

物化视图 VS Rollup

在没有物化视图功能之前,用户一般都是使用 Rollup 功能通过预聚合方式提升查询效率的。但是 Rollup 具有一定的局限性,他不能基于明细模型做预聚合。

物化视图则在覆盖了 Rollup 的功能的同时,还能支持更丰富的聚合函数。所以物化视图其实是 Rollup 的一个超集。

也就是说,之前 ALTER TABLE ADD ROLLUP 语法支持的功能现在均可以通过 CREATE MATERIALIZED VIEW 实现。

使用物化视图

Doris 系统提供了一整套对物化视图的 DDL 语法,包括创建,查看,删除。DDL 的语法和 PostgreSQL, Oracle都是一致的。

创建物化视图

这里首先你要根据你的查询语句的特点来决定创建一个什么样的物化视图。这里并不是说你的物化视图定义和你的某个查询语句一模一样就最好。这里有两个原则:

- 从查询语句中抽象出,多个查询共有的分组和聚合方式作为物化视图的定义。

- 不需要给所有维度组合都创建物化视图。

首先第一个点,一个物化视图如果抽象出来,并且多个查询都可以匹配到这张物化视图。这种物化视图效果最好。因为物化视图的维护本身也需要消耗资源。

如果物化视图只和某个特殊的查询很贴合,而其他查询均用不到这个物化视图。则会导致这张物化视图的性价比不高,既占用了集群的存储资源,还不能为更多的查询服务。

所以用户需要结合自己的查询语句,以及数据维度信息去抽象出一些物化视图的定义。

第二点就是,在实际的分析查询中,并不会覆盖到所有的维度分析。所以给常用的维度组合创建物化视图即可,从而到达一个空间和时间上的平衡。

通过下面命令就可以创建物化视图了。创建物化视图是一个异步的操作,也就是说用户成功提交创建任务后,Doris 会在后台对存量的数据进行计算,直到创建成功。

CREATE MATERIALIZED VIEW