K8s

中所有的内容都抽象为资源,资源实例化为对象。

集群资源的分类

名称空间级别

工作负载型资源( workload

):Pod

、ReplicaSet

、Deployment

、StatefulSet

、DaemonSet、Job

、CronJob

(ReplicationController

在v1.11

版本被废弃 )服务发现及负载均衡型资源( ServiceDiscovery LoadBalance

):Service

、Ingress

、...配置与存储型资源: Volume

( 存储卷 )、CSI

( 容器存储接口,可以扩展各种各样的第三方存储卷 )特殊类型的存储卷: ConfigMap

( 当配置中心来使用的资源类型 )、Secret

(保存敏感数据)、DownwardAPI

(把外部环境中的信息输出给容器)

集群级别

一旦定义在集群内都可见。

Namespace

, Node

, Role

, ClusterRole

, RoleBindiing

, ClusterRoleBinding

元数据型

HPA

、PodTemplate

、LimitRange

在k8s

中,一般使用 yaml

格式的文件来创建符合我们预期期望的pod

, 这样的 yaml

文件,我们一般成为 资源清单。

apiVersion

:String

,K8s Api

的版本,可以用kubectl api-versions

命令查询kind

:String

,yaml

定义的资源类型和角色metadata

:Object

, 元数据对象,固定值就写metadataname

: 元数据对象的名称namespace

: 元数据对象的命名空间,有我们自身定义spec

:Object

详细定义对象,固定值是Spec1. Always

:Pod

一旦终止运行,则无论容器是否终止,kubelet

服务都将重启它。2、 OnFailure

: 只有Pod

以非0

退出码终止时,kubelet

才会重启该容器,如果容器正常结束,则不会重启3、 Never

.Pod

终止后,kubelet

将退出码报告给Master

,不会重启Pod

.name

:String

, 这里是定义容器的名字image

:String

, 这里定义要用到的镜像名称imagePullPolicy

:String

, 定义镜像拉取策略,有Always

,Never

,IfNotPresent

, 三个值。默认是Always

.command[]

,List

, 容器启动命令,因为是数据可以指定多个,不指定则使用镜像打包时使用的启动命令args

:List,

指定容器启动的命令参数,可以指定多个workingDir

:String

, 指定容器的工作目录volumeMountsp[]

,List

: 指定容器内部的存储卷配置ports[]

,List<Object>

,指定容器使用的端口列表env[]

:List<Object>

,指定容器运行前需要设置的环境变量列表resources

:Object

, 指定资源限制和资源请求的值1、 Always

: 每次都尝试拉取镜像2、 Never

: 表示仅使用本地镜像3、 IfNotPresent

: 如果本地有镜像就使用本地镜像,没有就拉取在线镜像。name

:String

, 指定可以挂载的存储卷的名称mountPath

,String

, 指定可以被容器挂载的存储卷的路径readOnly

,String

, 设置存储卷路径的读写模型,true

或者false

.name

:String

, 端口名称containerPort

:String

, 容器你需要监听的端口号hostPort

:String

, 指定容器所在主机需要监听的端口号, 默认跟上面containerPort

相同, 注意设置了hostPort

同一台主机无法启动该容器的相同副本protocol

:String

, 指定端口协议,支持TCP

,UDP

, 默认是TCPname

:String

, 环境变量名称value

:String

, 环境变量值cpu

:m

,CPU

请求. 单位为core

数,容器启动时初始化可用数量memory

:String

, 内存请求, 单位MIB

,Gib

, 容器启动的初始化可用数量cpu

:String

,CPU

的限制, 单位为core

数, 将用于docker run --cpu-shares

参数。memory

:String

,Mem

内存的限制,单位为MIB

,GiBlimits

: 设置容器运行时的资源的运行上限requests

:Object

, 指定容器启动和调度时的限制设置containers[]

:list

类型, 这里是spec

对象的容器列表定义,是个列表restartPolicy

:String

, 定义Pod的重启策略, 可选值是Always

,OnFailure

, 默认值是Always

.nodeSelector

:Object

, 定义Node

的label

过滤标签,以key

,value

的格式指定。imagePullSecrets

:Object

, 定义pull

镜像时使用Secret名称, 以name:secretKey

格式指定hostNetwork

:Boolean

, 定义是否使用主机网络,默认值为false

,设置为true

表示使用宿主机网络, 不使用docker

网桥,同时设置了true

将无法在同一台宿主机上启动第二个副本。

可以通过下面的命令实时查看 yaml 的配置内容

kubectl explain pod.

案例

通过资源清单创建一个pod.

apiVersion: v1

kind: Pod

metadata:

name: sample-demo

namespace: default

labels:

app: myapp

spec:

containers:

- name: my-app

image: fangjiaxiaobai/my-app:v1

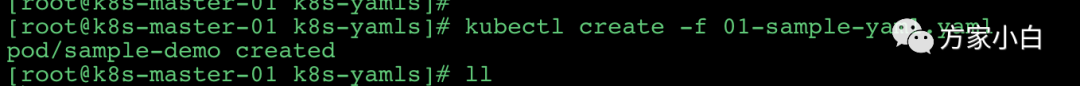

使用 kubectl create -f 01-sample-yaml.yaml

创建

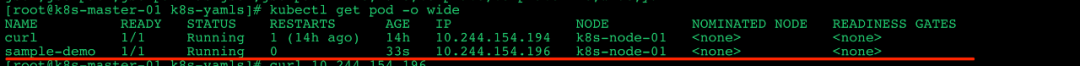

使用命令 kubectl get pods -o wide

查看下pod

的ip

和 状态:

然后使用 curl 10.244.154.195

可以看到

正常返回了 Nginx

的首页信息。

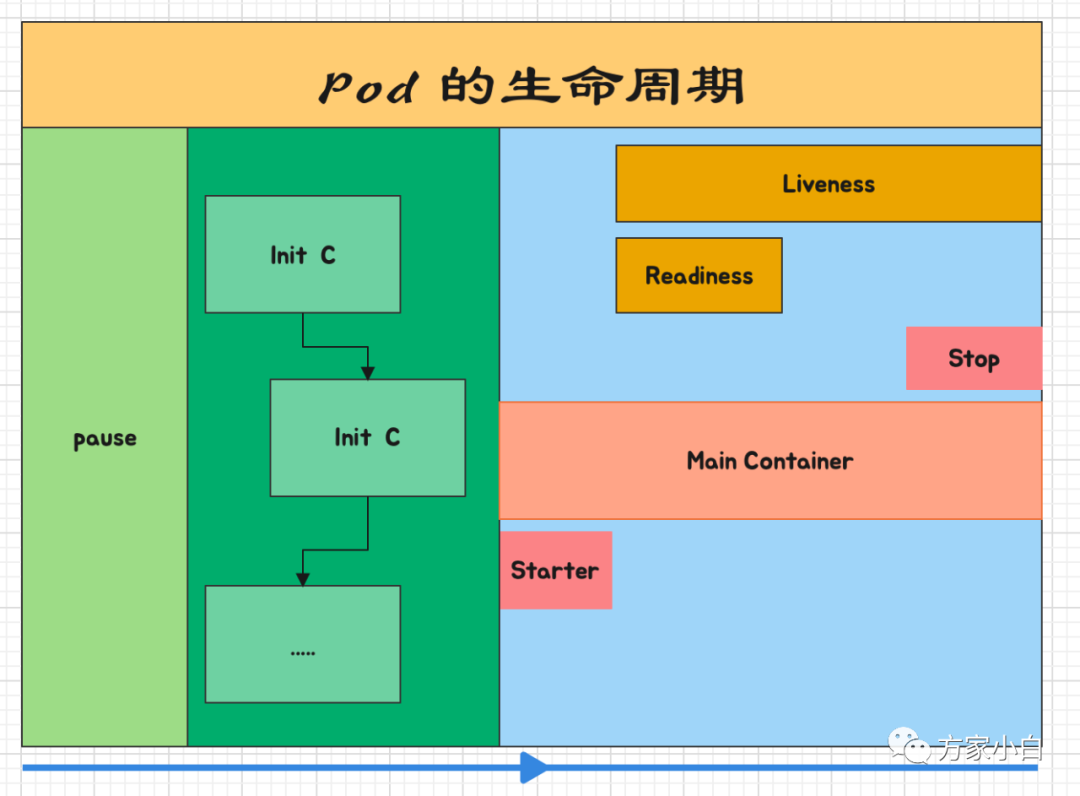

Pod

的生命周期

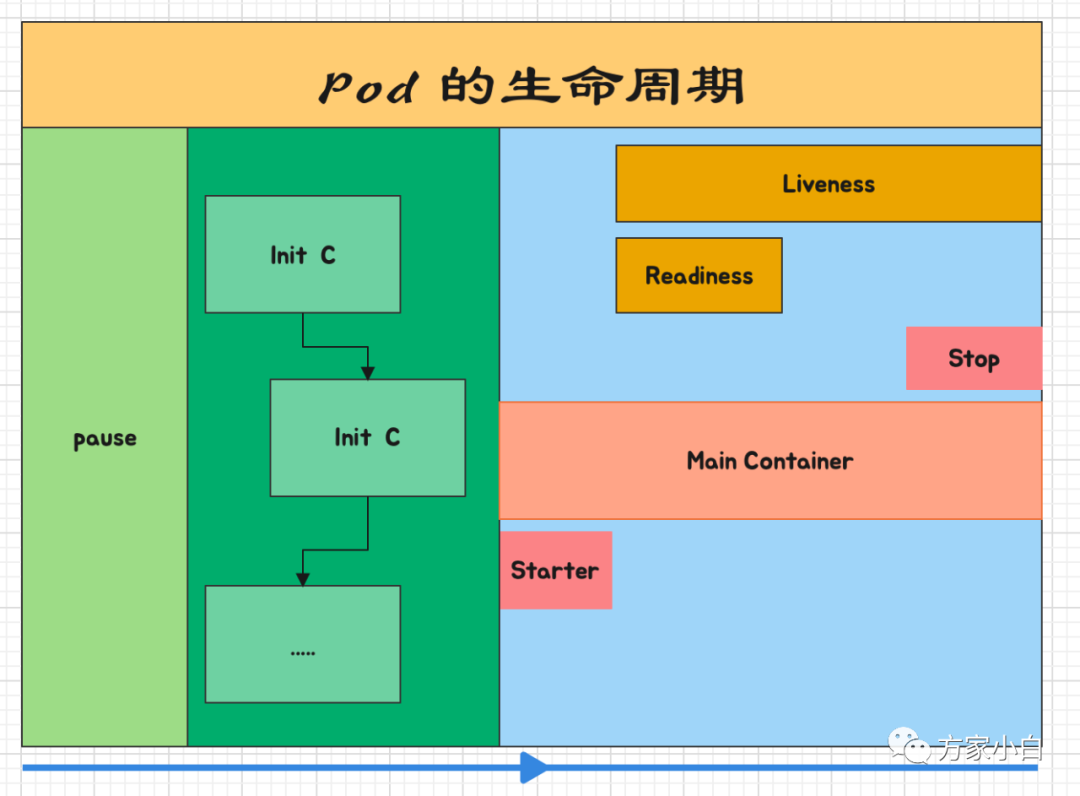

如上图, pod

的启动过程是: pod

创建时会首先创建一个 pause

容器. 然后执行创建多个 Init

容器, 然后再启动 主容器,也就是一般我们使用镜像创建起来的具有业务属性的容器,称为主容器。主容器会经历 Start->Running->Stop

,这些状态。

Pause 容器

从名字上看,pause

是一个"暂停"的容器, 它的作用是: 解决pod

的网络和存储的问题。pause

容器称为 Infra Container

, 其他的容器称为业务容器. Infra container

是一个非常小的镜像,大概 700KB

左右,是一个C

语言写的、永远处于“暂停”状态的容器。由于有了这样一个 Infra container

之后,其他所有容器都会通过 Join Namespace

的方式加入到 Infra container

的 Network Namespace

中。

Init 容器

Pod

能够具有多个容器,应用运行在容器里面,但是它也可能有一个或多个先于应用容器启动的Init

容器。Init

容器与普通的容器非常像,除了如下两点:

Init

容器总是运行到成功完成为止每个 Init

容器都必须在下一个Init

容器启动之前成功完成 如果Pod

的Init

容器失败,Kubernetes

Pod

,直到Init

容器成功为止。然而,如果Pod

对应的restartPolicy

为Never

,它不会重新启动

因为 Init

容器具有与应用程序容器分离的单独镜像,所以它们的启动相关代码具有如下优势:

它们可以包含并运行实用工具,但是出于安全考虑,是不建议在应用程序容器镜像中包含这 些实用工具的 它们可以包含使用工具和定制化代码来安装,但是不能出现在应用程序镜像中。例如,创建镜像没必要 FROM

另一个镜像,只需要在安装过程中使用类似sed

、awk

、python

或dig

这样的工具。应用程序镜像可以分离出创建和部署的角色,而没有必要联合它们构建一个单独的镜像。 Init

容器使用Linux Namespace

,所以相对应用程序容器来说具有不同的文件系统视图。因此,它们能够具有访问Secret

的权限,而应用程序容器则不能。它们必须在应用程序容器启动之前运行完成,而应用程序容器是并行运行的,所以 Init

容器能够提供了一种简单的阻塞或延迟应用容器的启动的方法,直到满足了一组先决条件。

init

小实验。

实验目的: init

容器会依次启动,只有 init

容器启动完成之后, 主容器才会启动.

实验步骤

创建 pod

.查看 pod

的状态变化查看 pod

中initC

的日志创建 Service-1查看 pod

的状态变化查看 pod

中initC

的日志创建 Service-2查看 pod

的状态变化查看 pod

中initC

的日志查看 pod

的日志

创建 pod

.

02-init-demo.yaml

apiVersion: v1

kind: Pod

metadata:

name: init-demo

labels:

app: init-app

spec:

containers:

- name: my-init-demo

image: fangjiaxiaobai/my-app:v1

command: ["sh", "-c", "echo the app is running! && sleep 3600"]

initContainers:

- name: init-myservice-1

image: busybox

command: ['sh', '-c', "until nslookup my-service-1; do echo 'waiting for my-service-1'; sleep 2; done;"]

- name: init-myservice-2

image: busybox

command: ['sh', '-c', "until nslookup my-service-2; do echo 'waiting for my-service-2'; sleep 2; done;"]

使用命令 kubectl create -f 02-init-demo.yaml

创建 pod

.

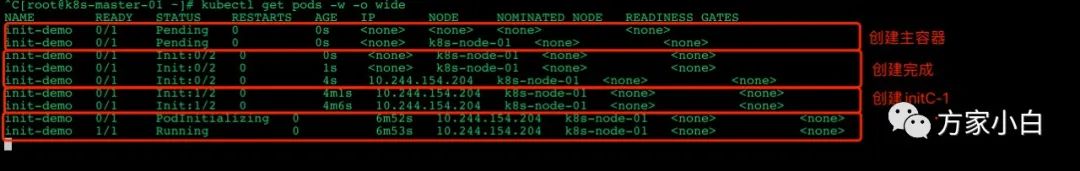

新开一个窗口使用 kubectl get pods -w -o wide

命令 查看 pod 的启动变化.

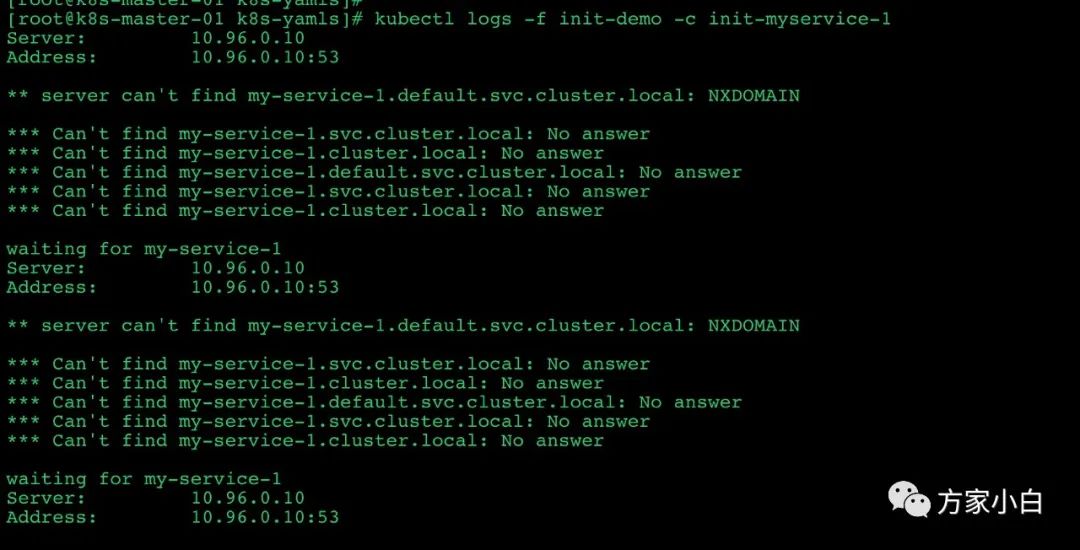

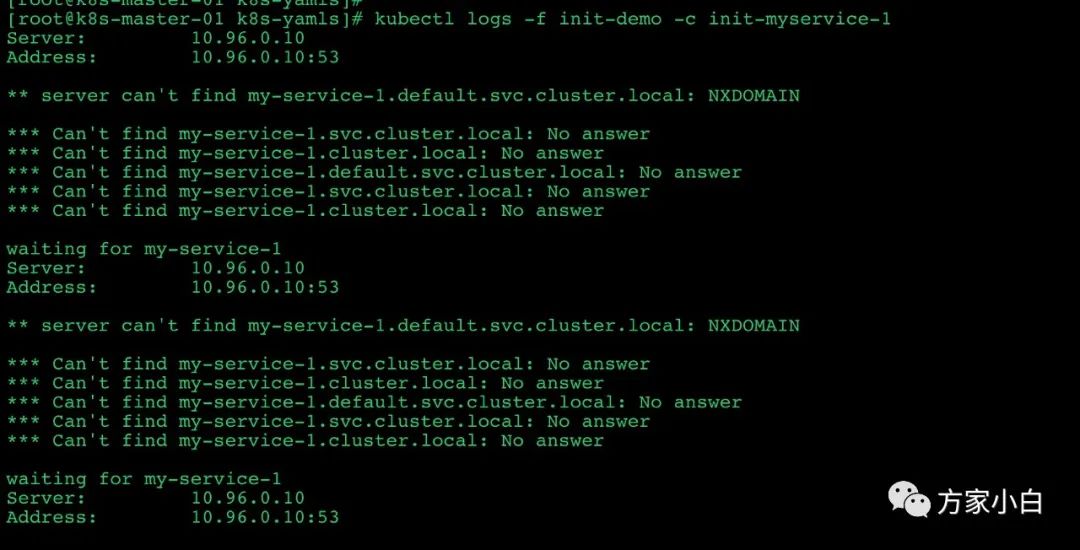

查看查看 pod

中init-c-1

的日志

发现 initC-1

一直在 nslookup

查找 my-service-1

.

创建 Service-1

02-init-demo-my-service-01.yaml

apiVersion: v1

kind: Service

metadata:

name: my-service-1

spec:

ports:

- protocol: TCP

port: 80

targetPort: 8080

使用命令 kubectl create -f 02-init-demo-my-service-01.yaml

查看 pod

中第一个 InitC

的日志

会出现

Server: 10.96.0.10

Address: 10.96.0.10:53

Name: my-service-1.default.svc.cluster.local

Address: 10.108.140.48

然后查看 pod

的状态. 会出现一条:

init-demo 0/1 Init:1/2 0 4m1s 10.244.154.204 k8s-node-01 <none> <none>

创建 Service-2

02-init-demo-my-service-02.yaml

apiVersion: v1

kind: Service

metadata:

name: my-service-2

spec:

ports:

- protocol: TCP

port: 80

targetPort: 8080

使用命令 kubectl create -f 02-init-demo-my-service-01.yaml

查看 pod

中第二个InitC

的日志直到出现

Server: 10.96.0.10

Address: 10.96.0.10:53

Name: my-service-2.default.svc.cluster.local

Address: 10.107.13.223

然后查看 pod

的状态. 会出现一条:

init-demo 0/1 PodInitializing 0 6m52s 10.244.154.204 k8s-node-01 <none> <none>

然后就会启动 pod

. 最终出现

init-demo 1/1 Running 0 6m53s 10.244.154.204 k8s-node-01 <none> <none>

然后查看 pod

的日志,会输出 the app is running.

[root@k8s-master-01 k8s-yamls]# kubectl logs -f init-demo

Defaulted container "my-init-demo" out of: my-init-demo, init-myservice-1 (init), init-myservice-2 (init)

the app is running!

关于init容器的特殊说明

在 Pod

启动过程中,Init

容器会按顺序在网络和数据卷初始化之后启动。每个容器必须在下一个容器启动之前成功退出如果由于运行时或失败退出,将导致容器启动失败,它会根据 Pod

的restartPolicy

指定的策略 进行重试。然而,如果Pod

的restartPolicy

设置为Always

,Init

容器失败时会使用RestartPolicy

策略在所有的 Init

容器没有成功之前,Pod

将不会变成Ready

状态。Init

容器的端口将不会在Service

中进行聚集。正在初始化中的Pod

处于Pending

状态,但应该会将Initializing

状态设置为true如果 Pod

重启,所有Init

容器必须重新执行对 Init

容器spec

的修改被限制在容器image

字段,修改其他字段都不会生效。更改Init

容器的image

字段,等价于重启该PodInit

容器具有应用容器的所有字段。除了readinessProbe

,因为Init

容器无法定义不同于完成 (completion

) 的就绪(readiness

)之外的其他状态。这会在验证过程中强制执行在 Pod

中的每个app

和Init

容器的名称必须唯一;与任何其它容器共享同一个名称,会在验证时抛出错误.

探针检测

探针是由 kubelet

对容器执行的定期诊断。要执行诊断,kubelet

调用由容器实现的 Handler

。有三种类型的处理程序:

ExecAction

:在容器内执行指定命令。如果命令退出时返回码为0

则认为诊断成功。TCPSocketAction

:对指定端口上的容器的IP

地址进行TCP

检查。如果端口打开,则诊断被认为是成功的。HTTPGetAction

:对指定的端口和路径上的容器的IP

地址执行HTTP Get

请求。如果响应的状态码大于等于200

且小于400

,则诊断被认为是成功的

每次探测都将获得以下三种结果之一:

成功:容器通过了诊断。 失败:容器未通过诊断。 未知:诊断失败,因此不会采取任何行动

探测的方式

livenessProbe

:指示容器是否正在运行。如果存活探测失败,则kubelet

会杀死容器,并且容器将受到其 重启策略 的影响。如果容器不提供存活探针,则默认状态为SuccessreadinessProbe

:指示容器是否准备好服务请求。如果就绪探测失败,端点控制器将从与Pod

匹配的所有Service

的端点中删除该Pod

的IP

地址。初始延迟之前的就绪状态默认为Failure

。如果容器不提供就绪探针,则默认状态为Success

Pod Hook

Pod hook

(钩子)是由 Kubernetes

管理的 kubelet

发起的,当容器中的进程启动前或者容器中的进程终止之前运行,这是包含在容器的生命周期之中。可以同时为 Pod

中的所有容器都配置 hook

Hook

的类型包括两种:

exec

:执行一段命令HTTP

:发送HTTP

请求

PodSpec

中有一个 restartPolicy

字段,可能的值为 Always

、OnFailure

和 Never

。默认为Always

。restartPolicy

适用于 Pod

中的所有容器。restartPolicy

仅指通过同一节点上的 kubelet

重新启动容器。失败的容器由 kubelet

以五分钟为上限的指数退避延迟(10秒

,20秒

,40秒

...)重新启动,并在成功执行十分钟后重置。如 Pod

文档 中所述,一旦绑定到一个节点,Pod

将永远不会重新绑定到另一个节点。

Pod phase

Pod

的 status

字段是一个 PodStatus

对象,PodStatus

中有一个 phase

字段。PodStatus

的相位(phase

)是 Pod

在其生命周期中的简单宏观概述。该阶段并不是对容器或 Pod

的综合汇总,也不是为了做为综合状态机Pod

相位的数量和含义是严格指定的。除了本文档中列举的状态外,不应该再假定 Pod

有其他的 phase

值

phase的值

挂起( Pending

):Pod

已被Kubernetes

系统接受,但有一个或者多个容器镜像尚未创建。等待时间包括调度Pod

的时间和通过网络下载镜像的时间,这可能需要花点时间运行中( Running

):该Pod

已经绑定到了一个节点上,Pod

中所有的容器都已被创建。至少有一个容器正在运行,或者正处于启动或重启状态成功( Succeeded

):Pod

中的所有容器都被成功终止,并且不会再重启失败( Failed

):Pod

中的所有容器都已终止了,并且至少有一个容器是因为失败终止。也就是说,容器以非0

状态退出或者被系统终止未知( Unknown

):因为某些原因无法取得Pod

的状态,通常是因为与Pod

所在主机通信失败

两个小实验。

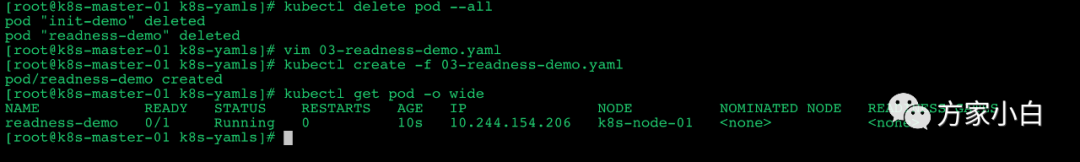

Readiness

03-readness-demo.yaml

apiVersion: v1

kind: Pod

metadata:

name: readness-demo

spec:

containers:

- name: readness-demo-container

image: fangjiaxiaobai/my-app:v1

imagePullPolicy: IfNotPresent

readinessProbe:

httpGet:

port: 80

path: /index.html

initialDelaySeconds: 1

periodSeconds: 3

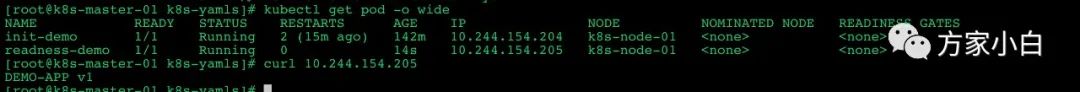

可以看到 readness-demo

正常启动成功,也已经ready

了。

下面删掉 readness-demo

这个pod

, 然后把 path:/index.html

改成 path:/index1.html

如下:

apiVersion: v1

kind: Pod

metadata:

name: readness-demo

spec:

containers:

- name: readness-demo-container

image: fangjiaxiaobai/my-app:v1

imagePullPolicy: IfNotPresent

readinessProbe:

httpGet:

port: 80

path: /index1.html

initialDelaySeconds: 1

periodSeconds: 3

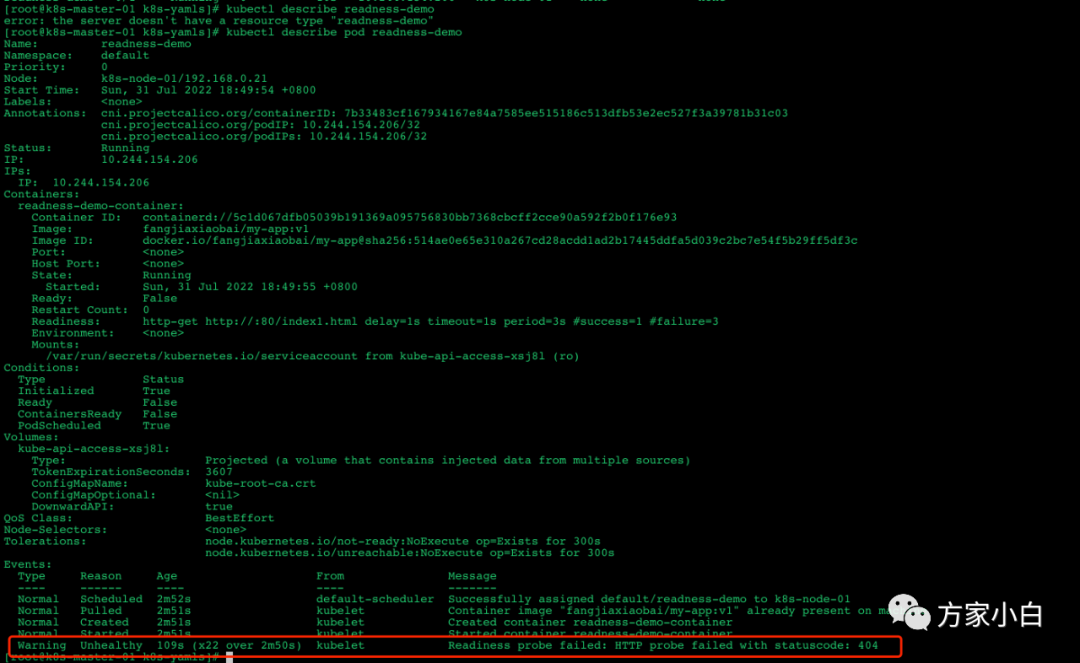

可以看到 ready: 0/1

, 我们可以查看一下 pod

的详细信息.

Readiness Failed

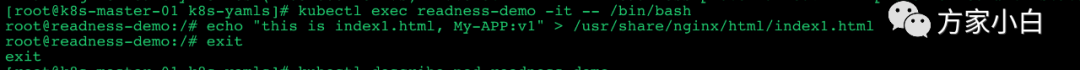

这时,我们进入容器中, 新建一个 index1.html

页面.

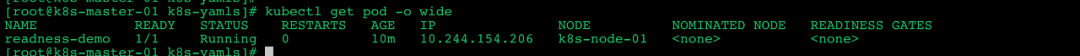

然后查看一下 pod

的状态。

Liveness

04-liveness-demo-exec.yaml

apiVersion: v1

kind: Pod

metadata:

name: liveness-demo

namespace: default

spec:

containers:

- name: liveness-demo-container

image: fangjiaxiaobai/my-app:v1

imagePullPolicy: IfNotPresent

command: ['/bin/sh', '-c', 'touch /tmp/live; sleep 20; rm -rf /tmp/live; sleep 3600;']

livenessProbe:

exec:

command: ['test', '-e', '/tmp/live']

initialDelaySeconds: 1

periodSeconds: 1

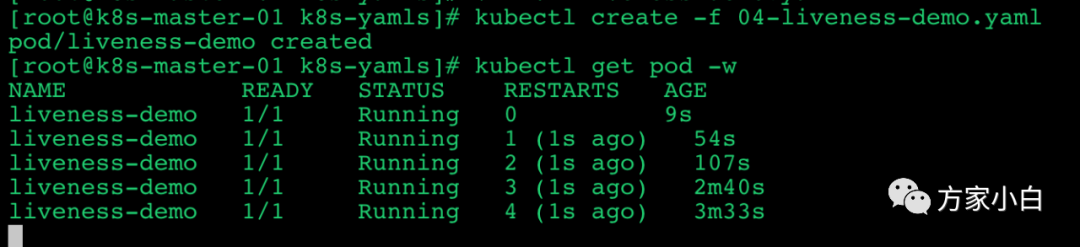

然后查看pod

的状态

04-liveness-httpGet-demo.yaml

apiVersion: v1

kind: Pod

metadata:

name: liveness-http-get-demo

namespace: default

spec:

containers:

- name: liveness-http-get-container

image: fangjiaxiaobai/my-app:v1

imagePullPolicy: IfNotPresent

ports:

- name: http-port

containerPort: 80

livenessProbe:

httpGet:

port: http-port

path: /index.html

initialDelaySeconds: 1

periodSeconds: 1

timeoutSeconds: 10

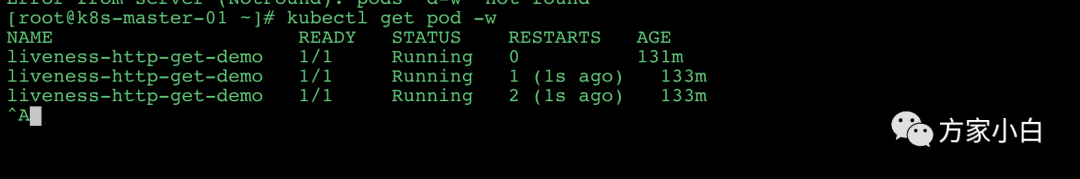

然后,我们删除index.html

kubectl exec liveness-http-get-demo -it -- rm -rf usr/share/nginx/html/index.html

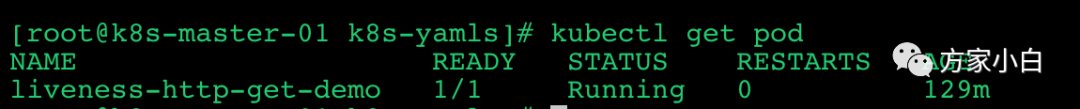

可以发现 pod 进行了重启。如下图(我删除了两次)

启动和停止

在pod的生命周期中, 我们讲完了 pause

, initC

, liveness

, readiness

. 还剩下 Starter

和 Stop

.

这个也比较简单,我通过下面这个实验来演示一下 pod 的启动和停止。

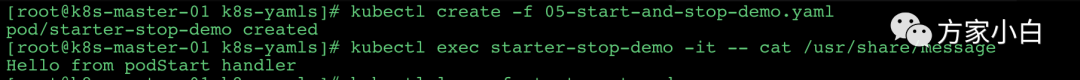

05-start-and-stop-demo.yaml

apiVersion: v1

kind: Pod

metadata:

name: starter-stop-demo

namespace: default

spec:

containers:

- name: stop-stop-demo-container

image: fangjiaxiaobai/my-app:v1

lifecycle:

postStart:

exec:

command: ['/bin/sh', '-c', 'echo Hello from podStart handler > /usr/share/message']

preStop:

exec:

command: ['/bin/sh', '-c', 'echo Bye from podStop handler']

然后查看一下 /usr/share/message

文件内容

当然,删除之后,这个容器我们就进不去了,但是我们知道了通过这种方式可以在 pod

的生命周期的各个阶段中做些操作。

ps: 以上所有 yaml 文件,可以在 https://github.com/fangjiaxiaobai/k8s/tree/main/yamls 中获取。

最后,点个关注,在看,点赞啊~~