为啥选它,王大拿有几点理由↓

而王大拿寻觅的这款全能型AI服务器,堪称业界最热的尖货!

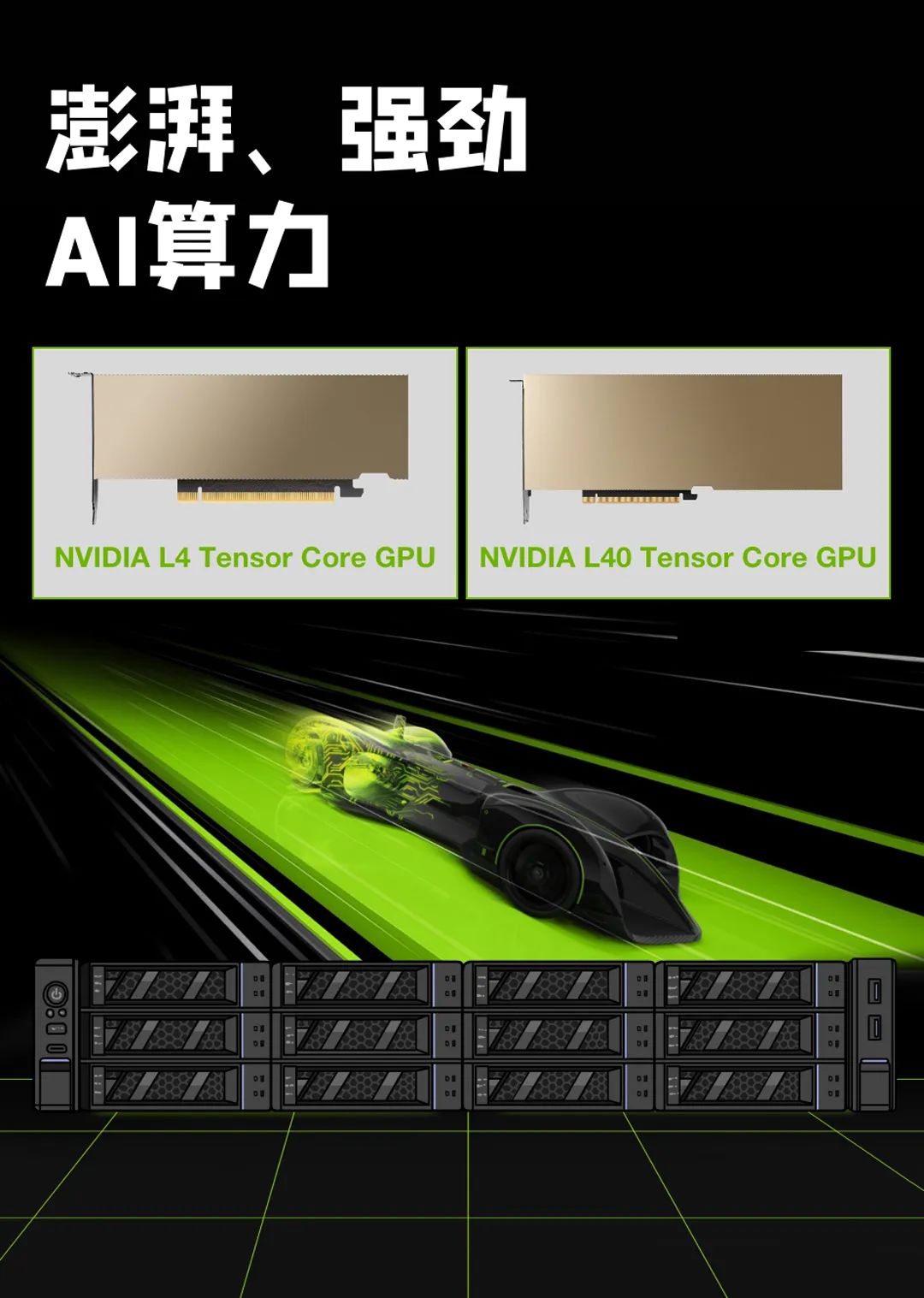

它率先支持2023 NVIDIA全新发布的两款GPU:NVIDIA L4 Tensor Core GPU和NVIDIA L40 Tensor Core GPU。

有这两款最新GPU加持,这款AI服务器自然如虎添翼。

于是,王大拿逢人就说,这AI服务器带给你的是“背推加速”感,好比之前开小面包,现在开法拉利。

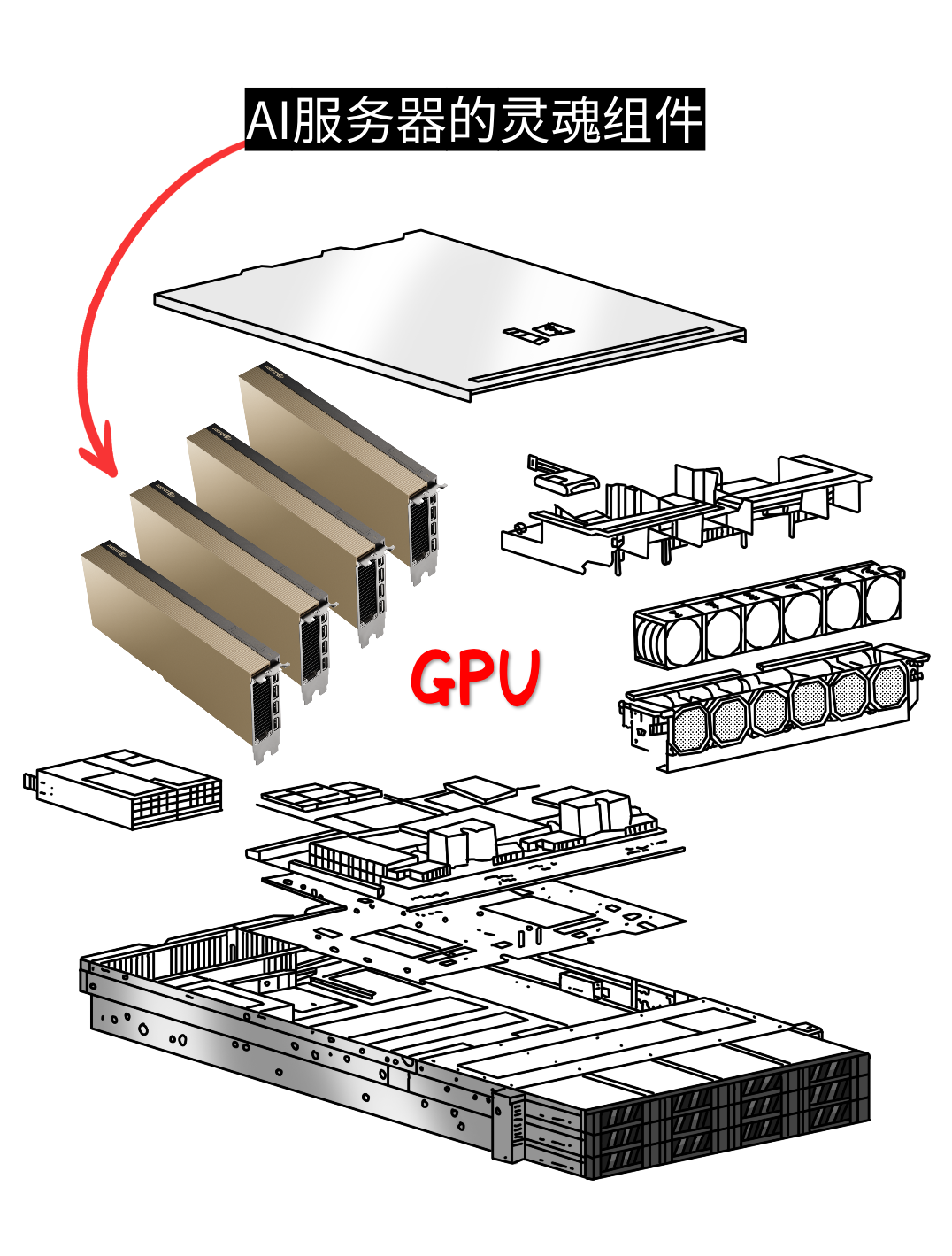

只因这款AI服务器配置极其灵活,支持多个GPU和加速卡,如果想要进阶,还可以组建一个分布式AI计算集群,这意味着具有更强的并行计算处理能力。

只因这款AI服务器配置极其灵活,支持多个GPU和加速卡,如果想要进阶,还可以组建一个分布式AI计算集群,这意味着具有更强的并行计算处理能力。这类客户大部分是互联网公司、云计算厂商,都是技术懂行人,完全忽悠不了,他们的需求实际得很:死磕性价比。

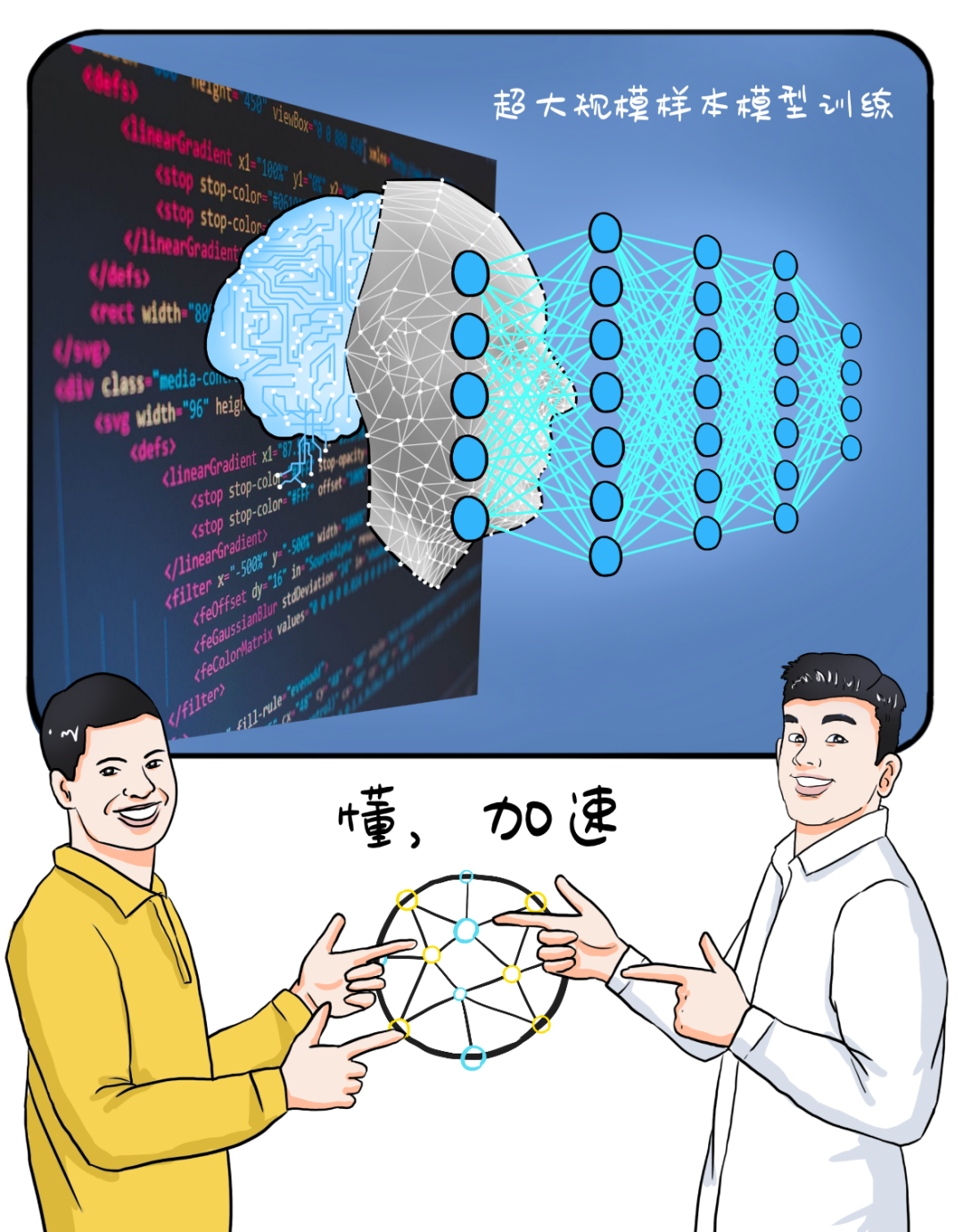

这类客户选择这款AI服务器,主要是为了构建更强大的云端AI计算和存储能力,为他们自己或者他们客户提供人工智能服务,比如,图像识别、自然语言处理、机器学习平台…

这类客户选择这款AI服务器,主要是为了构建更强大的云端AI计算和存储能力,为他们自己或者他们客户提供人工智能服务,比如,图像识别、自然语言处理、机器学习平台…像云渲染、仿真设计、工程设计、窗口柜台...,这类客户被云桌面“卡”怕了,他们诉求其实挺简单,就是要快,把3D类的处理卸载掉。

所以王大拿就会推荐这款AI服务器,构建更强“云主机”,以确保用户在远程桌面上进行各种计算任务时,能够得到快速和稳定的响应,并实现GPU虚拟化。

所以王大拿就会推荐这款AI服务器,构建更强“云主机”,以确保用户在远程桌面上进行各种计算任务时,能够得到快速和稳定的响应,并实现GPU虚拟化。

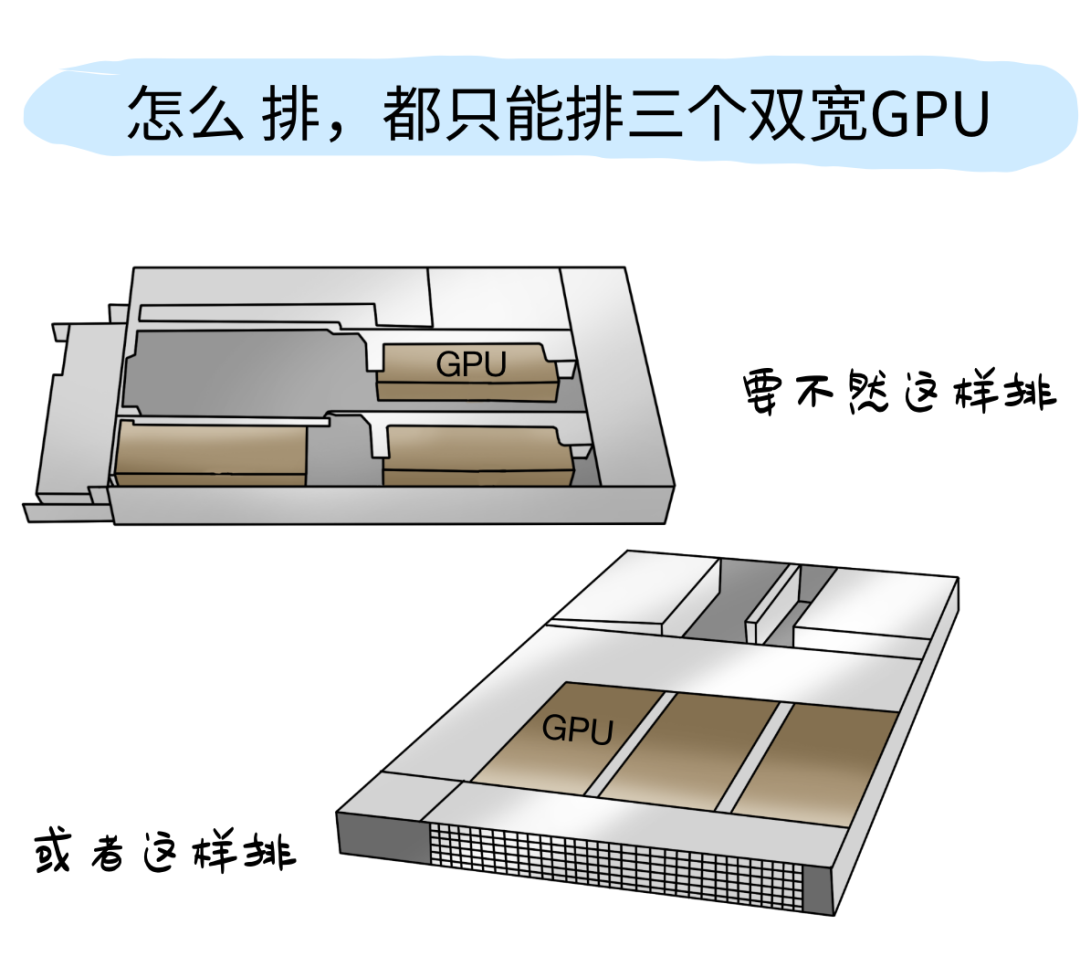

别家厂商不是不想多摆,而是↓

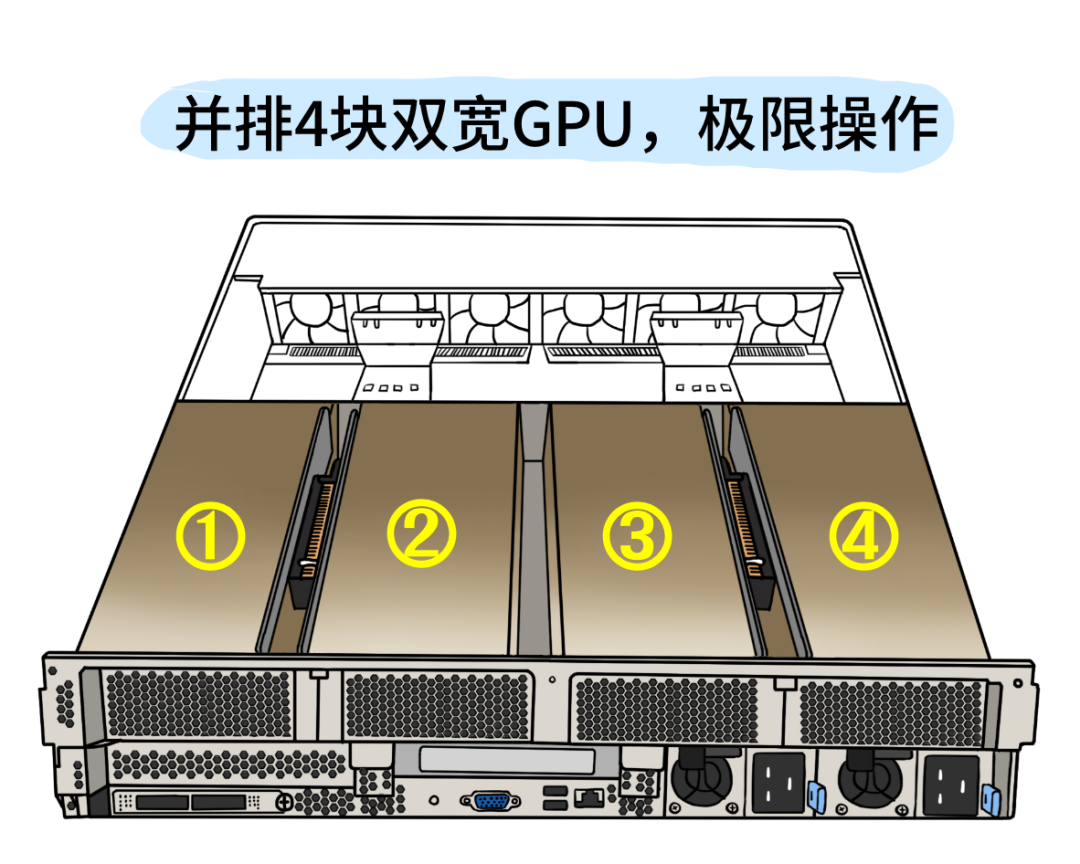

注:NVIDIA L40 Tensor Core GPU不含挡板的高度为110mm,4个GPU并列横摆,至少440mm,而这款AI服务器宽度仅为446mm,这个设计可以说是相当的极限操作了。

注:NVIDIA L40 Tensor Core GPU不含挡板的高度为110mm,4个GPU并列横摆,至少440mm,而这款AI服务器宽度仅为446mm,这个设计可以说是相当的极限操作了。

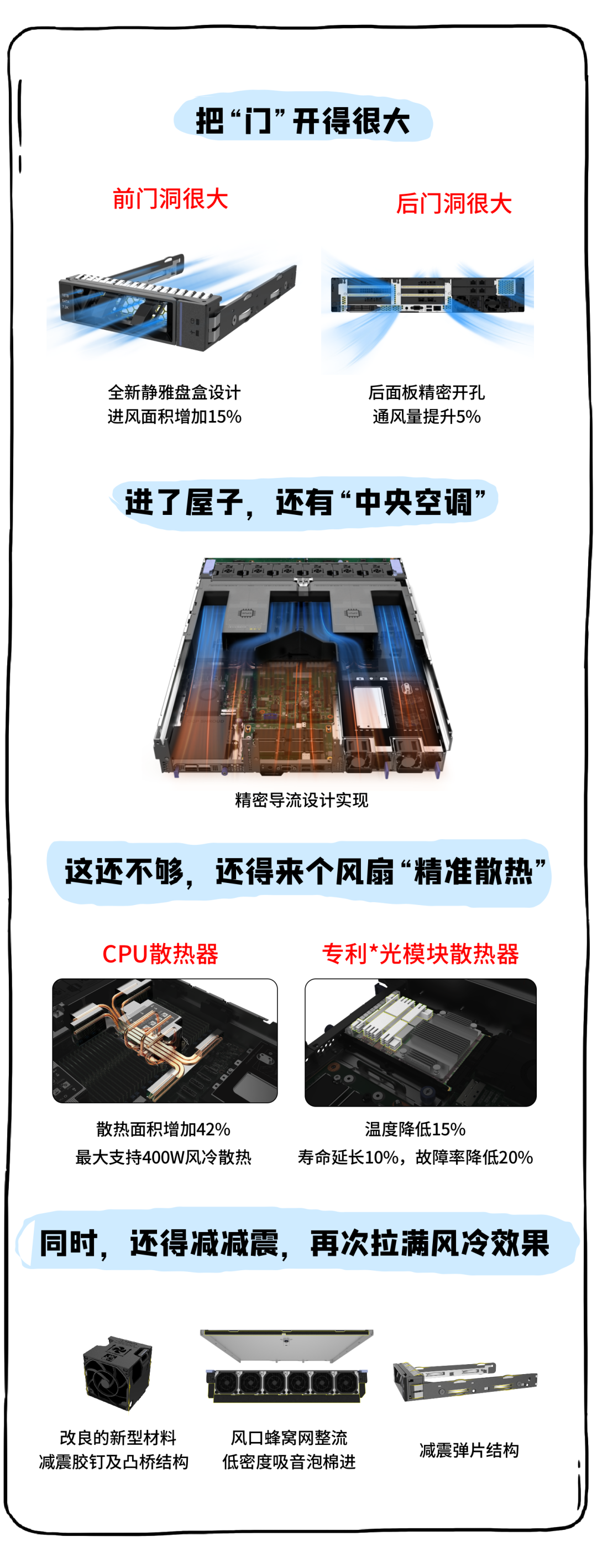

最终,风量提升30%,风压提升20%,震动降低5%,功耗降低15%,噪音降低10%。

该给大家揭谜底了

这么牛的「AI服务器」是哪家的

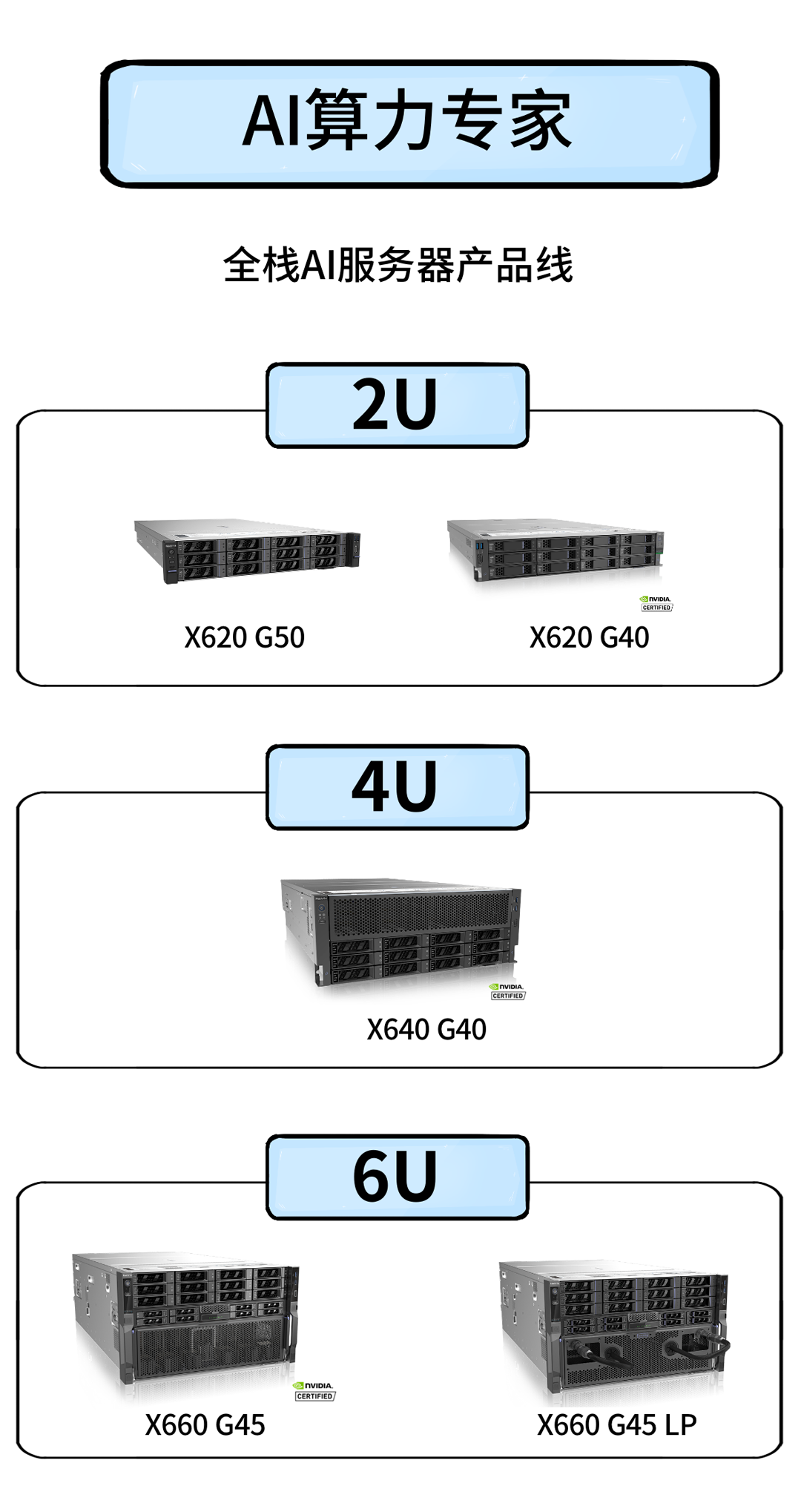

❶ 术有专攻,宁畅人称“AI算力专家”,江湖口碑极好,这个名号绝非浪得虚名。

▼

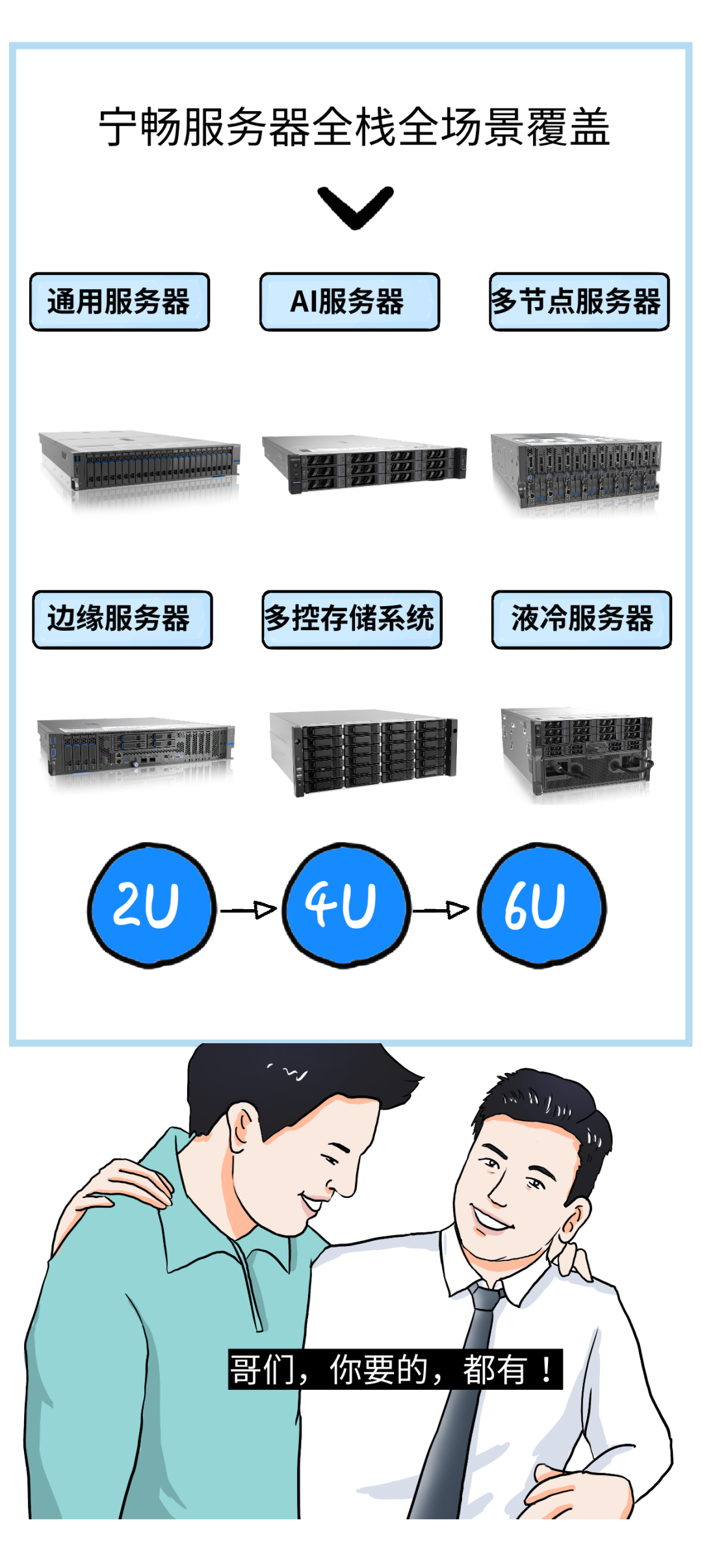

❷ 产品线齐全,性价比超高,卖他们产品,有“肉”吃

✓全产品形态覆盖:通用服务器、人工智能服务器、边缘服务器、多节点服务器、液冷产品方案

✓全节能需求覆盖:传统风冷、冷板式液冷、浸没式液冷

✓全场景覆盖:服务器级、机柜级、机房级、数据中心级

所以现在

一旦有人问王大拿服务器的行情

他就会自信满满地说

而当别人问王大拿AI服务器选型时

他也会斩钉截铁地

讲出自己的心头挚爱

↓

文章转载自特大号,如果涉嫌侵权,请发送邮件至:contact@modb.pro进行举报,并提供相关证据,一经查实,墨天轮将立刻删除相关内容。