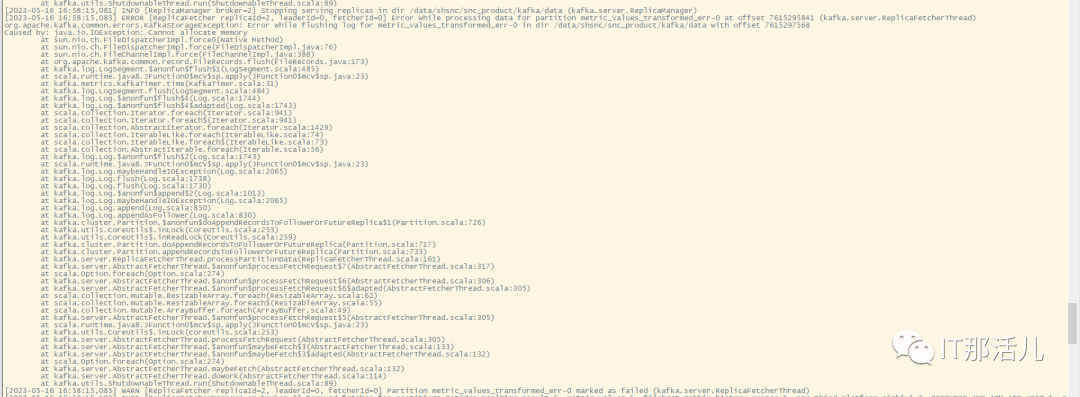

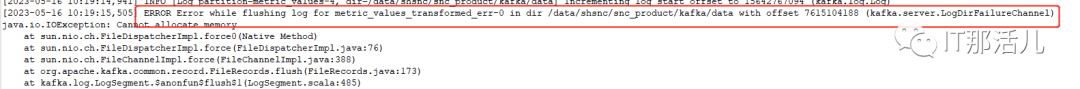

1. 启动kafka报错提示

Kafka/bin/kafka-server-start.sh

export KAFKA_HEAP_OPTS="-Xmx2G -Xms2G"

export KAFKA_HEAP_OPTS="-Xmx256M -Xms256M"

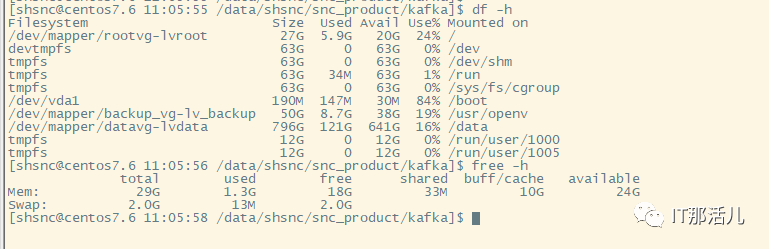

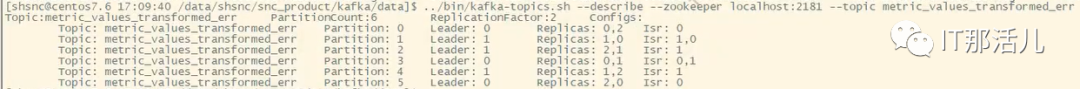

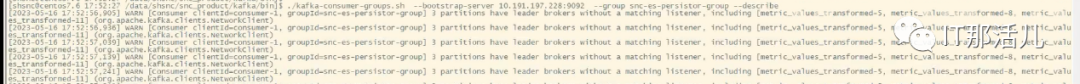

2. 查看Kafka分区数

kafka./bin/kafka-topics.sh --describe --zookeeper

localhost:2181 --topic metric_values_transformed_err

3. 尝试通过重新选举leader进行恢复

##为true时,producer像未存在的topic发送消息会自动创建topic,一般建议是false,不允许自动创建topic。

auto.create.topics.enable=false

unclean.leader.election.enable=true

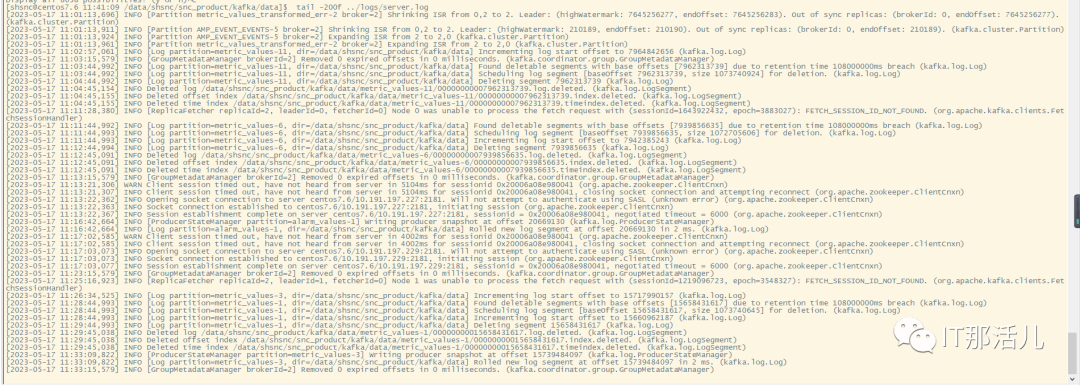

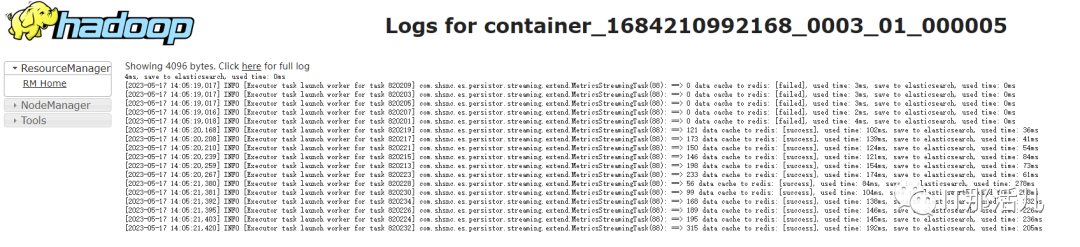

4. 查看消费topic的服务日志

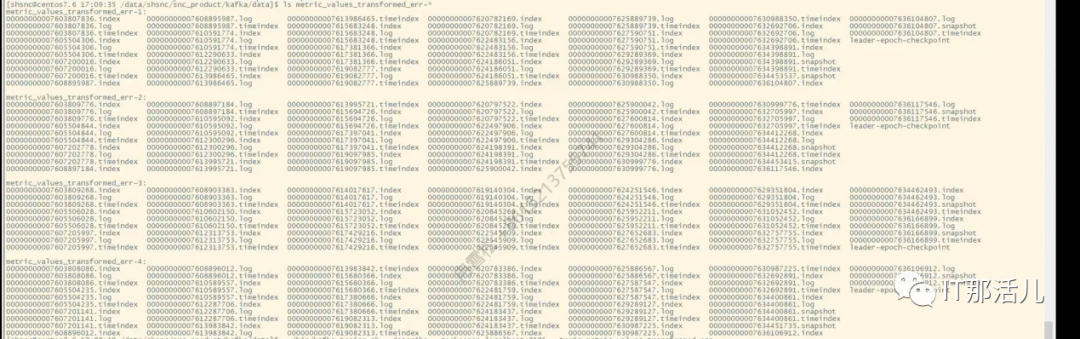

针对metric_values_transformed_err主题进行重新分配分区。 删除topic:metric_values_transformed_err,并重构topic:metric_values_transformed_err。

针对本次的topic分区损坏问题,我们选择了方案A进行处理。

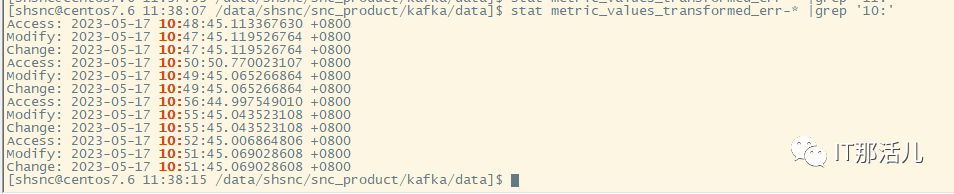

1. 针对metric_values_transformed_err主题进行重新分配分区

1)创建一个reassign.json的文件

vi reassign.json

{

"topics":[

{

"topic": "metric_values_transformed_err"

}

],

"version":1

}

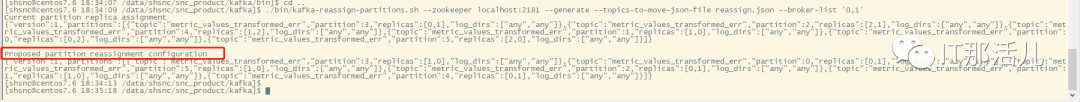

2)根据JSON文件和指定所要分配的broker节点列表来生成一份候选的重分配方案

kafka/bin/kafka-reassign-partitions.sh --zookeeper 、localhost:2181 --generate --topics-to-move-json-file reassign.json --broker-list '0,1,2'

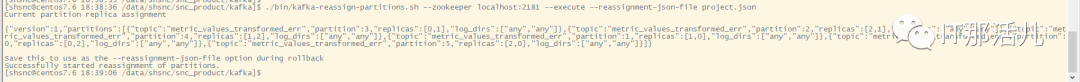

3)执行具体的分配动作

kafka/bin/kafka-reassign-partitions.sh --zookeeper

localhost:2181 --execute --reassignment-json-file project.json

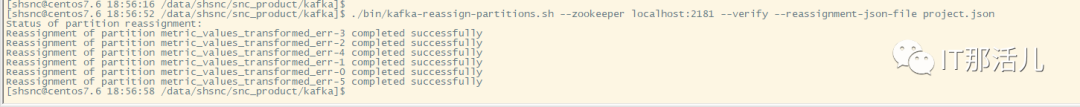

4)验证是否完成

kafka/bin/kafka-reassign-partitions.sh --zookeeper

localhost:2181 --verify --reassignment-json-file project.json

2. Kafka节点启动验证

本文作者:事业二部(上海新炬中北团队)

本文来源:“IT那活儿”公众号

文章转载自IT那活儿,如果涉嫌侵权,请发送邮件至:contact@modb.pro进行举报,并提供相关证据,一经查实,墨天轮将立刻删除相关内容。