2-Layer normalization 篇.pdf

5墨值下载

Layer normalization 篇

来自: AiGC面试宝典

宁静致远 2023年09月29日 12:37

Layer normalization-方法篇

一、Layer Norm 篇

1.1 Layer Norm 的计算公式写一下?

二、RMS Norm 篇 (均方根 Norm)

2.1 RMS Norm 的计算公式写一下?

2.2 RMS Norm 相比于 Layer Norm 有什么特点?

RMS Norm 简化了 Layer Norm ,去除掉计算均值进行平移的部分。

对比LN,RMS Norm的计算速度更快。效果基本相当,甚至略有提升。

三、Deep Norm 篇

3.1 Deep Norm 思路?

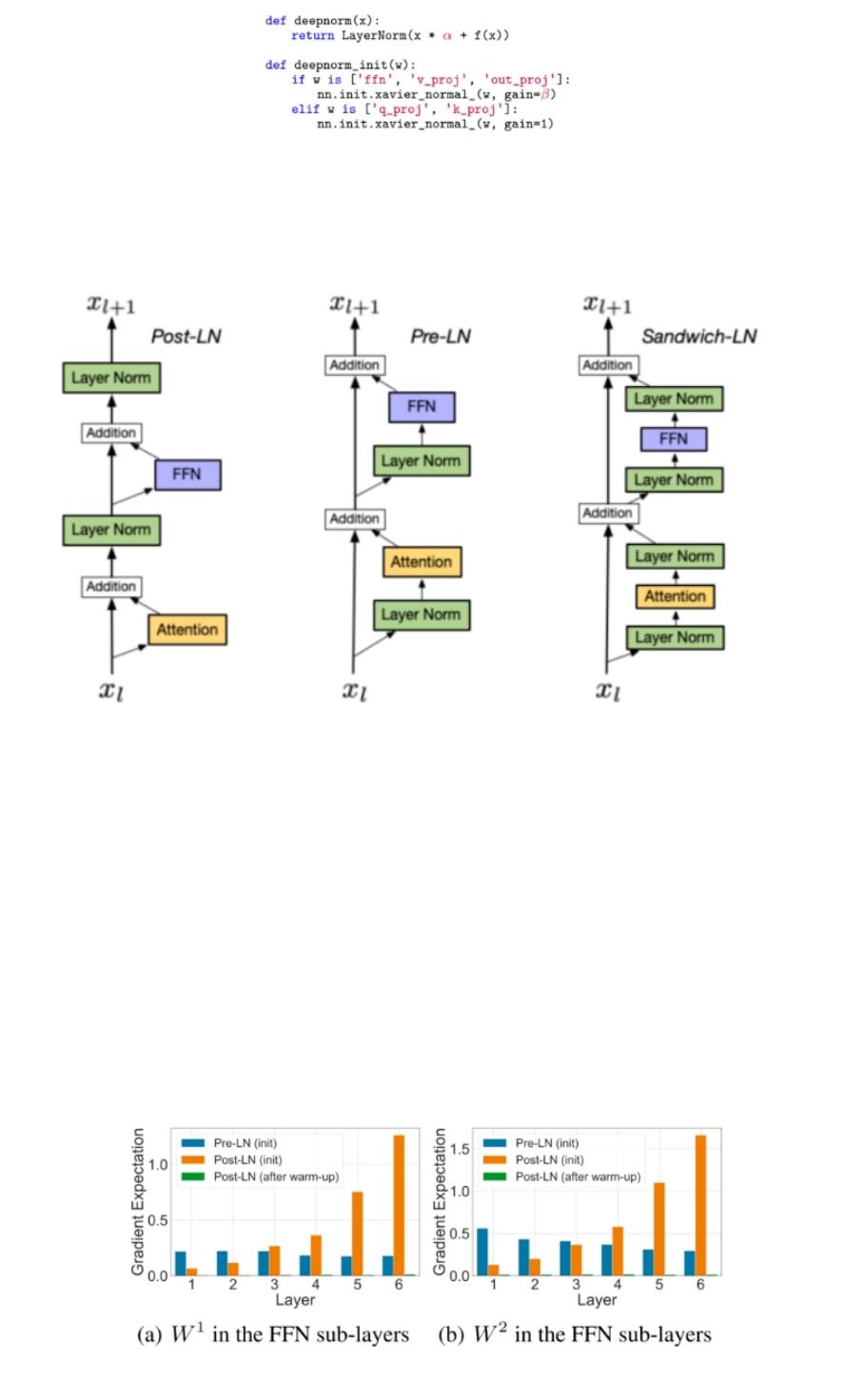

Deep Norm方法在执行Layer Norm之前,up-scale了残差连接 (alpha>1);另外,在初始化阶段down-scale了模

型参数(beta<1)。

3.2 写一下 Deep Norm 代码实现?

Deep Norm 有什么优点?

扫码加

查看更多

Deep Norm可以缓解爆炸式模型更新的问题,把模型更新限制在常数,使得模型训练过程更稳定。

Layer normalization-位置篇

1 LN 在 LLMs 中的不同位置 有什么区别么?如果有,能介绍一下区别么?

回答:有,LN 在 LLMs 位置有以下几种:

1. Post LN:

a. 位置:layer norm在残差链接之后

b. 缺点:Post LN 在深层的梯度范式逐渐增大,导致使用post-LN的深层transformer容易出现训练不稳

定的问题

2. Pre-LN:

a. 位置:layer norm在残差链接中

b. 优点:相比于Post-LN,Pre LN 在深层的梯度范式近似相等,所以使用Pre-LN的深层transformer训

练更稳定,可以缓解训练不稳定问题

c. 缺点:相比于Post-LN,Pre-LN的模型效果略差

3. Sandwich-LN:

a. 位置:在pre-LN的基础上,额外插入了一个layer norm

b. 优点:Cogview用来避免值爆炸的问题

c. 缺点:训练不稳定,可能会导致训练崩溃。

of 3

5墨值下载

【版权声明】本文为墨天轮用户原创内容,转载时必须标注文档的来源(墨天轮),文档链接,文档作者等基本信息,否则作者和墨天轮有权追究责任。如果您发现墨天轮中有涉嫌抄袭或者侵权的内容,欢迎发送邮件至:contact@modb.pro进行举报,并提供相关证据,一经查实,墨天轮将立刻删除相关内容。

下载排行榜

评论