#1 规划

当前 NN(namenode)节点:

10.99.0.6 node01

10.99.0.14 node02

扩容 DN(datanode)节点:

10.99.0.31 node04

部署前要求:新扩容的 DN 机器需要与当前 HDFS 集群机器时间同步。

#2 新增扩容机器准备磁盘和创建目录

一键部署主控机中:

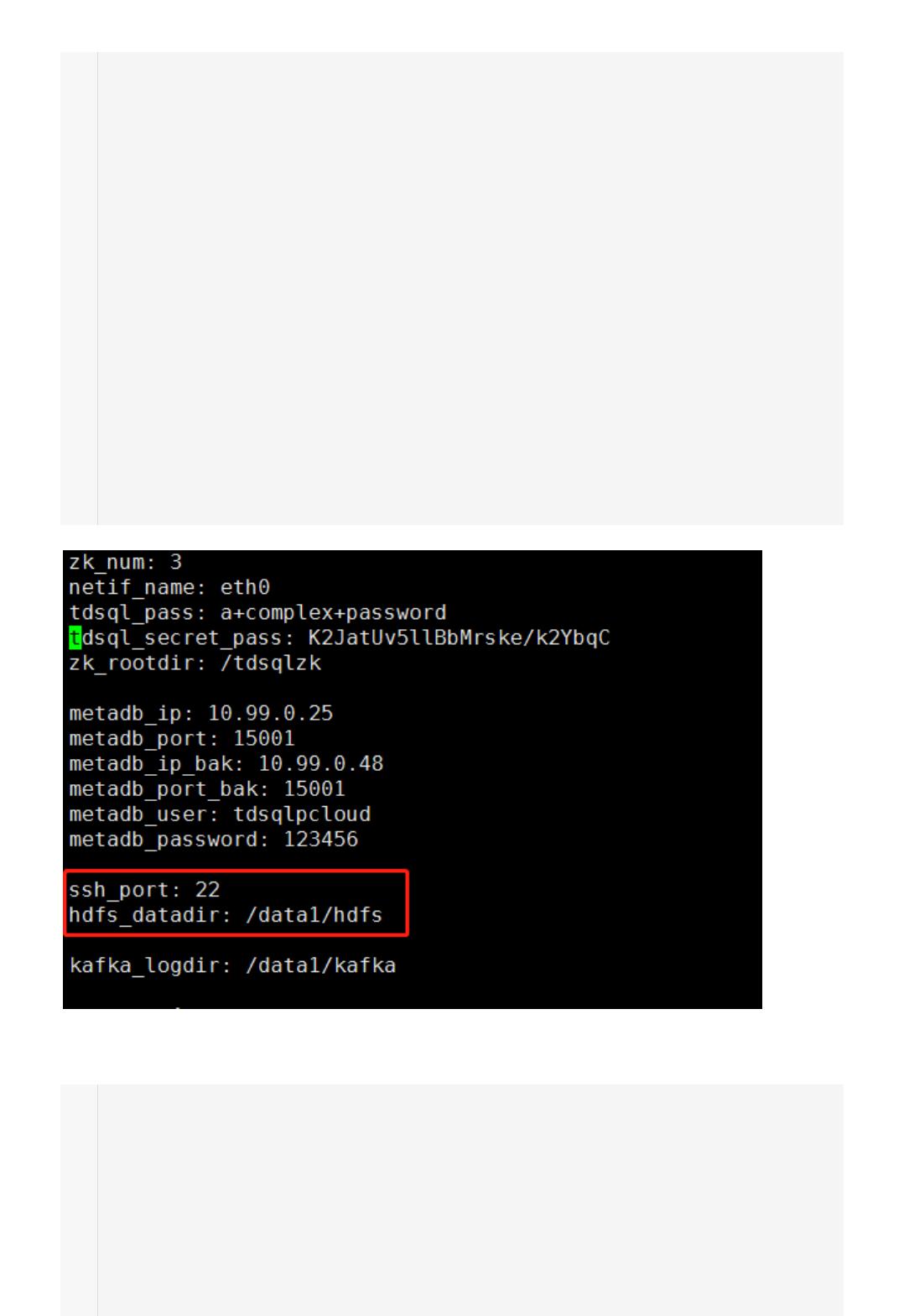

查看部署包中 tdsql_full_install_ansible/group_vars/all 文件 HDFS 目录

vim /data/tdsql_full_install_ansible/group_vars/all

新增 DN 机器上:

在新增 DN 机器上创建好目录,注意只是创建/data1 目录,不是创建/data1/hdfs。

# mkdir –p /data1

首先用 lsblk 查看磁盘信息

1

2

3

4

5

6

7

8

9

10

11

12

13

14

1

2

3

4

5

6

# lsblk

格式化为 xfs 文件系统(这里以 sdg 盘为例)

# mkfs.xfs -f /dev/sdg

修改/etc/fstab 文件,设置自动挂载到指定路径

/dev/sdg /data1 xfs defaults 0 0

挂载磁盘

# mount -a

用 df -hT 命令可以看到挂载成功

# df –hT

创建目录:

# mkdir –p /data1/hdfs

# chown -R tdsql:users /data1/hdfs

#3. 新增 DN 机器设置主机名和配置环境变量

新增 DN 机器:

hostnamectl set-hostname node04

所有的 HDFS 机器:

vim /etc/hosts

# BEGIN hdfs1 local host

10.99.0.6 node01

10.99.0.14 node02

10.99.0.16 node03

10.99.0.31 node04

# END hdfs4 local host

标红的地方是新增 DN 机器的 IP 地址,原有的 HDFS 集群机器有的内容最后添加标红内容,新

新增 DN 机器:

/etc/profile 文件最后加上一键部署主控机/tdsql_full_install_ansible/roles/hdfs/f

# vim /etc/profile

# BEGIN hadoop_env

export JAVA_HOME=/data/home/tdsql/jdk1.8.0_51

export CLASS_PATH=$JAVA_HOME/lib:$JAVA_HOME/jre/lib

export HADOOP_HOME=/data/home/tdsql/hadoop-3.0.3

export HADOOP_PID_DIR=/data/hadoop/pids

export HADOOP_COMMON_LIB_NATIVE_DIR=$HADOOP_HOME/lib/native

export HADOOP_OPTS="-Djava.library.path=$HADOOP_HOME/lib"

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

of 4

5墨值下载

【版权声明】本文为墨天轮用户原创内容,转载时必须标注文档的来源(墨天轮),文档链接,文档作者等基本信息,否则作者和墨天轮有权追究责任。如果您发现墨天轮中有涉嫌抄袭或者侵权的内容,欢迎发送邮件至:contact@modb.pro进行举报,并提供相关证据,一经查实,墨天轮将立刻删除相关内容。

下载排行榜

文档被以下合辑收录

评论