2019-05-17

multipath绑定信息失效

今天遇到一个情况,客户停止计算节点上的集群及数据库后,重启了存储节点,然后尝试启动集群发现磁盘组无法挂载上。我看了日志后发现是ASM未找到部分磁盘,然后到/dev/mapper下查看,发现存在部分磁盘不是以ZDATA*自定义开头的,而是mpath*这种默认的命名方式。存在命名问题的磁盘是最近刚刚新添加上去的磁盘,但是multipath.conf配置文件没有问题,我重新multipath -r 读取多路径配置后,就恢复正常,集群也可以正常拉起来。之前添加磁盘的时候,刚开始新磁盘也是以mpath*开头,后来改了multipath.conf配置文件重新读取后,mpath*的磁盘变为ZDATA*的磁盘,再将这些磁盘加进数据库磁盘组,一直到故障发生都没有重启过计算节点。为什么重启存储节点后,新添加的磁盘会变为mpath*,而不是ZDATA*,需要手动再multipath -r 一次?有解决办法没有?是不是重启一次计算节点服务器就没问题了?

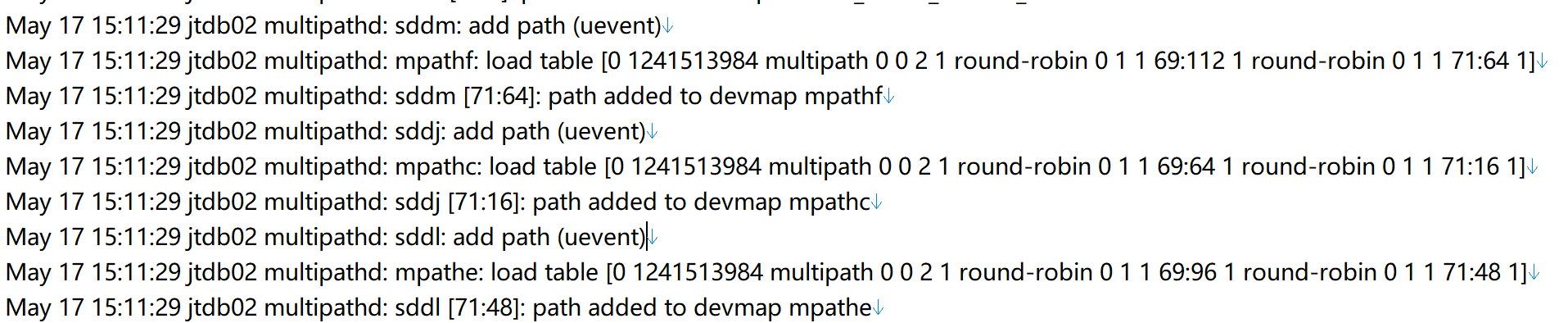

部分日志信息如下

收藏

分享

4条回答

默认

最新

回答交流

提交

问题信息

请登录之后查看

附件列表

请登录之后查看

邀请回答

暂无人订阅该标签,敬请期待~~

墨值悬赏

墨值悬赏

评论

评论